Sommario

Navigare in ambienti complessi come una foresta o un terreno montuoso richiede un insieme di sensi che vanno ben oltre la vista. Per l’essere umano, tatto, equilibrio, suono e percezione del contesto sono strumenti naturali che consentono di interpretare e reagire in tempo reale alle sfide di un ambiente caotico. Ma per i robot, questo tipo di consapevolezza spaziale è sempre stata un’impresa ardua.

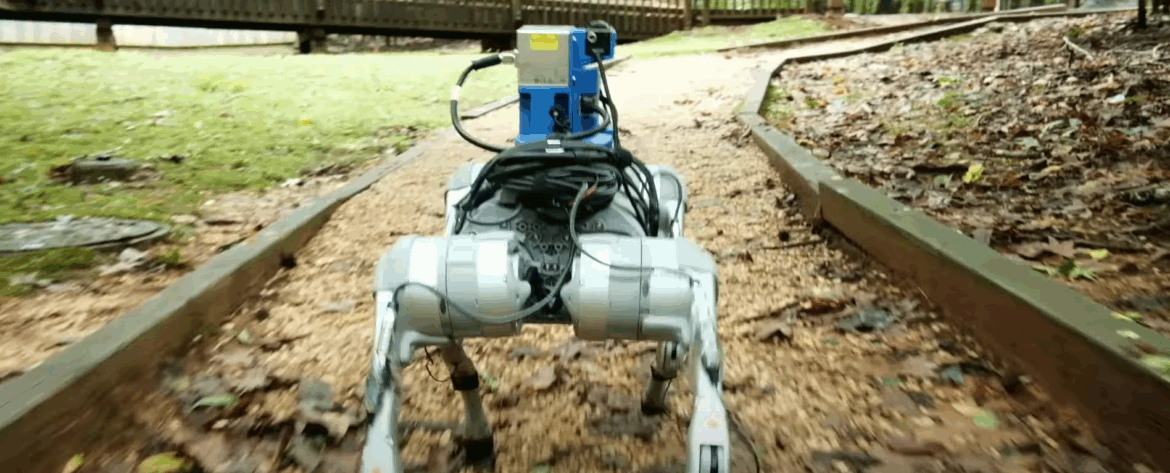

Un team di ricerca della Duke University, guidato dal professor Boyuan Chen, ha sviluppato un sistema chiamato WildFusion, capace di replicare nei robot proprio questa percezione multisensoriale ispirata all’essere umano, rendendo possibile una navigazione fluida e sicura in ambienti non strutturati, come quelli naturali o post-catastrofici.

Un nuovo modello di percezione: visione, vibrazione, tatto

WildFusion rappresenta una svolta concettuale nella progettazione dei sistemi di navigazione autonoma. Laddove i robot tradizionali si affidano principalmente a telecamere o sensori LiDAR, il nuovo framework sviluppato a Duke introduce un modello ibrido e adattivo, che fonde:

- Informazioni visive, tramite fotocamere RGB standard

- Input tattili, simulati con sensori di pressione e vibrazione sulle zampe robotiche

- Segnali sonori ambientali, come la caduta di un albero o il fruscio del vento

- Dati sull’equilibrio e la postura, per valutare la stabilità del terreno

Questa fusione sensoriale consente al robot di costruire una mappa tridimensionale più coerente e di scegliere percorsi stabili anche in assenza di riferimenti visivi chiari, come in caso di nebbia, terreno fangoso o vegetazione densa.

Applicazioni reali: esplorazione, salvataggio, ambiente

L’ambizione del progetto WildFusion non si limita alla teoria. Il sistema è già stato testato con successo su robot quadrupedi in simulazioni forestali e ambienti dinamici, con risultati positivi in termini di affidabilità, reattività e capacità predittiva del terreno.

Secondo Yanbaihui Liu, primo autore dello studio e dottorando al General Robotics Lab, “le tecniche di mappatura classiche spesso falliscono in ambienti in cui i sensori restituiscono dati incompleti o rumorosi. WildFusion nasce proprio per colmare questo gap”.

Le applicazioni più immediate si concentrano su:

- Missioni di salvataggio in zone montane o post-terremoto, dove la navigazione autonoma può salvare vite

- Esplorazione scientifica e ambientale, grazie alla capacità di rilevare pattern nel suolo e nella vegetazione

- Robotica militare e off-road, in contesti dove l’imprevedibilità del terreno è la norma

La ricerca è stata accettata alla IEEE International Conference on Robotics and Automation (ICRA) 2025, confermando la sua rilevanza a livello internazionale.

Il passo verso la cognizione artificiale incarnata

WildFusion rappresenta una delle prime implementazioni pratiche di cognizione incarnata nei robot mobili, un concetto secondo cui la comprensione dell’ambiente emerge dall’interazione fisica con esso, non da una rappresentazione astratta.

Questo approccio porta la robotica un passo più vicino al comportamento animale, introducendo logiche di apprendimento situato e sensomotorio.

Il futuro della robotica non sarà più solo questione di algoritmi, ma di esperienza percettiva adattiva, in cui ogni passo, ogni rumore e ogni contatto diventano dati validi per la decisione. WildFusion è un esempio concreto di questa visione: un robot che non solo vede, ma sente, ascolta e comprende il mondo attraverso il corpo.