Le novità di Google Cloud definiscono una fase di espansione che unisce agenti AI, infrastrutture sottomarine, partnership strategiche, analisi di minacce avanzate e un forte focus sulla produzione AI su larga scala, elementi che emergono già nel primo periodo. Il provider introduce un framework metodico per valutare agenti AI complessi, lancia il cavo sottomarino Dhivaru per migliorare la resilienza nell’Oceano Indiano, premia i Partner All-stars 2025, rilascia un learning path AI ready for production, e propone un hands-on dedicato al modello open multimodale Gemma 3. Queste iniziative si intrecciano con collaborazioni come quella con Ooredoo e con investimenti energetici sostenibili, rafforzando un ecosistema che integra infrastrutture, sicurezza e formazione per accelerare la trasformazione digitale globale.

Valutazione strutturata degli agenti AI

Google Cloud sviluppa un framework rigoroso per valutare agenti AI destinati a scenari complessi, introducendo criteri di successo legati allo scopo applicativo, come riassunti affidabili o operazioni conformi a regole codificate. La valutazione combina tre dimensioni principali: qualità dell’output, analisi delle traiettorie del processo decisionale e parametri di trust e safety. L’approccio misura il completamento dei task, la coerenza della conversazione, l’uso corretto dei tool e la robustezza contro input avversari. La componente di trust verifica bias, vulnerabilità e comportamento in situazioni limite. Questa struttura multilivello integra valutazione umana, sistemi LLM-as-a-judge e test basati su codice, fornendo una pipeline scalabile che si innesta nei flussi CI/CD come quality gate. Gli sviluppatori possono iniziare anche senza dataset dorati grazie a feedback binari e revisione umana, mentre il ciclo di monitoraggio in produzione sfrutta metriche operative, rilevamento del drift e aggiornamenti continui ai test suite. Il metodo evita i fallimenti silenziosi, nei quali un output apparentemente corretto maschera errori di ragionamento o tool usage inadeguato, garantendo affidabilità nella transizione da proof-of-concept a produzione.

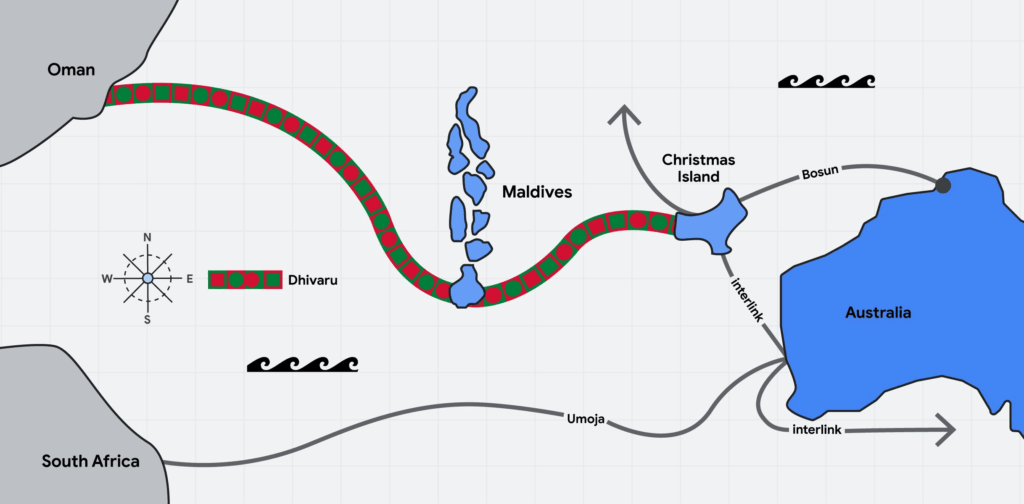

Il cavo sottomarino Dhivaru e l’espansione della connettività globale

Il progetto Dhivaru rappresenta la nuova infrastruttura trans-oceanica di Google Cloud, un sistema di cavi che collega Maldive, Christmas Island e Oman, ampliando la rete Australia Connect attraverso un segmento strategico dell’Oceano Indiano. La tecnologia utilizza multiplazione spaziale su sedici coppie di fibre, abilitando una gestione flessibile della banda per servizi che includono applicazioni AI persistenti come Gemini e Vertex AI. Gli hub realizzati nelle Maldive e a Christmas Island offrono capacità di switching, caching e colocation, riducendo la latenza e migliorando la resilienza grazie al rerouting automatico.

Il design energetico ottimizzato diminuisce i consumi rispetto ai data center tradizionali e integra soluzioni di sicurezza avanzate per le landing station. La configurazione evita aree a rischio geologico, assicurando stabilità a lungo termine. L’estensione Pearls prevista per il 2026 amplierà ulteriormente la copertura verso regioni emergenti dell’Africa orientale e dell’Asia meridionale. Il presidente Muizzu sottolinea come l’infrastruttura trasformi le Maldive in un hub digitale internazionale, mentre Ooredoo enfatizza gli impatti su turismo e servizi cloud. Il potenziamento favorisce anche la crescita del 5G e la modernizzazione dei sistemi aziendali locali, sostenendo ecosistemi digitali più robusti.

Partner All-stars 2025 e centralità dell’innovazione AI

Il programma Google Cloud Partner All-stars 2025 riconosce aziende che si distinguono per eccellenza in innovazione AI, delivery, marketing, vendite e solutions engineering. La categoria AI innovation premia i partner che guidano adozioni su larga scala, offrendo soluzioni agentiche capaci di modernizzare processi centrali delle imprese. I criteri per il riconoscimento includono competenze tecniche certificate, capacità di esecuzione end-to-end, campagne di marketing basate sui dati e performance commerciali superiori ai target. Il premio valorizza modelli organizzativi che coniugano strategia e innovazione, rafforzando la collaborazione con Google Cloud e ampliando la diffusione delle best practice nel settore enterprise. L’obiettivo è stimolare un ecosistema capace di sostenere trasformazioni tecnologiche complesse, alimentando nuove opportunità di mercato e consolidando relazioni durature tra provider e partner.

Percorso formativo per AI production-ready

Google Cloud rilascia un learning path gratuito destinato agli sviluppatori che vogliono portare applicazioni AI dalla fase di prototipo a un ambiente produttivo scalabile. Il programma include moduli dedicati allo sviluppo di app LLM con Vertex AI, deploy di modelli open e creazione di agenti tramite l’Agent Development Kit. Il curriculum approfondisce temi come sicurezza applicativa, fine-tuning avanzato e integrazione con infrastrutture come GKE e Cloud Run. Il percorso si aggiorna settimanalmente fino a dicembre 2025 e si basa su metodologie interne che definiscono requisiti di osservabilità, resilienza e CI/CD. La community utilizza l’hashtag ProductionReadyAI per condividere progetti e risultati. I benefici includono l’apprendimento di tecniche operative per scalare workload AI e il consolidamento di best practice per l’adozione responsabile di modelli avanzati. L’iniziativa democratizza l’accesso alla produzione AI, offrendo strumenti per costruire pipeline end-to-end sicure ed efficienti.

Gemma 3: hands-on per sviluppo, deployment e scalabilità

La guida hands-on dedicata a Gemma 3, modello open multimodale per testo e immagini, consente agli sviluppatori di sperimentare un’architettura pensata per funzionare in modo efficiente anche su hardware contenuto. Gemma 3 eredita tecnologie di Gemini e si integra nativamente con servizi come Cloud Run per un deploy serverless rapido, mentre GKE permette throughput elevati e orchestrazione avanzata. I laboratori pratici illustrano l’uso delle GPU, le strategie di scaling automatico e la gestione di API per application layer. Il modello supporta personalizzazione e controlli granulari, favorendo un’adozione responsabile e in linea con i requisiti di privacy. Il workflow suggerito accelera la transizione da test locali a produzione, riducendo complessità operative e semplificando la costruzione di applicazioni multimodali. La community condivide esempi e configurazioni, contribuendo a una diffusione più ampia delle competenze necessarie per applicazioni avanzate.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.