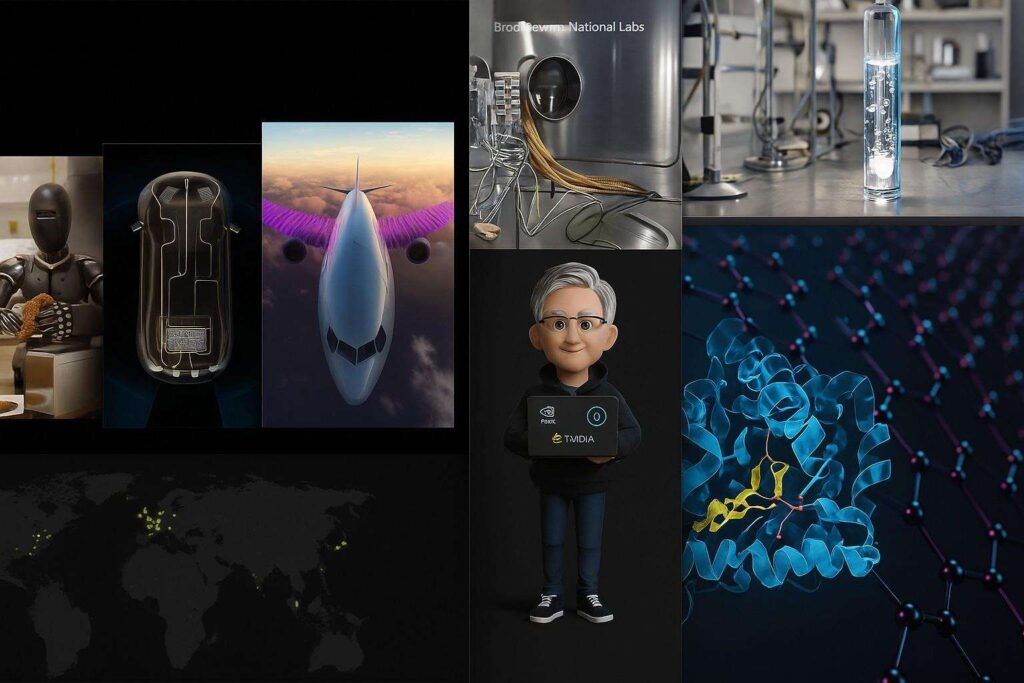

L’edizione Sc25 segna un passaggio decisivo nella trasformazione del supercomputing globale, con Nvidia che presenta un’ondata di innovazioni capaci di ridefinire il ritmo della ricerca scientifica. La compagnia introduce oltre 80 nuovi sistemi distribuiti tra Stati Uniti, Europa e Asia, raggiungendo una potenza combinata di 4.500 exaflops in calcolo AI e consolidando una leadership che si estende dal networking fotonico alla modellazione climatica, fino alla scoperta molecolare. L’accelerated computing diventa il nuovo standard: la quota di sistemi CPU-only nella Top500 crolla sotto il quindici per cento, mentre le architetture Hopper e Blackwell si impongono come il motore principale per la scienza ad alta intensità computazionale.

Sistemi come Jupiter, con una efficienza record di 63,3 gigaflops per watt e 116 exaflops dedicati all’intelligenza artificiale, dimostrano come GPU e reti avanzate possano trattare simulazioni prima considerate ingestibili. Nvidia presenta inoltre nuovi modelli open-source della famiglia Apollo, pensati per fisica, chimica, biologia e ingegneria, destinati a trasformare lo sviluppo di materiali e la progettazione farmaceutica. In parallelo, il kit AI Science abilita microservizi che comprimono analisi atomiche da mesi a settimane, portando la ricerca industriale nel dominio delle scale computazionali estreme. Il risultato è un ecosistema che unisce AI, supercomputing e networking ottico per rispondere a sfide come fusione energetica, clima, modellazione galattica e scoperta molecolare, con un impatto globale che coinvolge laboratori nazionali, università e industrie strategiche.

Trasformazione dell’accelerated computing

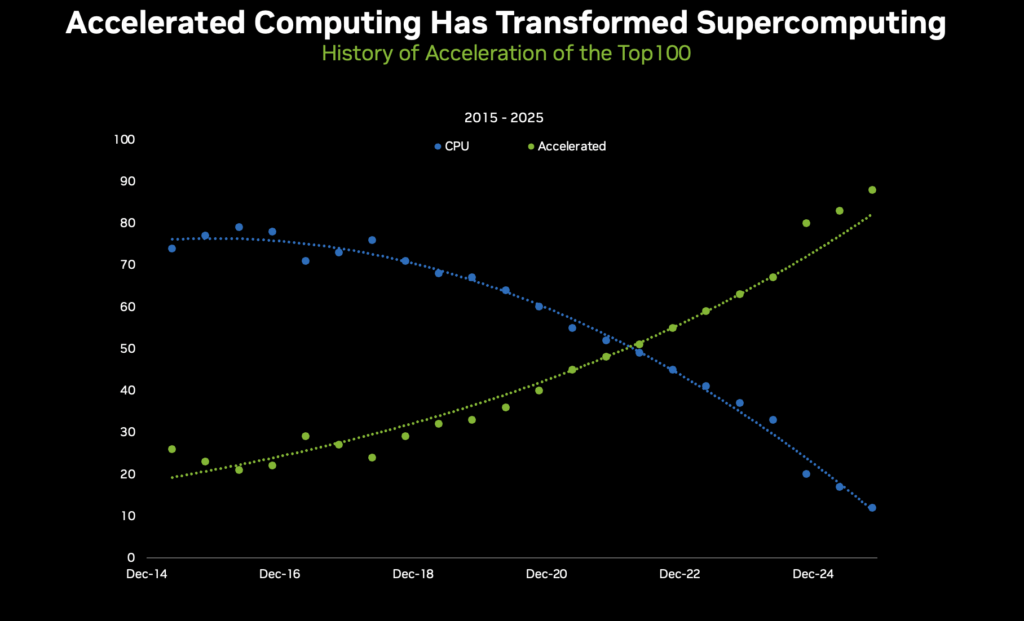

La trasformazione del supercomputing in ambiente accelerato è al centro della visione Nvidia. Negli ultimi cinque anni, la percentuale di sistemi CPU-only nella Top500 è scesa da oltre il settanta per cento a meno del quindici, mentre 388 sistemi utilizzano tecnologie Nvidia, di cui 218 accelerati da GPU e 362 connessi tramite reti Nvidia. Questa migrazione è trainata da architetture come Hopper e Blackwell, progettate per gestire precisioni flessibili che spaziano da FP64, essenziale per la scienza tradizionale, fino a INT8, dedicata al deep learning.

Sistemi simbolo come Titan, Summit, Sierra e l’attuale Jupiter rappresentano tappe evolutive di una linea che ha definito nuovi standard per previsioni meteo, genomica, scoperta farmaci e modellazione geofisica. Jupiter, basato su GH200 Grace Hopper, stabilisce record nell’efficienza energetica, un fattore centrale nella corsa all’exascale sostenibile. Nvidia domina anche la Green500, con otto dei sistemi più efficienti al mondo accelerati da GPU e sette connessi tramite Quantum InfiniBand. Secondo Jensen Huang, il deep learning diventa un martello di Thor per affrontare problemi che vanno dal clima all’energia, rivoluzionando metodologie consolidate. Questa transizione consente di spostare carichi computazionali enormi dalle CPU alle GPU, riducendo consumi energetici e ampliando la capacità delle strutture esistenti.

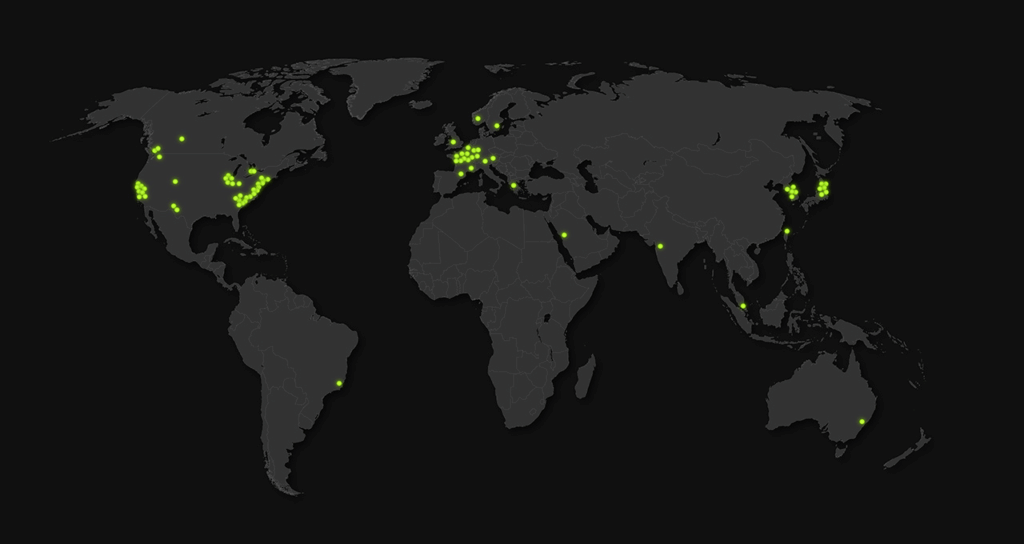

Nuovi sistemi scientifici globali alla Sc25

Alla Sc25 Nvidia annuncia oltre 80 nuovi sistemi destinati a guidare la ricerca scientifica globale, con una potenza combinata di 4.500 exaflops in AI. Negli Stati Uniti, il Texas Advanced Computing Center prepara Horizon, con 4.000 GPU Blackwell capaci di raggiungere 80 exaflops, ideale per simulare dinamiche molecolari, astrofisica e turbolenze atmosferiche. L’Argonne National Laboratory propone Solstice, un supercomputer con 100.000 GPU Blackwell per oltre 1.000 exaflops, e Equinox, progettato per integrarsi con infrastrutture del Dipartimento dell’Energia. Los Alamos sviluppa Mission e Vision, sistemi che si collegheranno a strumenti avanzati come il telescopio Vera Rubin e reti Quantum-X800 per attività classificate e AI agentica entro il 2027. In Europa, il centro tedesco Jülich espande Jupiter con 24.000 GH200 Grace Hopper, focalizzandosi su simulazioni climatiche ultra-dettagliate.

Il Leibniz Supercomputing Centre avvia Blue Lion, basato su Vera Rubin e orientato a modelli climatici e applicazioni di machine learning. In Danimarca, Gefion sfrutta un Dgx SuperPod con Quantum-2 per sostenere progetti di biotecnologia e quantum computing sovrano. L’Università di Bristol integra Isambard-AI, con focus su salute e modelli linguistici. In Asia, il Riken giapponese lavora su progetti come FugakuNext, con connessione NvLink Fusion per modellazione del pianeta e manifattura avanzata. La Tokyo University of Technology realizza un sistema con DGX B200 per 2 exaflops dedicati ai modelli linguistici. La Corea del Sud distribuisce oltre 50.000 GPU Blackwell per cloud sovrani con partner come Samsung e Hyundai, mentre Foxconn sviluppa una AI factory a Taiwan con 10.000 GPU Blackwell. Questo mosaico di sistemi crea una rete globale di capacità computazionale ai massimi livelli.

Avanzamenti in networking e computing accelerato

Nvidia rivoluziona il networking scientifico introducendo ConnectX-9 SuperNIC e BlueField-4 DPU, integrati con architetture Grace Hopper per costruire AI factories. ConnectX-9 offre connessioni ad altissima velocità, mentre BlueField-4, con 64 core Grace CPU, sposta funzioni di gestione del data center dalla CPU alla DPU, liberando risorse critiche per GPU e AI. Nvidia lancia anche Quantum-X Photonics e Quantum-X1600, nuovi switch InfiniBand che eliminano transceiver pluggabili e riducono il consumo energetico di 3,5 volte, aumentando la resilienza delle reti di dieci volte. Applicazioni scientifiche a lunga durata possono mantenersi attive cinque volte più a lungo senza interruzioni. Soluzioni come TACC, Lambda e CoreWeave integreranno questi switch dal prossimo anno. DGX Spark, basato su Grace Blackwell, fornisce un petaflop di AI con 128 GB di memoria unificata, adatto a modelli da 200 miliardi di parametri. La tecnologia NvLink-C2C garantisce una banda cinque volte superiore a PCIe Gen5, riducendo latenza nei training su vasta scala. Nvidia enfatizza sicurezza zero-trust, isolamento multi-tenant, e pipeline storage accelerate tramite BlueField-4. In questo ecosistema, la combinazione di computing accelerato e networking fotonico crea architetture ottimizzate per l’exascale sostenibile.

AI per scoperta materiali alla Sc25

La Sc25 vede il debutto dei microservizi del kit AI Science, inclusi i moduli Alchemi NIM per ricerca conformazionale, screening di materiali e dinamiche molecolari. Aziende come Eni e Universal Display utilizzano questi strumenti per valutare milioni di candidati molecolari in poche settimane, con throughput dieci volte maggiore dei metodi tradizionali. Universal ottiene un’accelerazione 10.000 volte nell’analisi delle proprietà OLED, riducendo simulazioni da giorni a secondi. Il Brookhaven National Laboratory integra Holoscan per elaborazione dati in tempo reale dal sincrotrone NSLS-II, permettendo feedback immediato in esperimenti su batterie e nanoparticelle. Nvidia collabora con laboratori nazionali per creare pipeline autonome AI-assistite che riducono costi, aumentano precisione sperimentale e permettono ricerche prima inaccessibili. I microservizi AI ottimizzano predizioni atomiche per aerospazio, manifattura e materiali sostenibili, trasformando la scienza dei materiali in una disciplina dominata da modelli ibridi tra simulazione e AI.

Modelli open Apollo per simulazioni scientifiche

La famiglia di modelli Apollo rappresenta la nuova frontiera delle simulazioni scientifiche. Si tratta di modelli open ottimizzati per fisica computazionale, fluidodinamica, ingegneria strutturale, chimica, elettronica e clima. Apollo utilizza architetture transformer e modelli di diffusione, integrando conoscenza dominio-specifica in strutture neurali addestrate su dataset scientifici massivi. Disponibili su Hugging Face e come microservizi NIM, includono checkpoint preaddestrati e workflow completi per training e inferenza. Aziende come Applied Materials usano Apollo per modellare materiali semiconduttori e processi produttivi, mentre Cadence lo integra per digital twin aeronautici in tempo reale. Siemens, Neural Concept e Luminary Cloud adottano Warp per simulazioni fisiche accelerate via GPU. Apollo abilita inferenza real-time su modelli addestrati con triliardi di token, riducendo tempi di simulazione e costi operativi per ingegneria, chimica e materiali avanzati.

Impatto globale delle innovazioni Nvidia

L’impatto delle innovazioni Nvidia si estende su scala planetaria. Sistemi come Horizon simulano terremoti, astrofisica e transizioni di fase, mentre Solstice integra dati DOE per modellazione energetica avanzata. Jupiter produce simulazioni climatiche ad altissima risoluzione, riducendo incertezze nelle previsioni meteo. In Danimarca, Gefion sostiene biotecnologie e energie pulite, mentre in Giappone ABCI-Q avanza ricerca quantistica e modellazione molecolare. Corea del Sud e Taiwan creano AI factory per manifattura e modelli linguistici sovrani. Le architetture Blackwell e Grace Hopper diventano elementi centrali per affrontare sfide globali come energia pulita, materiali avanzati e clima estremo. La convergenza di supercomputing e AI crea un ciclo virtuoso di innovazione, favorendo posti di lavoro qualificati e l’espansione delle industrie digitali.

Evoluzione del supercomputing con Nvidia

Nvidia guida una evoluzione che passa dal predominio CPU-only alla supremazia GPU-accelerated. Oltre l’ottanta per cento dei sistemi Top100 utilizza tecnologia Nvidia, con modelli come Titan, Piz Daint, Summit e Sierra che hanno segnato momenti chiave nella storia del computing ad alte prestazioni. Oggi architetture come Blackwell e Hopper introducono la metrica degli AI-flops, con Jupiter che supera 116 exaflops dedicati a modelli AI per fusione energetica e genomica. Le reti Quantum-X riducono interruzioni e migliorano resilienza per applicazioni di lungo periodo. Microservizi NIM per scienza dei materiali permettono screening da miliardi di candidati, mentre l’integrazione con tecnologie di storage ottimizza pipeline dati per training su larga scala. L’evoluzione segna una convergenza fra fisica computazionale e AI, dove la simulazione tradizionale diventa ibrida e potenziata da modelli multifisici.

Applicazioni AI in scienza e industria

Le applicazioni AI presentate da Nvidia alla Sc25 mostrano come la ricerca scientifica e l’industria stiano convergendo verso modelli ibridi. Eni utilizza Alchemi per analizzare catalizzatori dell’idrogeno a costi ridotti, mentre Universal Display usa pipeline accelerate per creare materiali OLED efficienti. Il Brookhaven National Laboratory sfrutta Holoscan per imaging nanometrico in tempo reale, applicato allo sviluppo di batterie di nuova generazione. Applied Materials utilizza Apollo per ottimizzare la produzione di semiconduttori, mentre Siemens integra Warp per simulazioni fluidodinamiche ad alta precisione. Queste applicazioni riducono i tempi di calcolo da giorni a secondi e permettono esplorazioni in spazi progettuali vastissimi, rendendo l’AI una componente inevitabile per l’innovazione scientifica ed energetica.

Futuri sviluppi Nvidia in AI e computing

Nvidia anticipa estensioni del progetto Pearls per il 2026, nuove generazioni di modelli Apollo, architetture integrate quantum-classiche tramite NvQLink con fedeltà del 99%, sistemi DGX Spark per fine-tuning locale e nuove implementazioni di BlueField-4 per AI factories avanzate. Le collaborazioni con laboratori e partner industriali permetteranno la nascita di nuovi supercomputer destinati a energia, clima, medicina computazionale e materiali sostenibili. L’obiettivo è superare la soglia dell’exaflop sostenibile e creare un panorama globale in cui AI e supercomputing non sono più discipline separate, ma un’unica infrastruttura per la scoperta scientifica.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.