Nvidia presenta un’ondata di modelli AI open-source dedicati a guida autonoma, robotica e AI fisica durante NeurIPS, segnando uno dei passaggi più rilevanti dell’anno per l’ecosistema della ricerca. Le novità includono il debutto di DRIVE Alpamayo-R1, un modello VLA orientato al ragionamento autonomo, capace di valutare traiettorie e gestire scenari complessi con pedoni. Parallelamente emergono modelli per speech, safety AI e strumenti per dataset sintetici che favoriscono simulazioni realistiche per robotica avanzata. Mentre Nvidia apre la strada a una nuova generazione di AI fisica, Google estende Gemini 3 AI Mode a 120 Paesi con funzioni multimodali e strumenti generativi come Nano Banana Pro, mentre AWS introduce la suite Transform, dedicata alla modernizzazione del codice enterprise, dai mainframe ai sistemi Windows e ai runtime cloud-native. Le innovazioni presentate delineano un trend netto per il 2025: ricerca più aperta, modelli più accessibili, workflow automatizzati con AI e una crescente unificazione tra AI digitale e AI fisica. L’impatto è immediato per sviluppatori, ricercatori e aziende, che ottengono tool più avanzati per ottimizzare performance, ridurre debito tecnico e accelerare sperimentazione scientifica.

Contributi Nvidia per AI fisica

Nvidia consolida la propria leadership nella AI fisica ampliando il rilascio open-source a NeurIPS. Il modello DRIVE Alpamayo-R1 emerge come primo VLA per guida autonoma basato su ragionamento chain-of-thought, progettato per interpretare traiettorie, prevedere comportamenti e affrontare situazioni complesse nello scenario urbano. La base tecnica risiede in Cosmos Reason, mentre la licenza consente ampia personalizzazione per usi non commerciali. Migliora tramite reinforcement learning e viene distribuito assieme a un ecosistema tecnico completo: dataset aperti tramite i Physical AI Open Datasets, test prestazionali con AlpaSim, linee guida in Cosmos Cookbook, generazione sintetica con LidarGen, correzione artefatti tramite Omniverse NuRec Fixer e conversione dei modelli video in policy robotiche con Cosmos Policy.

Strumenti come ProtoMotions3, basato su Isaac Lab, accelerano il training di modelli per la generazione di movimenti umani digitali, mentre collaborazioni con partner come Voxel51, 1X, Figure AI e ETH Zurich ampliano le applicazioni nei domini di robotica, autonomia veicolare e simulazione avanzata. L’intero ecosistema si concentra sulla creazione di modelli fisici più realistici, sull’addestramento in ambienti simulati e su una pipeline open che consente alla comunità di testare, modificare e migliorare modelli complessi con costi ridotti. Nvidia rafforza così un settore emergente, dove dataset sintetici, simulazioni scalabili e policy robotiche generalizzate stanno diventando fondamentali per la sicurezza degli AV e la riproducibilità scientifica.

Innovazioni Nvidia per AI digitale

Accanto alla fisica, Nvidia amplia il proprio contributo all’AI digitale con modelli open-source per speech, safety e dataset generativi. Soluzioni come MultiTalker Parakeet riconoscono parlato sovrapposto in streaming multi-speaker, mentre Sortformer effettua diarizzazione in tempo reale distinguendo accuratamente i parlanti. Strumenti come Nemotron Content Safety Reasoning permettono l’applicazione di policy personalizzate con ragionamento avanzato, mentre Nemotron Content Safety AudioDataset introduce dataset audio specifici per rilevare contenuti non sicuri in sistemi multimodali.

Nvidia porta inoltre ambienti di reinforcement learning per LLM con NeMo Gym, include componenti RLVR e strumenti per dataset sintetici come NeMo Data Designer, che automatizza la generazione e il refining dei corpus per modelli generativi. L’azienda presenta 70 paper a NeurIPS, spaziando dal ragionamento matematico all’audio multimodale, introducendo architetture come Audio Flamingo 3, Minitron-SSM, Jet-Nemotron e Nemotron-Flash, progettate per ottimizzare latenza, compressione e ragionamento step-by-step. Collaborazioni con realtà come CrowdStrike mostrano l’applicabilità dei modelli nei domini della sicurezza informatica, con AI agentiche pensate per analisi, detection e risposta a eventi complessi. I benefici avanzano in direzione di maggiore trasparenza, performance ottimizzate e licenze più aperte, che innalzano la qualità della ricerca accessibile.

Espansione di Gemini 3 in Google Search

Google amplia la distribuzione di Gemini 3 AI Mode a 120 Paesi in lingua inglese, con accesso tramite menu dedicato per abbonati AI Pro. Questa estensione introduce capacità multimodali più mature, inclusa la generazione di codice agentico, layout visivi dinamici, simulazioni personalizzate e interfacce interattive. L’aggiunta di Nano Banana Pro, basato su Gemini 3 Pro e integrato con la conoscenza di Search, permette la creazione di immagini, infografiche e rappresentazioni visive generate al volo. Le query complesse beneficiano di ragionamento più coerente e risposte strutturate, mentre l’adozione di strumenti generativi integrati in Search innalza l’esperienza utente con risposte ricche, contestualizzate e visualizzate in modo comprensibile. L’espansione globale rappresenta un passaggio significativo verso una Search sempre più AI-native, dove multimodalità ed elaborazione contestuale diventano parte del workflow quotidiano di milioni di utenti. L’aggiornamento rafforza anche la produttività professionale, grazie a modelli più precisi e a interazioni estese nei contesti di lavoro e studio.

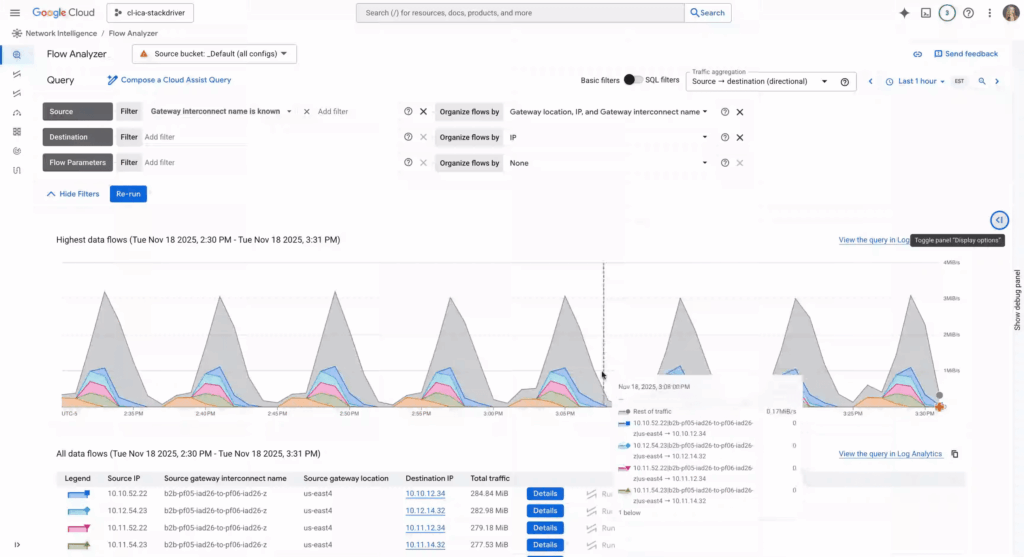

VPC Flow Logs per reti cross-cloud

Google Cloud introduce VPC Flow Logs nella piattaforma Cross-Cloud Network, permettendo il monitoraggio granulare dei flussi ibridi su tunnel VPN e VLAN Interconnect. Lo strumento cattura flussi 5-tuple, annotazioni gateway, direzione traffico e metadata come project ID e location, fornendo una visione completa dei percorsi applicativi. Inoltre abilita analisi dettagliate tramite Cloud Logging, integrandosi con Flow Analyzer e Gemini Cloud Assist per interrogazioni naturali dei dati, confronti storici e diagnosi rapide dei top talker.

La granularità acquisita facilita l’individuazione di elephant flows, l’ottimizzazione delle policy DSCP, l’audit degli ambienti Shared VPC e la conformità tramite record strutturati. L’integrazione con console, CLI, API e Terraform favorisce adozione aziendale senza costi aggiuntivi per l’analisi. L’iniziativa aumenta sicurezza, visibilità e performance delle infrastrutture ibride, mentre Cross-Cloud Network rafforza il posizionamento di Google nel networking distribuito.

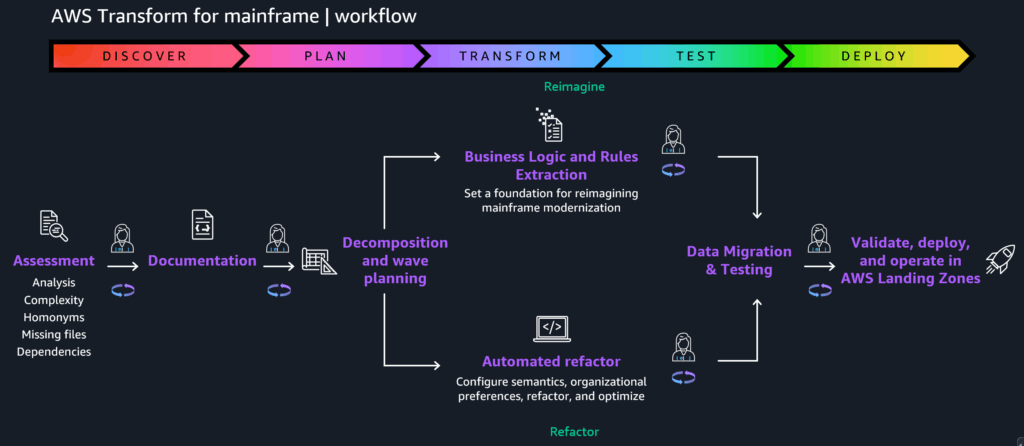

Reimagine in AWS Transform per mainframe

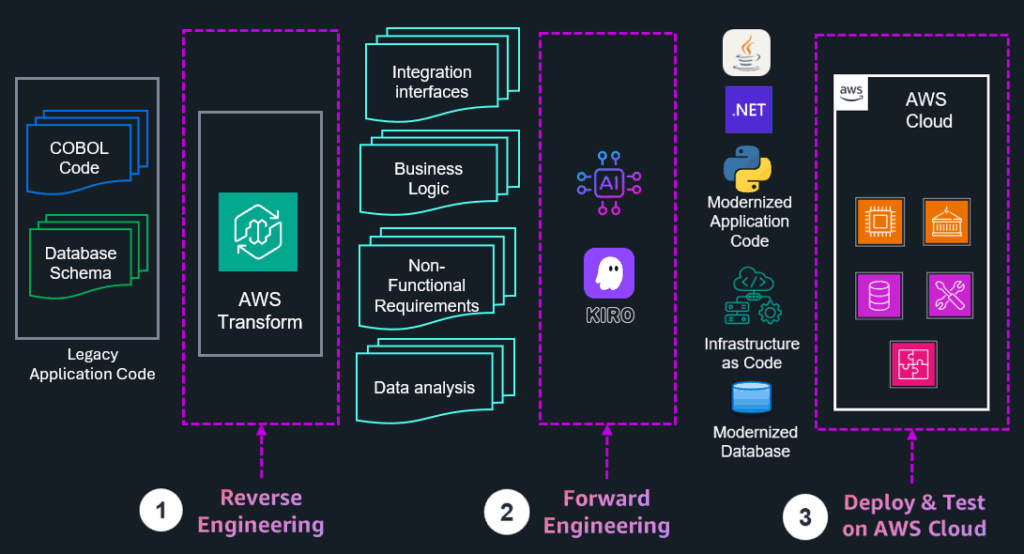

AWS presenta Reimagine, una funzione di AWS Transform che automatizza la trasformazione dei sistemi mainframe tramite pattern AI-driven. La soluzione analizza architetture monolitiche COBOL, converte batch in processi real-time, estrae logiche di business e genera specifiche di microservizi. Il flusso segue tre fasi: reverse engineering, forward engineering e deploy con IaC, supportando validazione human-in-loop per ridurre errori.

La piattaforma integra testing automatico, generazione di dizionari dati, script JCL e piani di migrazione. Si focalizza sui flussi z/OS batch, configurando entry point e casi di test e integrando strategie Replatform e Rehost. I benefici includono accelerazione delle modernizzazioni da anni a pochi mesi, maggiore precisione e riduzione dei costi operativi. La disponibilità della soluzione inizia in regioni selezionate senza costi aggiuntivi, con integrazione naturale con S3, CloudFormation e DMS.

Capacità full-stack Windows in AWS Transform

AWS introduce capacità di modernizzazione full-stack Windows, coprendo migrazioni da .NET Framework a .NET 6+, da SQL Server verso Aurora PostgreSQL e da Web Forms a Blazor. La piattaforma analizza dipendenze, complessità e wave plan attraverso report generati automaticamente. Fornisce conversioni di stored procedure, refactoring del codice, deployment su EC2 Linux o ECS e aggiornamenti real-time durante la trasformazione. Queste capacità aumentano la velocità di migrazione fino a cinque volte, garantendo coerenza tra tier applicativi e riducendo errori. L’integrazione con IAM, rete, DMS e CloudFormation facilita implementazioni scalabili in contesti enterprise. La disponibilità iniziale parte da US East, senza costi aggiuntivi per le feature dedicate Windows.

AWS Transform Custom per debito tecnico

AWS introduce Transform Custom, un sistema di trasformazione AI per eliminare debito tecnico in codebase scritte in Java, Node.js e Python. La piattaforma effettua upgrade runtime, migrazioni di framework, conversioni da CDK a Terraform, transizione da x86 a Graviton e modernizzazione degli SDK AWS. Riconosce pattern custom nei repository, rifattorizza utility e applica standard di coding coerenti. Lo strumento basa l’interazione su un linguaggio naturale che traduce richieste in trasformazioni, con generazione di piani, raffinamento iterativo, orchestrazione CI/CD e gestione multi-repo. I benefici includono riduzione dell’effort fino all’80%, maggiore coerenza e scalabilità delle codebase ed eliminazione dei colli di bottiglia in progetti enterprise. La soluzione è disponibile via CLI e dashboard web, senza costi aggiuntivi.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.