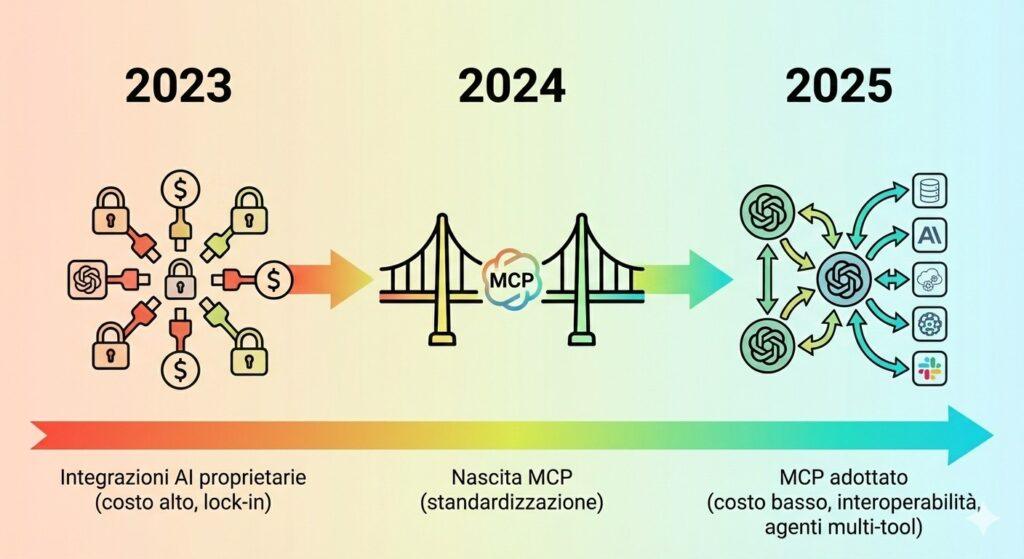

Il Model Context Protocol (MCP) è emerso nel 2024 come la soluzione standardizzata e aperta per superare il principale limite dei moderni modelli di linguaggio (LLM): l’isolamento dai dati e dalle azioni del mondo reale. Definito come “una porta universale” per l’AI, MCP, sviluppato originariamente da Anthropic e rapidamente adottato dai principali player (OpenAI, Google, Microsoft), definisce un linguaggio comune (basato su JSON-RPC) per collegare gli assistenti AI a strumenti, database e applicazioni esterne.

Questo protocollo separa in modo netto la logica del modello dalla complessità delle API sottostanti, introducendo i concetti di Host, Client e Server MCP. Il suo impatto è dirompente: riduce drasticamente i costi di integrazione, elimina il vendor lock-in e abilita la creazione di agenti AI realmente autonomi e multicanale. L’adozione di MCP come standard de facto, rafforzata dal suo trasferimento alla Agentic AI Foundation sotto la Linux Foundation, lo rende l’infrastruttura di base per la prossima generazione di applicazioni e automazioni enterprise basate sull’intelligenza artificiale.

Cosa leggere

Model context protocol: la porta universale per connettere l’AI a dati e sistemi reali

Il model context protocol (MCP), protocollo aperto ideato nel 2024, si è affermato come una delle innovazioni più significative per lo sviluppo dell’intelligenza artificiale applicata. Fino alla sua comparsa, i modelli di linguaggio (LLM) erano entità relativamente chiuse, potenti nella generazione di testo, ma limitate nella capacità di interagire in modo standardizzato con l’infrastruttura aziendale: file, database, strumenti software e applicazioni.

L’MCP, definito da molti come la “colla” che unisce il modello con il mondo reale, risolve questo problema. Non è un prodotto o un’API chiusa, ma uno standard di comunicazione neutrale, paragonabile all’USB-C che ha unificato il collegamento tra dispositivi fisici. Il suo obiettivo è semplice ma rivoluzionario: definire un modo unico, sicuro e riutilizzabile per i modelli di linguaggio di accedere a dati, strumenti e contesto operativo.

Cos’è esattamente il model context protocol

Alla base, il model context protocol è un protocollo open source a livello applicativo che specifica la modalità di dialogo tra un’applicazione AI e un server che eroga funzionalità.

La comunicazione è basata su JSON-RPC 2.0, uno standard che utilizza messaggi strutturati (JSON) per le chiamate a procedure remote, garantendo interoperabilità indipendentemente dal linguaggio di programmazione o dalla piattaforma.

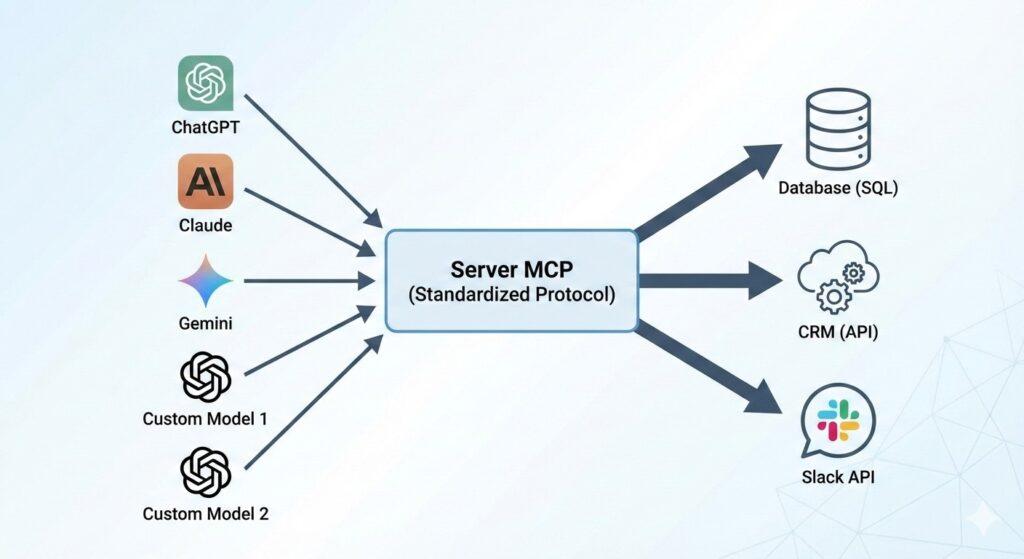

Il concetto fondamentale di MCP è la separazione dei ruoli, che ha un effetto dirompente sulla governance e lo sviluppo:

- L’applicazione AI (Host) non scrive più integrazioni proprietarie.

- I sistemi reali (Database, CRM, API) vengono incapsulati in un Server MCP standard.

- Il Modello AI comunica con il Server MCP attraverso un Client MCP che parla il linguaggio standard.

Questa architettura riduce il lock-in e massimizza il riutilizzo. Se un’azienda espone il proprio sistema di ticketing aziendale come Server MCP, sia un assistente basato su Claude, sia uno basato su Gemini, sia un modello self-hosted potranno interagire con esso utilizzando lo stesso endpoint e lo stesso protocollo.

Come funziona MCP: host, client e server

L’architettura MCP si basa su tre attori distinti che interagiscono in un flusso logico ben definito.

L’host MCP

L’host è l’applicazione che gestisce l’esperienza utente finale. È ciò che l’utente vede e utilizza:

- Un IDE (Integrated Development Environment) con funzionalità di code assistance.

- Una chat aziendale interna o un pannello di controllo.

- Un’applicazione desktop o un assistente vocale.

È l’host che decide, in base al prompt dell’utente, quali modelli interrogare e quali server MCP sono necessari per ottenere il contesto o eseguire un’azione.

Il client MCP

Il client è la componente tecnica che gestisce la connessione a un singolo server MCP. Il suo compito è scoprire l’elenco di strumenti (funzioni invocabili), risorse (dati, file, documenti) e prompt template disponibili su quel server, negoziare la versione del protocollo e inoltrare le richieste generate dal modello.

Il server MCP

Il server MCP è il cuore dell’integrazione con il mondo reale. Esso espone le capacità di uno o più servizi sottostanti. È qui che si scrivono i collegamenti reali: l’interrogazione di un database tramite SQL, la chiamata a un’API REST per un gateway di pagamento, l’attivazione di un workflow in un sistema ERP.

Quando l’utente richiede qualcosa che va oltre la conoscenza interna del modello (ad esempio, “Quanti ticket P1 sono aperti nel CRM?”), il flusso è il seguente:

- L’Host riceve la richiesta.

- Il Modello (ragionando sul prompt) determina di aver bisogno di uno strumento esposto dal Server CRM MCP.

- Il Client MCP invoca la funzione appropriata sul Server.

- Il Server esegue la query SQL sul CRM e restituisce la risposta in un formato strutturato standard.

- Il Modello riceve la risposta come contesto aggiuntivo e formula la risposta finale all’utente.

Questo incapsulamento è il motivo per cui MCP non è “solo un’altra API”: definisce il linguaggio con cui i sistemi si rendono disponibili all’AI, indipendentemente dal modello specifico.

“Differenza tra OpenAPI e Model Context Protocol”

Perché MCP cambia lo sviluppo di applicazioni AI

L’impatto di MCP si riflette su tre aree principali: costi, agenti e sicurezza.

Agenti AI e orchestrazione

L’MCP è fondamentale per l’era degli agenti AI. Un agente non è una semplice chatbot, ma un sistema complesso che deve: mantenere uno stato, prendere decisioni intermedie, eseguire azioni e correggersi. Per fare ciò, necessita di accedere a un ampio arsenale di strumenti esterni in modo affidabile e standardizzato.

MCP fornisce il framework protocollare affinché un agente possa orchestrare più azioni in sequenza, parlando contemporaneamente con Server che gestiscono la documentazione (risorse), il CRM (strumenti di aggiornamento) e Slack (strumenti di comunicazione), tutto all’interno di un singolo flusso definito.

| Vantaggio MCP | Impatto sullo Sviluppo AI |

| Interoperabilità | Elimina il vendor lock-in. È facile migrare da un modello AI all’altro senza rifare le integrazioni con i sistemi core. |

| Riusabilità | Un singolo Server MCP (che espone, ad esempio, la logica di accesso al database) può essere utilizzato da tutti gli Host/Modelli nell’azienda. |

| Riduzione della complessità | Gli sviluppatori si concentrano sulla logica di business del Server, non sul formato proprietario richiesto da ogni singolo modello. |

Sicurezza e governance

L’esposizione di funzionalità a un modello AI è intrinsecamente rischiosa. Tuttavia, MCP spinge verso una maggiore sicurezza perimetrale:

- Visibilità: Le azioni del modello non sono nascoste in script interni, ma passano attraverso il Server MCP, che funge da gateway osservabile e auditabile.

- Controllo: Il Server MCP definisce in modo granulare i parametri e il perimetro di esecuzione degli strumenti. Questo rende più semplice implementare politiche di accesso e identità (IAM) rigorose.

Il rischio, come sottolineato dagli esperti, si sposta sulla corretta configurazione dei Server MCP. Una debole gestione delle identità (ad esempio, l’uso di credenziali statiche con permessi troppo ampi) in combinazione con tecniche di prompt injection può trasformare lo standard in un moltiplicatore di rischio. Per questo, l’attenzione della Agentic AI Foundation si sta concentrando sull’integrazione nativa di MCP con sistemi di autorizzazione Zero Trust.

“Documentazione ufficiale Agentic AI Foundation su MCP e IAM“

Il futuro di MCP sotto la Linux Foundation

L’importanza strategica di MCP è stata confermata nel 2025 dalla decisione congiunta di Anthropic, OpenAI e Block di trasferire il protocollo e i relativi componenti chiave alla nuova Agentic AI Foundation, sotto l’egida della neutrale Linux Foundation.

Questa mossa ha un significato chiaro: evitare la frammentazione e il vendor lock-in, garantendo che MCP diventi uno standard di fatto governato dalla comunità, essenziale per la crescita degli agenti AI. L’obiettivo è stabilire per l’AI applicata ciò che protocolli come HTTP e SMTP hanno stabilito per Internet: una base di comunicazione comune e affidabile.

Per gli sviluppatori e per le aziende, ignorare il Model Context Protocol equivale a ignorare lo standard che governerà le interazioni tra intelligenza artificiale e sistemi IT nei prossimi anni.

Chi sono i principali attori che supportano il Model Context Protocol?

Il Model Context Protocol (MCP) è nato con Anthropic ed è rapidamente supportato e adottato da tutti i principali player dell’AI, inclusi OpenAI, Google DeepMind, Microsoft e Block. La governance del protocollo è stata poi trasferita alla Agentic AI Foundation, sotto l’ombrello della Linux Foundation, per garantirne la neutralità e l’apertura.

Qual è la differenza tra MCP e una normale integrazione API?

Una normale integrazione API è specifica, spesso unidirezionale e legata al formato richiesto da un singolo modello o provider. MCP è un protocollo standard aperto che definisce il linguaggio in cui i sistemi espongono funzionalità (strumenti e risorse) ai modelli. Consente a più modelli e host diversi di accedere allo stesso Server MCP, riducendo la necessità di riscrivere integrazioni proprietarie.

Cos’è un Server MCP e a cosa serve?

Il Server MCP è la componente che incapsula e rende “AI-ready” i sistemi reali (come database, CRM, file system). È il punto di contatto tra la logica di un’applicazione (o di un agente AI) e l’esecuzione di azioni concrete. Il server espone strumenti e risorse in un formato standardizzato basato su JSON-RPC, permettendo al modello di invocare queste funzioni in modo controllato.

Come aiuta MCP a prevenire il vendor lock-in?

Esporre i sistemi aziendali tramite un Server MCP standardizzato fa sì che la logica di integrazione non sia più legata a un singolo modello AI. Se un’azienda decide di cambiare il modello di linguaggio (ad esempio, passando da un vendor all’altro o a una soluzione self-hosted), l’Host AI deve solo reindirizzare il traffico al nuovo modello, mentre il costoso lavoro di integrazione con i sistemi legacy e enterprise (realizzato nel Server MCP) rimane intatto e riutilizzabile.

Iscriviti a Matrice Digitale

Ricevi le notizie principali direttamente nella tua casella di posta.

Niente spam, disiscriviti quando vuoi.