L’ecosistema dell’intelligenza artificiale continua a evolversi a ritmi serrati, trainato da mosse strategiche di colossi come Nvidia e Meta. Nvidia ha rafforzato la sua leadership nel computing ad alte prestazioni (HPC) acquisendo SchedMD, lo sviluppatore principale del gestore di carichi di lavoro open-source Slurm, e lanciando la famiglia di modelli Nemotron 3 ottimizzati per l’efficienza. Parallelamente, Meta sta ridefinendo la sicurezza mobile su Android integrando l’AI generativa per automatizzare l’adozione di framework “secure-by-default”, riducendo drasticamente vulnerabilità critiche come l’hijacking degli intent tramite patch automatiche generate da modelli Llama. Queste iniziative convergono verso un futuro in cui scalabilità, efficienza energetica e sicurezza sono pilastri integrati nello sviluppo software.

Nvidia potenzia l’HPC con l’acquisizione di SchedMD

In una mossa che consolida ulteriormente il suo dominio nel supercomputing e nell’AI, Nvidia ha completato l’acquisizione di SchedMD, la forza trainante dietro Slurm (Simple Linux Utility for Resource Management). Slurm è il sistema di gestione dei carichi di lavoro open-source standard de facto, utilizzato in oltre la metà dei supercomputer della classifica TOP500. Nvidia ha garantito che Slurm rimarrà un software vendor-neutral e open-source, dissipando i timori di un lock-in proprietario. L’obiettivo è accelerare l’ottimizzazione dei carichi di lavoro paralleli complessi sulle piattaforme accelerate Nvidia, garantendo scalabilità e throughput elevati per l’addestramento e l’inferenza di modelli foundation. Questa acquisizione strategicamente posiziona Nvidia al centro dell’orchestrazione delle risorse per l’AI generativa, offrendo supporto diretto a fornitori cloud e laboratori di ricerca globali.

Nemotron 3 e DGX Spark: Efficienza e Potenza Locale

Sul fronte dei modelli e dell’hardware, Nvidia ha introdotto la famiglia Nemotron 3, con il modello di punta Nemotron 3 Nano 30B-A3B. Basato su un’architettura ibrida MoE (Mixture of Experts), questo modello è ottimizzato per task come il debugging software e la summarization, offrendo una finestra di contesto fino a un milione di token e riducendo i costi di inferenza grazie a una gestione efficiente dei token di reasoning. Per supportare lo sviluppo locale, Nvidia ha svelato DGX Spark, un supercomputer AI compatto basato sull’architettura Grace Blackwell con 128 GB di memoria unificata.

In combinazione con framework come Unsloth, DGX Spark permette il fine-tuning rapido di LLM (Large Language Models) direttamente su workstation, riducendo drasticamente il consumo di VRAM e la dipendenza dal cloud. Unsloth, in particolare, accelera il training su GPU GeForce RTX fino a 2,5 volte rispetto ai metodi tradizionali, democratizzando l’accesso a tecniche avanzate come LoRA (Low-Rank Adaptation) e il reinforcement learning.

Meta: AI Generativa per la Sicurezza Android

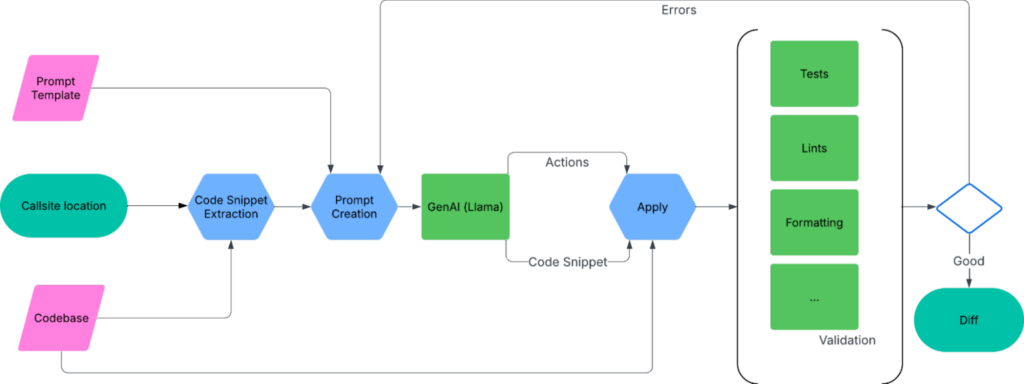

Mentre Nvidia si concentra sull’infrastruttura, Meta sta rivoluzionando la sicurezza delle applicazioni mobili. L’azienda ha sviluppato framework secure-by-default per Android, come SecureLinkLauncher, progettati per avvolgere le funzioni del sistema operativo potenzialmente rischiose e prevenire vulnerabilità come l’intent hijacking. La vera innovazione, tuttavia, risiede nel metodo di adozione: Meta utilizza l’AI generativa basata su modelli Llama per automatizzare la migrazione del codice legacy verso questi nuovi framework sicuri.

L’AI analizza il codice esistente, inferisce il contesto e lo scope (ad esempio, se un’azione deve essere limitata alle app della “famiglia” Meta o restare interna), e genera automaticamente patch correttive. Queste modifiche vengono validate tramite linter, compilazione e test automatizzati, riducendo il carico cognitivo per gli sviluppatori e accelerando l’adozione di standard di sicurezza elevati su codebase immense come quelle di Facebook, Instagram e WhatsApp. Questo approccio ibrido, che combina analisi statica e generazione di codice AI, rappresenta un passo avanti significativo nella protezione dei dati utente su scala globale.

“Blog tecnico di Meta sulla sicurezza Android guidata dall’AI”

Perché Nvidia ha acquisito SchedMD?

Nvidia ha acquisito SchedMD per ottimizzare l’integrazione del gestore di carichi di lavoro Slurm con le sue piattaforme di calcolo accelerato. Questo migliora l’efficienza e la scalabilità dei cluster HPC e AI, pur mantenendo Slurm come progetto open-source e neutrale rispetto ai fornitori hardware.

Che cos’è Nemotron 3 Nano?

Nemotron 3 Nano è un modello di linguaggio di piccole dimensioni (SLM) sviluppato da Nvidia, ottimizzato per l’efficienza e l’esecuzione locale su GPU RTX. Utilizza un’architettura Mixture of Experts per offrire alte prestazioni in task come il debugging e la summarization con bassi costi computazionali.

Come Meta utilizza l’AI per la sicurezza delle app Android?

Meta utilizza modelli di AI generativa (basati su Llama) per scansionare il codice delle sue app Android, identificare usi insicuri delle API di sistema e generare automaticamente patch che migrano il codice verso framework interni “secure-by-default”, prevenendo vulnerabilità come l’hijacking degli intent.

Cos’è Unsloth e come aiuta nel fine-tuning?

Unsloth è un framework open-source che ottimizza il processo di fine-tuning dei Large Language Models (LLM). Grazie a tecniche avanzate di gestione della memoria, permette di addestrare modelli complessi su GPU consumer (come le Nvidia RTX) riducendo significativamente il consumo di VRAM e i tempi di training.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.