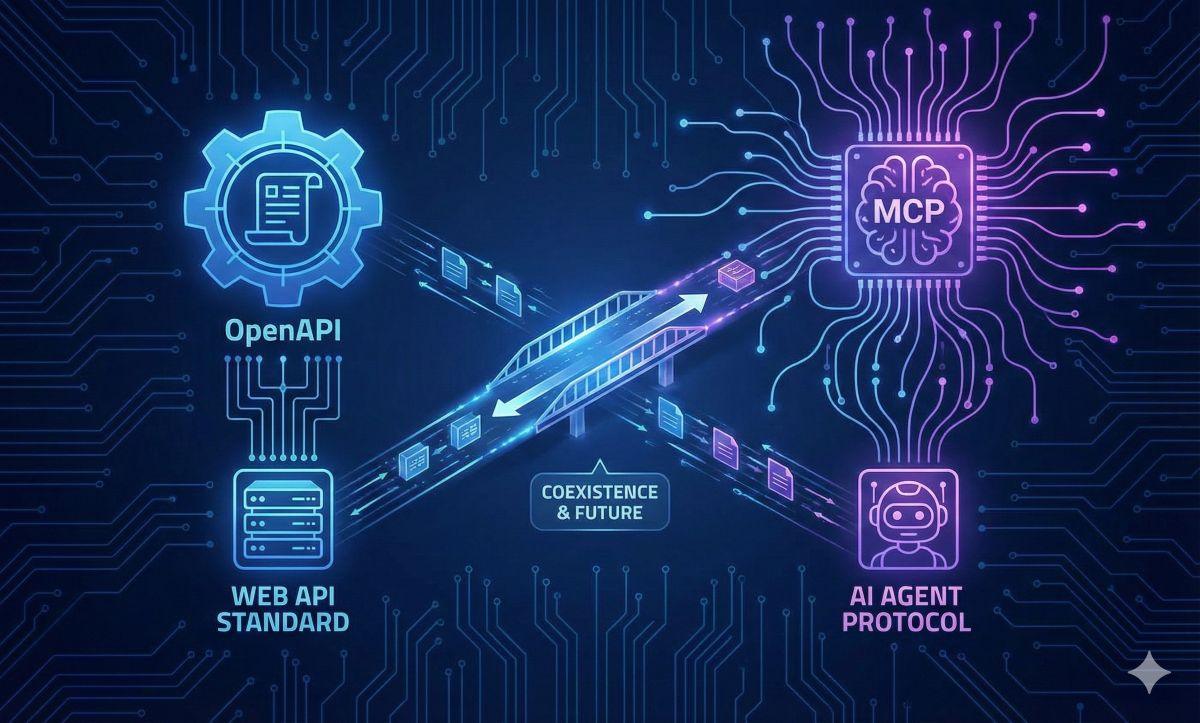

La differenza tra OpenAPI (ex Swagger) e il nuovo Model Context Protocol (MCP) rappresenta il passaggio dall’era del web tradizionale a quella dell’Intelligenza Artificiale agentica. Mentre OpenAPI rimane lo standard de facto per descrivere come due applicazioni software comunicano via HTTP (REST), MCP è stato progettato specificamente per connettere i Modelli di Linguaggio (LLM) ai dati e agli strumenti in modo universale. In sintesi: OpenAPI fornisce la “mappa” statica delle API per sviluppatori umani; MCP fornisce un “adattatore universale” dinamico che permette all’AI di agire, leggere risorse e utilizzare prompt senza bisogno di integrazioni personalizzate per ogni servizio.

Cosa leggere

OpenAPI: Il contratto del web tradizionale

Per capire la rivoluzione portata da MCP, bisogna prima guardare a ciò che ha dominato l’ultimo decennio: OpenAPI. Nato come Swagger, OpenAPI è una specifica che descrive in modo statico e dettagliato come funziona un’API REST. Definisce gli endpoint (es. /users), i metodi (GET, POST), i parametri richiesti e la struttura delle risposte.

È perfetto per gli sviluppatori umani: permette di generare documentazione automatica e SDK client. Tuttavia, quando un modello di Intelligenza Artificiale (LLM) prova a “leggere” un file OpenAPI, incontra spesso problemi:

- Verbosità: Le specifiche possono essere enormi, consumando preziosi token della finestra di contesto del modello.

- Mancanza di contesto: OpenAPI dice come chiamare una funzione, ma non sempre spiega efficacemente quando o perché usarla in uno scenario complesso.

- Staticità: Se l’API cambia, il modello deve rileggere l’intera specifica.

Model Context Protocol (MCP): L’interfaccia nativa per l’AI

L’MCP è nato per risolvere i limiti di OpenAPI nell’era degli agenti intelligenti. Non si limita a descrivere un’API HTTP; crea un protocollo di connessione bidirezionale (basato su JSON-RPC) tra l’AI (il client) e il sistema (il server).

La differenza filosofica è netta. MCP non espone solo “endpoint”, ma tre concetti nativi per l’AI:

- Risorse: Dati che il modello può leggere (come file, log, record database) senza dover fare complesse chiamate GET.

- Prompt: Istruzioni pre-confezionate che aiutano il modello a usare lo strumento nel modo migliore.

- Strumenti (Tools): Funzioni eseguibili che il modello può invocare per compiere azioni.

Mentre OpenAPI richiede che ogni applicazione AI (es. ChatGPT, Claude) scriva un’integrazione specifica (“plugin”) per leggere quella specifica, un server MCP è universale: una volta creato, funziona con qualsiasi client AI compatibile.

Il confronto diretto: Struttura e Utilizzo

La distinzione fondamentale è che OpenAPI è orientato al trasporto (HTTP), mentre MCP è orientato al contesto.

Ecco una sintesi delle differenze chiave:

| Caratteristica | OpenAPI (Swagger) | Model Context Protocol (MCP) |

| Obiettivo | Descrivere API REST per sviluppatori | Connettere dati e tool agli LLM |

| Architettura | Client-Server HTTP statico | Connessione persistente (JSON-RPC) |

| Flessibilità | Richiede codice specifico per ogni API | Adattatore universale (Plug & Play) |

| Gestione Dati | Richiesta/Risposta puntuale | Espone risorse e contesti completi |

| Adozione | Standard globale per il Web | Standard emergente per Agenti AI |

Coesistenza: perché non bisogna scegliere

È importante notare che MCP non uccide OpenAPI. Anzi, spesso i due lavorano insieme. Lo scenario più comune per le aziende oggi è avere i propri servizi backend documentati con OpenAPI, e poi costruire un leggero Server MCP che “avvolge” quelle API.

In questo scenario, il server MCP agisce da curatore: seleziona solo gli endpoint rilevanti dal vasto file OpenAPI, li semplifica e li presenta al modello AI in un formato ottimizzato, fornendo anche i prompt giusti per utilizzarli. OpenAPI resta il motore sotto il cofano; MCP diventa il cruscotto intelligente per l’autista AI.

L’MCP sostituirà OpenAPI?

No, servono a scopi diversi. OpenAPI rimarrà lo standard per la comunicazione tra server e applicazioni web tradizionali. MCP diventerà lo standard per la comunicazione tra sistemi e agenti di Intelligenza Artificiale.

Un LLM può leggere direttamente un file OpenAPI?

Sì, molti modelli moderni possono leggere specifiche OpenAPI. Tuttavia, questo metodo è spesso inefficiente in termini di token e meno affidabile rispetto all’uso di un server MCP, che fornisce un contesto più pulito e strutturato.

Posso usare OpenAPI dentro un server MCP?

Assolutamente sì. Una delle pratiche migliori è creare un server MCP che funge da “wrapper” attorno a una specifica OpenAPI esistente, esponendo al modello AI solo le funzioni necessarie.

Quale è più sicuro?

Entrambi hanno implicazioni di sicurezza. OpenAPI si affida alla sicurezza HTTP (OAuth, API Key). MCP supporta l’autenticazione ma sposta il focus sulla governance dell’agente, introducendo spesso meccanismi di “Human-in-the-loop” (approvazione umana) prima di eseguire azioni critiche.

Iscriviti a Matrice Digitale

Ricevi le notizie principali direttamente nella tua casella di posta.

Niente spam, disiscriviti quando vuoi.