Google introduce Gemini 3 Flash, aggiorna l’ecosistema AI tra app, ricerca, strumenti per sviluppatori, istruzione e business, e consolida una strategia che punta a combinare intelligenza di frontiera, velocità operativa e scalabilità industriale. Nel primo periodo emergono i nodi centrali: Gemini 3 Flash, integrazione nativa in app Gemini e Search, nuove capacità multimodali, un rafforzamento della sicurezza dei contenuti generati, e un’espansione degli agenti AI come leva di produttività. L’aggiornamento segna un passaggio strutturale nel 2025, perché riduce i compromessi storici tra potenza e latenza, estende l’AI a contesti edge e professionali, e allinea l’offerta alle pressioni normative e di mercato. La traiettoria è chiara: risposte più rapide, ragionamenti più profondi, costi più bassi, e una governance più visibile dei contenuti sintetici.

Lancio di Gemini 3 Flash tra intelligenza di frontiera e velocità

Google annuncia Gemini 3 Flash come modello progettato per superare il trade-off tra modelli potenti ma lenti e modelli rapidi ma limitati. La novità risiede nell’architettura ottimizzata per latenza ridotta senza sacrificare ragionamento avanzato, con prestazioni che raggiungono livelli da ricerca accademica su benchmark complessi. Gemini 3 Flash diventa la modalità predefinita nell’app Gemini e in AI Mode di Search, spostando l’esperienza quotidiana verso risposte contestualizzate in pochi secondi. La gestione multimodale consente analisi su immagini e video, trasformando brevi clip in piani d’azione o sintesi operative. La velocità dichiarata, superiore alle generazioni precedenti, rende il modello adatto a flussi agentici e a interazioni ad alta frequenza, dove il tempo di risposta incide direttamente sulla produttività.

Dal punto di vista industriale, la piattaforma scala su volumi elevatissimi, con l’API di Gemini che processa oltre un trilione di token al giorno, e introduce caching del contesto per ridurre i costi operativi fino al 90%. Il posizionamento economico punta a favorire l’adozione in produzione, mantenendo prezzi competitivi per milione di token e un profilo di efficienza adatto a servizi consumer e enterprise. Aziende di software applicativo adottano Gemini 3 Flash per operazioni rapide e coding agentico, con risultati di rilievo nei test di affidabilità sullo sviluppo software.

App Gemini e ricerca, un ecosistema che diventa operativo

L’aggiornamento dell’app Gemini rende Gemini 3 Flash il cuore dell’esperienza, affiancando modalità rapide per richieste quotidiane e opzioni più profonde per problemi complessi. Restano disponibili modelli dedicati alla matematica avanzata, mentre l’editing immagini evolve con strumenti di selezione precisa che consentono modifiche mirate tramite gesti naturali. L’integrazione con NotebookLM rafforza la tracciabilità delle risposte, ancorandole alle fonti caricate e migliorando la sintesi visuale dei risultati.

In Search, l’AI Mode assume un ruolo centrale per le domande sfumate e contestuali, combinando informazioni in tempo reale, risultati locali e segnali visivi. Le valutazioni e le foto di Maps entrano nel flusso conversazionale, rendendo la ricerca più decisionale. L’accesso a funzionalità avanzate cresce per gli abbonati, con limiti più alti e strumenti creativi estesi, mentre la generazione di immagini e presentazioni beneficia di pipeline più robuste. L’effetto complessivo è una ricomposizione della ricerca da elenco di link a interfaccia di lavoro, capace di accompagnare l’utente dalla domanda all’azione.

Strumenti per sviluppatori, dall’edge al cloud

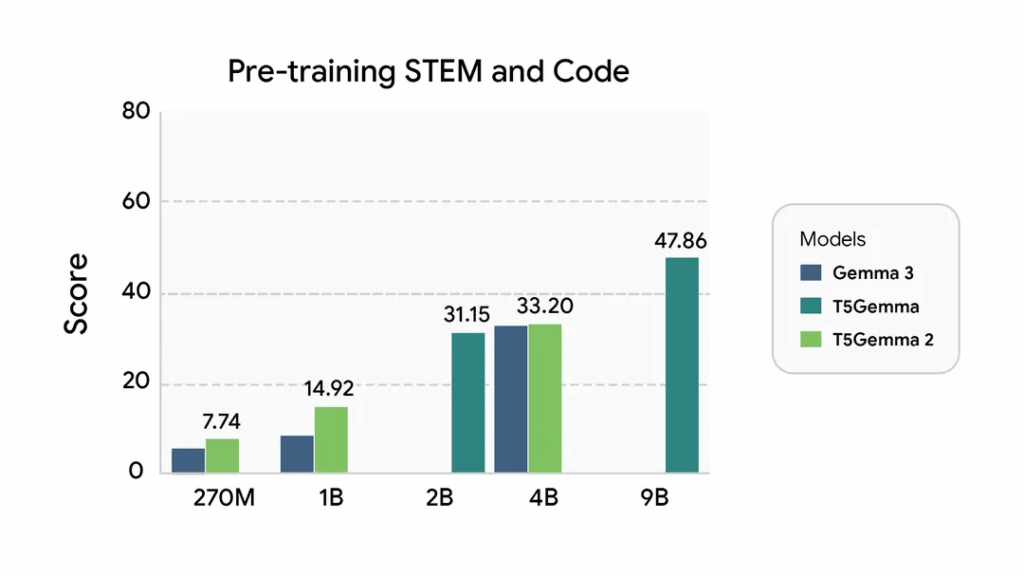

Sul fronte developer, Google amplia l’offerta con T5Gemma 2, evoluzione encoder-decoder basata su Gemma 3 che riduce i parametri grazie a embedding legati e introduce un’attenzione unificata più efficiente. Il contesto esteso fino a 128K token e il supporto multimodale rafforzano l’uso in scenari multilinguali e cross-media. I checkpoint pre-addestrati accelerano la sperimentazione e l’adozione in pipeline esistenti.

Con FunctionGemma, il function calling arriva su edge, aprendo a dispositivi leggeri e a comportamenti deterministici offline. L’approccio sposta l’AI dal dialogo all’azione, consentendo l’esecuzione di comandi locali e simulazioni in browser, con casi d’uso che vanno dai controlli mobile alle esperienze interattive. Google AI Studio consolida la gestione delle API con dashboard di logging e monitoraggio, mentre l’ecosistema Android beneficia di integrazioni rapide per personalizzazioni su Wear OS. L’insieme disegna una catena completa che va dall’addestramento al deployment, riducendo attriti e tempi di messa in produzione.

NotebookLM evolve tra tabelle e presentazioni

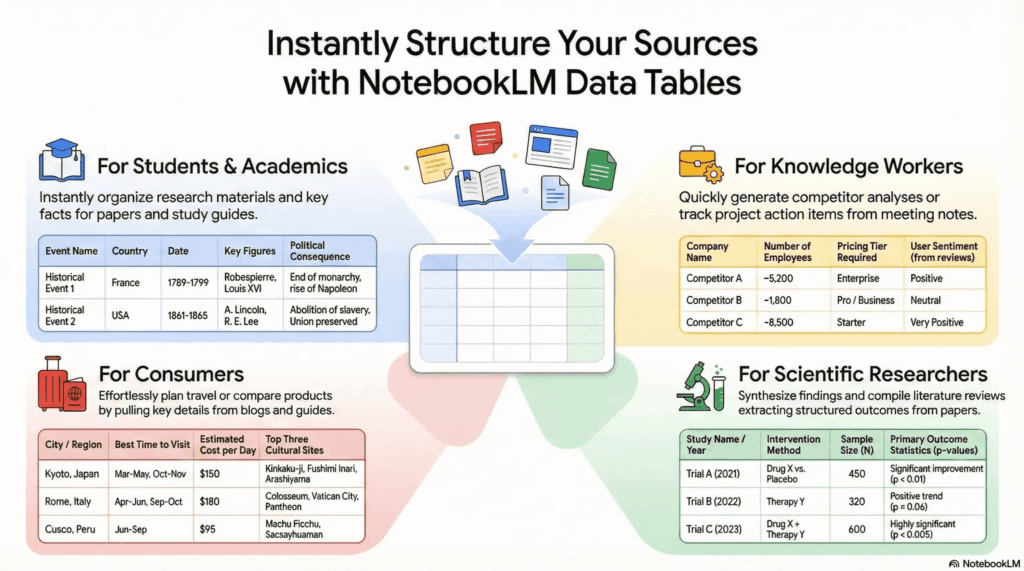

NotebookLM introduce Data Tables per trasformare fonti eterogenee in strutture esportabili. La funzione organizza informazioni sparse in tabelle operative, utili per riunioni, studi clinici, preparazione di esami e pianificazione. La sintesi strutturata diventa un acceleratore cognitivo, riducendo il tempo necessario a passare dal materiale grezzo all’insight.

Parallelamente, la generazione di slide deck evolve in narrazioni visive coerenti. La conversione di report in presentazioni tematiche, con stili adattabili, consente di gestire contenuti lunghi come storyboard e di visualizzare dati complessi attraverso metafore. L’obiettivo è chiaro: spostare l’AI dal riassunto al racconto operativo, dove la forma visiva sostiene decisioni e comunicazione.

Educazione e capitale umano, l’AI come infrastruttura didattica

Google rafforza l’impegno nell’educazione con programmi pilota che restituiscono tempo agli insegnanti e sperimentazioni che mostrano un uso creativo dell’AI da parte degli studenti. L’annuncio di Gemini for Education per le high school statunitensi segna l’ingresso strutturale dell’AI nei curricula, accompagnato da 137 milioni di euro in grant dedicati. I report sui giovani europei indicano un ottimismo diffuso verso l’AI, con un impatto percepito positivo sull’apprendimento, a fronte di una richiesta esplicita di formazione responsabile e design trasparente.

La strategia educativa non separa competenze tecniche e valori. L’ascolto delle voci giovani e l’attenzione alle competenze critiche diventano parte integrante dell’adozione, riducendo il rischio di un uso opaco degli strumenti. L’AI si configura come infrastruttura didattica, non come scorciatoia, con benefici misurabili sul tempo e sulla qualità dell’apprendimento.

Agenti AI e produttività, il ponte verso il 2026

Le prospettive di business indicano gli agenti AI come vettore principale di trasformazione. L’automazione delle routine, la gestione di flussi complessi e le esperienze concierge personalizzate ridisegnano i processi. I casi aziendali mostrano riduzioni significative dei tempi, traduzioni automatiche verso query strutturate e diminuzione dei falsi positivi nella sicurezza operativa. L’interoperabilità tra agenti, supportata da protocolli dedicati, diventa un requisito per scalare in ambienti eterogenei.

L’impatto si estende alla sicurezza, dove l’AI gestisce alert e correla segnali, e alla customer experience, dove la personalizzazione aumenta l’efficacia. Il valore emerge quando l’AI si integra nei sistemi esistenti e produce risultati tangibili, non quando resta confinata a demo.

Sicurezza dei contenuti e contrasto agli abusi

La sicurezza rimane una priorità dichiarata. Google avvia un’azione legale contro SerpApi per contrastare lo scraping illegale che aggira le misure di protezione e rivende contenuti licenziati. La mossa segnala un irrigidimento verso gli abusi in un contesto di aumento delle attività malevole.

Sul fronte della verifica dei contenuti, l’app Gemini introduce il rilevamento dei watermark SynthID nei video generati da AI. Gli utenti possono caricare file per identificare segmenti sintetici e ottenere risposte contestualizzate sull’origine dei contenuti. La trasparenza diventa un elemento operativo, non solo dichiarativo, e contribuisce a ricostruire fiducia in un ecosistema saturo di media generativi.

Compliance normativa e scelte per gli utenti

La conformità al Mobile Software Competition Act in Giappone porta schermate di scelta per browser e ricerca e l’espansione dello User Choice Billing. L’obiettivo è rafforzare le opzioni per utenti e sviluppatori mantenendo un modello di piattaforma aperta. In parallelo, Google Play lancia iniziative stagionali che ampliano l’accesso a contenuti digitali, mentre le funzionalità di personalizzazione delle fonti nelle notizie aumentano la visibilità dei siti selezionati dagli utenti. L’insieme delle misure indica una strategia di adattamento regolatorio che non rallenta l’innovazione, ma la incanala in percorsi compatibili con le norme locali e con le aspettative di trasparenza.

Un ecosistema che diventa infrastruttura

L’aggiornamento complessivo consolida il ruolo di Google nell’innovazione AI del 2025. Gemini 3 Flash riduce la distanza tra potenza e velocità, l’app Gemini e Search diventano strumenti operativi, gli sviluppatori ottengono una catena completa dal cloud all’edge, l’educazione riceve investimenti mirati, e la sicurezza dei contenuti acquisisce strumenti verificabili. Il risultato è un ecosistema che smette di essere collezione di feature e assume la forma di infrastruttura, pronta a sostenere agenti, flussi e decisioni su scala globale.

Domande frequenti su Gemini 3 Flash

Quali sono i vantaggi principali di Gemini 3 Flash rispetto ai modelli precedenti?

Gemini 3 Flash offre un equilibrio ottimale tra velocità e intelligenza, superando i compromessi tra modelli rapidi ma limitati e modelli potenti ma lenti. È tre volte più veloce di Gemini 2.5 Pro e riduce i costi di contesto fino al 90%.

Come posso utilizzare la nuova funzione Nano Banana nell’app Gemini?

Nano Banana è uno strumento di editing immagini integrato nell’app Gemini. Per usarlo, basta caricare o generare un’immagine e circondare con il dito l’area che si desidera modificare, permettendo all’AI di applicare cambiamenti precisi e localizzati.

Cos’è T5Gemma 2 e a chi è rivolto?

T5Gemma 2 è un modello AI avanzato per sviluppatori, basato sull’architettura encoder-decoder di Gemma 3. È ideale per applicazioni che richiedono analisi multimodale e multilingua, supportando contesti estesi fino a 128K token e ottimizzato per piattaforme come Hugging Face.

In che modo NotebookLM migliora la produttività con le Data Tables?

La funzione Data Tables di NotebookLM permette di estrarre e organizzare automaticamente informazioni sparse da documenti e fonti diverse in tabelle strutturate ed esportabili. È utile per sintetizzare dati da riunioni, trial clinici o pianificazioni complesse.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU...