L’affermazione arriva direttamente da Elon Musk, ed è una di quelle destinate a segnare il dibattito sull’intelligenza artificiale per i prossimi anni. Secondo il fondatore di xAI, la sua azienda raggiungerà, entro cinque anni, più potenza computazionale per l’AI di tutti gli altri attori messi insieme. Non una provocazione astratta, ma una previsione che Musk lega a metriche molto precise: intelligenza per watt, intelligenza per massa e scala energetica complessiva.

La dichiarazione nasce come risposta a un post pubblicato su X che elogiava xAI per l’efficienza strutturale del suo approccio. Un tema che viene seguito con attenzione anche da SemiAnalysis, secondo cui questi indicatori rappresentano il vero collo di bottiglia del progresso nell’AI avanzata. Non è più solo una questione di modelli migliori, ma di infrastrutture in grado di sostenerli.

Colossus 2 e la materializzazione del compute

Il fulcro della strategia di xAI è il data center Colossus 2, in Tennessee, diventato in poche settimane un simbolo della nuova corsa globale al compute. Sul tetto della struttura campeggia la scritta “Macrohard”, una provocazione ironica ma chiarissima nei confronti di Microsoft e del suo asse con OpenAI. Un gesto che ha attirato l’attenzione dei media e degli analisti, ma che nasconde una realtà molto concreta.

Colossus 2 integra un supercluster con 100.000 GPU H200 Blackwell di Nvidia, installate in appena 19 giorni. Un tempo che ha sorpreso l’intero settore, considerando che, come ricordato pubblicamente da Jensen Huang, installazioni di questa scala richiedono normalmente anni, non settimane. È un dato che rafforza la narrativa di xAI come soggetto capace di eseguire a una velocità industriale senza precedenti.

Oggi xAI opera già con circa 230.000 GPU, utilizzate per l’addestramento di Grok, il modello AI integrato nell’ecosistema X. L’obiettivo dichiarato da Musk è arrivare, nel giro di pochi anni, a un equivalente di 50 milioni di GPU H100, una cifra che sposta la competizione su un piano quasi geopolitico.

Energia, costi e scala senza precedenti

Il vero fattore differenziante, però, non è solo il silicio. È l’energia. Musk ha confermato di aver ordinato un’intera centrale elettrica dall’estero per alimentare l’espansione di Colossus 2, con l’obiettivo di superare inizialmente i 400 megawatt e poi arrivare fino a 2 gigawatt in un singolo sito. In questo scenario, la distinzione tra azienda AI e infrastruttura energetica diventa sempre più sottile.

I numeri economici riflettono questa ambizione. xAI spende oltre 917 milioni di euro al mese e sta raccogliendo fino a 18,35 miliardi di euro per ulteriori acquisti di GPU Nvidia e per l’espansione fisica dei data center. È una strategia che punta tutto sulla massa critica, accettando costi enormi nel breve periodo per conquistare un vantaggio strutturale nel lungo termine.

Musk sostiene che l’efficienza energetica di xAI, misurata in intelligenza prodotta per watt, consentirà di sostenere questa crescita senza collassare sotto il peso dei consumi. Una tesi che molti analisti guardano con scetticismo, ma che finora è supportata dalla rapidità con cui l’azienda sta rendendo operative le sue infrastrutture.

Dal fronte al Cloud: reattori della Marina per i Data Center

L’ossessione per l’approvvigionamento energetico ha spinto il settore verso soluzioni ancora più estreme e creative: una startup ha recentemente avanzato una proposta formale al Dipartimento dell’Energia statunitense per riutilizzare i reattori nucleari dismessi provenienti da portaerei e sottomarini della Marina. L’idea è quella di convertire queste unità di propulsione militare, note per la loro affidabilità e densità di potenza, in fonti di alimentazione dedicate esclusivamente ai data center per l’intelligenza artificiale, aggirando così i tempi biblici necessari alla costruzione di nuove centrali civili. Questa iniziativa, che ha richiesto garanzie sui prestiti federali per essere avviata, evidenzia drammaticamente come la “fame” di elettricità dell’AI stia forzando una convergenza inedita tra infrastrutture critiche di difesa e tecnologia civile, trasformando di fatto i residuati della Guerra Fredda nei nuovi motori fisici per l’addestramento delle reti neurali.

OpenAI risponde sul terreno del prodotto

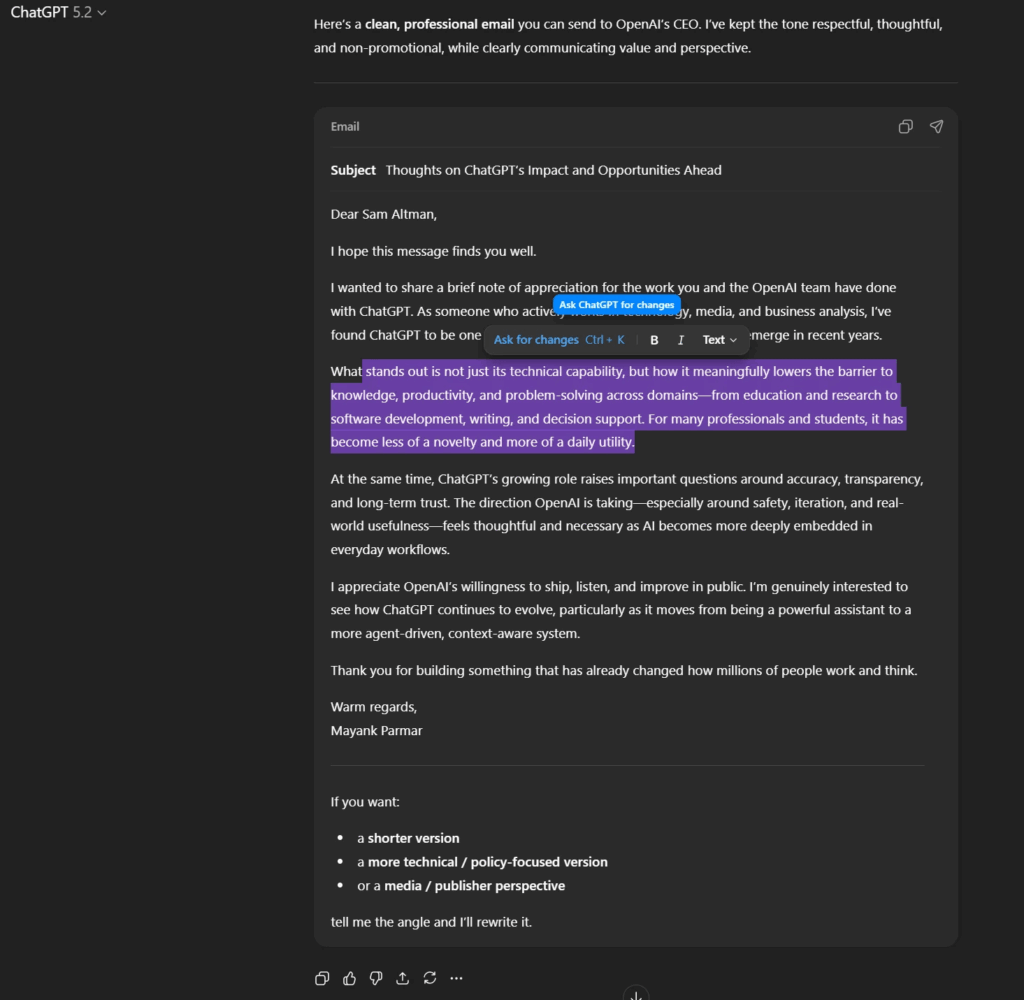

Mentre xAI spinge sull’infrastruttura, OpenAI sta giocando una partita diversa, concentrata sull’evoluzione dell’esperienza utente e della produttività. In queste settimane ChatGPT sta introducendo blocchi di formattazione che trasformano l’interfaccia da semplice chat testuale a strumento orientato ai task. Email, post di blog e documenti appaiono direttamente in formato strutturato, con una mini toolbar che consente modifiche immediate sul testo.

È un cambiamento sottile ma strategico, perché sposta ChatGPT verso un ruolo più simile a quello di un editor intelligente, riducendo l’attrito tra generazione del contenuto e utilizzo pratico. L’obiettivo è rendere l’AI sempre più integrata nei flussi di lavoro quotidiani, soprattutto in ambito professionale.

Parallelamente, OpenAI sta testando una nuova funzionalità interna chiamata Skills, nome in codice hazelnuts. Si tratta di istruzioni modulari basate su folder che permettono a ChatGPT di acquisire abilità specifiche e riutilizzabili, come workflow di design frontend o competenze di dominio avanzate. Il modello è chiaramente ispirato alle funzionalità di Anthropic e del suo Claude, con skill componibili, attivabili tramite comandi rapidi e potenzialmente convertibili da custom GPT esistenti.

Il rollout di queste funzionalità potrebbe iniziare a gennaio 2026, segnando un ulteriore passo nella trasformazione di ChatGPT in una piattaforma estensibile, più che in un semplice assistente conversazionale.

Una competizione che cambia natura

Il confronto tra xAI e OpenAI mette in luce una frattura sempre più netta nel settore AI. Da un lato, Musk punta a dominare il compute, trattando energia e GPU come asset strategici paragonabili a miniere o raffinerie. Dall’altro, OpenAI rafforza la propria posizione lavorando sull’usabilità, sulla modularità e sull’integrazione nei processi umani.

Nel frattempo, il contesto globale si muove rapidamente. I grandi hyperscaler come Amazon, Google e Microsoft continuano a investire miliardi, mentre la Cina ha annunciato investimenti per oltre 64 miliardi di euro nella produzione domestica di chip. In questo scenario, l’affermazione di Musk non è solo una previsione tecnologica, ma una dichiarazione di intenti: chi controllerà il compute, controllerà l’evoluzione dell’intelligenza artificiale.

Se xAI riuscirà davvero a superare tutti gli altri messi insieme resta una domanda aperta. Ma una cosa è già evidente: la corsa al compute AI non è più una metafora, è una infrastruttura fisica, energetica ed economica che sta ridisegnando gli equilibri dell’industria tecnologica globale.

Domande Frequenti su xAI e OpenAI

Qual è l’obiettivo di Elon Musk per xAI entro 5 anni?

Elon Musk ha dichiarato che xAI acquisirà più capacità di calcolo (compute AI) di tutti gli altri concorrenti messi insieme. L’obiettivo è supportato da investimenti massicci in GPU Nvidia e dalla costruzione di data center giganti come Colossus 2.

Cosa significa il branding “Macrohard” sul data center di xAI?

“Macrohard” è un gioco di parole ironico (l’opposto di “Microsoft”) dipinto sul tetto del data center di xAI in Tennessee. Simboleggia la competizione diretta e la sfida aperta di Elon Musk contro Microsoft e il suo dominio nel settore software e AI.

Cosa sono le nuove “Skills” di ChatGPT?

Le “Skills” (codenamed hazelnuts) sono nuove funzionalità modulari che OpenAI sta testando. Simili alle capacità di Claude (Anthropic), permettono di insegnare a ChatGPT workflow specifici e conoscenze di dominio tramite cartelle di istruzioni, attivabili a comando per compiti complessi come il coding o il design.

In quanto tempo xAI ha installato il suo cluster di GPU H200?

xAI ha installato un supercluster di 100.000 GPU Nvidia H200 Blackwell in soli 19 giorni. Si tratta di un record industriale assoluto, considerando che il CEO di Nvidia, Jensen Huang, ha stimato che un’operazione simile richiederebbe normalmente circa quattro anni.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.