Nvidia ha usato il Ces 2026 come palco strategico per ridefinire l’evoluzione del computing accelerato, presentando Rubin, una piattaforma AI codesignata di nuova generazione, una spinta decisa sui modelli AI open e un rafforzamento dell’ecosistema per autonomia veicoli. L’insieme degli annunci disegna una traiettoria chiara: l’AI non è più confinata ai data center hyperscale, ma diventa infrastruttura trasversale, dal gaming domestico fino ai veicoli autonomi e alle AI factory enterprise.

Rubin e il salto architetturale del computing AI

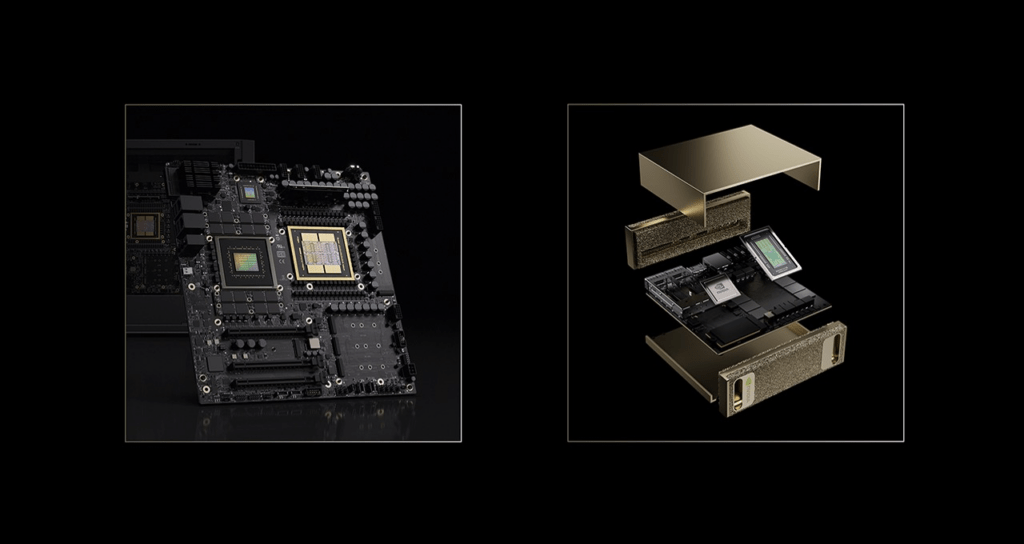

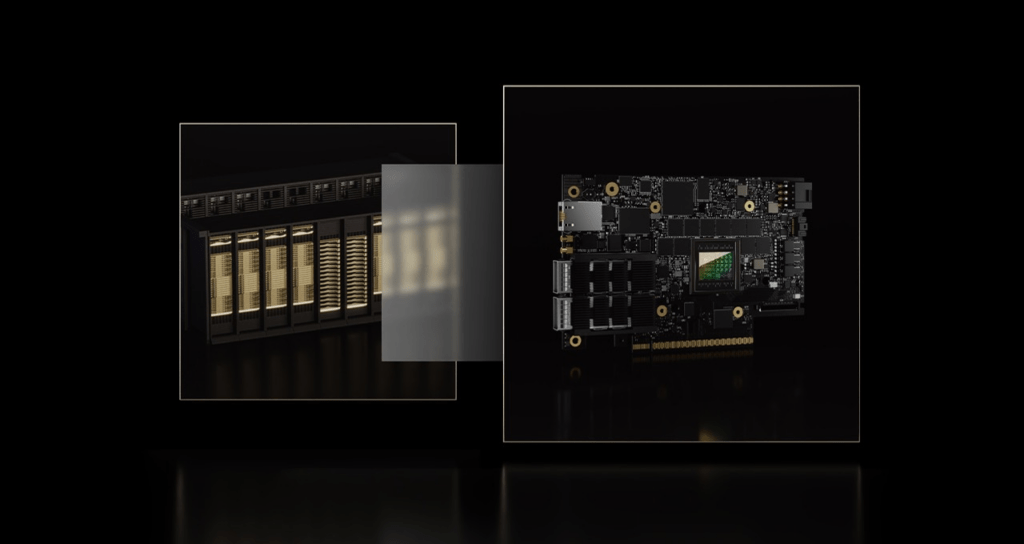

Rubin rappresenta la prima piattaforma Nvidia extreme-codesignata con sei chip integrati in un unico sistema, pensata per abbattere drasticamente i costi e le latenze dell’inferenza AI. Al centro c’è la GPU Rubin, capace di raggiungere 50 petaflops in NVFP4, supportata da una terza generazione di Transformer Engine che introduce compressione hardware nativa per modelli di frontiera e agentic AI.

La componente CPU è affidata a Vera, un processore Armv9.2 con 88 core Olympus, progettato per lavorare in modo simbiotico con la GPU attraverso NVLink-C2C. L’interconnessione NVLink 6 spinge la banda fino a 3,6 TB/s per GPU, rendendo Rubin particolarmente adatta a workload complessi come Mixture of Experts e modelli a contesto esteso.

A completare la piattaforma arrivano ConnectX-9 SuperNIC, BlueField-4 DPU e Spectrum-6 Ethernet Switch, che spostano networking e sicurezza direttamente in hardware. La seconda generazione di Confidential Computing protegge i dati a livello rack-scale su CPU, GPU e fabric NVLink, mentre il nuovo RAS Engine consente monitoraggio continuo dello stato del sistema e interventi di servicing tre volte più rapidi grazie a tray modulari senza cablaggi.

DGX SuperPOD e AI factory su scala industriale

Rubin non nasce come prodotto isolato, ma come base per le nuove AI factory. Il DGX SuperPOD aggiornato integra la piattaforma in configurazioni estreme come DGX Vera Rubin NVL72, che combina 36 CPU Vera, 72 GPU Rubin e 18 BlueField-4 DPU, raggiungendo 28,8 exaflops FP4 e 600 TB di memoria veloce.

La variante DGX Rubin NVL8 permette di scalare fino a 512 GPU su 64 sistemi, offrendo un incremento di 5,5 volte le prestazioni NVFP4 rispetto a Blackwell. Il risultato è una riduzione stimata di 10 volte del costo per token in inferenza, un fattore che rende economicamente sostenibili modelli agentici e sistemi di reasoning avanzato.

La gestione dell’infrastruttura è affidata a Mission Control, software che orchestra non solo carichi AI, ma anche power e cooling, rendendo il data center un sistema integrato e governabile come una singola entità.

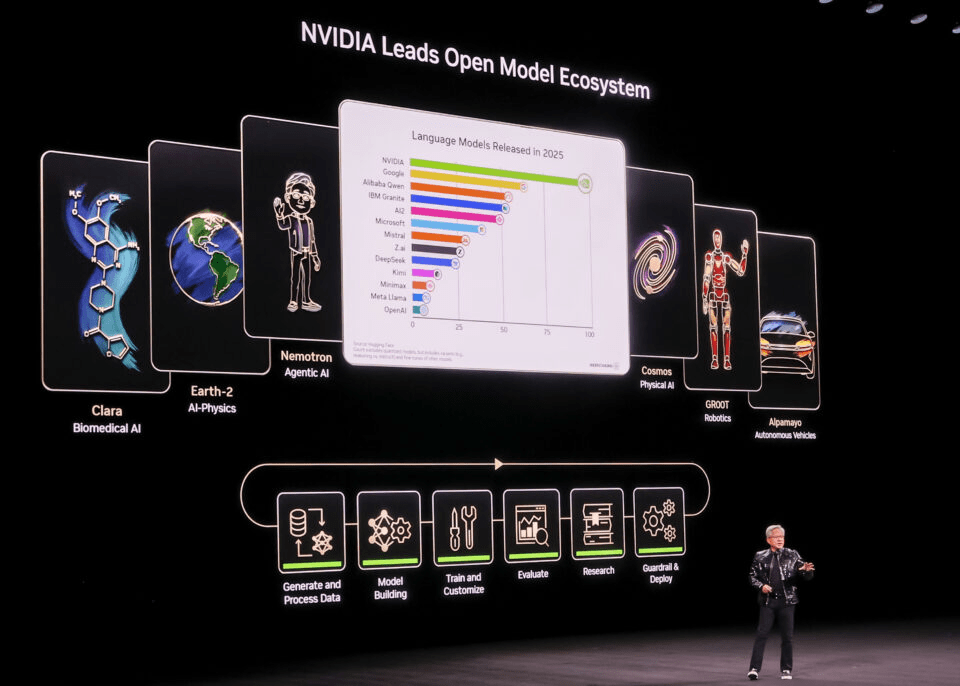

AI open: modelli, dati e tool come acceleratore di ecosistema

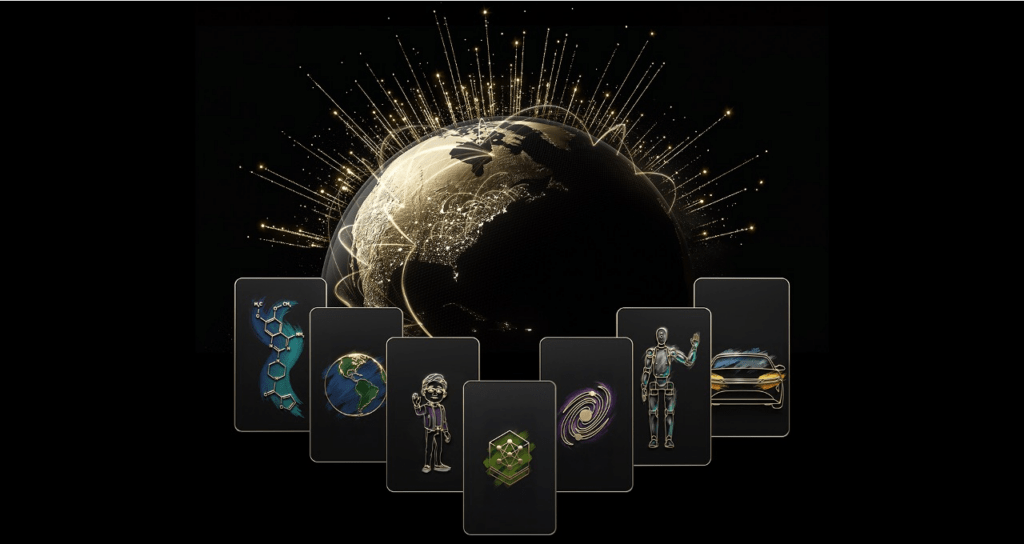

Accanto all’hardware, Nvidia spinge con decisione sull’AI open. La famiglia Nemotron viene ampliata con modelli per speech, multimodal RAG e safety, accompagnati da dataset aperti distribuiti su Hugging Face. La piattaforma Cosmos introduce strumenti per la generazione di video sintetici e reasoning applicato alla robotica, con Cosmos Reason 2 come VLM per embodied AI.

Nel dominio automotive emerge Alpamayo, una famiglia di modelli VLA open pensati per la guida autonoma. Alpamayo R1 viene presentato come il primo reasoning VLA open per veicoli, affiancato da AlpaSim per la simulazione avanzata. Nvidia dichiara dataset che superano 10 trilioni di token linguistici, 500.000 traiettorie robotiche e 100 terabyte di dati sensoriali, un patrimonio che rende questi modelli immediatamente applicabili in sanità, robotica e mobilità.

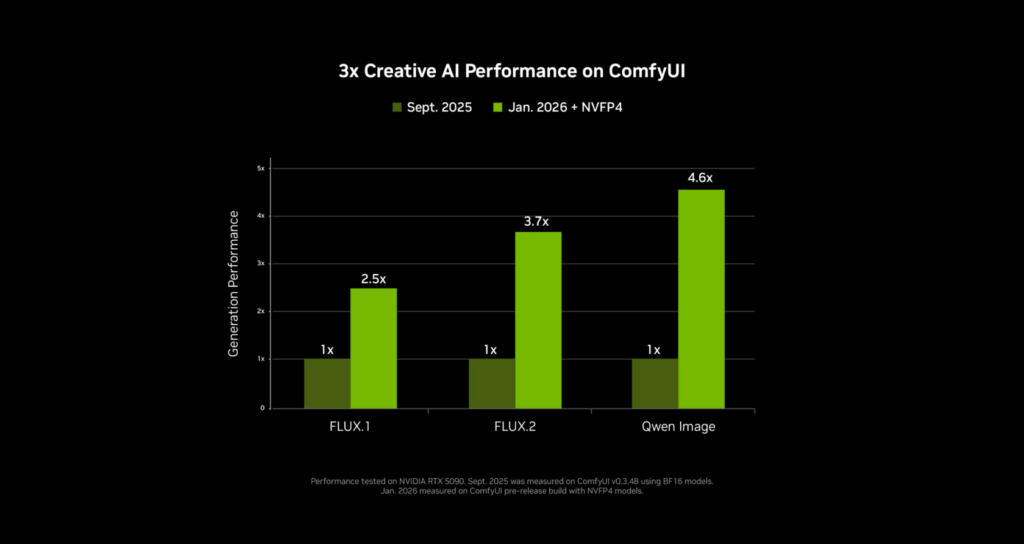

Lato toolchain, i NIM microservices semplificano il deployment dei modelli su infrastrutture Nvidia, mentre RTX AI Garage porta l’AI generativa anche su PC, con accelerazioni per video 4K grazie a LTX-2 di Lightricks. Progetti come ComfyUI, Ollama e llama.cpp ottengono incrementi fino al 35% nelle prestazioni di inferenza, soprattutto su modelli MoE come Nemotron 3.

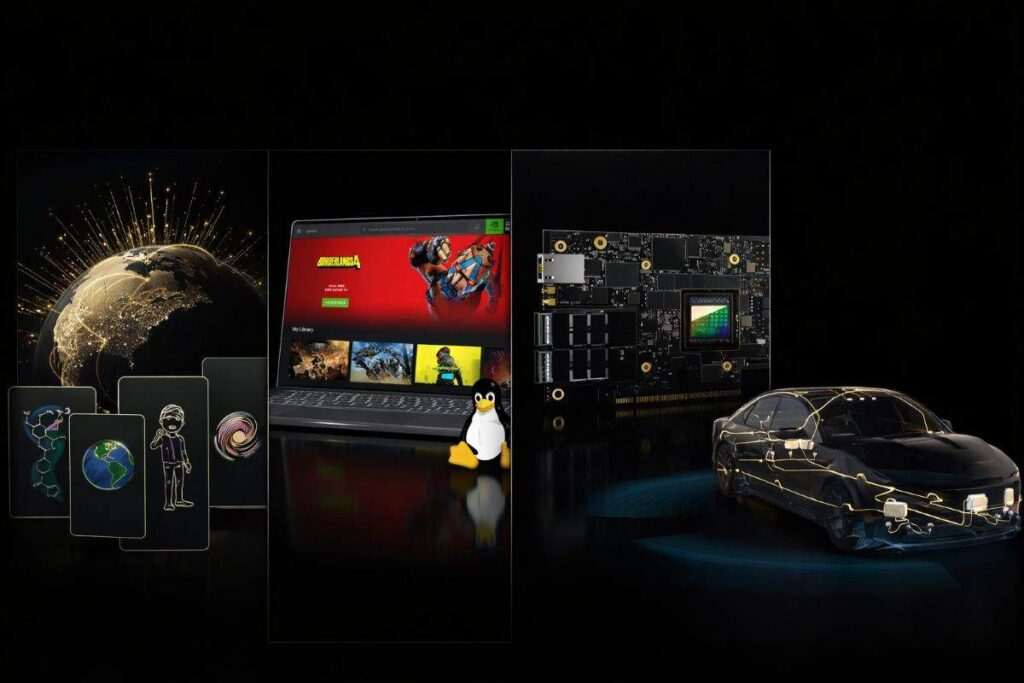

Gaming: DLSS 4.5 e il salto verso i 240 fps in path tracing

Nel gaming, Nvidia consolida la leadership con DLSS 4.5, che introduce Dynamic Multi Frame Generation in modalità 6X. La tecnologia genera fino a cinque frame aggiuntivi per ogni frame renderizzato, rendendo possibili 240+ fps anche in path tracing su RTX 50 Series. Il nuovo Transformer di seconda generazione per la Super Resolution è già disponibile tramite NVIDIA App. Oltre 250 giochi supportano DLSS 4, inclusi titoli ad alta visibilità come ARC Raiders, Battlefield 6 e nuove produzioni come 007 First Light. Sul fronte display, i monitor G-SYNC Pulsar promettono una chiarezza di movimento oltre i 1.000 Hz, con regolazioni automatiche della luminosità tramite Ambient Adaptive Technology.

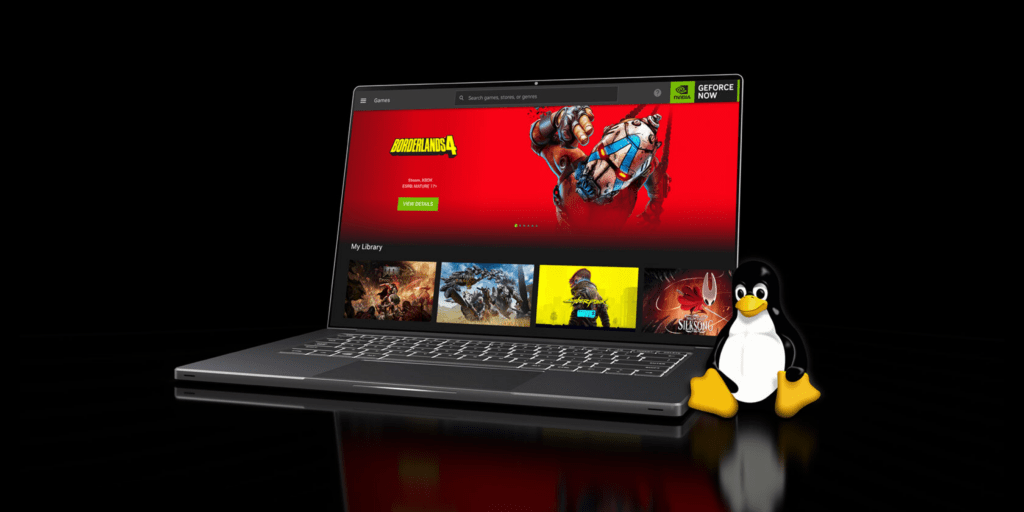

L’ecosistema si espande anche sul cloud: GeForce NOW arriva con app native per Linux Ubuntu 24.04+ e Amazon Fire TV 4K, supportando streaming fino a 5K 120 fps o 1080p 360 fps su server RTX 5080.

Autonomia veicoli e DRIVE Hyperion

Sul fronte automotive, Nvidia rafforza DRIVE Hyperion come piattaforma di riferimento per la guida autonoma avanzata. L’architettura combina due SoC DRIVE AGX Thor basati su Blackwell, capaci di 2.000 teraflops FP4, con fusione sensoriale a 360 gradi e supporto nativo per transformer perception e VLA models.

Il framework Halos viene utilizzato per validare la sicurezza secondo standard globali, integrando simulazioni su larga scala. Un caso emblematico è Mercedes-Benz, che integra DRIVE AV sulla nuova CLA, offrendo assistenza di livello avanzato con navigazione urbana point-to-point, avoidance proattivo delle collisioni e parcheggio automatico. Lo stack AI opera in parallelo ai sistemi di sicurezza tradizionali, con aggiornamenti over-the-air per MB.DRIVE ASSIST PRO. L’ecosistema si estende anche a operatori come Uber per veicoli passenger di livello 4, con prospettive di applicazione nel trasporto merci a lungo raggio.

Enterprise AI e sicurezza zero-trust

In ambito enterprise, Nvidia posiziona BlueField come pilastro per la cybersecurity zero-trust nelle AI factory. Soluzioni come DOCA Argus offrono visibilità in tempo reale su ingestion, fine-tuning e inference, mentre partnership con vendor di sicurezza consentono enforcement delle policy direttamente a livello hardware.

La linea DGX Spark e DGX Station porta capacità di supercomputing anche in formato deskside, con supporto a modelli open come Llama 4 e Qwen3 e incrementi fino al 35% in vLLM. Spark è disponibile immediatamente, mentre Station arriverà in primavera tramite partner come Acer e Dell.

Nvidia come architrave dell’AI ubiqua

La presentazione di Jensen Huang al Ces 2026 ha chiarito la visione: l’AI deve scalare su ogni dispositivo, dal data center al PC, fino all’automobile. Con Rubin, modelli open e un ecosistema software sempre più integrato, Nvidia consolida il ruolo di architrave del computing accelerato, trasformando l’AI in una piattaforma universale che ridisegna gaming, enterprise e mobilità.

Domande frequenti su Nvidia al CES

Cos’è la piattaforma Rubin presentata al Ces 2026?

Rubin è una piattaforma AI codesignata con sei chip che combina GPU, CPU, networking e sicurezza per ridurre fino a 10 volte i costi di inferenza rispetto a Blackwell.

Perché Nvidia punta sui modelli AI open?

I modelli open come Nemotron, Cosmos e Alpamayo accelerano l’adozione globale dell’AI, favorendo integrazione rapida in robotica, sanità e automotive.

Qual è il ruolo di DLSS 4.5 nel gaming?

DLSS 4.5 introduce la Dynamic Multi Frame Generation, permettendo 240+ fps in path tracing su RTX 50 Series, anche in risoluzione 4K.

Come Nvidia supporta la guida autonoma?

Attraverso DRIVE Hyperion e DRIVE AV, Nvidia fornisce hardware, software e modelli AI per autonomia avanzata, adottati da costruttori come Mercedes-Benz.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.