AI browser gestione del rischio in azienda non è più un tema teorico ma una questione operativa concreta. I browser dotati di intelligenza artificiale promettono automazione, efficienza e supporto cognitivo nella navigazione web, ma introducono rischi strutturali elevati sul piano della cybersecurity, della protezione dei dati e della governance. La presente analisi si basa su una ricerca realizzata da Giancarlo Montico, che ha esaminato l’impatto di AI browser e AI agent nei workflow quotidiani – dalla ricerca alla sintesi, dalla compilazione all’automazione – evidenziando criticità sistemiche spesso sottovalutate nelle organizzazioni. Un recente report di Gartner ha esplicitamente consigliato alle organizzazioni di bloccare o limitare l’uso degli AI browser, ritenendo non adeguatamente trattabile il rischio residuo associato a questi strumenti nel contesto aziendale.

Il problema non è l’AI in sé, ma il modo in cui l’intelligenza artificiale viene integrata nel browser, trasformandolo da semplice strumento di accesso al web a agente attivo, capace di prendere decisioni, interagire con servizi esterni, inviare dati a backend terzi e operare in modo parzialmente non supervisionabile.

Cosa leggere

Il perimetro del rischio negli AI browser

Gli AI browser si collocano in una zona grigia tra endpoint, applicazione cloud e sistema di automazione. A differenza dei browser tradizionali, non si limitano a visualizzare contenuti, ma li interpretano, li sintetizzano, li trasformano e, in alcuni casi, agiscono al posto dell’utente. Questo cambia radicalmente il perimetro di rischio.

Il primo elemento critico è l’automazione non supervisionata. Funzioni come compilazione automatica di moduli, interazione con portali aziendali, accesso a servizi SaaS o gestione di credenziali possono avvenire senza una chiara possibilità di controllo in tempo reale. In termini di gestione del rischio, questo significa perdita di tracciabilità decisionale.

Il secondo fattore è la dipendenza da backend AI esterni. Molti AI browser si appoggiano a infrastrutture cloud proprietarie, spesso extra-UE, sulle quali l’organizzazione non ha visibilità né potere di audit. I flussi informativi diventano opachi e difficilmente mappabili, soprattutto quando i dati di navigazione vengono utilizzati per training, inferenza o ottimizzazione dei modelli.

Infine, la complessità della supply chain digitale aumenta in modo significativo. Il browser non è più un singolo prodotto, ma un ecosistema che coinvolge fornitori di modelli AI, servizi di inferenza, plugin, estensioni e API di terze parti. Ogni anello introduce una nuova superficie di attacco.

Il riferimento al framework nazionale di cybersecurity

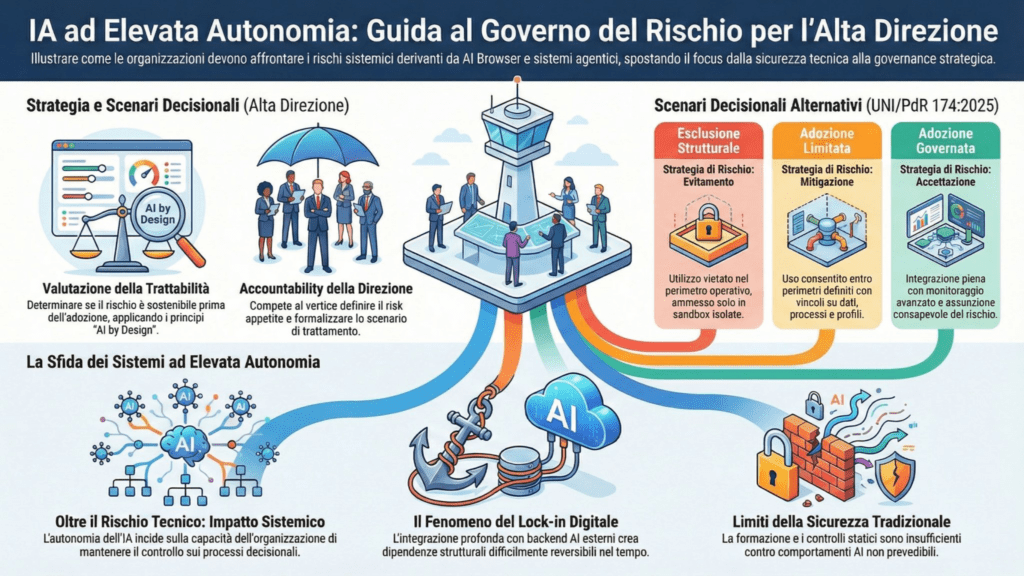

Nel contesto italiano, l’analisi del rischio associato agli AI browser trova un riferimento chiaro nella UNI/PdR 174:2025, che fornisce un modello strutturato per la gestione del rischio informatico in organizzazioni pubbliche e private. Questo standard, integrato con il Framework Nazionale per la Cybersecurity e la Data Protection 2025, consente di valutare non solo la probabilità di un evento, ma anche la trattabilità del rischio.

Secondo questo approccio, un rischio può essere accettato solo se adeguatamente mitigabile con misure proporzionate. Nel caso degli AI browser, le evidenze indicano che molte minacce sono di natura strutturale, non eliminabili con semplici controlli tecnici o policy interne. Questo porta a un rischio residuo elevato, difficilmente compatibile con i requisiti di sicurezza by design e by default.

La governance del rischio informatico proposta dall’Agenzia per la Cybersicurezza Nazionale rafforza questa impostazione, sottolineando la necessità di decisioni documentate, motivate e coerenti con il quadro normativo vigente.

Allineamento con i framework internazionali

Sul piano metodologico, l’analisi degli AI browser è coerente anche con i principali framework internazionali. Il NIST CSF 2.0 fornisce la struttura generale per la gestione del rischio cyber, mentre il NIST AI Risk Management Framework affronta in modo specifico i rischi legati all’intelligenza artificiale, come opacità, bias, perdita di controllo e dipendenza tecnologica.

A livello di sistemi di gestione, la ISO/IEC 42001:2023 introduce requisiti per l’AI management system, enfatizzando responsabilità, accountability e valutazione continua degli impatti. Tuttavia, il quadro nazionale italiano viene considerato sufficiente e adeguato per supportare decisioni operative, senza dover necessariamente ricorrere a standard aggiuntivi.

Protezione dei dati e flussi verso terze parti

Uno degli aspetti più critici degli AI browser riguarda la protezione dei dati. La navigazione web aziendale può includere informazioni sensibili, dati personali, segreti industriali o contenuti coperti da obblighi di riservatezza. Quando questi dati vengono elaborati da un motore AI esterno, il rischio di data leakage aumenta in modo significativo.

La difficoltà non è solo tecnica, ma anche giuridica. I flussi verso terze parti devono essere tracciabili, giustificabili e conformi al GDPR. In molti AI browser, però, la trasparenza sui trattamenti è limitata e le modalità di conservazione o riutilizzo dei dati non sono sempre chiaramente definite. Questo rende complesso dimostrare la conformità in caso di audit o incidente.

AI browser e fattore umano

Il fattore umano resta centrale. L’interfaccia “intelligente” degli AI browser può indurre un eccesso di fiducia negli output generati, riducendo il senso critico dell’utente. In ambito aziendale, questo si traduce in un aumento del rischio operativo, soprattutto quando le decisioni prese dal browser influenzano processi di business, comunicazioni ufficiali o accessi a sistemi interni.

Le linee guida nazionali sull’uso dell’AI nel lavoro, integrate con il Decreto Ministeriale 180 del 17 dicembre 2025, rafforzano l’obbligo di mappare gli impatti, valutare i rischi organizzativi e chiarire le responsabilità decisionali. In questo quadro, l’adozione indiscriminata di AI browser appare difficilmente difendibile.

La legittimità della limitazione tecnologica

Un punto chiave emerso dall’analisi è che limitare o bloccare una tecnologia non è un atto di arretratezza, ma una decisione di gestione del rischio pienamente legittima quando il rischio residuo non è adeguatamente trattabile. La UNI/PdR 174:2025 riconosce esplicitamente questa possibilità, purché la scelta sia motivata, documentata e coerente con il contesto operativo.

Nel caso degli AI browser, la combinazione di automazione non supervisionabile, opacità dei flussi informativi e dipendenza da backend esterni configura una condizione in cui la proporzionalità delle misure di mitigazione viene meno. Da qui la posizione prudenziale di Gartner e di molti esperti di cybersecurity.

Perché il tema è destinato a crescere

Gli AI browser rappresentano solo il primo esempio di una più ampia tendenza: l’ingresso di agenti AI autonomi negli strumenti quotidiani di lavoro. La gestione del rischio, però, non può essere subordinata alla pressione dell’innovazione. Al contrario, deve fungere da filtro razionale, capace di distinguere tra sperimentazione controllata e adozione su larga scala.

In assenza di un salto di maturità tecnologica sul fronte della trasparenza, del controllo e della governance, gli AI browser resteranno un rischio elevato per molte organizzazioni, soprattutto quelle soggette a obblighi regolatori stringenti.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.