La gerarchia dei layer dei Large Language Models mostra una sorprendente convergenza con la dinamica temporale del linguaggio nel cervello umano. Questa è la conclusione centrale di uno studio neuroscientifico che mette in relazione l’elaborazione sequenziale dei modelli linguistici neurali con l’attività cerebrale misurata direttamente durante l’ascolto di una narrazione naturale. Il risultato non riguarda una semplice somiglianza funzionale, ma suggerisce principi computazionali condivisi tra intelligenza artificiale e sistemi biologici coinvolti nella comprensione del linguaggio.

Cosa leggere

Principi computazionali condivisi tra LLM e cervello umano

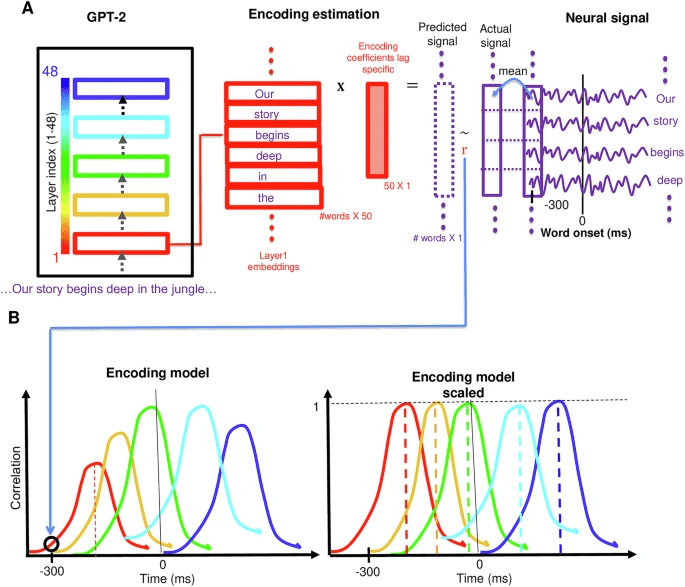

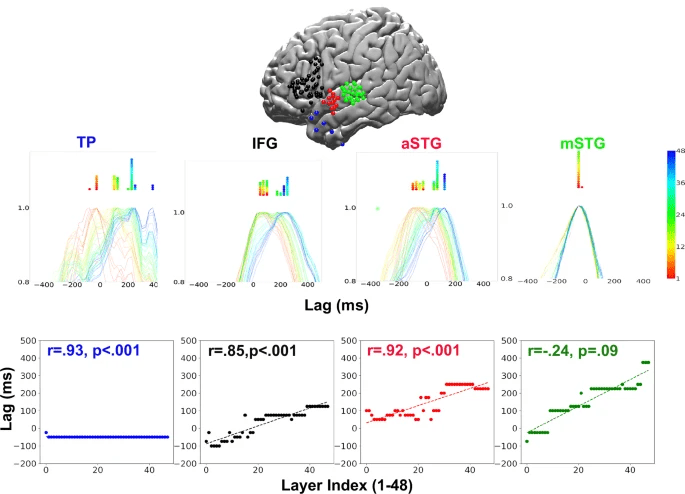

Lo studio parte da un presupposto chiave: il linguaggio umano non viene elaborato in un singolo istante, ma attraverso accumuli progressivi di informazione su scale temporali crescenti. Per testare questa ipotesi, i ricercatori hanno utilizzato segnali di elettrocorticografia (ECoG) registrati da pazienti sottoposti a monitoraggio clinico mentre ascoltavano una narrazione continua di circa trenta minuti. Questa metodologia consente una risoluzione temporale molto più fine rispetto a fMRI o EEG tradizionali.

In parallelo, gli autori hanno estratto embedding contestuali parola per parola da modelli linguistici di grandi dimensioni, analizzando come ciascun layer contribuisca alla previsione dell’attività neurale. La scoperta centrale è che i layer più superficiali dei LLM si allineano a risposte cerebrali precoci, mentre i layer più profondi corrispondono a fasi successive dell’elaborazione linguistica, in modo coerente e sistematico.

B a sinistra Illustrazione del grafico delle prestazioni di codifica.

B a destra Illustrazione del grafico delle prestazioni di codifica in scala.

Questa corrispondenza non emerge da semplici interpolazioni lineari, ma dalle trasformazioni non lineari sequenziali tipiche dei transformer, indicando che non è la rappresentazione statica della parola a contare, bensì il processo computazionale che la trasforma progressivamente.

Dinamica temporale nelle aree linguistiche del cervello

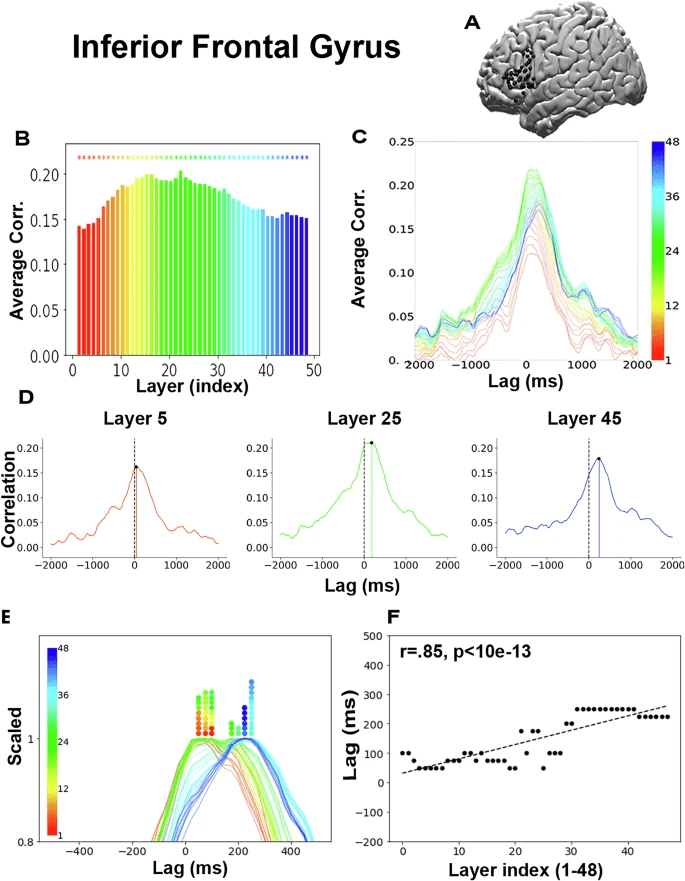

B Prestazioni medie di codifica massima tra gli elettrodi IFG per ogni strato. Codifica a colori per indice (rosso-blu) come descritto nella Fig.

1.

C

Grafico di codifica per strato nell’IFG.

D Le prestazioni di codifica per gli strati 5, 25 e 45 mostrano lo spostamento strato per strato delle prestazioni di picco attraverso i ritardi.

E Codifiche scalate.

F Grafico a dispersione del ritardo che produce le prestazioni di codifica di picco per ogni strato. Viene riportato un valore

p unilaterale

per la correlazione ritardo-strato (

N = 48).

L’analisi si concentra su più regioni lungo il cosiddetto stream ventrale del linguaggio, includendo aree temporali e frontali coinvolte nella comprensione semantica e sintattica. I risultati mostrano che la dinamica layer–tempo è particolarmente marcata nelle regioni frontali inferiori, comunemente associate alla pianificazione e integrazione linguistica, mentre è assente o debole in regioni più sensibili a caratteristiche acustiche di basso livello.

1. (In basso) Diagramma di dispersione del ritardo che produce il picco di prestazioni di codifica per ogni strato. Sono riportati i valori

p unilaterali per la correlazione ritardo-strato (

N = 48).

Per le parole predette correttamente dal modello, la correlazione tra profondità del layer e latenza della risposta neurale raggiunge valori molto elevati, indicando che la previsione linguistica è un fattore chiave dell’allineamento cervello–LLM. Quando una parola è sorprendente o imprevedibile, il pattern temporale cambia, soprattutto nei layer intermedi, suggerendo che il cervello reagisce in modo differenziato al surprisal linguistico.

Questo rafforza l’idea che la predizione della parola successiva, principio fondante dell’addestramento dei LLM, rifletta un meccanismo centrale anche nella comprensione umana del linguaggio.

Perché gli LLM superano i modelli linguistici simbolici

Un confronto diretto con rappresentazioni linguistiche tradizionali evidenzia un altro punto cruciale. Modelli simbolici basati su fonemi, morfemi, sintassi o categorie semantiche discrete non riescono a riprodurre la struttura temporale osservata nei segnali neurali. Anche quando combinati, questi approcci mostrano una correlazione significativamente inferiore rispetto agli embedding contestuali dei LLM.

Questo non implica che le categorie linguistiche classiche siano inutili, ma suggerisce che il cervello non le elabora in modo rigidamente gerarchico e isolato nel tempo. Al contrario, le rappresentazioni contestuali apprese statisticamente dai LLM sembrano catturare una dinamica più simile a quella neurale reale, dove significato, contesto e previsione si fondono continuamente.

In altre parole, i LLM non imitano il linguaggio umano perché “conoscono” le regole grammaticali, ma perché implementano un processo di trasformazione sequenziale dell’informazione che rispecchia quello biologico.

Architetture artificiali e architettura cerebrale

Un punto centrale della discussione riguarda la differenza strutturale tra cervello e LLM. I transformer elaborano l’informazione in parallelo, mentre il cervello opera in modo intrinsecamente sequenziale e temporale, con segnali che si propagano lungo reti ricorrenti e localmente connesse. Eppure, nonostante questa differenza architetturale, la gerarchia funzionale emergente risulta sorprendentemente simile.

Questo apre a una prospettiva importante: futuri modelli linguistici potrebbero integrare componenti ricorrenti o meccanismi temporali espliciti per avvicinarsi ancora di più alla dinamica corticale. Allo stesso tempo, i risultati suggeriscono che alcune proprietà fondamentali della comprensione linguistica non dipendono dalla biologia, ma da vincoli computazionali più generali legati alla predizione e all’integrazione del contesto.

Implicazioni per neuroscienze e intelligenza artificiale

Dal punto di vista delle neuroscienze computazionali, lo studio fornisce una validazione empirica dei LLM come modelli cognitivi del linguaggio, almeno a livello funzionale. Non si tratta più solo di strumenti ingegneristici, ma di sistemi che permettono di testare ipotesi sulla struttura temporale dell’elaborazione linguistica umana.

Dal lato dell’intelligenza artificiale, i risultati rafforzano l’idea che l’addestramento su grandi quantità di linguaggio naturale consenta l’emergere spontaneo di rappresentazioni compatibili con il cervello, anche senza vincoli biologici espliciti. Questo alimenta il dibattito su modelli futuri addestrati su dati multimodali, sociali e temporali, più vicini all’esperienza umana reale rispetto ai corpus testuali massivi.

Un ulteriore contributo chiave è la pubblicazione del dataset completo, che include stimoli linguistici, risposte neurali e embedding modello per modello. Questo dataset diventa un benchmark aperto per confrontare teorie alternative, architetture diverse e nuovi approcci all’allineamento cervello–AI.

Domande frequenti su LLM e dinamica cerebrale del linguaggio

In che senso i layer dei LLM riflettono il cervello umano?

Ogni layer del modello corrisponde a una fase temporale diversa dell’attività neurale durante la comprensione del linguaggio, mostrando un allineamento sistematico tra profondità computazionale e latenza cerebrale.

Perché le parole predette meglio mostrano correlazioni più forti?

Perché la predizione è un meccanismo centrale sia nei LLM sia nel cervello umano, che anticipa l’informazione linguistica prima che venga completamente elaborata.

I modelli simbolici tradizionali sono quindi superati?

Non sono inutili, ma risultano meno efficaci nel catturare la dinamica temporale reale del cervello rispetto agli embedding contestuali appresi dai LLM.

Questo significa che i LLM “pensano” come gli esseri umani?

No, ma indica che condividono principi computazionali fondamentali con il cervello umano, soprattutto nella gestione del contesto e della predizione linguistica.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.