La nuova offensiva di Nvidia nel mercato dell’intelligenza artificiale passa dalla GPU Vera Rubin, una piattaforma pensata per consolidare il vantaggio competitivo contro gli accelerator AMD Instinct in una fase di boom senza precedenti dell’AI. L’annuncio tecnico non arriva in un vuoto industriale, ma in un contesto segnato da vincoli energetici, tensioni geopolitiche, accuse legali sui dati di training e supply chain sempre più stressate.

Vera Rubin segna un cambio di passo netto rispetto alla generazione precedente. Nvidia ha aumentato in modo aggressivo bandwidth di memoria e potenza elettrica, scegliendo deliberatamente una strategia “performance first” per attrarre hyperscaler e operatori di data center che competono su throughput e latenza nei workload AI più intensivi.

Cosa leggere

Vera Rubin: più banda, più watt, più pressione sui data center

Secondo le informazioni circolate nel settore, Vera Rubin porta la banda di memoria a 22,2 TB/s, in forte aumento rispetto ai 13 TB/s delle soluzioni precedenti. Il dato più discusso riguarda però il TDP, che sale fino a 2.300 watt, contro i 1.800 watt stimati per le controparti AMD di fascia alta. In termini relativi, Rubin arriverebbe a consumare circa il 35% in più rispetto a MI450, e oltre il 60% in più rispetto a Blackwell Ultra B300.

Questa scelta tecnica non è casuale. Nvidia punta a offrire vantaggi netti in addestramento e inferenza su larga scala, dove la disponibilità di energia e raffreddamento è già parte integrante dell’investimento. Per gli hyperscaler, il costo marginale dell’elettricità diventa secondario rispetto al time-to-train e alla capacità di servire modelli sempre più grandi.

Il rovescio della medaglia è evidente: la corsa alle prestazioni AI sta spingendo i data center verso limiti infrastrutturali, rendendo l’energia uno dei principali colli di bottiglia dell’intero settore.

Cina, restrizioni e il viaggio di Jensen Huang

Sul piano geopolitico, Nvidia si muove su un terreno delicato. Il CEO Jensen Huang ha in programma un viaggio in Cina in concomitanza con eventi interni legati al Capodanno lunare. Sebbene l’azienda eviti commenti ufficiali, il contesto è chiaro: le restrizioni statunitensi sull’export di GPU AI avanzate continuano a limitare l’accesso al mercato cinese.

Nvidia ha avviato spedizioni limitate di H200 verso la Cina grazie a permessi specifici USA, ma Pechino ha imposto ulteriori vincoli, consentendo l’acquisto solo a laboratori universitari e attività di ricerca e sviluppo. Per Nvidia, mantenere una presenza simbolica e relazionale nel mercato cinese diventa cruciale, anche in assenza di volumi commerciali significativi.

Dati di training, accuse legali e il rischio reputazionale

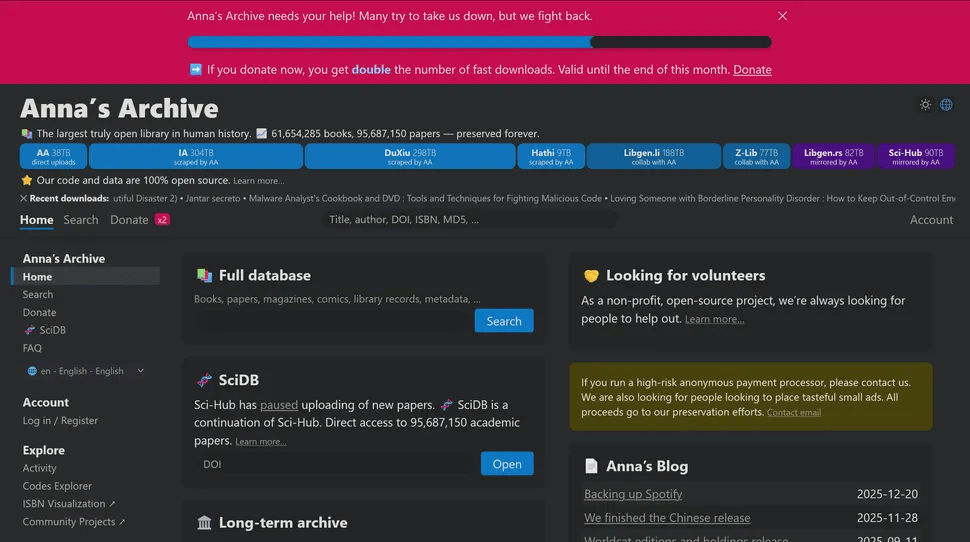

Alla pressione tecnologica e geopolitica si aggiungono accuse legali che toccano un nervo scoperto dell’intero settore AI: l’uso di dati protetti da copyright. Documenti emersi in cause civili indicano che team Nvidia avrebbero valutato un accordo con Anna’s Archive per accedere rapidamente a centinaia di terabyte di libri piratati, utilizzati nel dataset Books3 per l’addestramento di modelli linguistici.

Nvidia sostiene che l’uso rientri nel fair use, ma una class action di autori punta a risarcimenti potenzialmente elevati. Il caso evidenzia un problema sistemico: la dipendenza dell’AI generativa da grandi corpus testuali, spesso acquisiti in zone grigie legali, con rischi crescenti di contenzioso e regolazione più stringente.

AI, energia e “permesso sociale” secondo Microsoft

Il dibattito non riguarda solo Nvidia. Il CEO di Microsoft ha lanciato un messaggio chiaro: l’AI deve generare benefici diffusi, altrimenti rischia di perdere il “permesso sociale” per consumare enormi quantità di energia e risorse. Senza impatti tangibili su sanità, istruzione e produttività pubblica, la narrativa dell’AI come progresso condiviso potrebbe incrinarsi.

Il tema energetico è centrale. I data center AI stanno contribuendo a incrementi significativi dei prezzi dell’elettricità, sia per utenti industriali sia domestici, e il consumo idrico associato al raffreddamento è ormai oggetto di scrutinio politico.

OpenAI, scaling del compute e conti in rosso

Nel frattempo, OpenAI mostra come il modello economico dell’AI resti in forte tensione. Nel 2025 la spesa stimata supera 20 miliardi di euro, a fronte di ricavi intorno agli 8–9 miliardi. La logica è chiara: più potenza di calcolo genera più domanda e più ricavi, ma la profittabilità resta lontana.

OpenAI ha annunciato investimenti diretti per l’upgrade delle reti elettriche legate ai data center Stargate, con l’obiettivo di non scaricare i costi energetici sulle comunità locali. È un segnale di come le aziende AI siano costrette a intervenire direttamente sulle infrastrutture, andando oltre il semplice acquisto di hardware.

Adozione AI: pochi vincitori, molti in attesa

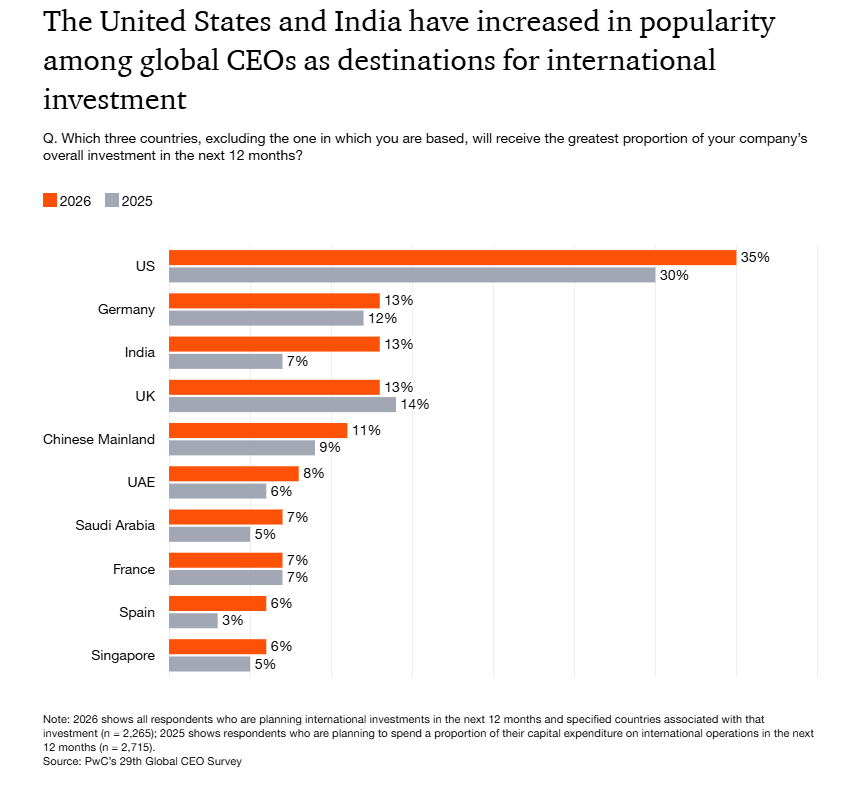

Una survey globale di PwC fotografa una realtà meno entusiasta dell’hype. Oltre la metà dei CEO dichiara di non aver ancora visto benefici concreti dall’AI. Solo una minoranza segnala aumenti simultanei di ricavi e riduzione dei costi. Le cause principali sono dati non pronti, assenza di roadmap chiare e scarsa adozione quotidiana degli strumenti AI.

Questo dato rafforza il rischio di una bolla selettiva, in cui pochi attori – tipicamente big tech e hyperscaler – catturano valore, mentre il resto dell’economia fatica a tradurre l’AI in vantaggi operativi.

Supply chain: memoria, NAND e reshoring

Sul fronte hardware, l’effetto AI si estende alla memoria. Kioxia ha dichiarato di aspettarsi forniture NAND completamente allocate per il 2026–2027, decretando la fine degli SSD da 1 TB a prezzi ultra-bassi. L’AI consumerà una quota crescente della produzione di memoria, con effetti diretti sui prezzi per consumatori e imprese.

In parallelo, gli Stati Uniti accelerano il reshoring delle catene critiche, incluse terre rare e magneti industriali, per ridurre la dipendenza dalla Cina. Investimenti pubblici e venture capital puntano a ricostruire capacità produttive strategiche, mentre Taiwan rassicura che gli accordi con Washington non comprometteranno la propria industria dei semiconduttori.

Un equilibrio sempre più fragile

La strategia Nvidia su Vera Rubin mostra come la leadership nell’AI si giochi su prestazioni estreme, anche a costo di consumi energetici record. Ma il quadro complessivo è più complesso: energia, dati, supply chain e consenso sociale stanno diventando fattori determinanti quanto la pura potenza di calcolo.

Se l’AI non riuscirà a dimostrare benefici diffusi e sostenibili, la corsa alle GPU più potenti rischia di scontrarsi con limiti politici, economici e infrastrutturali. In questo scenario, la vera sfida non è solo battere AMD sul teraflop, ma rendere l’intelligenza artificiale compatibile con il mondo reale.

Domande frequenti su Nvidia Vera Rubin e il mercato AI

Perché Nvidia ha aumentato così tanto i consumi di Vera Rubin?

Per massimizzare le prestazioni nei data center AI, dove hyperscaler privilegiano throughput e velocità di addestramento rispetto all’efficienza energetica.

AMD può competere con Vera Rubin?

AMD Instinct resta competitiva sul piano dell’efficienza, ma Nvidia punta a mantenere il vantaggio sulle prestazioni assolute, soprattutto nei workload più grandi.

Le restrizioni verso la Cina penalizzano Nvidia?

Limitano i volumi, ma Nvidia cerca di mantenere relazioni strategiche e una presenza simbolica in attesa di scenari geopolitici più stabili.

L’AI rischia davvero una bolla?

Sì, se i benefici resteranno concentrati in poche aziende e non si tradurranno in valore diffuso per imprese, servizi pubblici e cittadini.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.