n8n è oggi al centro di una doppia linea di frattura nella sicurezza dell’intelligenza artificiale: da un lato le vulnerabilità RCE critiche che colpiscono il motore di automazione dei workflow, dall’altro l’emersione del LLMjacking, una forma di furto di compute AI monetizzata su scala industriale. Le rivelazioni di JFrog Security Research su CVE-2026-1470 e CVE-2026-0863, insieme all’attribuzione di Operation Bizarre Bazaar da parte di Pillar Security, mostrano come le piattaforme AI stiano diventando infrastrutture ad alto valore criminale, esposte sia a exploit diretti sia a campagne sistematiche di abuso.

Cosa leggere

n8n e le vulnerabilità RCE nei workflow AI

n8n è una piattaforma di automazione che collega API LLM, sistemi IAM, database e servizi aziendali in workflow complessi. Proprio questa centralità la rende un bersaglio privilegiato. JFrog Security Research ha identificato due vulnerabilità ad alta gravità che consentono esecuzione di codice remoto a utenti autenticati con permessi di creazione o modifica dei workflow, trasformando l’istanza in una skeleton key aziendale.

La prima, CVE-2026-1470 con CVSS 9.9, colpisce il motore di valutazione delle espressioni JavaScript. La sandbox di n8n utilizza una combinazione di AST sanitization, regex e hook come ThisSanitizer e PrototypeSanitizer per impedire accessi pericolosi a constructor e __proto__. L’exploit sfrutta però l’istruzione with, non sanitizzata correttamente, che introduce variabili di un oggetto nel contesto corrente. Applicata a una funzione, constructor diventa un identificatore valido, risolvendo a Function. Questo bypass consente eval dinamico e l’esecuzione di comandi sul processo principale n8n, fino al RCE completo sull’host. La falla interessa tutte le versioni precedenti a 1.123.17, 2.4.5 e 2.5.1.

La seconda vulnerabilità, CVE-2026-0863 con CVSS 8.5, riguarda il nodo Python in modalità interna. In questo scenario, il codice Python viene eseguito come subprocess nel processo principale n8n, con una sandbox che tenta di negare import e builtin pericolosi. L’exploit abusa delle eccezioni AttributeError introdotte in Python 3.10, che espongono riferimenti agli oggetti coinvolti nell’errore. Attraverso f-string, traceback e frame di esecuzione, un attaccante può ricostruire l’accesso ai builtins, reintrodurre import e raggiungere il modulo os, ottenendo RCE sul sistema operativo. Questa falla colpisce versioni precedenti a 1.123.14, 2.3.5 e 2.4.2 quando è attiva la modalità interna.

Il punto chiave, evidenziato da JFrog, è strutturale: sandboxare linguaggi dinamici come JavaScript e Python resta estremamente complesso. Evoluzioni del linguaggio, come nuove semantiche di risoluzione dei nomi o gestione delle eccezioni, possono rompere assunzioni di sicurezza anche in sandbox progettate con cura.

Impatto operativo delle RCE in n8n

In ambienti reali, un exploit riuscito su n8n consente hijack completo dei workflow, accesso a segreti, token API, credenziali cloud e movimenti laterali verso sistemi collegati. Poiché n8n viene spesso utilizzato come collante tra servizi critici, l’impatto supera la singola applicazione e diventa supply chain interno. Per questo n8n raccomanda upgrade immediati, la riduzione del numero di utenti autorizzati a modificare workflow e l’uso della modalità esterna containerizzata per l’esecuzione Python in produzione.

LLMjacking e Operation Bizarre Bazaar

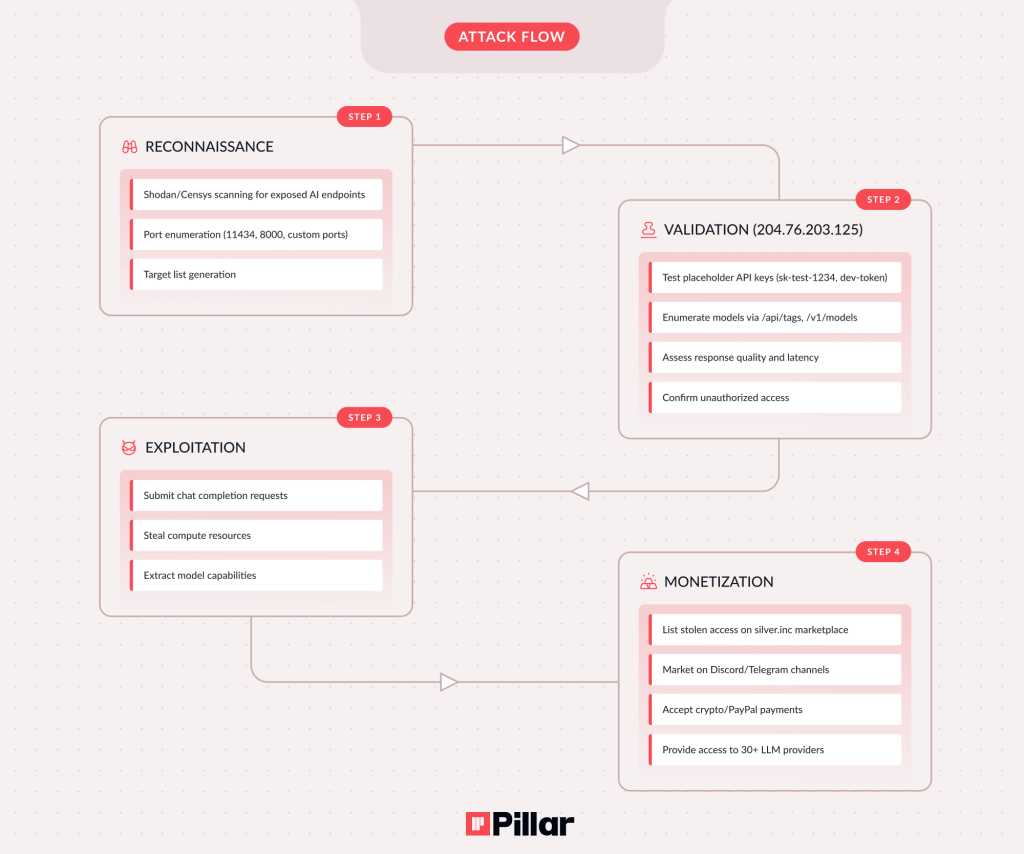

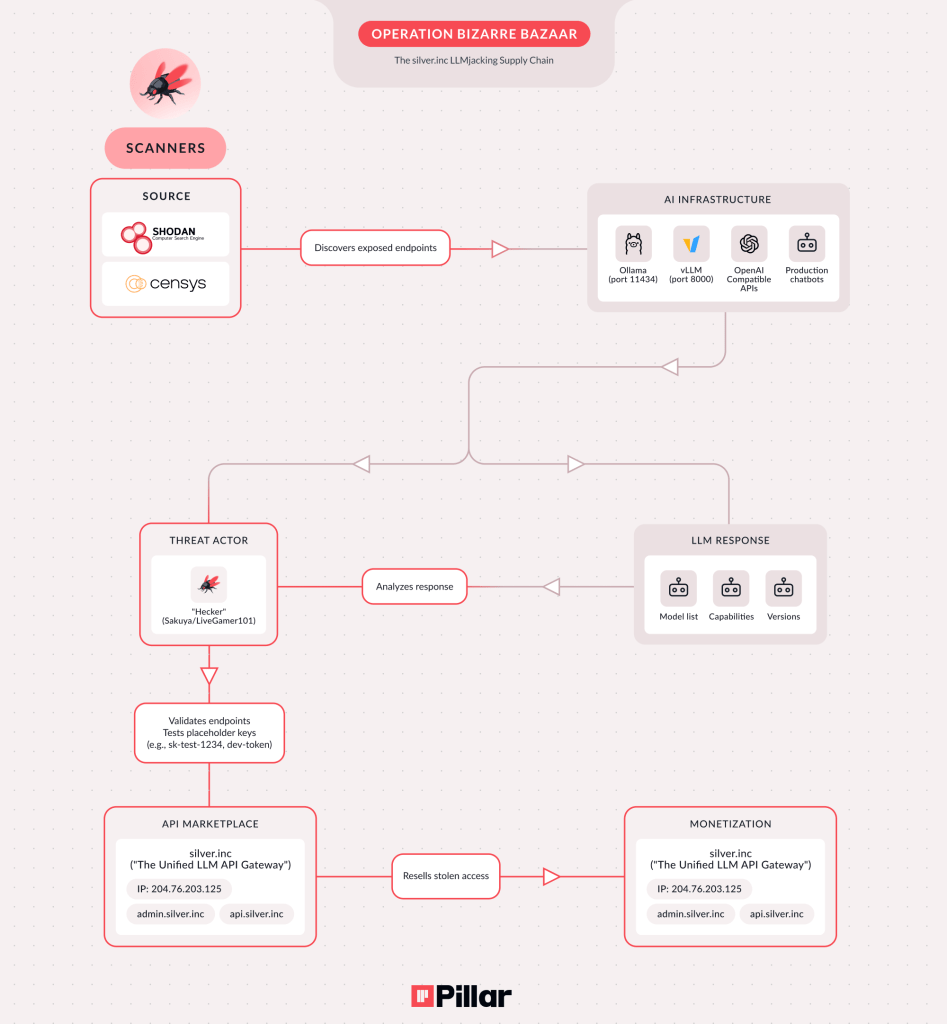

In parallelo alle vulnerabilità applicative, Pillar Security ha attribuito Operation Bizarre Bazaar a un threat actor noto come Hecker o Sakuya, segnando la prima campagna LLMjacking attribuita con monetizzazione commerciale esplicita. Il LLMjacking non mira a rubare dati tradizionali, ma compute per inference, trasformando l’accesso non autorizzato ai modelli in ricavi diretti.

Tra dicembre 2025 e gennaio 2026, Pillar ha osservato oltre 35.000 sessioni di scansione contro endpoint AI esposti, con una media di 972 tentativi al giorno. I target principali includono Ollama esposto sulla porta 11434, server MCP (Model Context Protocol) senza autenticazione e implementazioni vLLM su porte di default. Gli attaccanti utilizzano bot distribuiti, intelligence da Shodan e Censys, e validano gli endpoint con chiavi placeholder prima di monetizzare l’accesso.

Il cuore economico dell’operazione è il marketplace silver.inc, che funge da gateway unificato per oltre 30 provider LLM, rivendendo accessi scontati del 40–60% rispetto ai prezzi ufficiali. In pratica, le organizzazioni pagano l’inference a prezzo pieno, mentre gli attaccanti rivendono compute rubato, trasferendo i costi alle vittime.

MCP, movimenti laterali e rischio supply chain

Un elemento particolarmente critico emerso da Operation Bizarre Bazaar è il ruolo dei server MCP, progettati per collegare LLM a file system, database e servizi interni. Pillar ha osservato che circa il 60% del traffico malevolo mira proprio a MCP, non solo per rubare compute, ma per preparare movimenti laterali. Un MCP esposto può consentire lettura di codice, dump di credenziali, accesso a repository e pivot verso strumenti come Slack o GitHub.

Questa dinamica eleva il LLMjacking da semplice abuso di risorse a rischio di compromissione della supply chain AI, dove un singolo endpoint esposto può diventare il punto di ingresso per attacchi più ampi.

Mitigazioni urgenti per n8n e LLMjacking

Per n8n, le azioni immediate includono patching alle versioni corrette, disabilitazione della modalità Python interna, containerizzazione dei runtime e monitoraggio comportamentale dei workflow. È fondamentale trattare n8n come asset critico, con controlli di least privilege e logging avanzato.

Contro il LLMjacking, Pillar raccomanda autenticazione forte su tutti gli endpoint AI, chiusura delle porte di default, rate limiting e blocco di subnet note per scanning. Le organizzazioni dovrebbero inventariare gli endpoint AI esposti, auditare MCP e implementare monitoraggio delle anomalie di consumo, in grado di rilevare pattern tipici di test-key e enumerazione dei modelli.

Domande frequenti su n8n e LLMjacking

Le vulnerabilità n8n richiedono accesso autenticato?

Sì. Entrambe le RCE richiedono la capacità di creare o modificare workflow, ma una volta sfruttate consentono compromissione completa dell’istanza e accesso ai sistemi collegati.

Cos’è il LLMjacking e perché è diverso dagli attacchi tradizionali?

Il LLMjacking mira a rubare compute AI per l’inference, monetizzandolo tramite rivendita di accessi ai modelli. Non è solo abuso API, ma furto diretto di risorse computazionali.

Perché i server MCP sono così pericolosi se esposti?

Perché collegano i modelli AI a file system e database. Un MCP non autenticato può consentire movimenti laterali, esfiltrazione di segreti e compromissione della supply chain.

Patch e firewall sono sufficienti contro queste minacce?

Sono necessari ma non sufficienti. Servono autenticazione robusta, segmentazione di rete, monitoraggio continuo e controlli di consumo per individuare rapidamente abusi di inference e sandbox escape.

Iscriviti a Matrice Digitale

Ricevi le notizie principali direttamente nella tua casella di posta.

Niente spam, disiscriviti quando vuoi.