Hugging Face è al centro di una campagna di malware Android polimorfo scoperta da Bitdefender, mentre Ollama emerge come una delle superfici di attacco più estese nel panorama LLM self-hosted, con 175.000 server esposti pubblicamente in 130 paesi. Nelle prime settimane del 2026, le indagini di SentinelOne e Censys mostrano come fiducia nelle piattaforme AI, configurazioni deboli e automazione stiano convergendo in un nuovo modello di minaccia. Qui trovi l’analisi tecnica completa: come funziona la catena di infezione su Hugging Face, perché Ollama cambia il threat model degli LLM, e quali sono le implicazioni operative per utenti, aziende e difensori.

Cosa leggere

Abusi su Hugging Face per la distribuzione di malware Android

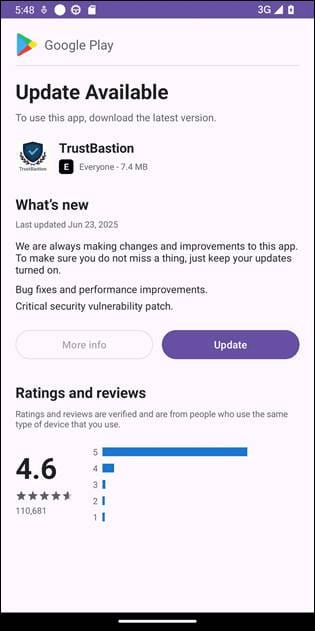

L’indagine di Bitdefender ricostruisce una campagna che sfrutta Hugging Face come infrastruttura di hosting per migliaia di APK malevoli. L’accesso iniziale avviene tramite un’app dropper chiamata TrustBastion, presentata come strumento di sicurezza capace di rilevare scam, SMS fraudolenti e phishing. Subito dopo l’installazione, TrustBastion attiva una strategia di scareware, mostrando avvisi di aggiornamento obbligatori che imitano l’interfaccia di Google Play, inducendo l’utente a concedere permessi estesi.

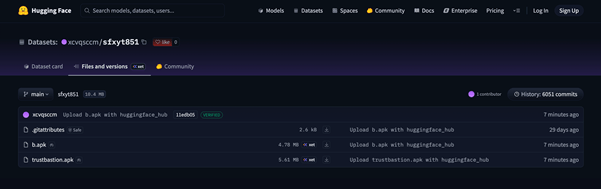

Il dropper contatta un dominio di controllo che reindirizza a un repository su Hugging Face, sfruttando la CDN della piattaforma per il download del payload. Qui entra in gioco un meccanismo di polimorfismo server-side: nuove varianti del malware vengono generate ogni 15 minuti, eludendo i sistemi di rilevamento basati su firme. Il repository incriminato, attivo per 29 giorni, accumula oltre 6.000 commit prima della rimozione. Dopo la segnalazione, Hugging Face elimina i dataset infetti, ma l’operazione riemerge rapidamente sotto il nome Premium Club, con icone diverse ma codice identico, a dimostrazione di una capacità di rigenerazione rapida.

Il payload finale agisce come Remote Access Tool e sfrutta in modo aggressivo gli Accessibility Services di Android, presentati come necessari alla protezione del dispositivo. Una volta concessi, questi privilegi permettono overlay a schermo, cattura di screenshot, simulazione di swipe, e blocco dei tentativi di disinstallazione. Il malware monitora continuamente l’attività dell’utente, esfiltra immagini e dati verso server C2 e visualizza interfacce di login false per servizi finanziari come Alipay e WeChat, sottraendo credenziali e codici di blocco dello schermo. La fiducia implicita nella piattaforma di hosting diventa così il fattore decisivo per il successo dell’infezione.

Ollama esposto: quando l’LLM locale diventa infrastruttura pubblica

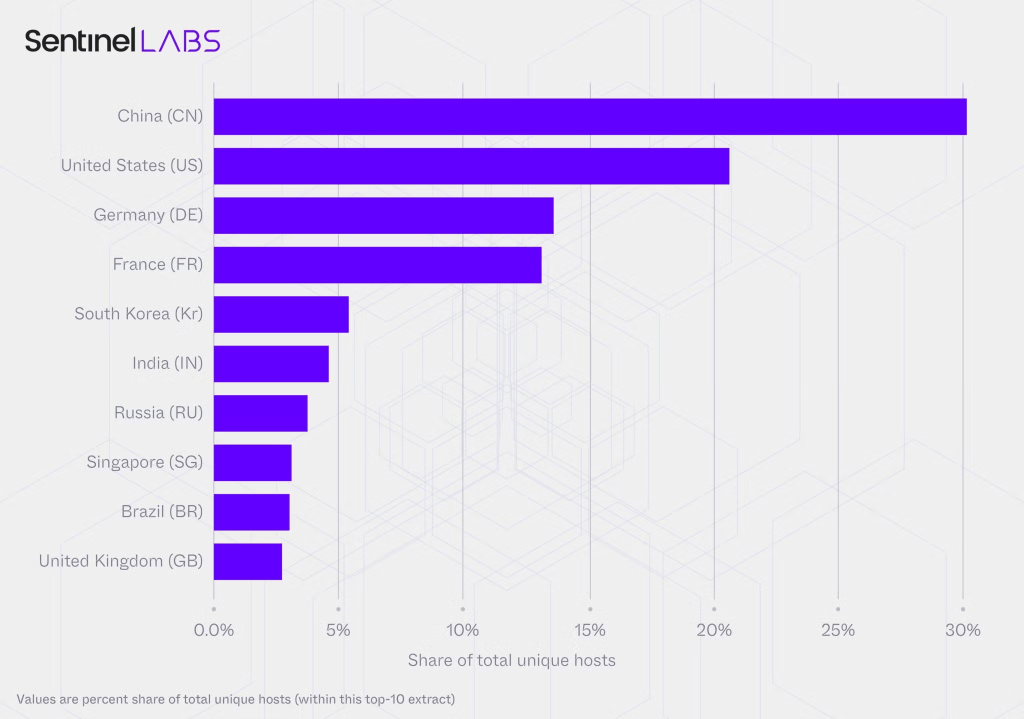

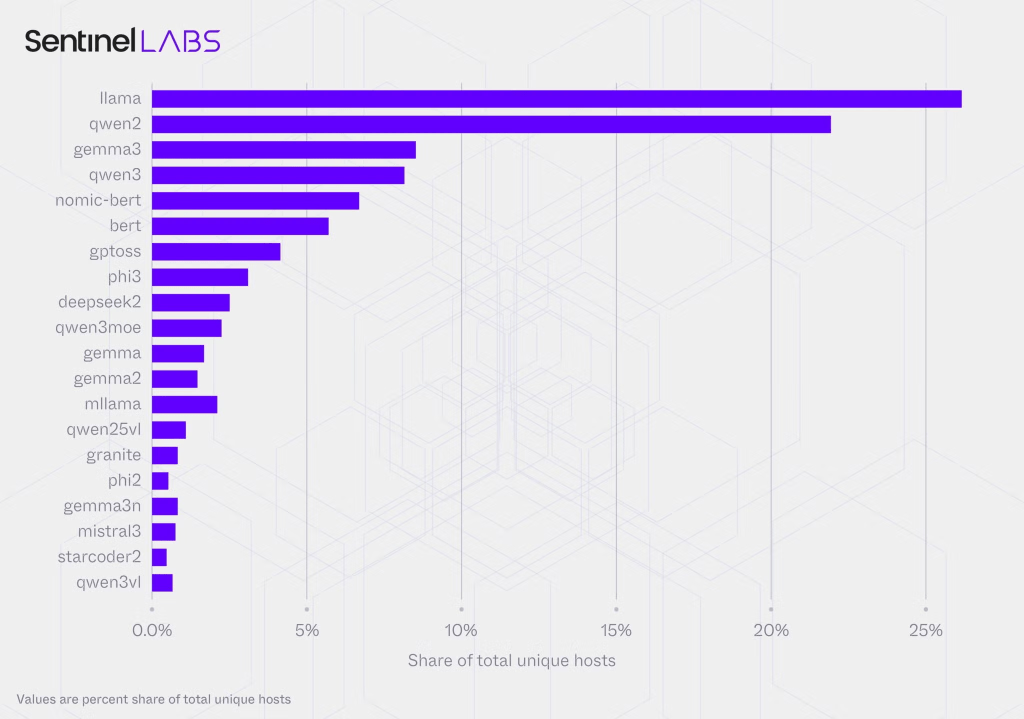

In parallelo, le analisi di SentinelOne e Censys evidenziano un problema strutturale legato a Ollama, framework open-source per l’esecuzione locale di modelli LLM su Windows, macOS e Linux. Sebbene Ollama leghi di default a localhost, una modifica minima del bind a 0.0.0.0 rende l’endpoint accessibile da Internet. Il risultato è una superficie di attacco senza precedenti: 175.000 host unici esposti, distribuiti in 130 paesi, con una concentrazione superiore al 30% in Cina, seguita da Stati Uniti, Germania, Francia, Corea del Sud, India, Russia, Singapore, Brasile e Regno Unito.

Il dato più critico riguarda le capacità di tool-calling: oltre il 48% degli host pubblicizza funzioni che consentono esecuzione di codice, accesso a API e interazioni con sistemi esterni. Questo altera radicalmente il threat model. Un endpoint che genera testo può produrre contenuti dannosi; un endpoint tool-enabled può compiere azioni privilegiate. In assenza di autenticazione, logging e controllo di rete, l’LLM diventa una porta d’ingresso operativa. L’analisi rileva inoltre 201 host con template prompt non censurati, che rimuovono i guardrail di sicurezza, e supporto a modalità oltre il testo come ragionamento e visione, ampliando ulteriormente il perimetro di rischio.

LLMjacking e mercati dell’accesso LLM

Queste esposizioni alimentano il fenomeno del LLMjacking, in cui gli attaccanti abusano delle risorse computazionali delle vittime per generare spam, disinformazione, mining di criptovalute o rivendita degli accessi. Le ricerche citano operazioni che scansionano Internet, validano endpoint LLM non protetti e commercializzano l’accesso come API scontate. La natura decentralizzata di Ollama, spesso distribuito su reti residenziali, complica la governance tradizionale e rende inefficaci molte misure perimetrali.

Il punto chiave è che gli LLM self-hosted devono essere trattati come qualsiasi altra infrastruttura accessibile esternamente. Endpoint, autenticazione forte, segmentazione di rete e monitoraggio non sono opzionali. Quando un LLM è integrato in processi di tool-calling, ogni prompt diventa potenzialmente un’azione.

Implicazioni per la cybersecurity AI

I casi Hugging Face e Ollama mostrano una convergenza pericolosa: piattaforme fidate, open-source e automazione abbassano le barriere di distribuzione e amplificano l’impatto degli abusi. Nel primo caso, una piattaforma nota per dataset e modelli diventa CDN per malware Android polimorfo; nel secondo, un runtime LLM locale si trasforma in infrastruttura pubblica non governata. La lezione operativa è chiara: security by design deve estendersi all’AI, includendo controlli sui commit e sui dataset, hardening delle configurazioni, autenticazione obbligatoria e monitoraggio continuo.

Per gli utenti Android, la mitigazione passa da limitare installazioni fuori dallo store, rivedere i permessi e diffidare di scareware. Per chi utilizza Ollama, la regola è restare su localhost, applicare auth, isolare la rete e disabilitare tool-calling se non necessario. Per le piattaforme, serve una sorveglianza attiva degli abusi e tempi di risposta rapidi. L’ecosistema AI sta diventando edge-first: senza governance, l’edge diventa il punto di rottura.

Domande frequenti sugli abusi AI su Hugging Face e Ollama

In che modo Hugging Face è stata usata per distribuire malware Android?

Gli attaccanti hanno sfruttato repository e CDN di Hugging Face per ospitare APK malevoli, richiamati da un dropper che imitava app di sicurezza. Un polimorfismo server-side generava nuove varianti ogni 15 minuti, eludendo il rilevamento.

Perché l’esposizione di Ollama è così pericolosa?

Perché molti server sono accessibili senza autenticazione e supportano tool-calling, che consente esecuzione di codice e interazioni esterne. Questo trasforma l’LLM in un endpoint operativo ad alto rischio.

Cos’è il LLMjacking?

È l’abuso di istanze LLM esposte per sfruttarne le risorse computazionali o rivenderne l’accesso. Gli attaccanti monetizzano tramite spam, disinformazione, mining o vendita di API non autorizzate.

Quali sono le mitigazioni essenziali per chi usa LLM locali?

Limitare l’esposizione a localhost, applicare autenticazione forte, segmentare la rete, disabilitare tool-calling non necessario e monitorare costantemente l’uso degli endpoint.

Iscriviti a Matrice Digitale

Ricevi le notizie principali direttamente nella tua casella di posta.

Niente spam, disiscriviti quando vuoi.