Google Cloud accelera l’adozione dell’intelligenza artificiale enterprise attraverso un’espansione strutturale di Vertex AI, l’integrazione dei modelli Claude Opus 4.6, il potenziamento di Gemini 3 e un rafforzamento deciso delle soluzioni di Sovereign Cloud, ridefinendo il modo in cui aziende e sviluppatori progettano, governano e mettono in produzione workflow AI complessi. L’obiettivo non è solo aumentare le prestazioni, ma ridurre le frizioni operative, migliorare la sicurezza e garantire controllo sui dati in scenari regolati.

Vertex AI e l’integrazione di Claude Opus 4.6 per workflow complessi

L’integrazione di Claude Opus 4.6 all’interno di Vertex AI rappresenta un passaggio chiave nella strategia di Google Cloud. Il modello di Anthropic è progettato per coding avanzato, analisi finanziarie articolate e orchestrazione di agenti multi-step con capacità di recupero dagli errori, riducendo attività che tradizionalmente richiedevano giorni a poche ore operative. Claude Opus dimostra particolare efficacia nella produzione di documentazione professionale, fogli di calcolo e presentazioni con consapevolezza del dominio, grazie alla capacità di collegare filing regolatori, report di mercato e dataset strutturati.

Vertex AI fornisce un endpoint globale per l’accesso a Claude, con funzionalità di prompt caching a TTL flessibile per l’ottimizzazione dei costi, batch prediction per carichi massivi e web search in preview per l’arricchimento dei contesti. L’infrastruttura è affiancata da strumenti di governance come Model Armor contro prompt injection e AI Protection integrata nel Security Command Center. La disponibilità di Claude Opus anche su Marketplace e la presenza di notebook GitHub pronti all’uso abbassano drasticamente la soglia di adozione enterprise.

GKE Inference Gateway e la riduzione strutturale della latenza

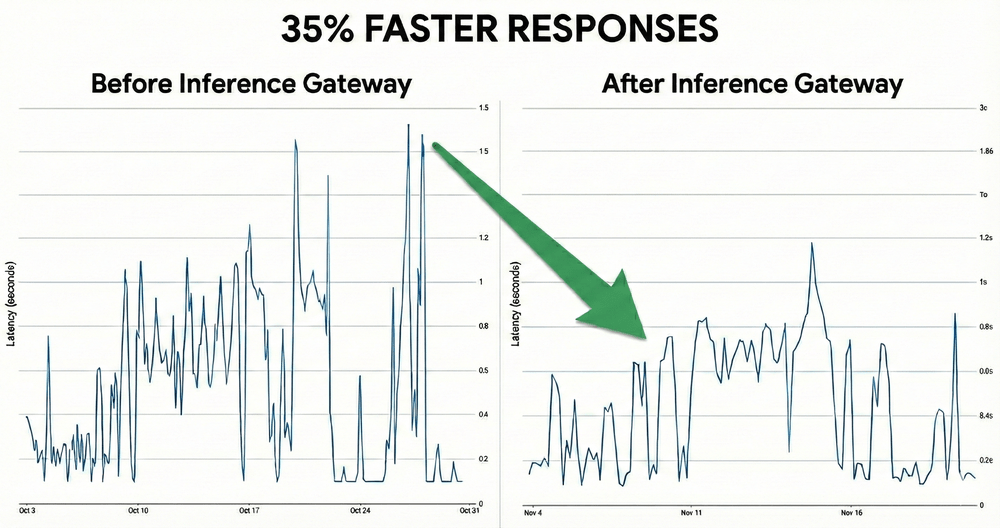

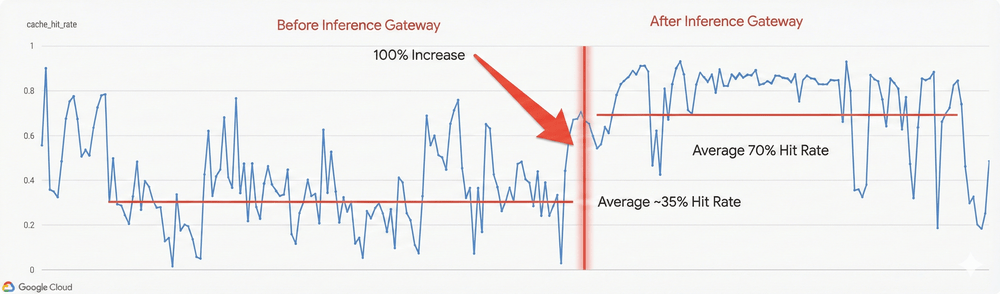

Un elemento tecnico centrale è il GKE Inference Gateway, costruito sulla Kubernetes Gateway API e progettato per ottimizzare l’inferenza su Vertex AI. Il gateway introduce routing load-aware e content-aware, analizzando metriche Prometheus come la KV Cache utilization per dirigere le richieste verso i pod più efficienti. Il sistema ispeziona i prefissi delle richieste per individuare cache già esistenti, riducendo la ricomputazione e stabilizzando le prestazioni sotto carichi variabili.

I risultati dichiarati mostrano una riduzione del time to first token del 35%, un aumento dell’hit rate della cache fino al 70% e una diminuzione della latenza P95 del 52% in workload complessi come quelli basati su modelli di coding. L’admission control integrato previene starvation in condizioni di burst, rendendo l’infrastruttura adatta a scenari enterprise critici dove la prevedibilità della latenza è un requisito operativo.

Gemini 3 e lo sviluppo di workforce AI agentica

Il potenziamento di Gemini 3 segna un’evoluzione verso una vera forza lavoro AI. Gemini 3 Pro è orientato a ragionamento avanzato, pianificazione e orchestrazione, mentre strumenti come Gemini CLI consentono interazioni dirette via terminale, ideali per automazione CI/CD e ambienti headless. Installabile via npm, la CLI supporta multiplexing con tmux ed estensioni tramite Open VSX e MCP, integrandosi nei flussi di sviluppo esistenti.

Accanto alla CLI, Antigravity introduce un ambiente IDE completo per la gestione di agenti multipli, con dashboard centralizzata, debugging nativo e browser integrato per task visivi. L’approccio spec-driven consente di trattare i prompt come vere e proprie SOP in markdown, migliorando riproducibilità e governance. La combinazione di Gemini 3 Pro per istruzioni di alto livello e modelli più leggeri per l’esecuzione consente di bilanciare costo, velocità e accuratezza nei sistemi agentici complessi.

Sovereign Cloud e il controllo dei dati in ambienti regolati

Parallelamente alle innovazioni AI, Google Cloud rafforza la propria offerta di Sovereign Cloud, articolata in Data Boundary, Dedicated e Air-Gapped. Le configurazioni Air-Gapped operano senza connettività esterna, bloccando qualsiasi accesso remoto e consentendo l’operatività anche in scenari di disconnessione prolungata. Le soluzioni Dedicated permettono a partner e operatori terzi di gestire l’infrastruttura senza interventi diretti di Google, rispondendo a requisiti di NIS2 e DORA.

L’adozione da parte di enti governativi, settori difesa e grandi gruppi industriali evidenzia una strategia orientata a sovranità digitale reale, supportata da crittografia con chiavi esterne, client-side encryption e possibilità di eseguire carichi ML localmente in regioni selezionate. Questo approccio mira a ridurre il rischio geopolitico e normativo, rendendo l’AI enterprise compatibile con contesti ad alta sensibilità.

Applicazioni industriali e metriche di valore

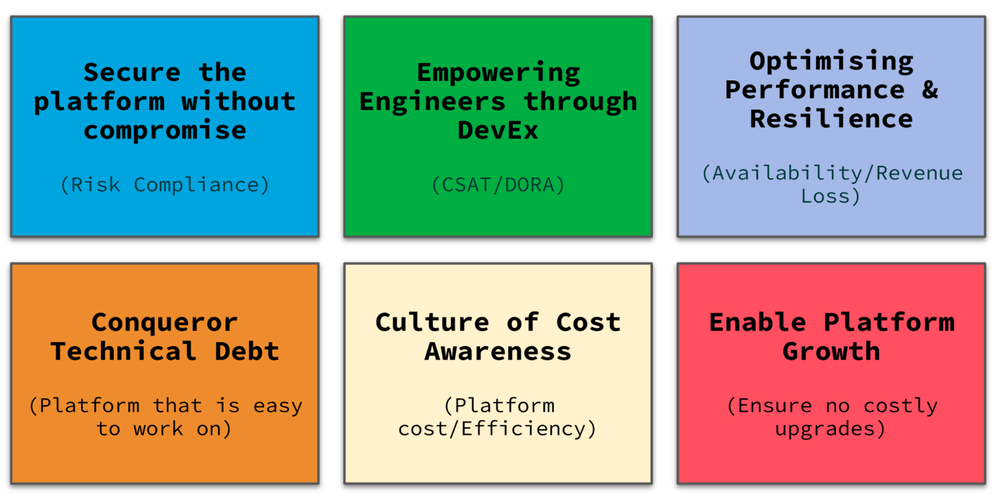

Casi d’uso concreti mostrano come la piattaforma venga applicata oltre il software puro. Starfish Space utilizza Compute Engine e Kubernetes per simulazioni orbitali Monte Carlo, accelerando lo sviluppo dei veicoli satellitari Otter e riducendo i costi hardware. Nel retail, John Lewis Partnership misura il valore della piattaforma attraverso metriche DORA, feedback DX e visualizzazioni in Grafana, collegando performance tecnologica e risultati organizzativi.

| Funzionalità | Stato Disponibilità |

|---|---|

| Claude Opus 4.6 su Vertex AI | ✅ GA (Generale) |

| Adaptive Thinking (Ragionamento Adattivo) | GA |

| Effort Parameter (Controllo livello di sforzo) | GA |

| 128k Output Tokens (Lunghezza risposta aumentata) | GA |

| Fine-grained Tool Streaming (Toggle per streaming granulare) | GA |

| Tool Params Consistency (Coerenza quoting parametri) | GA |

| 1M Context Window (Finestra di contesto estesa) | ⚠️ Preview |

| Compaction API (Compattazione automatica contesto) | ⚠️ Preview |

Stato del rilascio su Google Cloud Vertex AI: Il modello principale e le funzionalità di ragionamento (Adaptive Thinking) sono pienamente operativi (GA), mentre le capacità di contesto massivo (1 Milione di token) e la nuova API di compattazione sono attualmente in fase di Preview.

Questi esempi evidenziano come l’AI di Google Cloud non sia proposta come sperimentazione isolata, ma come infrastruttura produttiva, misurabile e integrata nei processi aziendali.

Roadmap 2026 e democratizzazione dell’AI enterprise

| Funzionalità | Antigravity IDE | Gemini CLI |

|---|---|---|

| Target (Utente Ideale) | Chiunque voglia creare App (Focus su Agenti AI) | Sviluppatori & Tecnici (Amanti del Terminale) |

| Installazione | Installer Grafico Nessun requisito previo | Tramite NPM (Richiede Node.js) |

| Gestione Agenti Multipli | Agent Manager Dashboard visiva di controllo | Multiplexing Manuale (via tmux o finestre separate) |

| Vantaggi Interfaccia | Browser Integrato Feedback Visivo immediato Debug Nativo | Headless Mode (No UI) Ideale per Scripting CI/CD Accesso a tool locali ( gh, gcloud) |

| Estensibilità | Estensioni Open VSX Protocollo MCP Agent Skills | Estensioni CLI Protocollo MCP Agent Skills |

| Filosofia di Sviluppo | Guidata (Opinionated) con Walkthroughs ricchi | Configurabile (via estensione Conductor) |

Guida alla scelta: Antigravity IDE è la soluzione “chiavi in mano” con browser e debug visivo per chi costruisce app con agenti AI, mentre Gemini CLI offre potenza pura, modalità headless e integrazione con script locali per i dev esperti.

Il roadshow di febbraio 2026 e i programmi di formazione associati indicano una direzione chiara: rendere l’AI production-ready, multimodale e accessibile. I laboratori su orchestrazione multi-agente, Graph RAG e memory persistence mirano a ridurre ulteriormente il gap tra prototipo e produzione. L’inclusione di free tier, crediti di avvio e strumenti CLI rafforza una strategia di democratizzazione controllata, dove la potenza tecnologica è bilanciata da governance e sicurezza.

Domande frequenti su Google Cloud Vertex AI

Google Cloud Vertex AI è adatto a workflow enterprise complessi?

Sì. Vertex AI è progettato per ambienti enterprise grazie a endpoint globali, supporto a modelli avanzati come Claude Opus e Gemini 3, strumenti di governance e integrazione nativa con Kubernetes. La piattaforma consente di orchestrare agenti multi-step, gestire carichi variabili e mantenere controllo su sicurezza e costi.

Qual è il ruolo di Gemini 3 rispetto a Vertex AI?

Gemini 3 agisce come motore di ragionamento e orchestrazione all’interno dello stack Google Cloud. Vertex AI fornisce l’infrastruttura, mentre Gemini 3 abilita workflow agentici, automazione e sviluppo spec-driven, integrandosi tramite CLI, IDE e servizi cloud.

In che modo Google Cloud affronta il tema della sovranità dei dati?

Con Sovereign Cloud, Google Cloud offre configurazioni Data Boundary, Dedicated e Air-Gapped che garantiscono controllo locale dei dati, blocco degli accessi remoti e conformità a normative come NIS2 e DORA. Questo consente l’uso dell’AI anche in contesti altamente regolati.

Il GKE Inference Gateway migliora davvero le prestazioni AI?

Sì. Il GKE Inference Gateway introduce routing intelligente basato su carico e contenuto, riducendo la latenza e migliorando la stabilità. I dati indicano riduzioni significative del time to first token e della latenza P95, rendendo l’inferenza più prevedibile in produzione.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.