Netflix porta l’intelligenza artificiale al centro della sua piattaforma Graph Search, trasformando le query in linguaggio naturale in filtri strutturati affidabili su dati federati enterprise. L’evoluzione nasce da un limite storico: l’accesso allo stato aziendale richiedeva input in un Domain Specific Language (DSL) potente ma complesso, mediato da centinaia di interfacce applicative che traducevano azioni UI in query valide. Con l’arrivo di LLM accessibili e di un’architettura RAG (Retrieval Augmented Generation) mirata, Netflix riduce drasticamente l’attrito cognitivo, mantenendo correttezza sintattica, semantica e pragmatica a scala.

Dal DSL al linguaggio naturale: perché serviva un cambio di paradigma

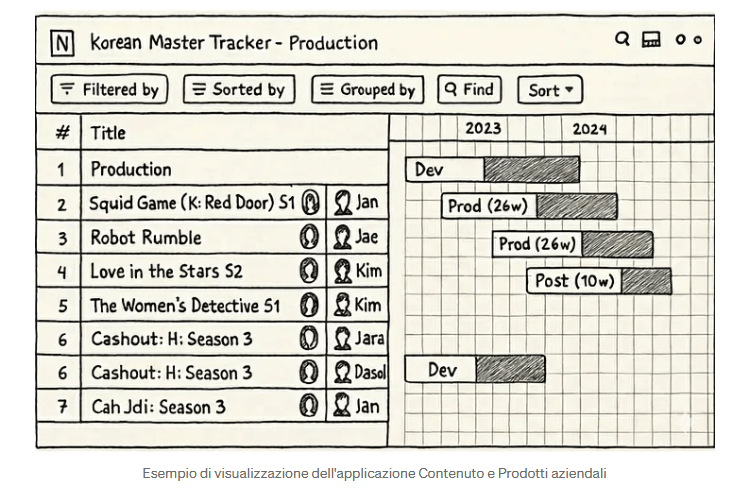

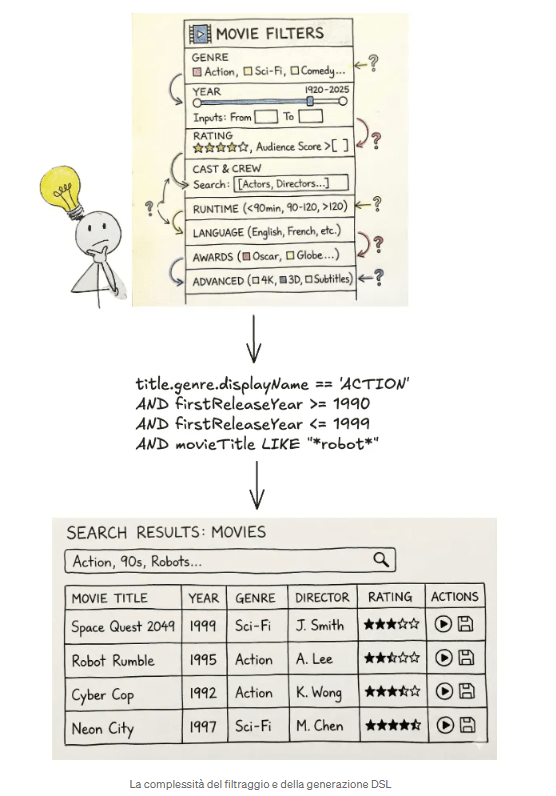

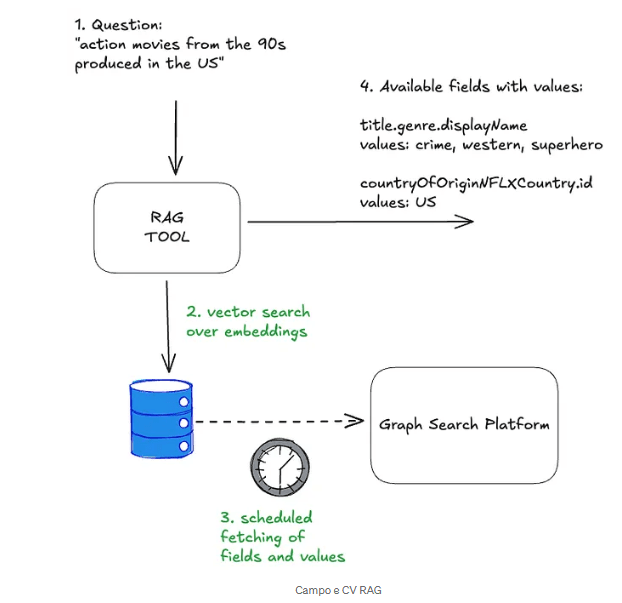

Nei prodotti Content e Business, migliaia di utenti filtrano tabelle e viste per ottenere risposte operative. Un esempio tipico—“tutti i film degli anni ’90 sui robot dagli USA”—è naturale per l’utente, ma storicamente richiedeva che ogni applicazione convertisse controlli UI in DSL. Il risultato era una frammentazione dell’esperienza: componenti bespoke, supporto DSL inconsistente, e una curva di apprendimento diversa per ogni app. Nei domini con centinaia di campi, persino gli esperti venivano rallentati da form complessi e da traduzioni mentali continue tra intento e query.

L’AI consente di invertire il flusso: non più utenti che parlano la lingua dei sistemi, ma sistemi che comprendono la lingua degli utenti—senza perdere precisione.

Text-to-Query su Graph Search: il problema reale

Text-to-SQL è un tema noto, ma Graph Search introduce complessità ulteriori: dati distribuiti, GraphQL come strato di definizione, campi tipizzati, vocabolari controllati e vincoli di dominio. Una conversione utile deve essere sintatticamente valida (parse corretta del DSL), semanticamente corretta (tipi e valori ammessi), e pragmaticamente corretta (l’intento dell’utente è rispettato).

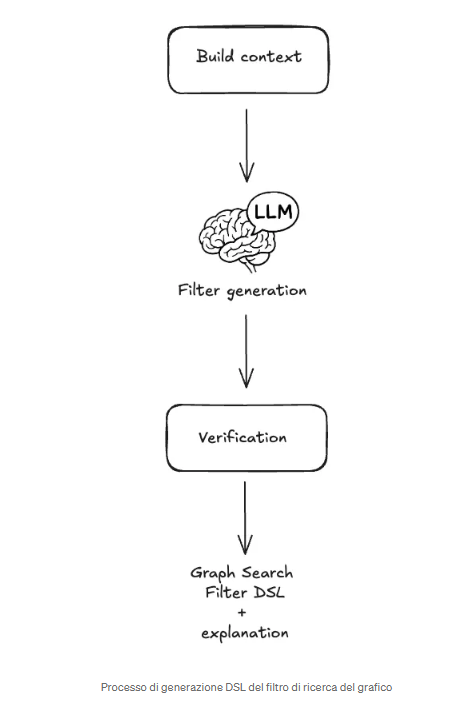

Netflix affronta il problema con una pipeline end-to-end che combina ingegneria del contesto, RAG selettivo, istruzioni LLM mirate e validazioni deterministiche post-generazione.

Ingegneria del contesto: dare all’LLM solo ciò che serve

Gli indici Graph Search possono esporre centinaia di campi e migliaia di valori (enum, foreign key, vocabolari controllati). Fornire tutto all’LLM aumenta latenza e rumore; non fornire i valori rischia allucinazioni. La soluzione è curare il contesto.

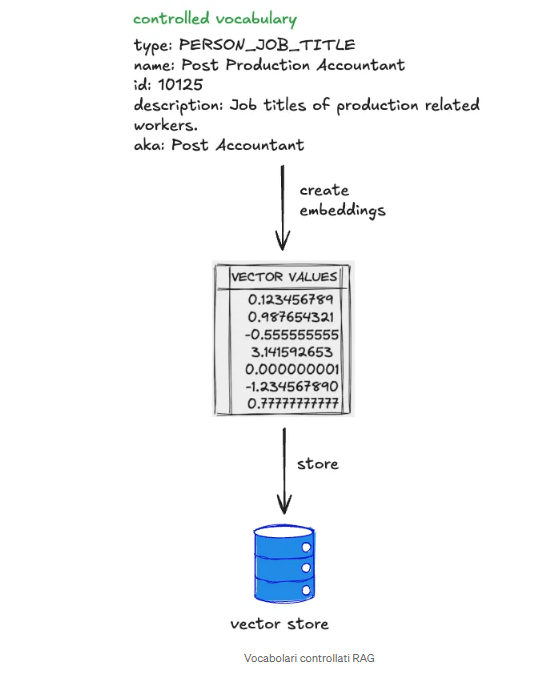

Netflix costruisce embedding sui metadata dei campi (nome, descrizione, tipo) e sui valori dei vocabolari controllati (ID, display name, descrizioni, alias). La query naturale viene segmentata; per ogni segmento, una vector search recupera un top-K di campi e valori rilevanti. I risultati vengono deduplicati e iniettati nel prompt come contesto minimo sufficiente. Questo approccio riduce drasticamente il “needle-in-a-haystack problem”, migliorando accuratezza e determinismo.

Field RAG e Controlled Vocabulary RAG: due livelli, un risultato

Il Field RAG individua i campi pertinenti all’intento; il Controlled Vocabulary RAG identifica i valori corretti quando l’utente allude a concetti come paesi, generi o tag (“USA”, “anni ’90”, “robot”). I vocabolari sono recuperati via GraphQL e reindicizzati periodicamente per restare allineati ai domini. La combinazione dei due livelli consente di ancorare la generazione ai soli campi e valori disponibili, riducendo errori e aumentando la qualità del filtro finale.

Istruzioni LLM e generazione del filtro

Con il contesto pronto, l’LLM riceve istruzioni concise: generare un filtro DSL sintatticamente, semanticamente e pragmaticamente corretto usando esclusivamente il contesto fornito. Le regole di sintassi del DSL sono incluse; la correttezza semantica è “grounded” nei metadata; la correttezza pragmatica è favorita dalla selezione accurata del contesto.

Validazione post-generazione: quando l’AI deve essere verificabile

Prima di restituire il risultato, Netflix applica validazioni deterministiche. Un parser AST verifica la correttezza sintattica; un controllo semantico confronta campi e valori con i metadata. In caso di allucinazioni o incongruenze, il sistema chiede all’utente di affinare la query o attiva retry cauti per l’auto-correzione, mantenendo limiti stretti sui tentativi.

Costruire fiducia: rendere visibile l’intento

La sfida più difficile è la correttezza pragmatica. Ambiguità come “Dark” (titolo specifico vs mood) sono inevitabili nel linguaggio naturale. Netflix affronta il problema rendendo visibile il lavoro dell’AI: i filtri generati non vengono mostrati come DSL grezzo, ma riflessi nella UI sotto forma di chips e facet già familiari. L’utente vede subito cosa è stato selezionato (ad esempio “Country: Germany”) e può correggere con controlli standard. Per ridurre ulteriormente l’ambiguità, la piattaforma supporta @mentions di entità (serie, film), che vincolano esplicitamente il contesto e aumentano la fiducia nei risultati.

Architettura end-to-end e visione di piattaforma

L’architettura separa pre-processing (RAG e costruzione del contesto), generazione (LLM), e post-processing (validazioni e rendering UI). Il risultato è un sistema che aumenta le applicazioni esistenti senza riscriverle, preparando il terreno a RAG più ampi su Graph Search e a una piattaforma self-managed. Netflix evidenzia che questo è solo l’inizio: valutazioni rigorose in produzione, estensioni GraphQL-first e nuove capability (come intent detection e query rewriting) sono parte della roadmap.

Perché conta

Con questa evoluzione, Netflix colma il divario tra complessità enterprise e interazioni naturali, spostando l’onere dal linguaggio degli utenti a quello dei sistemi—senza sacrificare affidabilità. È un caso di studio su come LLM, RAG e validazioni deterministiche possano convivere per rendere usabile ciò che è intrinsecamente complesso.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.