Anthropic sceglie una mossa che vale più di un annuncio: si posiziona come “buon vicino” della rete elettrica e prova a disinnescare una delle critiche più tossiche verso l’industria dell’AI, quella per cui i data center fanno crescere i costi infrastrutturali e questi finiscono in bolletta, anche per chi non usa mai un chatbot. La promessa è netta: coprire il 100% dei costi infrastrutturali della rete legati ai propri carichi AI, assumendosi gli oneri degli aggiornamenti necessari e impegnandosi a non scaricare sugli utenti americani gli aumenti indotti dalla domanda di elettricità dei server.

La questione non è più teorica. Nel settore circola una stima diventata bandiera politica: l’AI negli Stati Uniti richiede almeno 50 GW nei prossimi anni. È una cifra che fa capire perché i carichi da GPU non siano più “un problema da hyperscaler”, ma un tema che entra nei dossier di regolatori, utility, autorità locali, senatori e candidati. Anthropic incrocia questo scenario e tenta un ribaltamento di narrativa: se l’AI ha bisogno di nuova energia e di una rete più robusta, allora chi cresce con l’AI deve pagare la sua quota, senza socializzare i costi.

In parallelo, la stessa Anthropic spinge sul fronte prodotto e sul fronte percezione: aggiorna Claude liberando funzioni prima riservate agli abbonati, mantenendo l’esperienza senza annunci e trasformando la gratuità in un messaggio competitivo. Nel testo emerge un sottinteso chiaro: mentre alcuni concorrenti aprono la porta alla pubblicità per i piani free, Claude prova a diventare il rifugio “pulito” per chi non vuole un assistente che interrompe o monetizza l’attenzione.

Energia, rete elettrica e l’AI che entra in bolletta

Il cuore della mossa di Anthropic è un cambio di postura su come si paga la crescita dell’AI. I data center, soprattutto quelli con carichi intensivi da GPU, non chiedono soltanto energia, ma chiedono capacità di trasmissione, interconnessioni, aggiornamenti di rete e investimenti che spesso vengono giustificati come infrastruttura “per tutti”, pur nascendo per far fronte a picchi localizzati. Anthropic dichiara di voler coprire gli aumenti dei prezzi dell’elettricità attribuiti alla domanda aggiuntiva dei propri centri e di investire in sistemi che riducano lo stress sulla rete.

Qui entra il dato più utile per capire perché l’argomento diventi infiammabile: in alcune aree, i prezzi all’ingrosso dell’elettricità risultano cresciuti del 267% negli ultimi cinque anni, in un contesto in cui gli aggiornamenti di rete per gestire carichi ad alta densità diventano un pezzo della spesa complessiva. Anthropic prova a incastrare quel numero in una promessa: se la rete diventa più cara perché io pretendo più energia e più capacità, allora io pago la differenza e non la metto sulle spalle dei consumatori.

Il passaggio successivo è ancora più ambizioso: Anthropic non si limita a dire “pago l’upgrade”, ma sostiene l’idea di produrre nuove fonti di energia per soddisfare esigenze future. In termini di comunicazione, è il tentativo di spostare l’AI da “predatore di energia” a “abilitatore di nuova energia”, cioè da causa di tensione a motore di investimenti. È una narrazione che piace a politica e utility perché offre un percorso: i data center pagano e accelerano la costruzione di capacità, e la rete potenziata diventa un beneficio diffuso.

Questa impostazione però vive di un equilibrio delicato. Se davvero l’AI corre verso 50 GW, allora le scelte su dove costruire, come ottenere i permessi, come collegare la nuova generazione e come distribuire i costi smettono di essere dettagli tecnici e diventano politica industriale. Anthropic lo sa e, infatti, lega l’impegno economico a una richiesta precisa: interventi governativi per permessi più rapidi, sviluppo della trasmissione e interconnessioni di rete che rendano più semplice aggiungere capacità “per tutti”, non solo per gli hyperscaler.

Pressione politica: senatori, bollette e la frase di Trump

Quando un argomento entra nel linguaggio delle bollette, cambia di livello. Nel testo si vede bene la traiettoria: senatori statunitensi inviano lettere a colossi come Amazon, Google e Meta per chiarire l’impatto dei data center sulle bollette residenziali, mentre Donald Trump porta la questione nel registro più semplice e più efficace per il pubblico: le aziende tech AI devono pagare il proprio consumo elettrico. L’AI viene così incorniciata non solo come tecnologia, ma come carico industriale che deve rispondere a una domanda di equità.

Anthropic usa questa cornice a proprio vantaggio e prova ad anticipare la prossima fase, quella in cui le utility e gli Stati iniziano a chiedere garanzie su chi paga infrastrutture e picchi. L’impegno “100% dei costi” diventa un modo per presentarsi come soggetto responsabile, pronto a trattare l’energia come parte del prezzo di crescita dell’AI. Non è un gesto filantropico: è una forma di assicurazione reputazionale in un mercato in cui il rischio è ritrovarsi addosso l’etichetta di azienda che “consuma e scarica sugli altri”.

Il contesto tecnico rende la tensione ancora più evidente. Il CEO di Microsoft, secondo quanto riportato nel testo, sottolinea un limite che sembra banale e invece racconta lo stato della corsa: non c’è elettricità sufficiente per installare tutte le GPU AI già disponibili in inventario. È l’immagine più concreta del collo di bottiglia: non è solo mancanza di chip o di fabbriche, è mancanza di potenza elettrica pronta e di rete in grado di sostenerla. In questo scenario, chi riesce a garantirsi energia e capacità di connessione ottiene un vantaggio competitivo quasi quanto chi riesce a garantirsi GPU.

Microsoft e OpenAI: impegni simili e una corsa alla legittimità

Anthropic non si muove nel vuoto. Il testo colloca la scelta dentro una sequenza di promesse che coinvolgono anche Microsoft e OpenAI. Microsoft parla di essere un “buon vicino” e di coprire aumenti energetici; OpenAI impegna fondi per aggiornamenti della rete e per carichi flessibili, cioè per sistemi che possano modulare domanda e ridurre i picchi, alleggerendo la pressione su grid e interconnessioni.

Questa convergenza indica un cambiamento di fase: l’industria dell’AI non vende più solo modelli, vende la capacità di crescere senza far saltare il patto sociale sull’energia. Pagare la rete, accelerare i permessi, investire in nuova generazione diventano strumenti di legittimazione oltre che di continuità operativa. Anthropic lo fa con una formula radicale, “100% dei costi”, che suona come un tentativo di fissare uno standard e costringere gli altri a inseguire sul piano reputazionale.

Claude apre funzioni gratis: file, connettori e competenze

Sul fronte prodotto, Anthropic compie un gesto altrettanto strategico: porta agli utenti gratuiti funzioni che prima erano per abbonati. Qui la leva è chiara: la differenza tra un assistente “da provare” e un assistente “da usare” sta nel momento in cui può produrre output reali e integrarsi nel lavoro quotidiano. Claude, secondo il testo, abilita per i free la creazione di file direttamente nelle conversazioni, con output come fogli Excel, presentazioni PowerPoint, documenti Word e persino PDF.

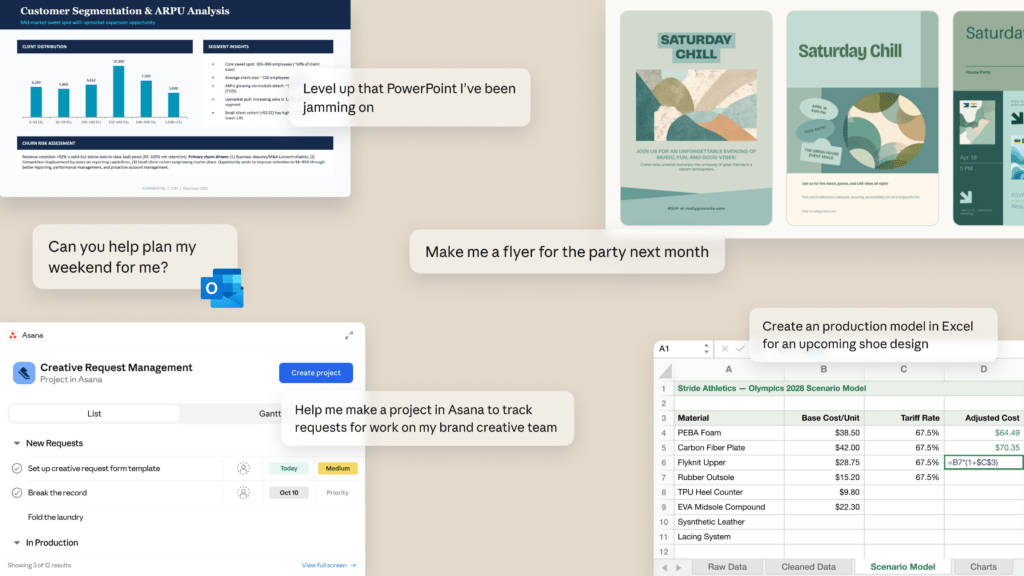

La scelta non è solo generosità. È un modo per spostare l’uso da chat a workspace e per trasformare Claude in un tool che sostituisce piccoli pezzi di suite d’ufficio, senza chiedere subito una carta di credito. In più, Anthropic introduce i connettori con servizi terzi, citando integrazioni con strumenti operativi come Slack, Asana, Zapier, Stripe, Canva, Notion, Figma e WordPress. È una lista che racconta l’obiettivo: entrare nei flussi di lavoro, non restare nel recinto della conversazione.

Il testo parla anche di competenze basate su filesystem e di skill predefinite per PowerPoint, Excel, Word e PDF, oltre alla possibilità di creare skill personalizzate con conoscenze organizzative. In pratica, Anthropic prova a rendere Claude più simile a una piattaforma estendibile, dove l’AI non è solo “risposta”, ma è procedura, template, automazione e, soprattutto, contesto riusabile. In un mercato dove i modelli tendono a somigliarsi, la differenza competitiva si sposta su strumenti, integrazioni e capacità di trasformare input in output direttamente utilizzabili.

La compattazione del contesto: conversazioni più lunghe senza “reset”

Tra le funzioni citate, la compattazione del contesto è una delle più rilevanti sul piano dell’esperienza. Anthropic punta a conversazioni più lunghe riassumendo automaticamente quanto già avvenuto, mantenendo il flusso senza costringere l’utente a ricominciare da capo. È un dettaglio che pesa perché molte frustrazioni degli utenti nascono proprio da qui: perdita di contesto, ripetizioni, e necessità di ricostruire istruzioni. Anthropic promette una gestione più fluida, pur mantenendo invariati i limiti di utilizzo per gli account free.

Nel testo viene citato anche l’assetto dei modelli: gli utenti gratuiti usano Sonnet 4.5, mentre i Pro accedono a Opus. Anche questo è un pezzo di strategia: aumentare valore percepito sul piano free senza smontare la differenziazione del piano a pagamento.

Claude ad-free e la concorrenza con la pubblicità

La parte più apertamente competitiva è la scelta di ribadire che Claude resta senza annunci. Nel contesto descritto, questa caratteristica diventa una calamita per utenti che non vogliono un assistente “monetizzato”. Il testo suggerisce che Claude attiri persone insoddisfatte dagli ads in ChatGPT, e colloca la tempistica in una finestra molto stretta: un annuncio ad-free di Anthropic e, poco dopo, l’avvio della pubblicità su piani non paganti o su tier specifici di OpenAI.

Questa dinamica crea un mercato nuovo: non più solo “qual è il modello migliore”, ma “quale assistente è più tollerabile nel quotidiano”. Se la pubblicità entra nell’interazione, cambia il rapporto psicologico con l’AI. Anthropic prova a capitalizzare quel momento e a definire Claude come alternativa “pulita”, dove il valore arriva da feature e integrazioni, non dall’attenzione venduta.

OpenAI aggiorna ChatGPT: ricerca profonda con visualizzatore documenti

Nel testo, la risposta di OpenAI non passa solo dalla qualità del modello, ma da un aggiornamento dell’esperienza di ricerca profonda. La novità più tangibile è un visualizzatore documenti a schermo intero, separato dalla finestra chat, che permette di sfogliare report generati come un documento vero, con una tabella dei contenuti a sinistra e una colonna dedicata alle citazioni a destra. La direzione è chiara: trasformare la ricerca in un oggetto navigabile e verificabile, non in un flusso di messaggi. OpenAI aggiunge anche controlli per focalizzare la ricerca, includendo siti web specifici e una collezione più ampia di app connesse come fonti considerate affidabili. È un tentativo di aumentare controllo e trasparenza, due punti dove gli utenti più esigenti valutano la differenza tra “chat” e “strumento”.

Nel testo, la ricerca profonda viene descritta come una funzione che scompone domande in parti, raccoglie e confronta informazioni dal web, verifica claim e sintetizza risultati in risposte coerenti. L’upgrade della sidebar, con possibilità di creare e modificare un piano di ricerca prima di iniziare e di tracciare progressi con aggiustamenti in corso, spinge verso una ricerca più “professionale”, più simile a un workflow che a una domanda singola. L’uscita segue una logica di rollout: prima abbonati Plus e Pro, poi estensione a tier più bassi e gratuiti nei giorni successivi. Anche qui si vede la competizione: la ricerca diventa un prodotto a sé, e l’AI da chat si sposta verso un ruolo di “analista” che produce report esportabili in Markdown, Word e PDF.

Chat temporanee: personalizzazione senza contaminare l’account

Il testo aggiunge un’altra evoluzione: il potenziamento delle chat temporanee in ChatGPT, con una promessa che cerca di conciliare due desideri opposti. Da un lato, la chat temporanea nasce come spazio “pulito”, che non usa o referenzia conversazioni passate e non influisce sull’account. Dall’altro, molti utenti vogliono comunque mantenere personalizzazioni, preferenze di tono e istruzioni custom. L’upgrade descritto punta a trattenere la personalizzazione senza rendere permanente la conversazione, mantenendola fuori dalla cronologia e non usandola per migliorare i modelli, con una conservazione di sicurezza fino a 30 giorni per motivi di compliance. In pratica, OpenAI prova a trasformare la temporaneità in una modalità utilizzabile davvero, non in un compromesso scomodo. Nel testo compare anche un tema sensibile: un modello di predizione dell’età basato su pattern di chat e comportamento conversazionale, con avvertenza che può sbagliare, scambiando adulti per teenager o viceversa. È un altro segnale del clima: l’AI consumer entra in una fase in cui sicurezza e policy diventano caratteristiche di prodotto, non solo clausole legali.

Energia e funzioni gratuite: due fronti della stessa guerra competitiva

La cosa più interessante, guardando insieme i pezzi, è che Anthropic sta combattendo su due piani che sembrano separati ma in realtà si parlano. Sul piano energia, l’azienda si mette avanti per evitare un contraccolpo politico e reputazionale: pago io, non paga il cittadino. Sul piano prodotto, apre funzioni avanzate gratis e insiste sull’assenza di ads: do valore, non vendo la tua attenzione. È una strategia coerente: ridurre frizioni, ridurre ostilità, aumentare fiducia. OpenAI risponde spingendo sull’idea che ChatGPT non sia solo un chatbot, ma un ambiente di lavoro dove la ricerca diventa documento e dove la privacy può essere gestita con modalità temporanee più comode. Microsoft, nel frattempo, segnala che la competizione non si vince solo con modelli e feature, ma con la capacità di trovare energia sufficiente per alimentare le GPU. Il mercato dell’AI, in questa fotografia, si sposta dal “chi è più intelligente” al “chi è più sostenibile”, “chi è più integrabile”, “chi è più credibile” e “chi è più accettabile” per utenti, aziende e politica. Anthropic tenta di trasformare energia e gratuità in un vantaggio reputazionale e di prodotto, mentre OpenAI alza il livello di usabilità e controllo della ricerca. In mezzo, la rete elettrica diventa un campo di battaglia dove la potenza richiesta non è più un dettaglio tecnico, ma una leva che può decidere chi scala e chi resta indietro.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.