Nvidia Blackwell Ultra guida una doppia trasformazione: da un lato l’adozione massiva dell’AI nelle telecomunicazioni, dall’altro un salto prestazionale nell’inference con architetture pensate per AI agentica e workload a bassa latenza. I dati del quarto sondaggio annuale di Nvidia mostrano che l’AI non è più sperimentazione, ma infrastruttura operativa. In parallelo, la piattaforma GB300 NVL72 promette fino a 50x throughput per megawatt rispetto a Hopper e fino a 35x riduzione dei costi per token nei carichi a bassa latenza.

AI nelle telecom: dal movimento dei bit al movimento dell’intelligenza

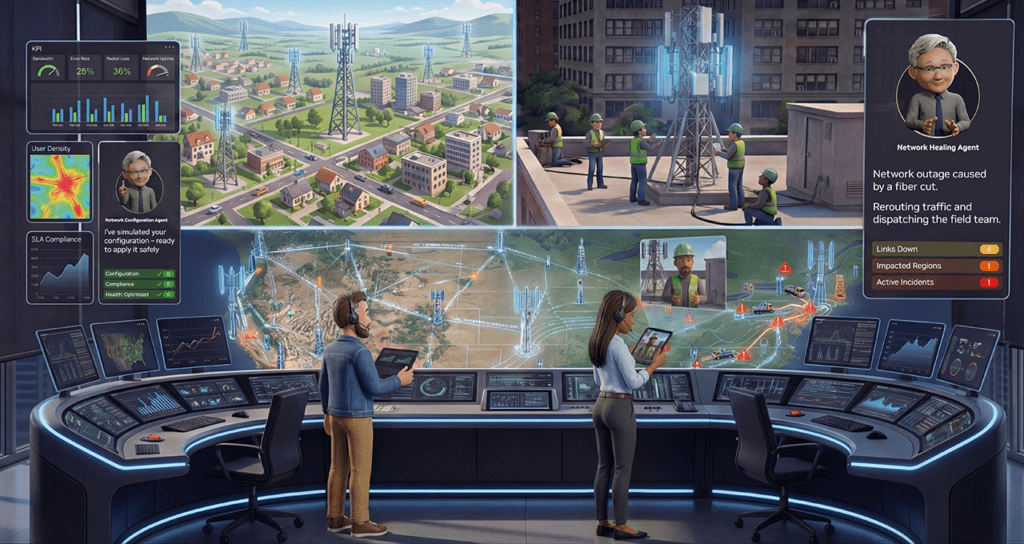

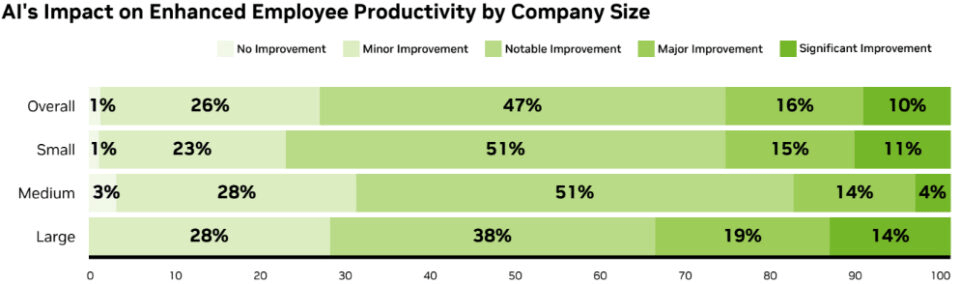

Il quarto sondaggio globale di Nvidia sullo stato dell’AI nelle telecomunicazioni raccoglie 1.000 risposte, con gli operatori telco che rappresentano circa un quarto del campione. Il dato più rilevante è sistemico: il 90% degli intervistati afferma che l’AI aumenta i ricavi annuali e riduce i costi operativi. Nel segmento telecom la percentuale si conferma al 90%, segnale di un ritorno sull’investimento percepito come concreto e misurabile. Il 77% degli intervistati prevede reti native AI prima del 6G, mentre il 65% degli operatori identifica l’AI come driver principale dell’automazione di rete. L’automazione supera l’esperienza cliente come use case prioritario in termini di ROI. Le reti autonome diventano il centro di gravità degli investimenti. Sebastian Barros, alla guida di Circles a Singapore, descrive la transizione come uno “shift sismico”. I provider di comunicazione smettono di limitarsi al trasporto dei dati e si posizionano come AICO, aziende di infrastrutture AI che operano vicino alla rete e in ambienti regolati. È un passaggio strutturale: non solo connettività, ma orchestrazione di intelligenza distribuita.

Reti autonome, ROI immediato e livelli TM Forum

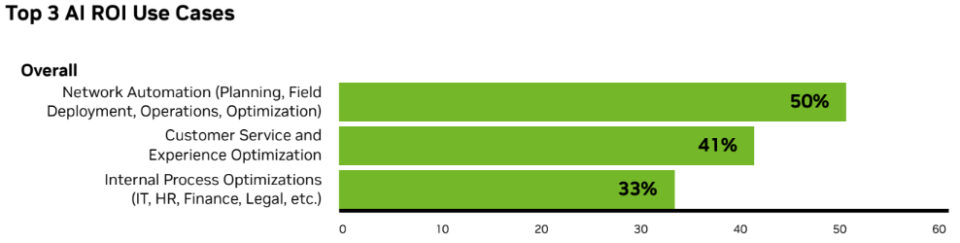

Nove intervistati su dieci dichiarano che l’AI genera sia incremento di revenue sia riduzione dei costi. Gli use case con ritorno più rapido includono le reti autonome al 50%, il miglioramento del servizio clienti al 41% e l’ottimizzazione dei processi interni al 33%.

Le reti autonome eliminano attività manuali ripetitive e intervengono su gestione energetica, predizione dei guasti, correzione della deriva di configurazione e pianificazione della capacità. L’88% delle organizzazioni si colloca oggi tra i livelli 1–3 di autonomia secondo il framework TM Forum, ma l’adozione di AI generativa e soprattutto AI agentica accelera la corsa verso il livello 5, quello di piena autonomia.

Chetan Sharma, di Chetan Sharma Consulting, sottolinea che l’AI agentica coordina decisioni in tempo reale tra domini di rete e IT, riducendo outage, consumi energetici e interventi manuali. L’89% dei telco prevede un aumento della spesa in AI nel 2026, rispetto al 65% dell’anno precedente, con il 35% che pianifica incrementi superiori al 10%.

Edge computing e RAN native AI

L’integrazione dell’AI nell’edge computing ridefinisce l’architettura delle reti. Portare l’inference vicino all’utente finale significa ridurre latenza e migliorare le performance delle applicazioni AI distribuite. I telco stanno investendo in RAN native AI e in preparazione al 6G, con il 77% che anticipa un rapido deployment di architetture wireless native AI. I driver principali includono efficienza spettrale, performance RAN per applicazioni edge AI e accelerazione della ricerca e sviluppo 6G. L’89% degli intervistati considera i modelli open source centrali nella propria strategia AI, mentre il 60% utilizza o valuta AI generativa, in crescita rispetto al 49% del 2024.

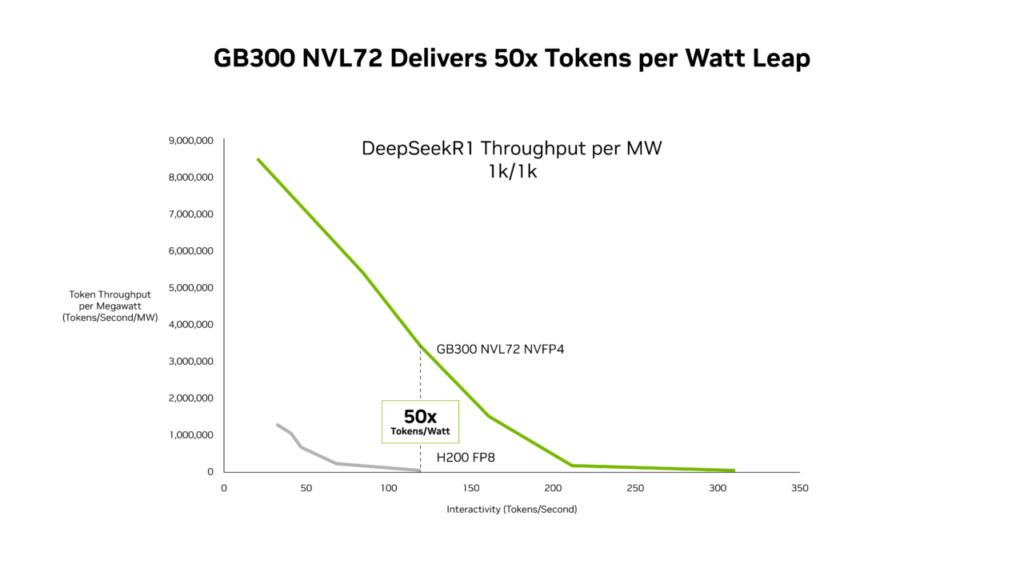

Blackwell Ultra e GB300 NVL72: 50x throughput per megawatt

Sul fronte hardware, Nvidia introduce dati di SemiAnalysis InferenceX che mostrano come Blackwell Ultra e in particolare GB300 NVL72 offrano fino a 50x throughput per megawatt rispetto a Hopper. Nei workload a bassa latenza, i costi per milione di token risultano fino a 35x inferiori. Provider come Microsoft, CoreWeave e Oracle Cloud Infrastructure stanno già distribuendo GB300 NVL72 per carichi agentici e applicazioni di coding AI. Secondo report di OpenRouter, le query legate alla programmazione AI sono passate dall’11% al 50%, segnale di un’esplosione della domanda per applicazioni che richiedono latenza minima e contesto esteso.

Il design co-ottimizzato hardware-software è centrale. Tecnologie come TensorRT-LLM migliorano le performance fino a 5x su GB200, mentre ottimizzazioni kernel GPU ad alta efficienza e NVLink Symmetric Memory consentono accesso diretto GPU-to-GPU riducendo latenza e overhead. Il lancio programmatico dipendente minimizza il tempo idle avviando il setup del kernel successivo prima del completamento del precedente.

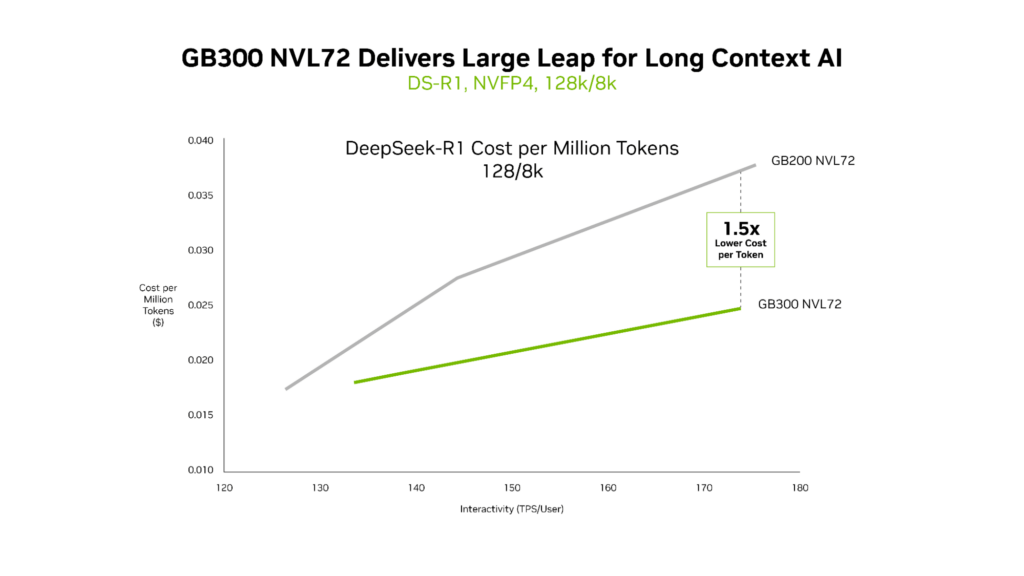

Lungo contesto e reasoning su codebase

Per workload con input fino a 128.000 token e output da 8.000 token, il GB300 NVL72 offre circa 1,5x costi inferiori rispetto al GB200 NVL72. Questo scenario è tipico degli assistenti di coding agentico che analizzano intere codebase. Blackwell Ultra introduce 1,5x performance NVFP4 superiori e 2x velocità di attention processing, migliorando la comprensione su contesti estesi.

Chen Goldberg, responsabile engineering di CoreWeave, evidenzia come l’inference sia ormai il centro della produzione AI. Performance su lungo contesto ed efficienza per token diventano variabili decisive per l’economia dei modelli su scala.

Rubin: la prossima ondata

Nvidia anticipa anche la piattaforma Rubin, che combinerà sei nuovi chip in un supercomputer AI dedicato. Per MoE inference, Rubin promette 10x throughput per megawatt rispetto a Blackwell e un decimo dei costi per milione di token. Per l’addestramento di modelli MoE di frontiera, sarebbe sufficiente un quarto delle GPU necessarie con Blackwell.

Implicazioni sistemiche per AI e telecom

La convergenza tra reti autonome e piattaforme ad alta efficienza come Blackwell Ultra crea un ciclo virtuoso. I telco riducono costi e aumentano ricavi grazie all’automazione AI. Le infrastrutture hardware riducono drasticamente i costi per token, rendendo sostenibili applicazioni agentiche in tempo reale su scala globale. La trasformazione non è solo tecnologica ma economica. Se l’AI agentica coordina decisioni tra rete, IT e customer journey senza intervento umano, e se l’inference diventa fino a 35x più economica, il modello operativo delle telecom cambia struttura. Le reti non trasportano solo traffico, ma orchestrano intelligenza distribuita a bassa latenza.

L’AI nelle telecom è un vantaggio competitivo o una necessità?

Con il 90% degli operatori che registra benefici economici e con investimenti in aumento nel 2026, l’AI non appare più come opzione strategica ma come prerequisito competitivo. L’arrivo di piattaforme come GB300 NVL72 e, in prospettiva, Rubin, suggerisce che l’efficienza energetica e il costo per token diventeranno metriche centrali tanto quanto la copertura di rete o la capacità di banda. In questo scenario, chi integra prima reti autonome e infrastrutture AI ad alta efficienza potrebbe ridefinire l’equilibrio del settore.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.