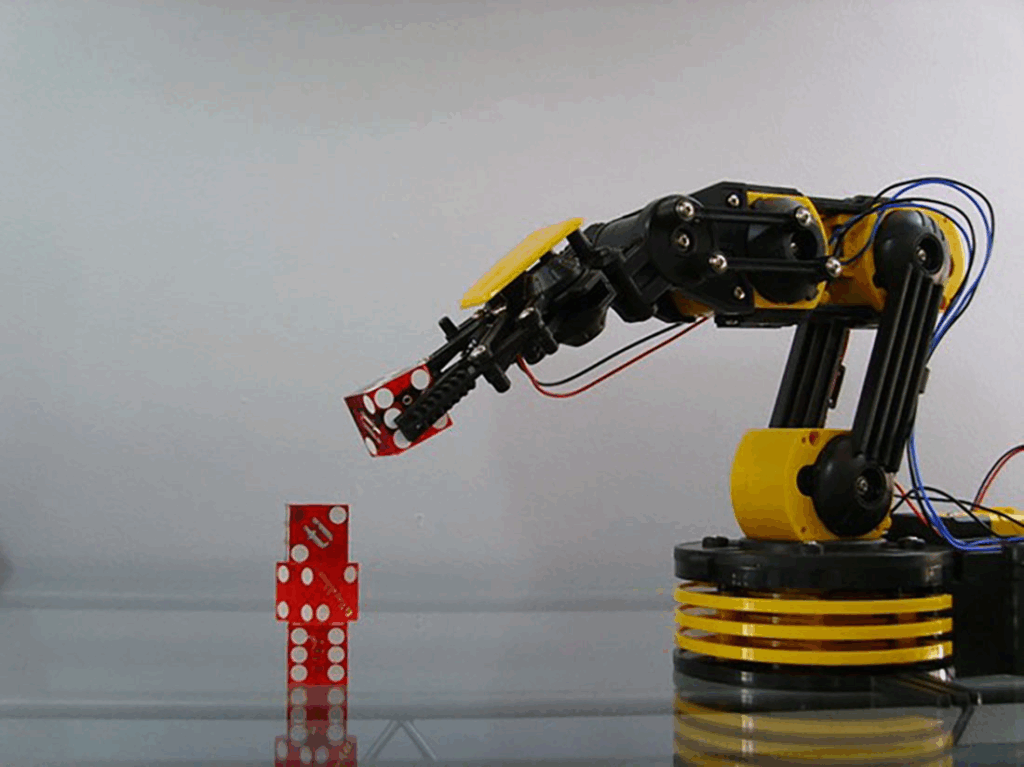

La stima della posa degli oggetti tenuti da mani o bracci robotici rappresenta una delle sfide cruciali per la robotica moderna, la computer vision e le applicazioni di realtà aumentata. Le difficoltà maggiori derivano dalle occlusioni causate dalla mano che impugna l’oggetto e dalle trasformazioni non rigide indotte dall’interazione mano-oggetto, come nel caso di oggetti deformabili o manipolati in modo complesso. Inoltre, le tecniche attuali spesso soffrono di disallineamento tra le caratteristiche estratte da dati RGB e RGB-D, complicando ulteriormente l’accuratezza della stima della posa.

Innovazione del team del Shibaura Institute of Technology e FPT University

Per superare questi limiti, un gruppo di ricerca guidato dal Professor Phan Xuan Tan (Shibaura Institute of Technology) insieme a Dr. Dinh-Cuong Hoang (FPT University) ha sviluppato un framework deep learning innovativo per la stima della posa tramite immagini RGB-D, che sarà pubblicato su Alexandria Engineering Journal. Il punto di forza della proposta è un meccanismo di fusione a votazione (“vote-based fusion”) in grado di integrare efficacemente informazioni bidimensionali (RGB) e tridimensionali (profondità), affrontando sia le occlusioni sia le difficoltà di fusione multimodale. Il framework decoupla inoltre il processo di apprendimento e integra un modello self-attention per modellare l’interazione mano-oggetto.

Architettura della rete e voto fusion

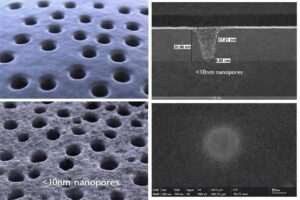

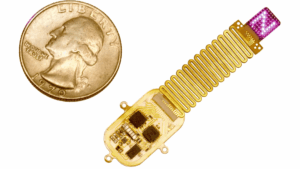

Il sistema è composto da quattro moduli principali: due backbone per l’estrazione delle feature da immagini 2D e cloud di punti 3D, moduli di voto separati, una nuova vote-based fusion module e un modulo hand-aware per la stima della posa. In pratica, le backbone estraggono i keypoints di mano e oggetto sia in 2D che in 3D. I moduli di voto raccolgono le predizioni su questi keypoints separatamente.

Successivamente, il modulo di fusione a votazione integra dinamicamente i voti provenienti dai due domini utilizzando una proiezione locale basata su raggio (radius-based neighborhood projection) e un meccanismo di channel attention. Questa architettura consente di preservare informazioni locali rilevanti e di adattarsi a condizioni di input variabili, rendendo il sistema più robusto ed efficace rispetto ai precedenti. Grazie a questo approccio, si mitigano gli effetti delle occlusioni e delle misallineamenti tra dati RGB e depth, portando a una stima della posa più precisa anche in scenari complessi e dinamici.

Il modulo hand-aware sfrutta una self-attention avanzata per modellare la relazione tra i keypoints di mano e oggetto, fondamentale per compensare le trasformazioni non rigide e la variabilità della presa.

Risultati sperimentali e applicazioni

Il framework è stato testato su tre dataset pubblici, ottenendo incrementi di accuratezza fino al 15% rispetto alle migliori tecniche esistenti e una robustezza superiore in condizioni reali. In esperimenti su campo, la precisione media raggiunta è stata del 76,8%, con miglioramenti fino al 13,9% sulle baseline. L’inferenza è estremamente rapida, con tempi fino a 40 ms senza refinement e 200 ms con refinement, garantendo applicabilità in contesti reali e sistemi robotici interattivi.

Implicazioni per robotica, computer vision e AR

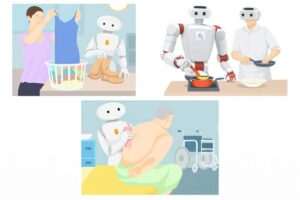

Questa ricerca affronta in modo diretto uno dei principali ostacoli nella robotica avanzata: la stima accurata della posa di oggetti in presenza di occlusioni, deformazioni e interazioni mano-oggetto complesse. L’approccio proposto è sia più preciso che più semplice di molte alternative, favorendo l’adozione su larga scala in settori come robotica industriale, robotica assistiva e tecnologie AR/VR immersive.

La nuova architettura deep learning del team Shibaura Institute of Technology rappresenta un progresso significativo per la stima della posa in scenari dinamici e occlusi. Il meccanismo di voto e la self-attention garantiscono accuratezza, robustezza e rapidità di calcolo, aprendo la strada a robot più intelligenti e a interazioni uomo-macchina più realistiche in realtà aumentata e virtuale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.