La nuova architettura Nvidia Blackwell segna un punto di svolta per l’intera industria dell’intelligenza artificiale. La piattaforma, progettata per unire efficienza energetica e potenza di calcolo, debutta nel primo cluster GB300 NVL72 ospitato su Microsoft Azure, aprendo una nuova era di supercomputing AI su scala industriale. Parallelamente, i benchmark InferenceMAX v1 certificano prestazioni senza precedenti, consolidando la leadership di Nvidia nelle infrastrutture destinate a modelli di grandi dimensioni e agenti multimodali.

Cosa leggere

Cluster GB300 NVL72 su Microsoft Azure

La serie NDv6 GB300 VM di Microsoft Azure rappresenta la prima implementazione globale della nuova piattaforma GB300 NVL72, una soluzione costruita per gestire i carichi più intensivi di ragionamento artificiale e inferenza in tempo reale. Ogni rack ospita 72 GPU Blackwell Ultra e 36 CPU Grace, in un design raffreddato a liquido per mantenere l’efficienza termica anche sotto i carichi più elevati. Il sistema offre 37 terabyte di memoria ad accesso rapido per VM, una rete interna NVLink di quinta generazione da 130 terabyte al secondo e una connessione Quantum-X800 InfiniBand da 800 Gb/s per GPU, elementi che consentono una comunicazione quasi istantanea tra le unità di calcolo. Il cluster complessivo supera le 4.600 GPU Blackwell collegate e fornisce una potenza di 1,44 exaflops in FP4 Tensor Core per singola VM, una capacità progettata per gestire modelli agentici e multimodali di nuova generazione. La partnership tra Nvidia e Microsoft consente a OpenAI di accedere a un’infrastruttura capace di alimentare training e inferenza su larga scala per modelli come GPT-Next e DALL-E avanzati, riducendo tempi di elaborazione e consumi energetici. Nidhi Chappell, vicepresidente di Azure AI Infrastructure, ha confermato che questa generazione di data center è stata “ripensata da zero” per rispondere alle esigenze dei modelli emergenti, con un’attenzione particolare alla scalabilità modulare e all’integrazione di sistemi di raffreddamento liquido che consentono di spingere oltre i limiti di densità computazionale.

Benchmark InferenceMAX: efficienza e ritorno economico

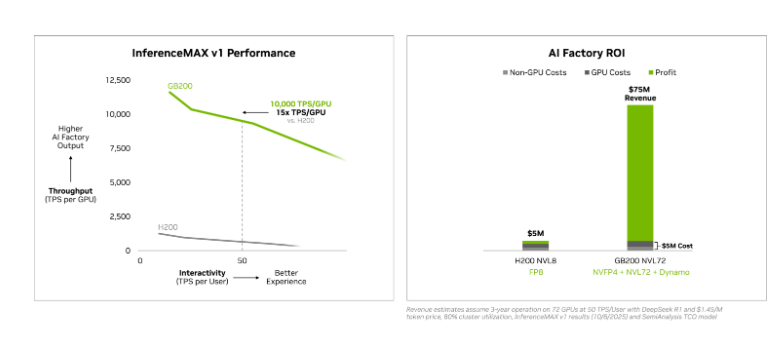

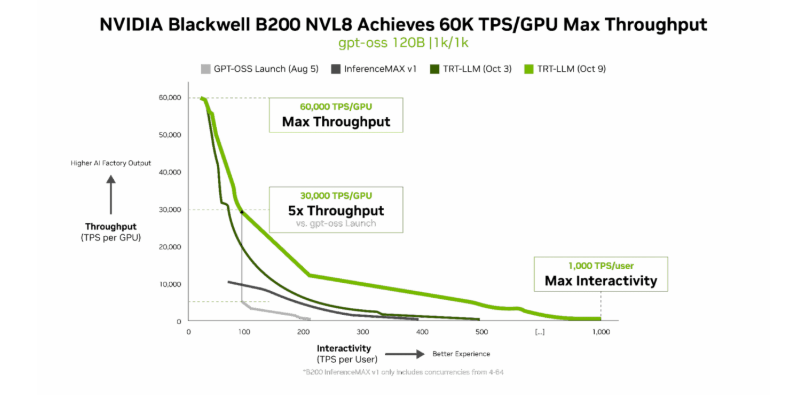

I test InferenceMAX v1 collocano Nvidia Blackwell in una posizione dominante nei benchmark globali per inferenza AI. Un singolo sistema GB300 NVL72 da 4,58 milioni di euro è in grado di generare ricavi stimati in 68,7 milioni di euro derivanti dai token elaborati nei modelli DSR1, registrando un ritorno economico quindici volte superiore all’investimento iniziale. Ogni GPU B200 della famiglia Blackwell elabora fino a 60.000 token al secondo, con un costo medio di due centesimi di euro per milione di token, valori che rappresentano un miglioramento di cinque volte rispetto alla generazione Hopper. Nei test con modelli GPT-OSS 120B, Llama 3.1 405B e DeepSeek-R1, Blackwell garantisce un throughput cinque volte superiore e una latenza inferiore del 70%, ridefinendo i parametri di efficienza per le architetture AI enterprise.

L’adozione di framework come TensorRT-LLM v1.0 e Dynamo consente di sfruttare appieno la banda NVLink Switch da 1.800 GB/s, aumentando la parallelizzazione dei processi e riducendo i colli di bottiglia tra GPU. Su Llama 3.3 70B, la piattaforma ha raggiunto oltre 10.000 token al secondo per GPU, quadruplando le prestazioni del predecessore H200. L’efficienza energetica resta uno dei tratti distintivi della generazione Blackwell: secondo i benchmark, l’architettura fornisce dieci volte più throughput per megawatt rispetto alle generazioni precedenti, garantendo costi operativi fino a quindici volte inferiori per ogni milione di token elaborato.

Tecnologie chiave e infrastruttura

Il segreto del successo di Blackwell risiede nel codesign hardware-software e nella piena integrazione tra NVFP4, NVLink di quinta generazione e NVSwitch, elementi che permettono una comunicazione simultanea tra decine di migliaia di GPU. L’architettura sfrutta memoria unificata per ridurre le latenze tra CPU e GPU, una caratteristica fondamentale per i carichi di AI agentica e modelli multimodali a contesto esteso. La rete two-tier di Azure collega i rack NVL72 tramite NVLink intra-rack e Quantum-X800 inter-rack, con funzionalità di adaptive routing e protocollo SHARP v4 per ridurre la congestione dei pacchetti. Queste innovazioni consentono una scalabilità quasi lineare su migliaia di GPU, aprendo la strada a AI factory completamente automatizzate. Nvidia accompagna il rilascio hardware con un ecosistema software che include strumenti open-source come FlashInfer, vLLM e SGLang, sviluppati con la collaborazione di oltre sette milioni di programmatori CUDA. Questi componenti ottimizzano l’inferenza e la gestione dei token in tempo reale, rendendo i modelli più reattivi e sostenibili anche su larga scala.

Impatto su OpenAI e sull’ecosistema AI

La disponibilità di cluster Blackwell su Azure segna una tappa cruciale nella strategia di consolidamento della leadership statunitense nel settore AI. OpenAI, principale beneficiario di questa infrastruttura, potrà sperimentare modelli con capacità di ragionamento e contestualizzazione avanzate, potenziando agenti digitali e sistemi multimodali di nuova generazione. Le prestazioni ottenute da Blackwell in MLPerf Inference 5.1 e InferenceMAX confermano la transizione verso un paradigma di AI scalabile e sostenibile, in cui il costo computazionale non cresce più linearmente con la complessità del modello. Con throughput superiori e costi inferiori, la tecnologia apre la strada a un’adozione più ampia dell’intelligenza artificiale anche nei settori scientifici ed enterprise.

La collaborazione tra Nvidia, Microsoft, OpenAI, Meta e DeepSeek rafforza un ecosistema aperto ma competitivo, dove la combinazione di infrastruttura cloud, GPU di nuova generazione e ottimizzazione software definisce la direzione dell’AI per il prossimo decennio.

Nuova era per le AI factory

Con la serie Blackwell, Nvidia ridefinisce il concetto di AI factory, trasformando i data center in impianti intelligenti capaci di processare milioni di token in tempo reale, con efficienza energetica e scalabilità mai viste prima. Microsoft Azure, grazie al cluster GB300 NVL72, diventa il principale fornitore di infrastrutture per AI enterprise e ricerca avanzata, offrendo un ambiente ottimizzato per modelli su scala exa-flop. Questa convergenza tra potenza computazionale e ottimizzazione software inaugura una fase in cui l’intelligenza artificiale diventa non solo più potente, ma anche economicamente sostenibile. Nvidia Blackwell, con la sua architettura integrata e la collaborazione strategica con Azure, consolida il ruolo degli Stati Uniti come polo mondiale dell’innovazione AI.