Le novità in AI e cloud mostrano due traiettorie convergentiifiziert: da un lato Nvidia accelera la progettazione dei modelli frontier attraverso l’architettura Mixture of Experts, dall’altro Google Cloud potenzia le sue infrastrutture con ottimizzazioni di rete, mitigazioni di sicurezza e automazione dei metadati per il data management. Nel primo periodo emergono i punti chiave del settore: architetture ispirate al cervello umano, fabbriche AI su scala globale, risposte immediate a vulnerabilità critiche come CVE-2025-55182, metadata generati automaticamente dal cloud, zero-day in grado di colpire Android, iOS e Chrome, con un ecosistema che punta a modelli più intelligenti, infrastrutture più resilienti e workload scientifici come la genomica conversazionale. Il panorama mostra una convergenza tra compute, sicurezza e automazione che definisce le piattaforme AI del 2026.

Mixture of Experts accelera la nuova generazione di modelli Nvidia

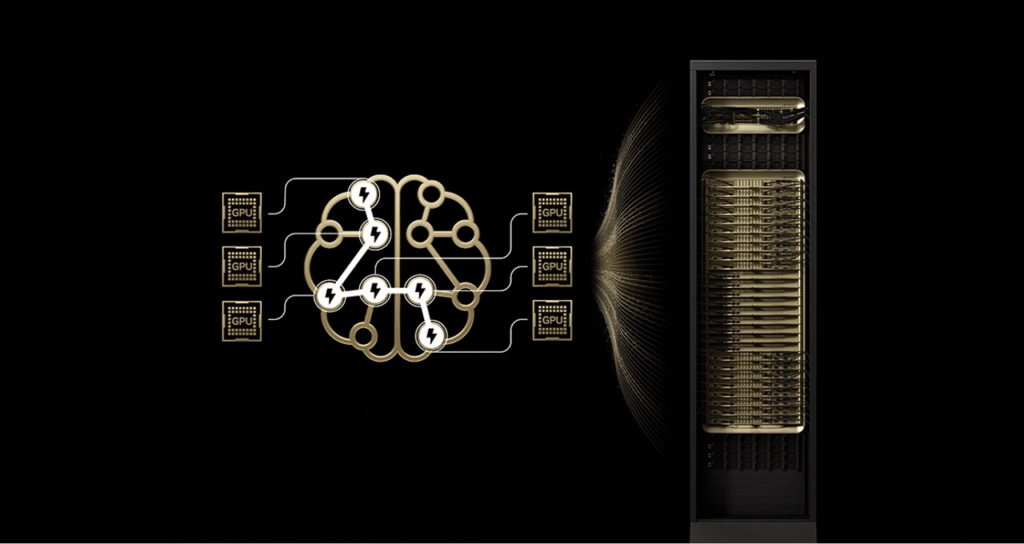

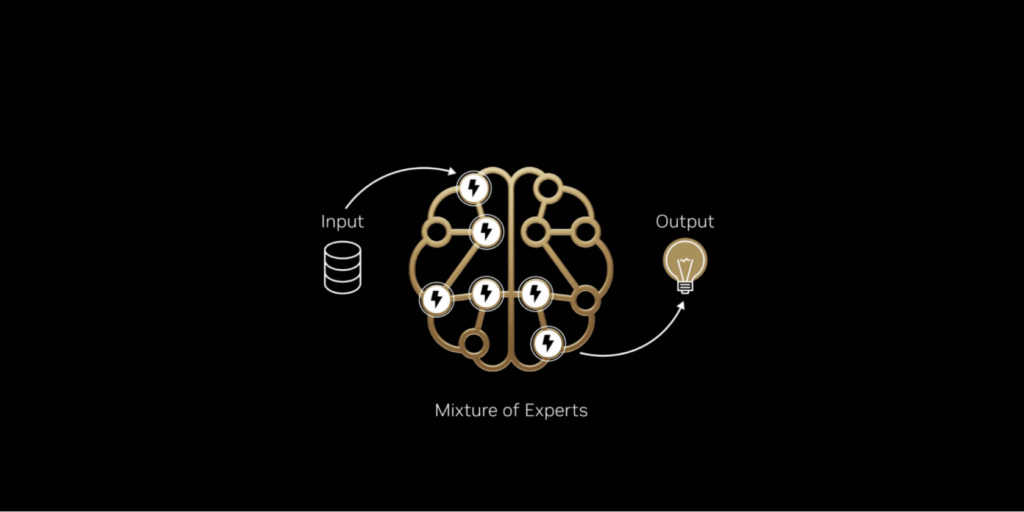

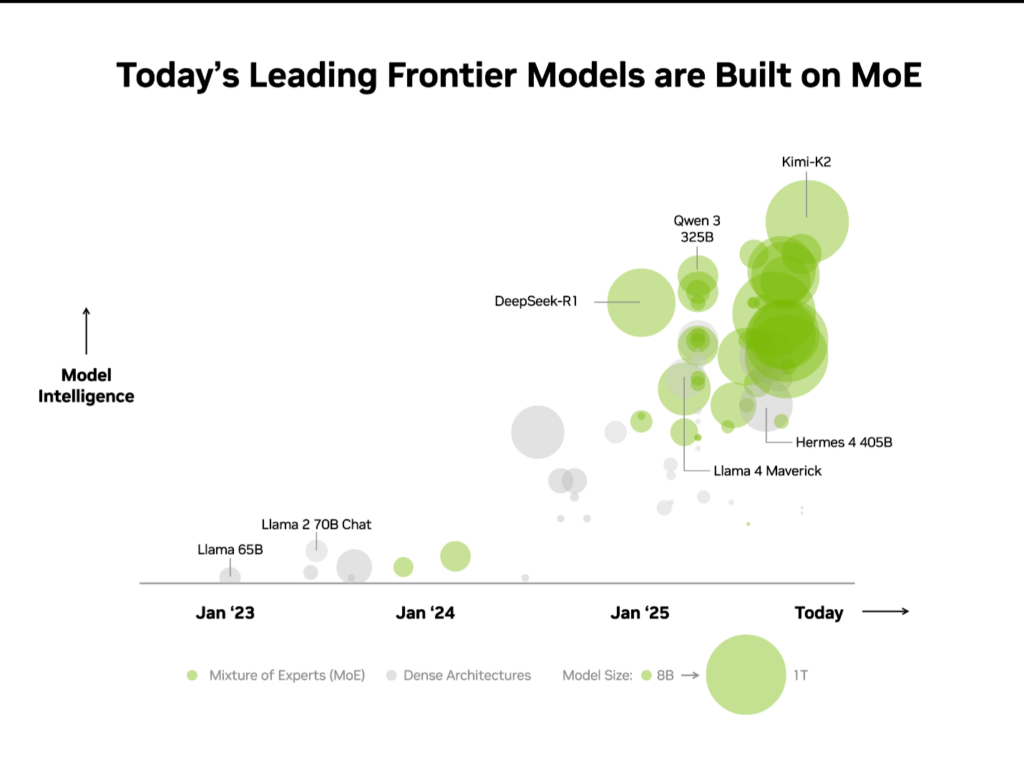

Nvidia presenta Mixture of Experts (MoE) come architettura cardine dei modelli frontier. Il sistema divide l’elaborazione tra esperti specializzati, attivati da un router neurale che instrada ogni token verso gli specialisti più competenti. Questa scelta permette a modelli con centinaia di miliardi di parametri di utilizzare effettivamente solo decine di miliardi per inferenza e training, riducendo radicalmente i costi di calcolo.

La conseguenza è una crescita modellistica settanta volte superiore a quella del 2023, favorita da efficienza energetica, scalabilità e prestazioni per watt mai viste. Oltre il 60 percento dei modelli open-source rilasciati nel 2025 adotta MoE, rendendolo il nuovo standard per AI multimodale, agentica e reasoning avanzato. Nvidia ottimizza l’architettura sui sistemi GB200 NVL72, capaci di 1,4 exaflops e 30 TB di memoria coerente via NVLink, riducendo colli di bottiglia e aprendo a finestre di contesto come 256K token.

Questa architettura emerge anche nei modelli Mistral Large 3, con 41 miliardi di parametri attivi su 675 totali, e nelle tecnologie di DeepSeek-R1, che sfruttano routing neurale avanzato per reasoning controllato. Nvidia integra compatibilità con TensorRT-LLM, SGLang, vLLM, e formati a bassa precisione come NVFP4, che abbassano il costo per token senza degradare la qualità generativa. Il risultato è un salto di intelligenza distribuita: modelli più rapidi, più intelligenti, meno costosi, capaci di lavorare su cloud, edge, robotica e agenti software coordinati.

Partnership Nvidia-AWS e fabbriche AI globali

Nvidia estende la partnership con AWS per costruire vere e proprie fabbriche AI, strutture cloud in grado di addestrare e distribuire modelli generativi su scala industriale. La piattaforma integra GPU Blackwell, rete Spectrum-X, architettura rack MGX, silicio custom AWS con Trainium4 e sistemi Nitro, formando un insieme di componenti ottimizzati per throughput, latenza e sicurezza sovrana dei dati.

Le aziende sviluppano modelli personalizzati usando gli Nvidia Nemotron integrati in Amazon Bedrock, abilitando applicazioni enterprise multimodali. Realtà come CrowdStrike e BridgeWise adottano Nemotron per agenti specializzati in detection, analisi finanziaria e automazione decisionale. La partnership espande anche i workload serverless avanzati: Amazon OpenSearch Service usa accelerazione cuVS per indicizzazione vettoriale dieci volte più veloce, riducendo costi operativi. I modelli Cosmos vengono distribuiti come microservizi NIM su Amazon EKS, offrendo un ecosistema modulare per inferenza, robotica, simulazione e elaborazioni fisiche. L’obiettivo è creare pipeline AI production-ready, integrate dall’hardware al software, con governance e controllo dei dati rispettati in settori regolamentati come finanza, salute, difesa e industria.

Collaborazione Nvidia-Mistral: open-source potenziato su GPU frontier

Nvidia collabora anche con Mistral AI, accelerando la suite Mistral 3 per cloud ed edge. I modelli integrano Mixture of Experts, contesti estesi, capacità multimodali e ottimizzazioni granulari basate su NVLink. L’efficienza energetica cresce del dieci volte rispetto ai sistemi H200, rendendo i modelli open-source competitivi con i frontier proprietari. Suite come Ministral 3 potenziano dispositivi edge tramite Ollama, Jetson e laptop RTX, espandendo l’accessibilità dell’AI di alto livello.

La collaborazione, strutturata attorno al framework TensorRT-LLM e agli strumenti NeMo per personalizzazione, porta un open-source più performante, più scalabile, più adatto all’impresa e meno dipendente da infrastrutture costose.

Reti flat in Google Kubernetes Engine e modernizzazione del cloud

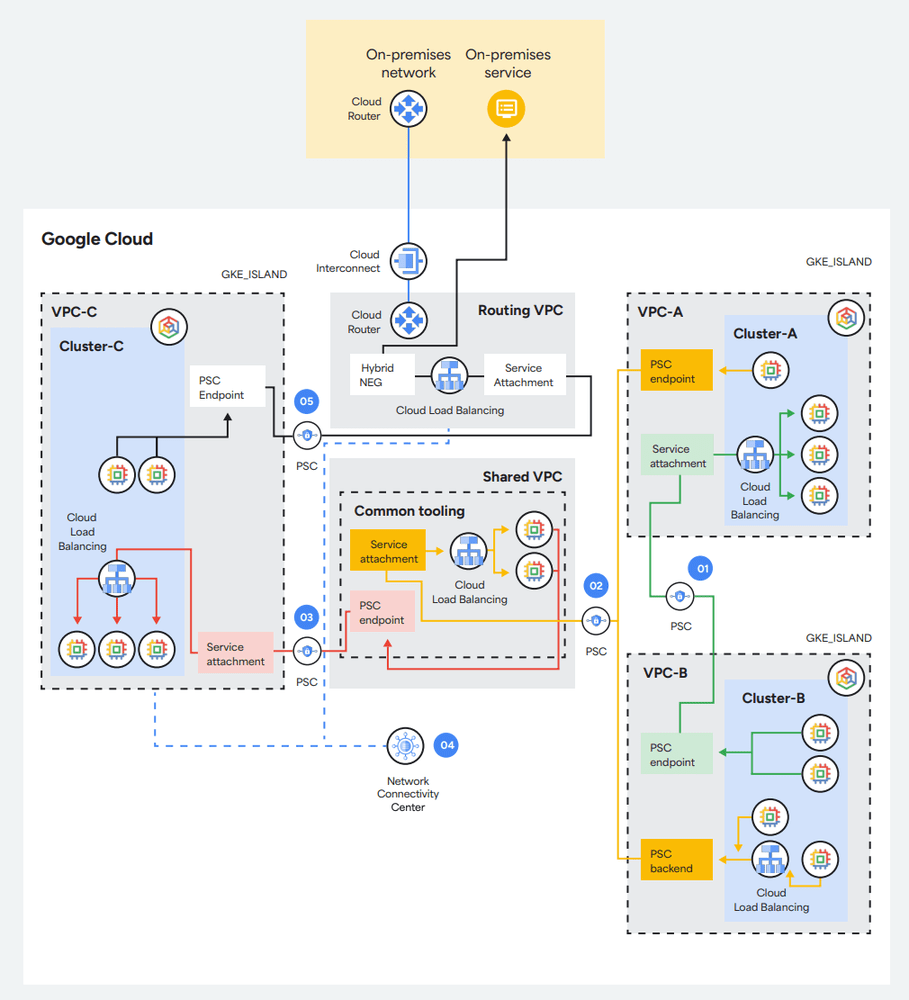

Google introduce una profonda revisione delle reti flat in GKE, progettate per fornire scalabilità nativa e performance costanti nei workload AI, generativi e agentici. La rete flat permette maggiore continuità operativa rispetto alla modalità “isola”, pur potendo emularne i comportamenti tramite VPC, Private Service Connect e Network Connectivity Center.

Questa architettura utilizza masquerading IP per instradare traffico Pod-to-world, consentendo alle organizzazioni di migrare da ambienti ibridi complessi a GKE senza sacrificare segmentazione o modelli di sicurezza esistenti. La guida Google fornisce blueprint architetturali per costruire cluster multi-tenant, servizi distribuiti e piattaforme di AI agentica.

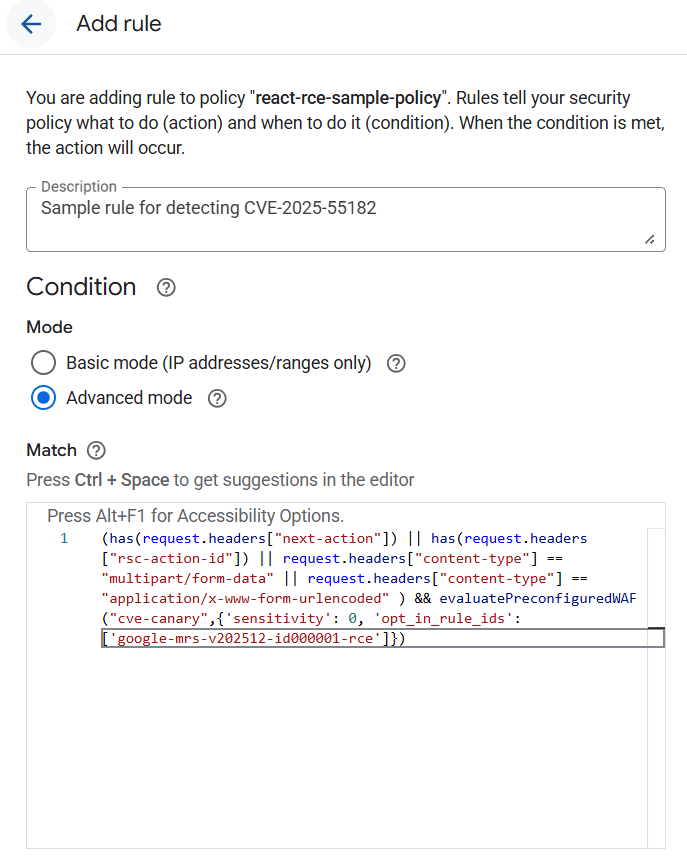

La risposta di Google al CVE-2025-55182

Google risponde immediatamente alla vulnerabilità CVE-2025-55182, una falla critica da CVSS 10.0 nei React Server Components, che abilita esecuzione remota di codice su React 19.x e Next.js 15-16. La compagnia rilascia la regola WAF Cloud Armor, progettata per bloccare tentativi di exploitation su Cloud Run, GKE, App Engine, Compute Engine, Firebase Hosting e soluzioni App Hosting.

La mitigazione intercetta header sospetti come next-action e rsc-action-id, agisce sui payload multipart e disabilita pattern tipici dei request chain malevoli. Le patch permanenti richiedono aggiornamenti a React 19.2.1 o Next.js last stable. Project Shield applica automaticamente le protezioni ai media e alle ONG vulnerabili.

Metadata automatica nel Google Data Cloud

Google Cloud introduce un sistema avanzato di metadata automatica, generata tramite Gemini, che analizza schemi, profili di colonna, distribuzioni, relazioni e pattern semantici. Il motore crea descrizioni leggibili, in lingua naturale, utili per governance, quality checking, discovery e query avanzate. L’integrazione con Dataplex Universal Catalog fornisce un livello unificato di gestione dei metadati, migliorando anche la risposta degli AI agentici e riducendo errori dovuti a conoscenza strutturale incompleta. Questo approccio aumenta la fiducia nei flussi di analytics ed elimina ore di documentazione manuale.

Genomica conversazionale su Google Cloud

Google sfrutta GKE, BigQuery, Gemini e l’Agent Development Kit per creare sistemi di genomica conversazionale capaci di rispondere in linguaggio naturale a query cliniche complesse. Il workflow unisce annotazione VEP, interrogazioni gnomAD, classificazioni ClinVar, caching persistente e orchestrazione multi-agent, riducendo tempi di analisi da ore a minuti. La piattaforma abilita interpretazioni genetiche ad alta velocità, analisi di varianti patogene, pattern demografici e insight clinici.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.