Ricercatori europei identificano sette fault line epistemologiche che separano il giudizio umano dal funzionamento dei large language models (LLM), introducendo il concetto di Epistemia per descrivere una condizione emergente in cui la plausibilità linguistica prende il posto della valutazione epistemica. L’analisi, firmata da Walter Quattrociocchi, Valerio Capraro e Matjaž Perc, ricostruisce il passaggio storico dall’AI simbolica ai trasformatori generativi e sostiene che gli LLM non siano agenti epistemici, ma sistemi di completamento stocastico di pattern. Nel primo periodo si concentrano i punti chiave dell’intero impianto teorico: gli LLM generano testo come traiettorie probabilistiche su grafi multidimensionali, non come esiti di credenze sul mondo; l’allineamento comportamentale maschera mismatch strutturali; l’Epistemia produce sensazione di conoscenza senza il lavoro del giudizio. Le implicazioni riguardano valutazione, governance e literacy epistemica nelle società che adottano l’AI generativa come infrastruttura cognitiva.

Dall’AI simbolica ai trasformatori generativi: una transizione epistemica

La genealogia proposta parte dalle mitologie degli automi e attraversa la stagione dei motori logici di Ramon Llull e Leibniz, fino all’Illuminismo meccanicista. Nel Novecento, la convergenza tra logica matematica, computazione ed elettronica culmina nell’“imitation game” di Alan Turing, che sposta l’attenzione dalla definizione astratta di pensiero al comportamento osservabile. L’AI simbolica interpreta l’intelligenza come manipolazione di simboli con regole esplicite, mentre le prime reti neurali introducono un apprendimento data-driven limitato dalla scala.

Il cambio di fase arriva con l’NLP statistico e, soprattutto, con i LLM generativi. Qui avviene la transizione epistemica decisiva: dalle tecnologie che filtrano informazioni (search, recommendation) lasciando il giudizio all’utente, a sistemi che generano risposte sintetiche. Questo collasso di ricerca, selezione e spiegazione in un’unica superficie testuale produce output autorevoli che ridimensionano il ruolo del giudizio umano, creando le condizioni dell’Epistemia.

Trasformatori, scala e automatizzazione del linguaggio

I trasformatori apprendono una funzione parametrizzata che mappa sequenze di simboli in distribuzioni di probabilità sul token successivo. I layer di self-attention integrano dipendenze long-range, mentre corpora massivi e scaling laws generano fluidità e versatilità. Ma la tesi centrale è netta: si automatizza il linguaggio, non la cognizione. Gli LLM operano su regolarità statistiche del testo umano, non su rappresentazioni del mondo; non tracciano condizioni di verità né strutture causali.

La scala raffina l’approssimazione della funzione, aumentando coverage e interpolazione, senza introdurre struttura epistemica. Meccanismi compensativi come retrieval-augmented generation o tool use ancorano l’output a fonti esterne, ma non trasformano il sistema in un agente epistemico: rendono le risposte convincenti, non sapienti. Il rischio cresce quando la generazione sostituisce l’informazione tradizionale.

La generazione del testo come cammino stocastico su un grafo

La produzione testuale può essere descritta come un processo stocastico su uno spazio di stati discreto: il vocabolario è un grafo diretto pesato; il contesto induce una distribuzione condizionale; il sampling definisce una traiettoria. Strategie di decodifica (greedy, temperature, top-k, nucleus) modulano l’entropia locale senza introdurre invarianti di verità.

Le distribuzioni linguistiche sono heavy-tailed e anisotrope: la massa probabilistica si concentra in regioni dense che riflettono frame frequenti. Questa attrazione statistica viene spesso scambiata per stabilità concettuale, ma non lo è. Persistenza non è credenza, ricorrenza non è memoria, concentrazione non è comprensione. Le allucinazioni non sono anomalie: sono esiti attesi quando manca un macchinario per riferimento ed evidenza. La scala migliora la coerenza interna, non l’accesso epistemico.

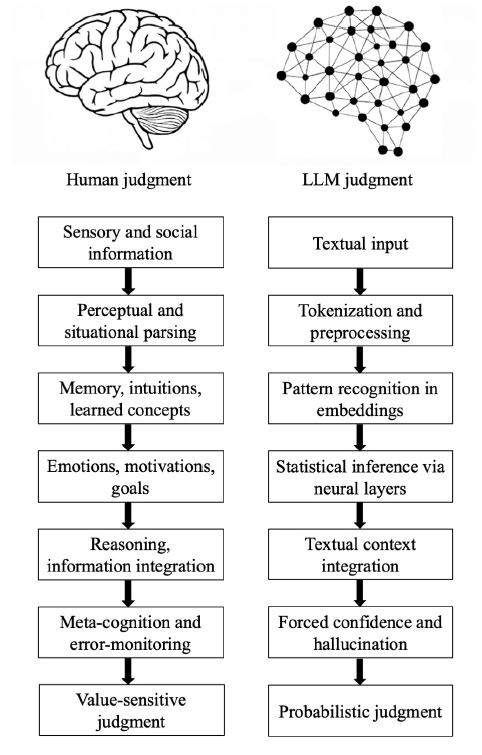

Pipeline epistemiche a confronto

Gli autori mappano due pipeline apparentemente parallele. Quella umana procede attraverso informazione sensoriale e sociale, parsing situazionale, memoria ed esperienza, motivazione ed emozioni, ragionamento, metacognizione, giudizio value-sensitive. È lenta, fallibile e biasata, ma vincolata dal mondo e da feedback istituzionali.

La pipeline LLM sostituisce questi stadi con prompt testuali, tokenizzazione, similarità in embedding, inferenza statistica, integrazione del contesto, confidenza forzata, predizione probabilistica. L’output può sembrare simile, ma le strutture interne divergono. Qui emergono le sette fault line epistemologiche.

Grounding e parsing: il distacco dall’esperienza

La prima fault line riguarda il grounding. Gli umani iniziano dal mondo multimodale; gli LLM dal testo. Il significato è ricostruito indirettamente da simboli. Senza segnali percettivi e sociali, sarcasmo e minaccia diventano ambigui. La seconda fault line è il parsing: l’umano struttura l’esperienza identificando agenti e intenzioni; l’LLM segmenta simboli per efficienza, cieco alla pragmatica. Ne derivano distorsioni semantiche non banali.

Esperienza e motivazione: pattern contro vissuto

La terza fault line è l’esperienza. La memoria umana è episodica e incarnata; gli LLM codificano similarità statistiche. Trattano l’impossibile plausibile come valido se frequente nei dati. La quarta fault line è la motivazione. Emozioni, goals e valori orientano il giudizio umano; gli LLM minimizzano errore predittivo senza preferenze intrinseche. Tecniche di allineamento possono introdurre bias paradossali, rivelando la fragilità dell’ottimizzazione senza valori.

Causalità e metacognizione: correlazioni e confidenza simulata

La quinta fault line è la causalità. Gli umani ragionano con controfattuali; gli LLM integrano correlazioni, vulnerabili a associazioni spurie e a cali di performance fuori distribuzione. La sesta fault line è la metacognizione. Gli umani sospendono il giudizio e calibrano l’incertezza; gli LLM devono rispondere, producendo confidenza simulata. Le allucinazioni diventano inevitabili.

Valore ed Epistemia: quando la plausibilità sostituisce la giustificazione

La settima fault line riguarda il valore. Il giudizio umano è situato, sensibile alle conseguenze; l’LLM fornisce predizioni probabilistiche senza stakes. Qui nasce l’Epistemia: un regime in cui la plausibilità linguistica surroga la giustificazione, creando sensazione di conoscenza anche quando il contenuto è corretto. Non è un bias occasionale, ma un fenomeno architetturale dei sistemi generativi inseriti in workflow epistemici privi di verifica.

Implicazioni per valutazione, governance e literacy

Gli autori propongono di spostare la valutazione oltre l’allineamento superficiale, con probe sensibili a gestione dell’incertezza, robustezza a shift, sensibilità controfattuale e appropriatezza dell’astensione. La governance deve distinguere domini assistivi da decisionali, richiedere trasparenza epistemica su ciò che i sistemi non fanno e trattare i mitigatori come parziali. La literacy deve diventare epistemica, insegnando le pipeline, le salvaguardie procedurali e la responsabilità istituzionale per evitare l’outsourcing del giudizio.

La tesi è netta: gli LLM producono output indistinguibili da giudizi umani attraverso un meccanismo generativo non giudicante. L’allineamento comportamentale è compatibile con un mismatch strutturale. Chiarire le sette fault line e l’Epistemia non serve a rifiutare l’AI generativa, ma a ridisegnare benchmark, policy e pratiche per preservare la responsabilità epistemica nelle infrastrutture cognitive ibride.

Domande frequenti su Umani vs LLM

Che cos’è l’Epistemia nel contesto dell’AI?

L’Epistemia è un concetto introdotto per descrivere una condizione in cui la plausibilità e la fluidità linguistica di un testo generato dall’AI vengono scambiate per accuratezza e verità. È l’illusione di conoscenza creata da sistemi che producono testo grammaticalmente corretto senza avere una reale comprensione o giudizio epistemico.

Quali sono le principali differenze tra il pensiero umano e gli LLM?

Le differenze principali, o “linee di faglia”, includono il grounding (gli umani hanno esperienza del mondo, gli LLM solo del testo), la motivazione (gli umani hanno scopi e valori, gli LLM minimizzano errori statistici), la causalità (gli umani ragionano su cause-effetti, gli LLM su correlazioni) e la metacognizione (gli umani sanno di non sapere, gli LLM tendono a confabulare).

Perché gli LLM soffrono di allucinazioni?

Le allucinazioni non sono errori del sistema, ma una conseguenza del suo funzionamento. Gli LLM sono motori di completamento probabilistico: quando mancano informazioni specifiche, il modello “riempie i buchi” scegliendo le parole statisticamente più probabili per mantenere la coerenza del testo, senza avere un meccanismo interno per verificare la verità fattuale.

Come possiamo usare gli LLM in modo sicuro nonostante questi limiti?

È fondamentale mantenere un approccio “human-in-the-loop”, verificando sempre le informazioni critiche. Inoltre, bisogna sviluppare una “literacy epistemica” per capire che l’AI genera pattern linguistici, non fatti, e usare tecniche come la RAG (Retrieval-Augmented Generation) per ancorare le risposte a fonti esterne affidabili.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.