Nvidia compie la mossa più rilevante della sua storia recente rafforzando la leadership nell’intelligenza artificiale con un accordo da 18 miliardi di euro per la licenza della proprietà intellettuale di Groq. Nel primo periodo emergono tutti i nodi centrali: l’accesso alle Language Processing Units a bassa latenza per l’inference real-time, l’ingresso in Nvidia di figure chiave come Jonathan Ross, il mantenimento dell’indipendenza operativa di Groq per evitare attriti antitrust, l’integrazione dell’IP nell’architettura AI factory di Nvidia, e un contesto geopolitico in cui i controlli USA sull’export di chip AI mostrano falle strutturali. In parallelo, Nvidia estende il proprio raggio d’azione oltre il data center sostenendo una ricerca avanzata sui meccanismi molecolari della memoria umana, che combina GPU RTX, visualizzazione VR e dataset tridimensionali su scala terabyte.

Il deal Groq: licenza IP, acquihire e strategia antitrust

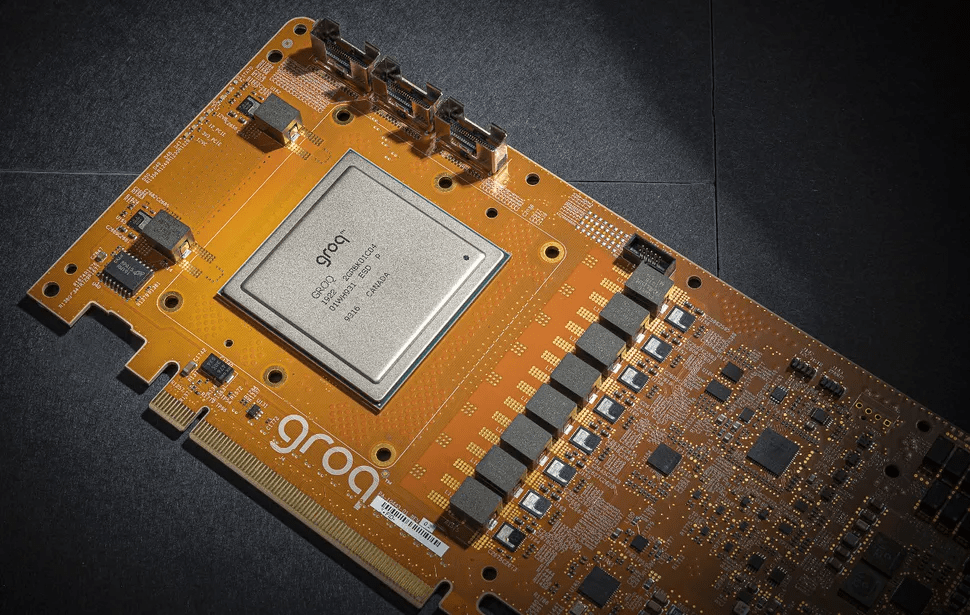

L’accordo con Groq non è un’acquisizione classica. Nvidia ottiene una licenza non esclusiva sugli asset intellettuali di Groq, inclusa la tecnologia delle LPU progettate per inference a bassissima latenza, e assorbe parte del capitale umano attraverso una formula di acquihire. Jonathan Ross entra in Nvidia insieme ad altri dirigenti, mentre Groq resta una società indipendente, guidata dal nuovo CEO Simon Edwards. Questa architettura consente a Nvidia di ampliare il proprio stack senza integrare l’intera azienda, riducendo il rischio di interventi regolatori.

Per Nvidia, il valore non è solo tecnologico ma temporale. Le LPU di Groq utilizzano SRAM on-board misurata in megabyte anziché HBM in gigabyte, una scelta che sacrifica capacità ma ottimizza determinismo e throughput per specifici carichi LLM in tempo reale. L’integrazione promette di colmare un vuoto nell’offerta Nvidia, tradizionalmente fortissima nel training e sempre più orientata a coprire l’intero ciclo di vita dell’AI, dall’addestramento all’inference in produzione.

Un’operazione record nel M&A AI

Con 18 miliardi di euro, il deal supera la storica acquisizione di Mellanox del 2019 e diventa il più grande nella traiettoria M&A di Nvidia. La cifra va letta alla luce del posizionamento di Groq, valutata 6,3 miliardi di euro nel 2025 e con 458 milioni di euro di ricavi fiscali, ma soprattutto del valore strategico dell’IP e del talento. La mossa segue altre operazioni mirate, come il reclutamento di team specializzati da Enfabrica, e consolida una strategia di assorbimento selettivo che evita integrazioni complesse.

Dal punto di vista competitivo, l’accordo risolve tensioni pregresse. Groq aveva accusato Nvidia di pratiche predatorie e di pressioni sui clienti; la licenza IP trasforma un potenziale antagonista in un partner tecnologico, mantenendo Groq come challenger nell’inference ma allineato all’ecosistema Nvidia.

AI factory, inference real-time e vantaggio software

Nvidia presenta l’operazione come un’estensione della propria AI factory, un’architettura che combina GPU, networking, software e ora anche processori low-latency per carichi real-time. L’obiettivo è coprire workload dove la latenza è critica, come agenti conversazionali, sistemi industriali e applicazioni edge ad alte prestazioni. Il vantaggio competitivo resta nel software, con compatibilità e toolchain che riducono i costi di adozione per clienti già vincolati all’ecosistema CUDA.

Groq continua a operare GroqCloud e a costruire infrastrutture, incluso un data center europeo a Helsinki, ma beneficia di liquidità e accesso privilegiato a un mercato dominato da Nvidia. L’equilibrio è delicato: Nvidia amplia l’offerta senza cannibalizzare completamente un’alternativa hardware che può restare appetibile per nicchie specifiche.

RTX, VR e la ricerca sulla memoria umana

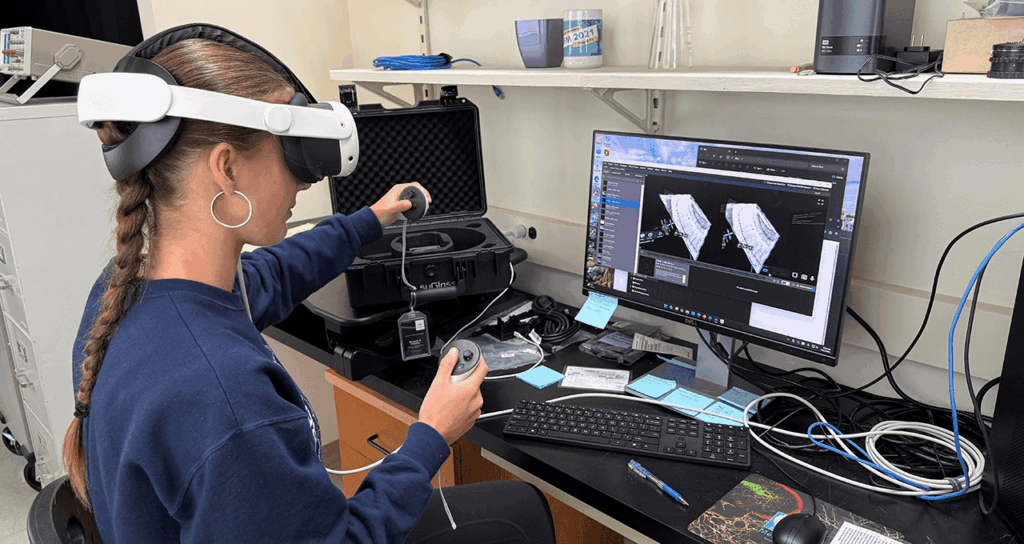

In parallelo al deal industriale, Nvidia rafforza il posizionamento scientifico sostenendo il Marine Biological Laboratory di Woods Hole in Massachusetts. Il progetto, guidato dal neuroscienziato Andre Fenton con la collaborazione di Abhishek Kumar, indaga i meccanismi molecolari della memoria nell’ippocampo umano. I ricercatori utilizzano workstation HP con GPU RTX Nvidia per analizzare 10 terabyte di immagini 3D ad alta risoluzione, visualizzate in realtà virtuale tramite la piattaforma syGlass.

La ricerca cerca marcatori proteici microscopici, strutture dell’ordine del micrometro che rappresentano circa l’1% delle proteine ippocampali, correlando posizione e funzione nella codifica della memoria a lungo termine. L’approccio computazionale supera colli di bottiglia storici nella gestione dei dati volumetrici e apre prospettive concrete nello studio di patologie come l’Alzheimer e altri disturbi neuropsichiatrici, dove la memoria è un fattore centrale.

Formazione, VR e trasferimento tecnologico

Un elemento distintivo del progetto MBL è l’uso della VR anche in ambito educativo. Studenti e tirocinanti esplorano dataset neurali immersivi, contribuendo all’etichettatura e all’analisi mentre apprendono concetti avanzati di neuroscienze. Questo modello di trasferimento tecnologico rafforza l’immagine di Nvidia come fornitore non solo di hardware per il profitto, ma di piattaforme abilitanti per la ricerca e la formazione scientifica.

Controlli export USA e il caso Megaspeed

Sul fronte geopolitico, un cliente Nvidia nel Sud-Est asiatico mette in luce i limiti dei controlli USA sull’export di chip AI. La società Megaspeed, con sede a Singapore e legami con la Cina, è sotto indagine per possibili diversioni di GPU verso mercati soggetti a restrizioni. Le autorità statunitensi e singaporiane analizzano discrepanze tra importazioni per miliardi di euro e capacità dichiarate dei data center.

Il caso evidenzia una debolezza strutturale: i controlli si basano su dichiarazioni di uso finale e su intermediari della filiera, rendendo complesso il tracciamento una volta che l’hardware è integrato in server o spedito attraverso più giurisdizioni. Nvidia afferma di non avere evidenze di violazioni e sottolinea l’uso di varianti conformi come H20 per mercati regolati, ma l’episodio conferma la difficoltà di far rispettare restrizioni in una supply chain globale e altamente frammentata.

Tra compliance e domanda globale

Le restrizioni su A100 e H100 prima, e l’introduzione di versioni limitate come A800, H800 e H20, hanno rallentato l’accesso cinese all’hardware di punta, ma non hanno eliminato la domanda. Schemi di smuggling e mercati ombra emergono, alimentati da premi elevati sulle GPU ristrette. Allo stesso tempo, la Cina accelera lo sviluppo di alternative domestiche, come Ascend di Huawei, che migliorano sul piano hardware ma restano indietro nel software.

Per Nvidia, la sfida è bilanciare compliance normativa e domanda globale, in un contesto dove gran parte del mercato AI si trova fuori dagli Stati Uniti e dai loro alleati. Il caso Megaspeed mostra che le politiche di controllo, se parziali, producono accessi parziali e incentivi alla frammentazione della supply chain.

Una mossa che ridefinisce l’ecosistema AI

Il licensing dell’IP Groq da 18 miliardi di euro segna un punto di svolta nel M&A AI del 2025. Nvidia rafforza l’offerta per l’inference real-time, assorbe talento critico e amplia l’AI factory senza acquisizioni totali. In parallelo, l’azienda dimostra come GPU e RTX possano abilitare progressi scientifici fuori dal data center, mentre le tensioni geopolitiche ricordano che il dominio tecnologico si gioca anche su regole, controlli e fiducia nella filiera.

Domande Frequenti su Nvidia, Groq e Export Chip

Cosa prevede l’accordo tra Nvidia e Groq?

Nvidia ha investito 18 miliardi di euro per licenziare la proprietà intellettuale (IP) di Groq e assumere parte del suo team chiave, incluso il fondatore Jonathan Ross. Groq rimarrà un’azienda indipendente, ma Nvidia integrerà la sua tecnologia LPU (Language Processing Unit) per migliorare l’inferenza AI a bassa latenza nei propri sistemi.

Perché i chip Groq sono importanti per Nvidia?

I chip LPU di Groq utilizzano memoria SRAM integrata invece della HBM esterna, garantendo una velocità di elaborazione (latenza) estremamente bassa per i modelli linguistici (LLM). Questa tecnologia è fondamentale per le applicazioni AI in tempo reale, un settore in cui Nvidia vuole rafforzare la propria offerta rispetto al solo training dei modelli.

In che modo Nvidia supporta la ricerca sulla memoria umana?

Nvidia fornisce GPU RTX e workstation HP al Marine Biological Laboratory per gestire enormi dataset da 10 terabyte. I ricercatori usano la realtà virtuale (VR) e l’AI per visualizzare in 3D le proteine dell’ippocampo, cercando di capire i meccanismi molecolari della memoria per combattere malattie come l’Alzheimer.

Qual è il problema con l’export dei chip Nvidia in Cina?

Nonostante le restrizioni USA, ci sono sospetti che aziende come Megaspeed a Singapore agiscano da intermediari per inviare chip AI avanzati in Cina. Le autorità stanno indagando su discrepanze tra l’hardware importato e la reale capacità dei data center locali, evidenziando le difficoltà nel controllare la diffusione della tecnologia AI globale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.