ChatGPT Jobs entra in fase di test come nuova funzione di OpenAI, mentre Google Cloud accelera sull’asse osservabilità, networking e DevOps con VPC Flow Logs, framework DORA, BigQuery MCP Server e dashboard di Gemini CLI. La convergenza tra strumenti AI orientati alle carriere e infrastrutture cloud misurabili cambia il modo in cui professionisti e imprese prendono decisioni operative, riducendo l’incertezza sia nel mercato del lavoro sia nella gestione di sistemi complessi. Il lettore ottiene una mappa chiara di cosa cambia, come funzionano i nuovi strumenti e quali controlli attivare subito per sfruttarli in modo concreto.

ChatGPT Jobs: come funziona la nuova area carriere

ChatGPT Jobs è una funzione sperimentale che amplia l’ambizione di ChatGPT oltre la conversazione generalista, introducendo uno spazio dedicato alle carriere. L’obiettivo è supportare esplorazione dei ruoli professionali, miglioramento del curriculum e pianificazione delle traiettorie lavorative. L’interfaccia, strutturata come dashboard interattiva, organizza le richieste legate al lavoro in un contesto separato, riducendo ambiguità, rumore informativo e dispersione.

Dal punto di vista operativo, la funzione guida l’utente nell’analisi delle competenze, suggerisce ruoli compatibili con il profilo e propone strategie per emergere nei processi di selezione, mantenendo una distinzione netta tra dati dell’utente e training dei modelli. Questo aspetto è centrale perché trasforma ChatGPT da strumento reattivo a supporto decisionale continuo.

L’elemento più rilevante non è la semplice riscrittura del CV, ma la comparazione strutturata delle opportunità. ChatGPT Jobs consente di confrontare posizioni, requisiti, skill richieste e percorsi di crescita, restituendo una vista sintetica ma operativa. La scelta di isolare la funzione in un’area dedicata risponde anche a esigenze di privacy, compliance e protezione dei dati professionali sensibili.

Sul piano strategico, l’impatto potenziale è elevato perché l’AI entra nella fase di posizionamento personale. Non si limita a suggerire, ma aiuta a comprendere come presentarsi rispetto a ruoli e contesti specifici, avvicinandosi alle funzionalità AI delle piattaforme di recruiting, con un vantaggio dato dall’integrazione nativa nell’ecosistema ChatGPT.

VPC Flow Logs e migrazioni di rete senza sorprese

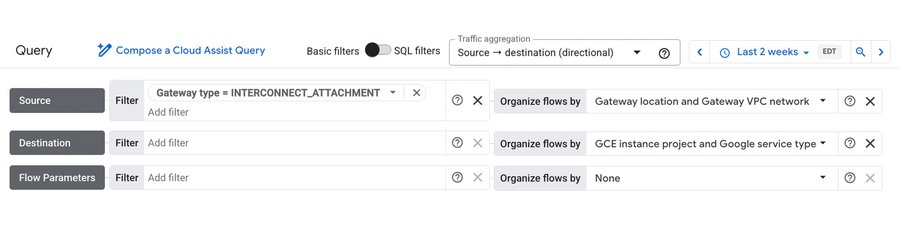

Sul fronte infrastrutturale, Google Cloud rafforza l’osservabilità di rete con VPC Flow Logs, strumento chiave per ridurre il rischio nelle migrazioni ibride e nei cutover complessi. I log catturano metadati dettagliati su traffico IP, porte e protocolli, consentendo di capire chi parla con chi all’interno di VPC, subnet, GKE e collegamenti come Cloud Interconnect.

La granularità dei dati abilita analisi quasi in tempo reale e riduce drasticamente il tempo di individuazione delle anomalie. Un caso emblematico è quello di Hackensack Meridian Health, che ha utilizzato VPC Flow Logs per monitorare traffico su VLAN attachments durante una migrazione critica. L’analisi dei flussi ha permesso di individuare pattern anomali in pochi minuti, trasformando attività che richiedevano ore in interventi rapidi e mirati.

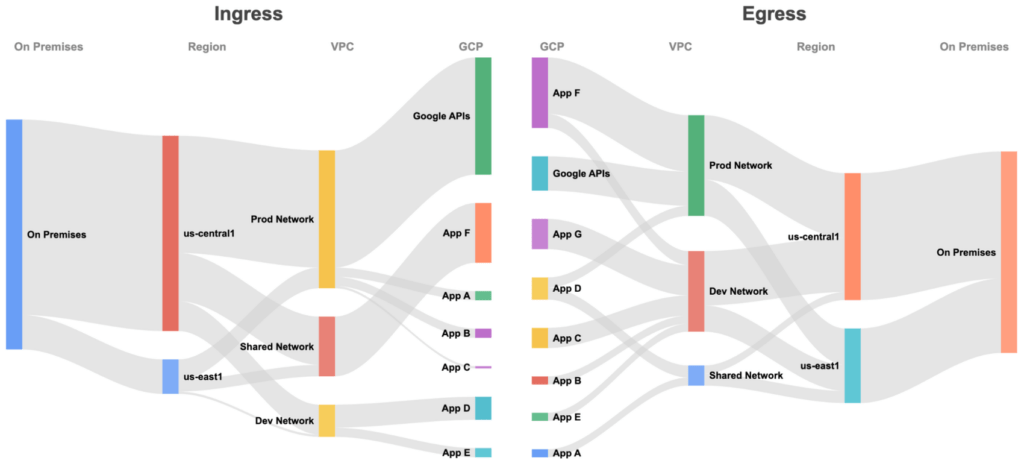

L’integrazione con Cloud Logging e BigQuery consente di archiviare grandi volumi di dati e costruire dashboard avanzate con Looker, incluse visualizzazioni come Sankey diagram per rappresentare i flussi tra data center e applicazioni. Dal punto di vista enterprise, il valore è duplice: capacity planning più accurato e compliance rafforzata grazie a una telemetria che documenta i percorsi del traffico.

DORA e DevOps: il caso FINRA come modello misurabile

Nel contesto della finanza regolata, FINRA ha adottato il framework DORA in collaborazione con consulenti Google per misurare e migliorare le performance DevOps. DORA si basa su indicatori chiave come deployment frequency, change lead time, change failure rate e recovery time, spostando il focus da metriche puramente operative a indicatori di valore reale.

L’implementazione non è stata rigida, ma adattata ai team, bilanciando velocità e stabilità. Il risultato è stato un incremento del 9% della produttività per sviluppatore in un anno, accompagnato da migliore developer experience e sprint più prevedibili. L’aspetto cruciale è la trasparenza: le metriche diventano strumenti di apprendimento continuo, non meccanismi punitivi.

Questo dimostra che DevOps può funzionare anche in ambienti altamente regolati, se supportato da metriche condivise e da una cultura generativa. La correlazione tra metriche di prodotto e indicatori di delivery consente decisioni informate, riducendo rework, errori ricorrenti e fallimenti di rilascio.

BigQuery MCP Server e agenti AI sui dati enterprise

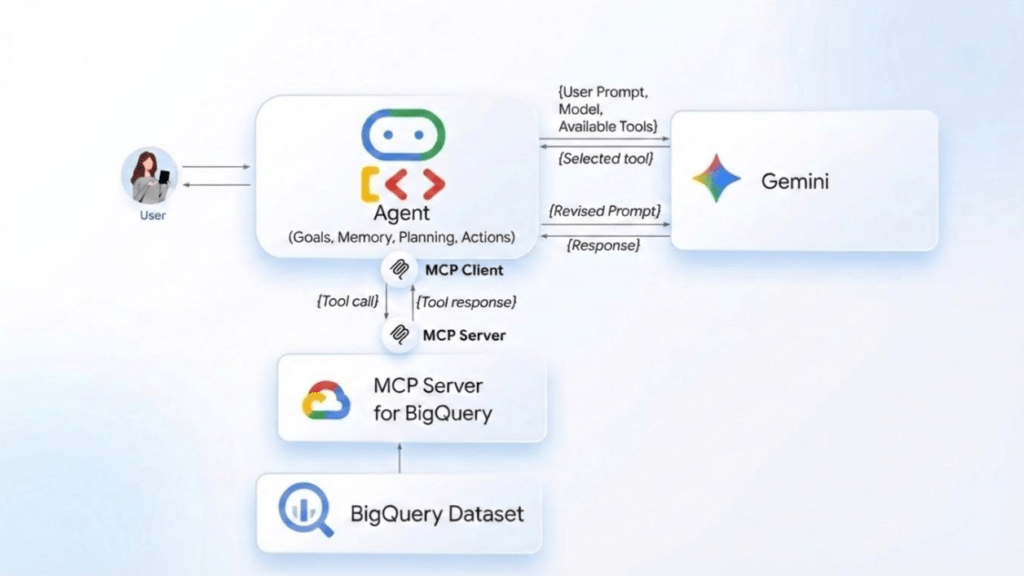

Con il Remote BigQuery MCP Server, Google Cloud introduce un servizio gestito che consente agli agenti AI di interrogare dataset BigQuery tramite protocollo MCP su HTTP sicuro. Il vantaggio chiave è l’eliminazione delle integrazioni custom, con una riduzione significativa del carico operativo sulla gestione dei server.

Gli sviluppatori possono costruire agenti tramite Agent Development Kit e integrarli con Gemini CLI, mantenendo il controllo degli accessi tramite OAuth e ruoli BigQuery. Dal punto di vista architetturale, il server funge da ponte standardizzato tra modelli generativi e dati enterprise, rendendo l’ecosistema più modulare, auditabile e sicuro.

Dataset di esempio dimostrano come sia possibile porre query in linguaggio naturale per estrarre trend, ordini principali e pattern temporali. Per le aziende, il beneficio è l’accelerazione dello sviluppo di applicazioni AI data-driven senza compromettere sicurezza, controllo degli accessi e tracciabilità delle richieste.

Dashboard Gemini CLI e osservabilità immediata

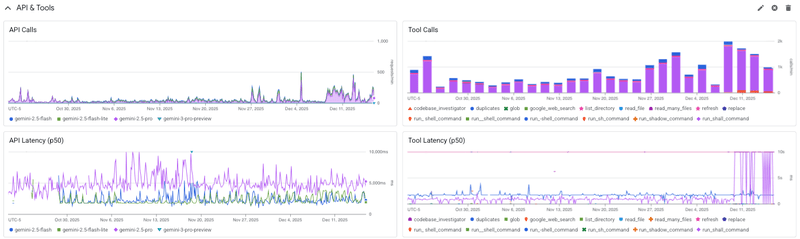

Gemini CLI si arricchisce di dashboard preconfigurati in Google Cloud Monitoring, offrendo visibilità immediata su utenti attivi, installazioni, consumo di token e linee di codice. L’integrazione con OpenTelemetry consente l’esportazione dei log verso diversi backend, riducendo il vendor lock-in e facilitando l’adozione in ambienti multi-cloud.

Le dashboard abbassano la barriera di ingresso all’osservabilità perché eliminano la necessità di query iniziali complesse. I team possono monitorare adozione, affidabilità e pattern di utilizzo, migliorando pianificazione delle risorse e priorità di sviluppo. La possibilità di personalizzare i template rende lo strumento adatto a team enterprise di grandi dimensioni.

Domande frequenti su ChatGPT Jobs

Cos’è ChatGPT Jobs e a cosa serve?

ChatGPT Jobs è una funzione sperimentale integrata in ChatGPT che supporta l’utente nell’esplorazione delle carriere, nell’analisi delle competenze e nel miglioramento del curriculum. Funziona come dashboard dedicata, separando le richieste professionali dal resto delle conversazioni e offrendo confronti strutturati tra ruoli e opportunità.

ChatGPT Jobs usa i dati dell’utente per addestrare i modelli?

No. I dati dell’utente non vengono utilizzati per il training dei modelli. La funzione è progettata per mantenere le informazioni professionali in spazi dedicati, riducendo i rischi di esposizione e rispettando privacy e compliance.

Perché VPC Flow Logs sono cruciali nelle migrazioni cloud?

VPC Flow Logs consentono di analizzare in dettaglio il traffico di rete tra risorse cloud e ambienti on-premise. Forniscono visibilità su IP, porte e protocolli, permettendo di individuare anomalie rapidamente e ridurre i rischi durante migrazioni ibride e cutover critici.

Qual è il vantaggio del BigQuery MCP Server per le aziende?

Il BigQuery MCP Server consente agli agenti AI di interrogare dataset enterprise in modo sicuro e standardizzato, senza integrazioni custom. Questo accelera lo sviluppo di applicazioni AI data-driven, mantenendo controllo degli accessi, auditabilità e sicurezza in ambienti enterprise regolati.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.