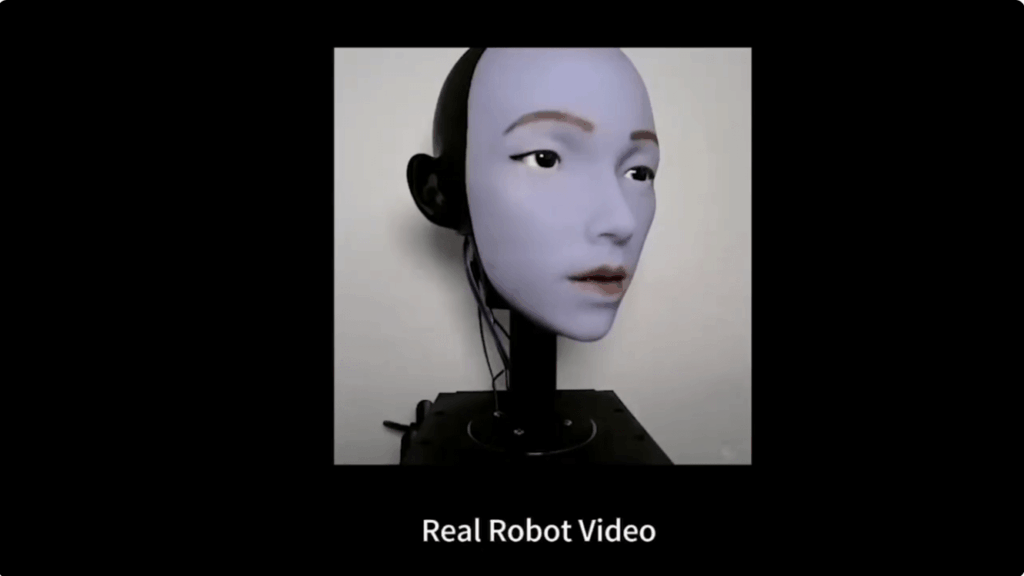

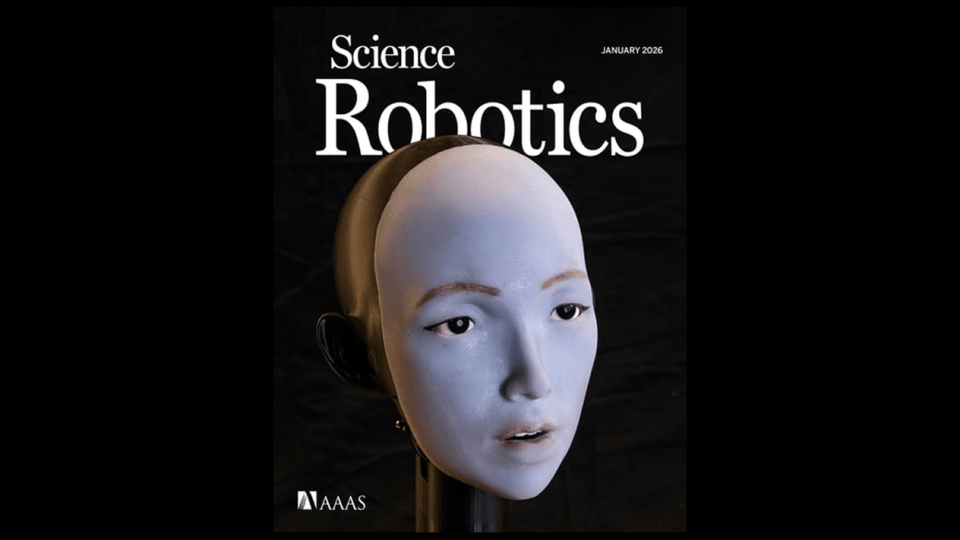

Robot Columbia lip sync è il risultato di uno studio che segna un punto di svolta nella robotica sociale e cognitiva. Un team di Columbia Engineering ha dimostrato che un robot dotato di volto flessibile può imparare a sincronizzare le labbra con il parlato osservando gli esseri umani, senza regole pre-programmate, senza dizionari fonetici e senza conoscere in anticipo lingue o suoni. La ricerca, pubblicata su Science Robotics, mostra come l’AI possa tradurre audio reale direttamente in azioni motorie facciali, aprendo scenari concreti per intrattenimento, educazione, cura degli anziani e interazioni uomo-robot più naturali. Il lettore trova qui cosa cambia, perché conta e quali rischi emergono.

Cosa leggere

Sviluppo del volto robotico flessibile

Alla base del progetto c’è un cambio di paradigma rispetto ai volti robotici rigidi. Gli ingegneri di Columbia hanno costruito un volto artificiale con pelle flessibile azionata da 26 motori indipendenti, capaci di produrre movimenti rapidi, coordinati e silenziosi. Questa architettura supera i limiti dei modelli tradizionali, basati su pochi gradi di libertà e su regole manuali che vincolano l’espressività.

Nel volto umano reale, decine di muscoli lavorano in sincronia con la voce per produrre fonemi, micro-espressioni e transizioni continue. Replicare questa complessità con regole statiche è impraticabile. Il robot Columbia, invece, non riceve istruzioni su come “muovere la bocca”: impara le correlazioni tra comandi motori e risultato visivo attraverso l’esperienza. Questo consente di articolare parole in lingue diverse, di seguire il ritmo del parlato e persino di cantare mantenendo una sincronizzazione credibile.

Il sistema evita la rigidità che alimenta la cosiddetta valle inquietante, perché la pelle flessibile e la dinamica continua dei movimenti riducono l’effetto artificiale. È un passo chiave verso volti robotici che non appaiono “meccanici”, ma espressivi e coerenti.

Apprendimento per auto-osservazione e imitazione umana

Il processo di apprendimento è centrale e innovativo. Nella prima fase, il robot viene posto davanti a uno specchio. Esegue migliaia di espressioni casuali, osservando il proprio riflesso. In questo modo costruisce una mappa interna che collega i comandi motori ai cambiamenti visivi del volto. Non c’è linguaggio, non c’è audio: solo visione e azione.

Questa auto-osservazione crea le fondamenta per la seconda fase, quella decisiva. Il robot passa a osservare labbra umane in video, prelevati da contenuti pubblici come YouTube. Ascolta l’audio associato e, grazie a un modello vision-to-action, apprende a collegare i suoni ai movimenti labiali osservati. Il sistema non “capisce” il significato delle parole, ma apprende la sincronia, in modo analogo a come fanno i bambini nei primi mesi di vita.

Il risultato è un modello che traduce direttamente l’audio in azioni motorie facciali, senza bisogno di trascrizioni testuali, dizionari fonetici o training linguistico specifico. Questo approccio elimina un enorme carico di programmazione manuale e rende il sistema adattabile a suoni nuovi.

Test di sincronizzazione su lingue e musica

I ricercatori hanno sottoposto il robot a una batteria di test estesi. Il sistema è stato valutato su discorsi spontanei, lingue diverse e brani musicali, dimostrando una capacità di generalizzazione notevole. Per la musica, il team ha utilizzato anche un album AI-generated, per verificare la risposta a ritmi e testi non convenzionali.

I risultati mostrano una sincronizzazione efficace nella maggior parte dei casi. Le difficoltà emergono su suoni specifici, come la “B” dura, che richiede una pressione labiale rapida, o la “W”, che implica un puckering marcato delle labbra. Secondo Hod Lipson, queste imperfezioni migliorano con la pratica: più il robot interagisce con umani reali, più affina i movimenti.

Le metriche riportate indicano un’accuratezza superiore all’80% nei test iniziali, con miglioramenti fino a circa 95% dopo sessioni di addestramento aggiuntive. Un risultato che, in robotica facciale, rappresenta un salto qualitativo.

Integrazione con AI conversazionali

Un aspetto chiave del progetto è l’integrazione con AI conversazionali. Yuhang Hu sottolinea che il lip sync diventa molto più potente quando viene collegato a modelli di dialogo avanzati come ChatGPT. In questo scenario, il robot non si limita a muovere le labbra in modo corretto, ma adatta le espressioni al contesto conversazionale.

Finestre di dialogo più lunghe consentono di modulare il tono, il ritmo e persino il sorriso in base alla conversazione. Questo crea un effetto che Lipson definisce “quasi magico”: un sorriso robotico ben sincronizzato innesca risposte emotive umane reali. È qui che la robotica espressiva smette di essere una dimostrazione tecnica e diventa interazione sociale.

Implicazioni per interazioni uomo-robot

Le applicazioni potenziali sono ampie e trasversali. Nell’intrattenimento, robot capaci di cantare e parlare con mimica credibile aprono nuove forme di spettacolo. In educazione, la mimica facciale può supportare l’apprendimento delle lingue, migliorando pronuncia e comprensione. In sanità e cura degli anziani, volti espressivi possono favorire compagnia, empatia e aderenza alle terapie.

Secondo Lipson, la robotica ha investito enormemente su gambe e mani, trascurando il volto. Eppure, il linguaggio facciale è uno dei canali comunicativi più potenti negli esseri umani. Con previsioni che parlano di miliardi di umanoidi nei prossimi decenni, l’assenza di espressività rischierebbe di rendere i robot socialmente inaccettabili. Questo studio indica che la valle inquietante può essere attraversata, se il volto viene progettato come sistema dinamico e apprendibile.

Rischi ed etica della robotica espressiva

La stessa potenza della tecnologia solleva interrogativi etici. Un robot capace di evocare risposte emotive può influenzare il comportamento umano in modo profondo. Lipson invita a uno sviluppo cauto, che bilanci benefici e rischi, soprattutto in contesti sensibili come la cura degli anziani o l’educazione dei bambini.

Hu parla di un “canale comunicativo untappato”: il volto. Usarlo responsabilmente significa evitare manipolazioni, dipendenze emotive o false attribuzioni di intenzionalità. La ricerca riconosce questi rischi e sottolinea la necessità di linee guida etiche parallele allo sviluppo tecnico.

Domande frequenti su Robot Columbia lip sync

Come impara il robot a sincronizzare le labbra senza regole predefinite?

Impara tramite auto-osservazione davanti a uno specchio per mappare comandi e movimenti, poi osserva labbra umane in video, collegando l’audio ai movimenti grazie a un modello vision-to-action.

Il robot comprende il linguaggio che pronuncia?

No. Il sistema non comprende il significato delle parole. Traduce l’audio in movimenti labiali sincronizzati, in modo simile all’imitazione infantile.

Quali sono le applicazioni più promettenti di questa tecnologia?

Intrattenimento, educazione linguistica, cura degli anziani, robot sociali e interfacce umano-robot più naturali, grazie a connessioni emotive più credibili.

Quali rischi etici comporta la robotica facciale espressiva?

Il rischio principale è l’influenza emotiva sugli umani. Per questo i ricercatori chiedono sviluppo responsabile, con attenzione a contesti sensibili e uso trasparente della tecnologia.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.