Google Cloud accelera sull’AI enterprise e lo fa con una serie di aggiornamenti che vanno oltre l’annuncio di nuove feature. Google Cloud sta intervenendo direttamente sui colli di bottiglia reali che frenano l’adozione dell’intelligenza artificiale in produzione: osservabilità degli agenti, orchestrazione dei workflow, gestione delle connessioni ai database, risposta agli outage e scalabilità dell’inference. In questo scenario entrano in gioco Gemini CLI, Datadog Agent Development Kit, Apache Airflow 3.1, AlloyDB con managed connection pooling, oltre a casi d’uso concreti di operatori come Fastweb e Vodafone.

Cosa leggere

Datadog e l’osservabilità dei sistemi agentic su Google Cloud

L’integrazione di Datadog con Agent Development Kit segna un passaggio chiave per chi sviluppa applicazioni agentic su Google Cloud. Il problema non è più costruire agenti AI, ma capire cosa fanno davvero quando entrano in produzione. Datadog introduce un livello di instrumentation automatica che traccia ogni passo dell’agente su una timeline unica, rendendo visibili latenza, costi token, errori di tool selection e loop infiniti.

Questo approccio consente ai team SRE e AI di individuare rapidamente problemi come hallucination, output incompleti o leak di dati sensibili, grazie a evaluator integrati e a controlli personalizzabili. La possibilità di riprodurre le chiamate in un playground e confrontare versioni diverse di modelli usando traffico reale riduce drasticamente i tempi di debugging. In un contesto enterprise, questa visibilità diventa fondamentale per compliance, audit trail e controllo dei costi, soprattutto quando più agenti cooperano su workflow complessi.

Cloud Composer e Apache Airflow 3.1 per workflow scalabili

Con il supporto in preview ad Apache Airflow 3.1, Cloud Composer compie un salto qualitativo nell’orchestrazione dei dati. Airflow 3.1 introduce workflow human-in-the-loop, consentendo di sospendere task in stato differito e richiedere approvazioni manuali direttamente dall’interfaccia o tramite integrazioni come Slack.

Le deadline alerts permettono di impostare soglie temporali che segnalano ritardi prima che diventino incidenti operativi, mentre la separazione tra scheduler ed execution migliora la scalabilità orizzontale. Il versioning nativo dei DAG e lo scheduling event-driven rendono Airflow più adatto a pipeline moderne, reattive a eventi esterni e asset dati dinamici. Per team distribuiti globalmente, la UI localizzata e l’estensibilità tramite plugin riducono il toil operativo e migliorano l’affidabilità complessiva.

AlloyDB e il managed connection pooling nativo

Uno degli aggiornamenti più concreti riguarda AlloyDB, che introduce il managed connection pooling in disponibilità generale. Il problema delle connessioni è noto: handshake TLS, creazione di sessioni e limiti di concorrenza diventano un freno soprattutto per applicazioni serverless e microservizi. Il pooler nativo di AlloyDB mantiene connessioni calde e le riutilizza, agendo come uno shock absorber durante i picchi di traffico.

I benefici sono misurabili: 3 volte più connessioni concorrenti e fino a 5 volte il throughput, con una riduzione significativa della latenza per query brevi. Due modalità operative, transaction e session, garantiscono sia massima efficienza sia compatibilità PostgreSQL. Eliminando la necessità di strumenti esterni come PgBouncer, AlloyDB semplifica le operazioni e riduce i costi infrastrutturali, un aspetto critico per workload AI che generano molte query brevi e frequenti.

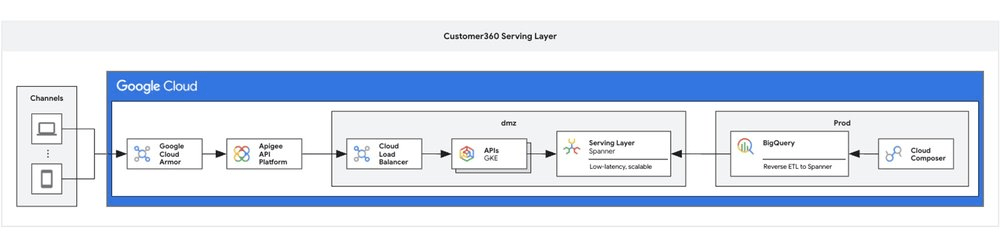

Fastweb e Vodafone, dati reimmaginati su Spanner e BigQuery

I casi di Fastweb e Vodafone mostrano come Google Cloud venga utilizzato per ripensare workflow dati su scala globale. Spanner garantisce transazioni consistenti multi-regione con bassa latenza, mentre BigQuery permette analisi su petabyte di dati in pochi secondi.

Vodafone utilizza queste tecnologie per ottimizzare la rete con query real-time, mentre Fastweb sfrutta BigQuery per analytics avanzate e modelli di machine learning orientati al servizio clienti. In entrambi i casi, la migrazione da sistemi legacy ha ridotto costi operativi e silos informativi, dimostrando come l’integrazione nativa tra database e AI sia ormai un fattore competitivo.

Nvidia Dynamo e lo scaling dell’inference MoE

Sul fronte hardware e inference, Nvidia introduce Nvidia Dynamo per scalare modelli Mixture of Experts su infrastrutture A4x. L’ottimizzazione del parallelismo consente di ridurre i costi computazionali fino al 40%, rendendo più sostenibile l’uso di modelli di grandi dimensioni in contesti enterprise.

L’integrazione con Google Cloud e Kubernetes semplifica il deployment, mentre il supporto a modelli con miliardi di parametri apre la strada a applicazioni AI più sofisticate senza compromettere tempi di risposta e consumo energetico.

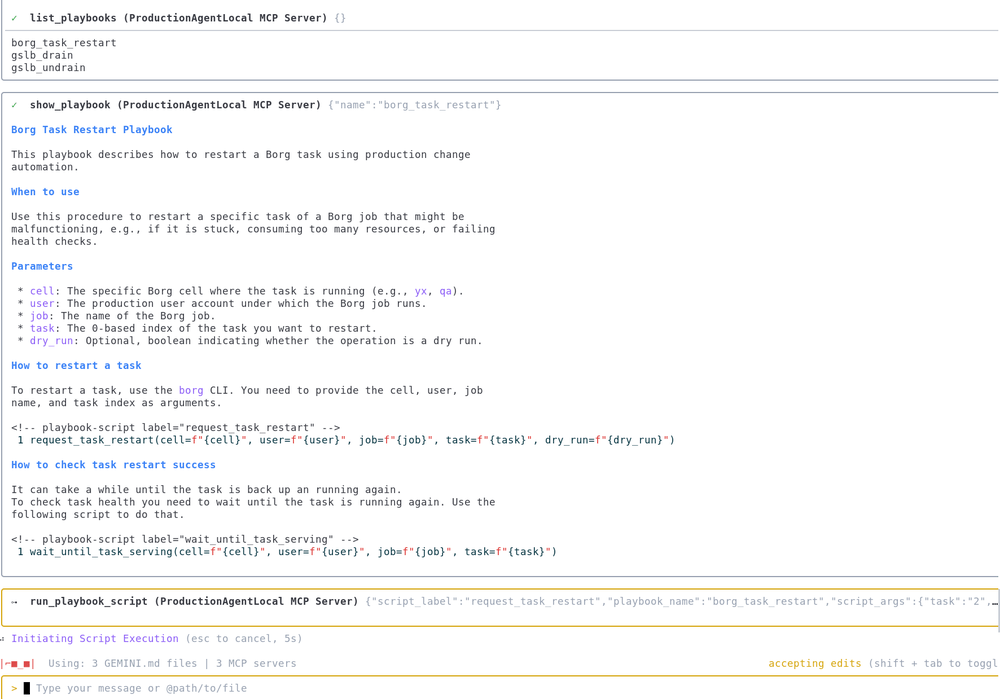

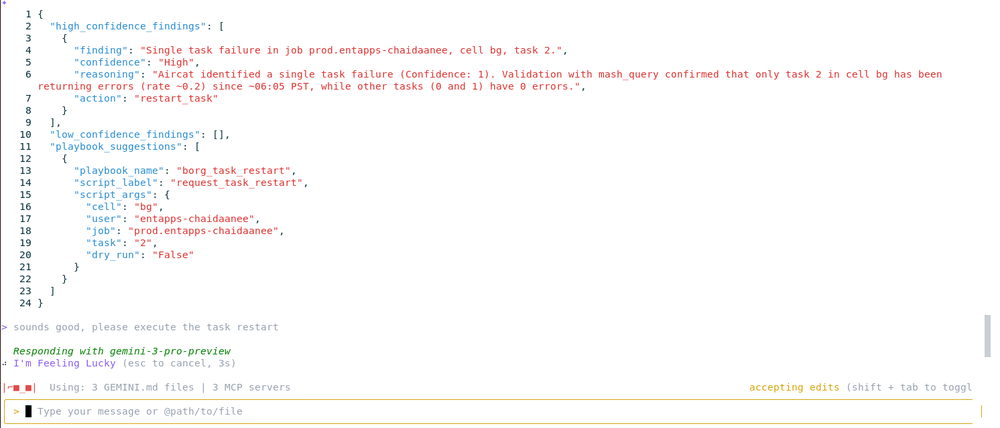

Gemini CLI e l’AI nella gestione degli outage

Uno degli aspetti più significativi è l’uso di Gemini CLI da parte degli SRE di Google per gestire outage reali. Integrando capacità agentic di Gemini 3 direttamente nel terminale, lo strumento automatizza analisi dei log, individuazione delle cause radice e mitigazioni iniziali, sempre con controllo umano.

Gemini CLI riduce MTTM e downtime, genera post-mortem strutturati e mantiene un audit trail utile per compliance. La natura open-source e l’estensibilità tramite MCP permettono ai team di adattarlo ai propri workflow, trasformando l’AI in un assistente operativo, non in un semplice chatbot.

Agent Factory, Cloud Run e incentivi RaMP

L’ecosistema si completa con Agent Factory, che sperimenta ambienti agent-first come Antigravity e generatori visivi come Nano Banana Pro, e con la possibilità di sviluppare prime app Gemini 3 su Cloud Run, passando dal prompt a un URL pubblico in pochi passaggi. A supporto delle migrazioni, il programma RaMP offre crediti e incentivi per workload enterprise, abbassando ulteriormente la barriera di ingresso.

Google Cloud e l’AI che entra nel lavoro quotidiano

Nel complesso, questi aggiornamenti mostrano una direzione precisa: Google Cloud sta spostando l’AI dal piano sperimentale a quello operativo, intervenendo su osservabilità, affidabilità e costi. Non si tratta di feature isolate, ma di un ecosistema che punta a rendere l’intelligenza artificiale gestibile, misurabile e sostenibile per le imprese che la usano ogni giorno.

Domande frequenti su Google Cloud e le nuove integrazioni AI

Gemini CLI può agire autonomamente durante un outage?

No, Gemini CLI automatizza analisi e suggerimenti, ma mantiene sempre un controllo umano sulle azioni critiche. Gli SRE approvano le mitigazioni prima dell’esecuzione.

Il managed connection pooling di AlloyDB sostituisce PgBouncer?

Sì, il pooling nativo elimina la necessità di tool esterni come PgBouncer, offrendo performance superiori e gestione semplificata direttamente dal servizio gestito.

Airflow 3.1 introduce lock-in con Google Cloud?

No, Apache Airflow resta open source e portabile. Cloud Composer fornisce un ambiente gestito, ma il codice dei DAG rimane compatibile con altre distribuzioni Airflow.

Datadog è necessario per monitorare agenti AI su Google Cloud?

Non è obbligatorio, ma l’integrazione con Datadog ADK offre visibilità avanzata su costi, errori e comportamenti degli agenti, riducendo rischi operativi e tempi di troubleshooting.

Iscriviti a Matrice Digitale

Ricevi le notizie principali direttamente nella tua casella di posta.

Niente spam, disiscriviti quando vuoi.