Nel 2026 Google Cloud prova a trasformare una promessa che nel 2024-2025 resta spesso marketing in una traiettoria industriale misurabile: far diventare gli AI agents un pezzo ordinario del lavoro quotidiano, senza lasciare scoperta la superficie d’attacco che inevitabilmente si allarga quando l’automazione tocca identità, dati e workflow. La sensazione, leggendo le novità annunciate, è che l’azienda voglia tenere insieme due piani che raramente convivono con coerenza. Da una parte, l’accelerazione sul fronte dei modelli e degli strumenti agentici; dall’altra, un linguaggio più “da CISO” del solito, con priorità dichiarate su resilienza, governance AI, identità non umane, e una risposta esplicita a campagne estorsive e supply chain che prendono di mira l’impresa dove fa più male: SSO, SaaS e dati ad alta sensibilità.

È un passaggio che si legge anche nel modo in cui vengono raccontati gli aggiornamenti delle piattaforme: non più soltanto “feature” isolate, ma tasselli di un disegno dove l’AI non è un componente accessorio. È un driver che impone nuove forme di query, nuove forme di database, nuove GPU in ambienti serverless, e soprattutto nuove regole operative per non trasformare l’adozione in un moltiplicatore di rischio. Il punto, nel 2026, non è se le aziende useranno agenti: è chi controllerà il perimetro decisionale di quegli agenti, quali dati vedranno, quali azioni potranno compiere e con quali garanzie di tracciabilità.

Novità AI: Gemini 3 come “motore” e l’idea di un enterprise agentico

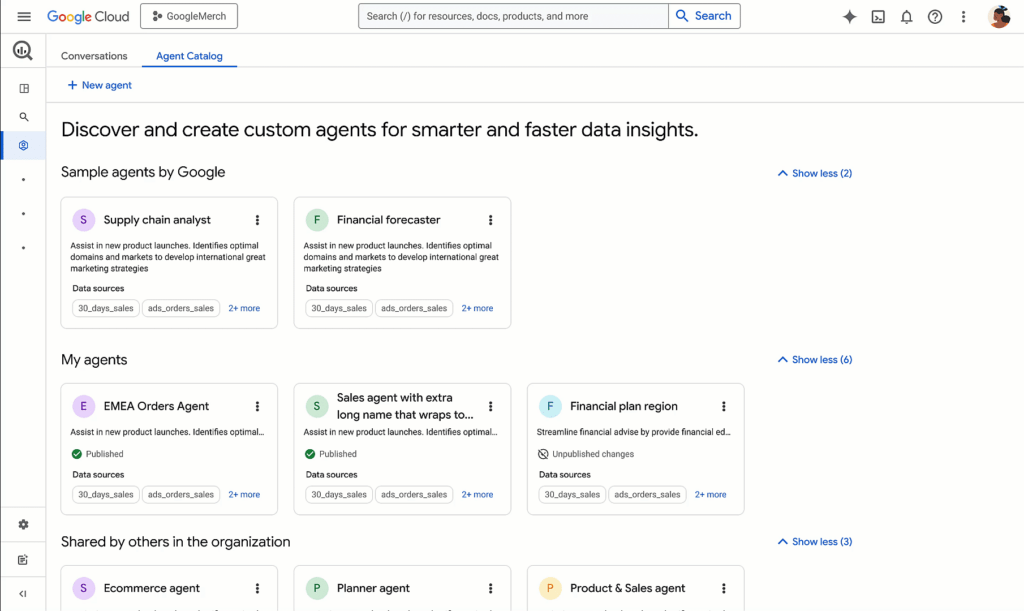

L’annuncio che fa da architrave è l’arrivo di Gemini in versione 3 come modello “più intelligente” disponibile su Vertex AI e su Gemini Enterprise. Il messaggio è chiaro: la piattaforma non vuole più limitarsi a offrire modelli per chat o generazione, ma punta a una capacità agentica sostenuta da multimodalità e orchestrazione. Nel linguaggio di Google Cloud, questo si traduce in un modello che non si limita a rispondere, ma ragiona su compiti, contesto e strumenti, con una narrativa che sposta l’attenzione dall’output alla catena di esecuzione.

Nel perimetro business, Gemini Enterprise per Customer Experience viene presentata come un’integrazione che unifica ricerca, commercio e servizio. La scelta di mettere insieme questi tre blocchi racconta una visione specifica: l’esperienza cliente smette di essere una sequenza di canali e diventa un flusso unico in cui un agente deve saper passare dal “trova” al “consiglia” fino a “risolvi”. In pratica, un assistente capace di muoversi tra cataloghi, knowledge base, ordini e sistemi di ticketing senza costringere l’utente a cambiare contesto. La promessa, implicita, è ridurre l’attrito operativo, ma anche rendere più sfruttabile il dato interno: se l’agente è davvero connesso, ogni interazione può diventare un evento osservabile e governabile, non un buco nero di conversazioni.

Universal Commerce Protocol: lo standard come arma strategica per gli agenti

Uno dei dettagli più rivelatori è il Universal Commerce Protocol, descritto come standard aperto per interazioni agentiche nel commercio. Qui la partita non è solo tecnica, è di posizionamento. Se gli agenti diventano intermediari, chi impone il “linguaggio comune” dell’interazione agentica può ridurre la frammentazione delle integrazioni e trasformare la compatibilità in vantaggio competitivo. Il protocollo viene raccontato come un modo per evitare connessioni one-off tra sistemi e verticali, ma il sottotesto è più ambizioso: creare un livello di interoperabilità che renda naturale l’adozione di agenti, perché “parlano” già con i sistemi in modo standardizzato.

Il rischio, in questo scenario, è che l’adozione degli agenti nel commercio diventi un acceleratore di frodi, impersonificazioni e abusi di identità. Ed è qui che il racconto di Google Cloud prova a restare coerente: lo standard si vende come semplificazione, ma deve convivere con un set di controlli che impediscano che l’agente diventi il nuovo endpoint vulnerabile. Nel 2026, l’agentic commerce non è un tema di UX: è un tema di autorizzazioni, audit, limitazioni di azione, e soprattutto di responsabilità quando qualcosa va storto.

Veo 3.1 e la generazione video che punta al mobile e al 4K

Sul fronte generativo, Veo 3.1 si muove con un miglioramento che sembra piccolo ma è altamente indicativo: modalità portrait e upscaling fino al 4K. È il classico aggiornamento che svela la direzione. Portrait significa mobile-first e short form, quindi un uso più vicino alle pipeline editoriali e social che ai demo da laboratorio. Il 4K, invece, è una dichiarazione implicita di maturità: non basta più “generare”, bisogna generare in formati compatibili con produzione e distribuzione reale. Nel contesto enterprise, l’upscaling non è una feature estetica, è un modo per ridurre il costo operativo di asset video, mantenendo qualità accettabile per campagne, training e contenuti interni.

BigQuery: quando l’analytics diventa conversazionale e genera SQL

La parte più “concreta” per molte aziende arriva dal lato dati. BigQuery introduce una linea di funzioni che spingono verso l’analytics conversazionale, con generazione di SQL da linguaggio naturale e workflow multi-stage che tengono conto di schema e metadati. Il punto, qui, non è soltanto far scrivere query a chi non conosce SQL. È inserire l’AI nel ciclo di analisi in modo che l’utente possa chiedere, ottenere una query coerente, ricevere una sintesi e poi iterare con domande successive senza ripartire da zero.

Nel racconto delle nuove funzioni si intravede un pattern: l’AI diventa “residente” nella piattaforma, con strumenti che vanno da classificazione testi a embedding e search semantica. In parallelo, l’idea di Comments to SQL sposta la query generation nel luogo dove i team già lavorano: il codice e i commenti, non un’interfaccia separata. Se l’analytics conversazionale è ben implementato, cambia il modo in cui i team data discutono: non più solo notebook e dashboard, ma conversazioni con un agente che produce SQL, propone visualizzazioni e suggerisce follow-up.

Questo scenario, però, introduce anche un rischio nuovo: la “comodità” può diventare un vettore di errori silenziosi se l’agente genera query semanticamente plausibili ma logicamente sbagliate. Per questo, nel 2026, l’analytics conversazionale non si gioca sulla sola generazione, ma sulla verificabilità: spiegazioni, tracciamento delle fonti interne, e un rapporto più esplicito tra domanda, query e risultato. È lo stesso problema delle AI in generale, ma qui tocca numeri, budget, forecast e decisioni operative.

Spanner: vettori, grafi e relazionale nello stesso motore

Sul versante database, Cloud Spanner spinge su un’idea che diventa quasi inevitabile nel 2026: unificare dati relazionali, vettori e grafi per applicazioni AI. La scelta è coerente con l’evoluzione di RAG e GraphRAG: se l’AI deve muoversi tra entità e relazioni, i grafi diventano naturali; se deve fare retrieval semantico, i vettori diventano necessari; se deve restare affidabile su transazioni e consistenza, il relazionale resta la base. Mettere tutto insieme significa tentare di ridurre la complessità architetturale che oggi costringe molti team a incollare sistemi diversi con layer di sincronizzazione.

Nel racconto di Spanner compaiono anche elementi che parlano ai team che devono far funzionare l’AI in produzione, non in demo: index advisor, raccomandazioni di schema, miglioramenti all’ottimizzatore, tiering dello storage, e meccanismi per aumentare efficienza e ridurre costi. È il tipo di evoluzione che suggerisce una maturazione: l’AI non è solo training e inferenza, è manutenzione, governance dei dati e riduzione del rischio di anti-pattern.

La parte più interessante, in chiave agentica, è che un database “ibrido” può diventare un backend naturale per applicazioni che devono rispondere sia a query strutturate sia a richieste semantiche, senza cambiare continuamente contesto. Nel 2026, la domanda è se questa unificazione regge sul piano operativo: performance, coerenza dei modelli di accesso, e soprattutto governabilità quando più tipi di dato convivono.

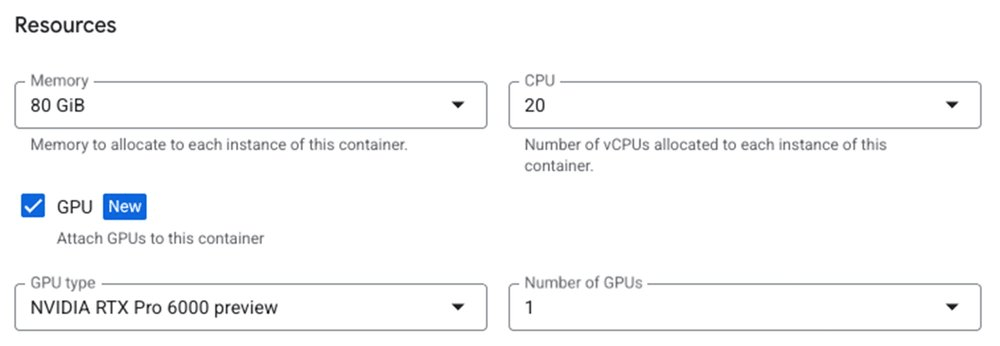

Cloud Run e GPU: inferenza serverless con hardware di fascia alta

Un segnale molto chiaro della direzione è l’apertura di Cloud Run alle GPU NVIDIA RTX PRO 6000 per workload AI. Quando una piattaforma serverless integra GPU, ammette implicitamente che l’AI sta uscendo dall’angolo “batch” e sta entrando nel terreno delle applicazioni rapide, on-demand, con tempi di avvio bassi e integrazione nativa con storage e pipeline. Questo rende più semplice portare modelli in produzione senza dover mantenere cluster dedicati per ogni microservizio, ma introduce una nuova necessità: controllo dei costi, priorità di scheduling, e soprattutto meccanismi di isolamento quando l’inferenza diventa un servizio esposto.

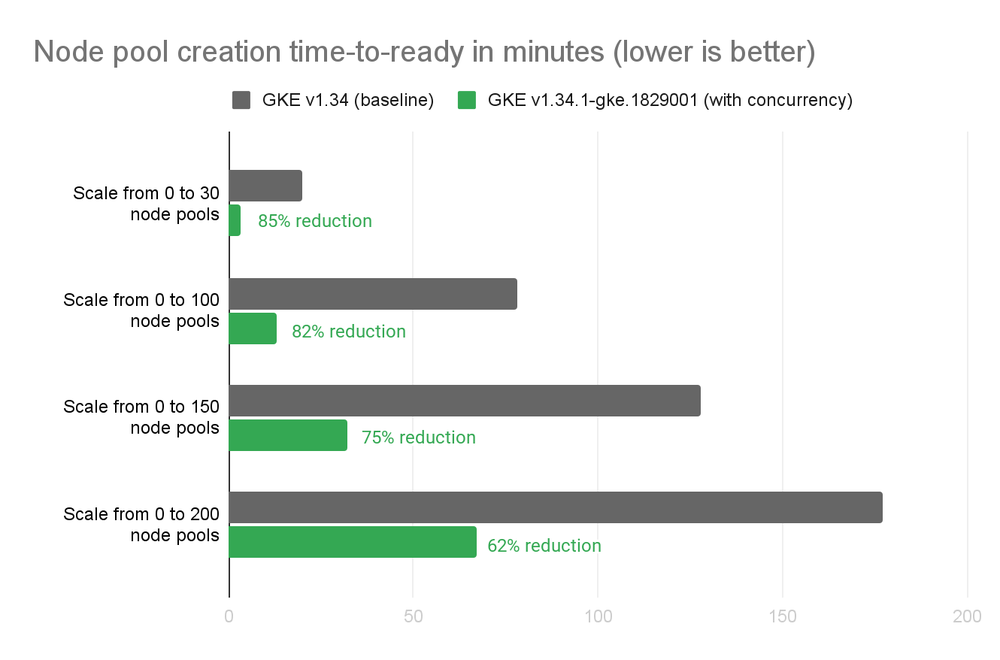

Sul fronte container e orchestrazione, Google Kubernetes Engine accelera la creazione dei pool di nodi riducendo le latenze di provisioning, mentre Dataflow spinge su ottimizzazioni per streaming ML e supporto a acceleratori. Qui si intravede un filo comune: ridurre il tempo che passa tra “ho un’idea” e “lo metto in produzione”. Perché gli agenti, in particolare, vivono di iterazione rapida: cambiano prompt, policy, tool e integrazioni con un ciclo molto più corto rispetto al software tradizionale.

Cyber defense: la risposta ai modelli estorsivi che colpiscono SSO e SaaS

La parte sicurezza non è un contorno. Nel 2026 Google Cloud la presenta come un blocco operativo in cui i CISO devono affrontare minacce che corrono “a velocità macchina”, con attori capaci di automatizzare vishing, phishing e movimento laterale in ambienti SaaS in tempi compatibili con la finestra di detection più critica.

Nella narrativa compaiono esplicitamente campagne attribuite a ShinyHunters, con dinamiche di estorsione che passano da credenziali e codici MFA catturati tramite domini fasulli, fino al pivot su piattaforme come Microsoft SharePoint e Salesforce. Il punto che emerge è che l’estorsione SaaS non richiede più un ransomware “classico” per fare leva. Basta dimostrare accesso, esfiltrare campioni credibili e costruire una pressione reputazionale e normativa, spesso chiedendo pagamento in criptovalute. È un modello che sposta l’attenzione: non si tratta solo di proteggere endpoint e server, ma di proteggere sessioni, identità, token, e soprattutto la postura dei servizi cloud dove il dato vive e dove l’azienda lavora.

In parallelo, viene citata l’interruzione di una rete proxy residenziale come IPIDEA, con implicazioni immediate per frodi, scraping e mascheramento del traffico malevolo. Se le reti proxy abbassano la qualità del segnale per i sistemi di difesa, allora ridurne la disponibilità diventa una misura di “igiene” che alza il costo operativo per i threat actor. Il coinvolgimento di Google Play Protect nel rimuovere app con SDK legati a questo tipo di infrastruttura è un dettaglio che conta: la difesa si sposta anche sul piano dell’ecosistema, non solo sul perimetro aziendale.

Cinque priorità CISO: identità, supply chain AI e difesa automatizzata

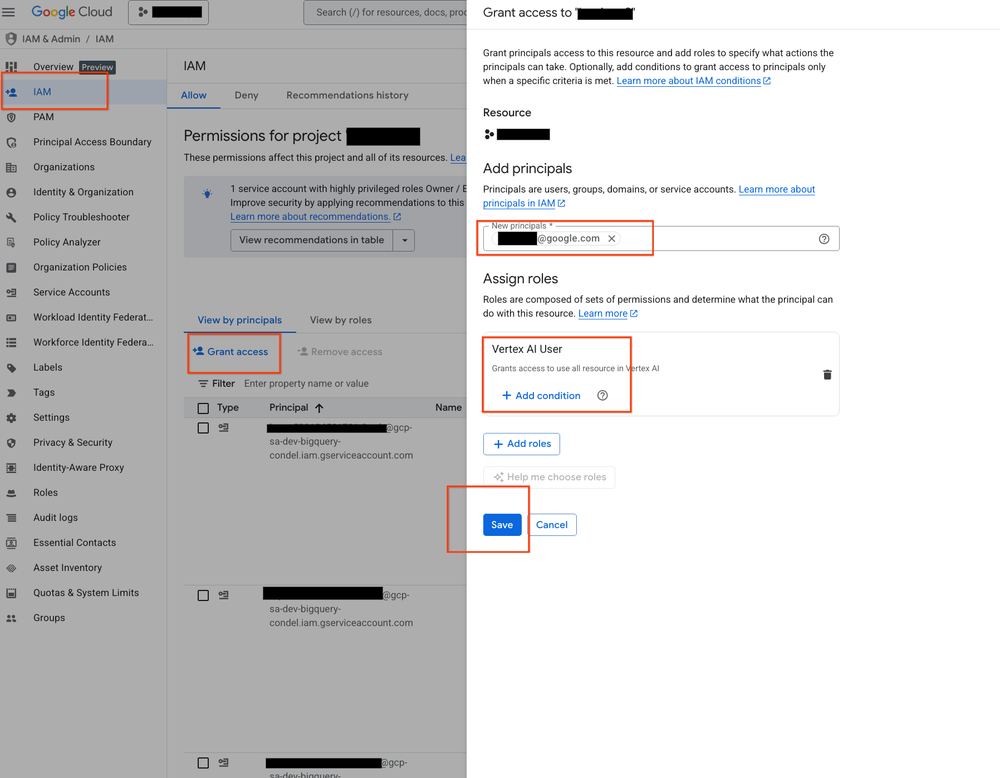

Il blocco “CISO Perspectives” elenca cinque priorità che, nel contesto 2026, suonano meno come slogan e più come una checklist inevitabile. La prima è l’allineamento tra compliance e resilienza quando l’AI entra nei processi tecnici: significa che l’adozione non può avvenire senza un piano di continuità, osservabilità e recupero. La seconda è la catena di fornitura dell’AI, con visibilità end-to-end e concetti come SLSA e SBOM, perché modelli, librerie e pipeline diventano vettori di rischio tanto quanto i pacchetti di codice tradizionali. La terza è l’identità, con un’enfasi che nel 2026 diventa inevitabile: non ci sono solo utenti umani, ci sono agenti e workload che agiscono come “identità” e devono essere governati.

La quarta priorità, difendere a velocità macchina, è quasi una confessione: senza automazione, l’impresa perde. Se l’attaccante impiega secondi per muoversi, il rilevamento e la risposta devono essere compressi nello stesso ordine di grandezza. La quinta è la governance AI, intesa come combinazione di competenza tecnica, test avanzati e controllo operativo. È un punto cruciale perché, quando gli agenti diventano capaci di agire, la governance smette di essere un documento: diventa un set di policy eseguibili.

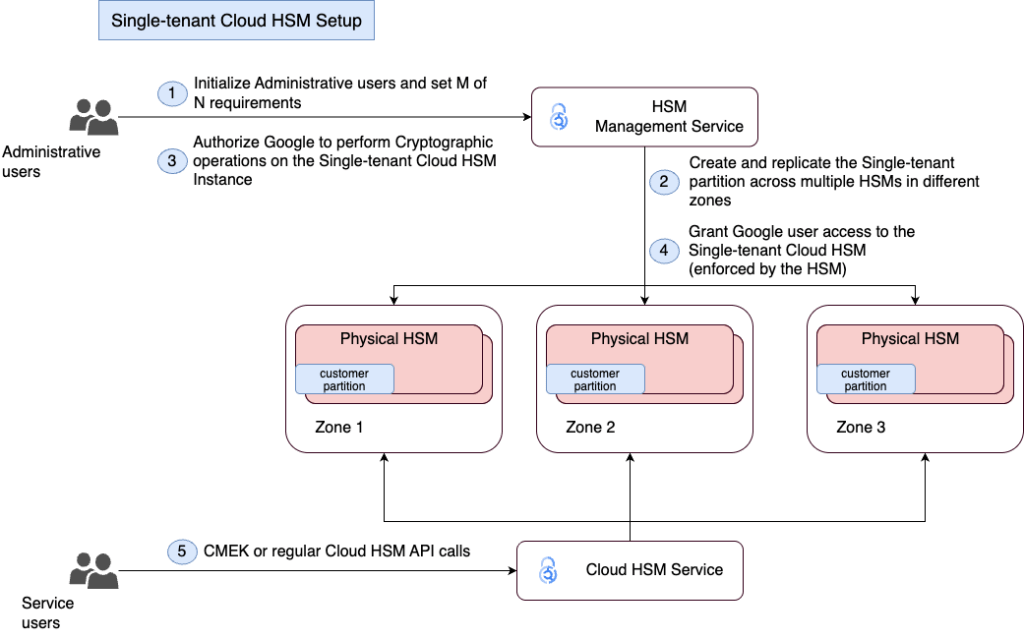

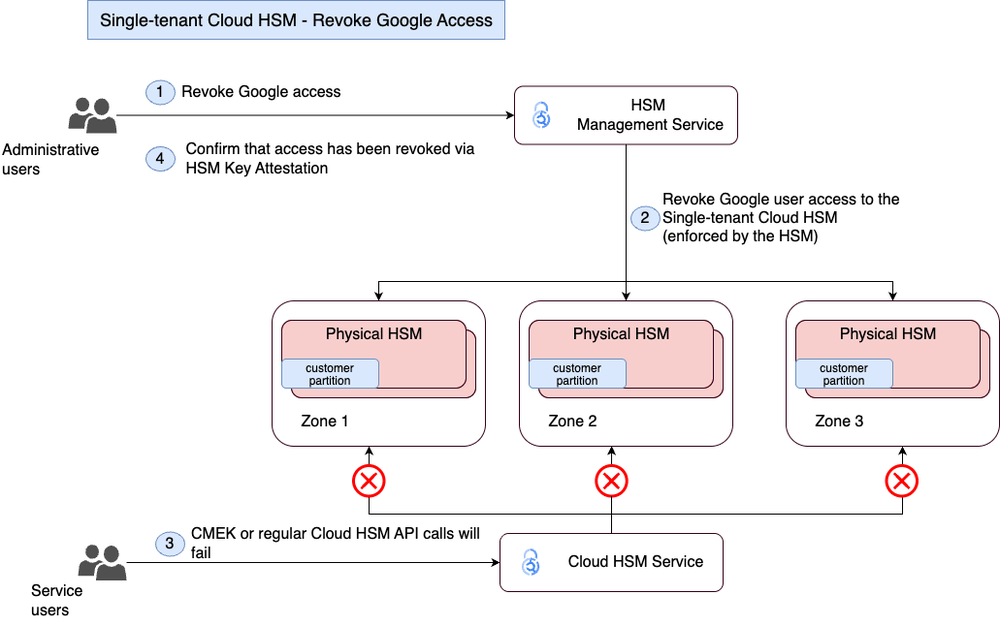

Single-tenant Cloud HSM: isolamento hardware per chiavi e fiducia

In questa cornice, l’introduzione di un’offerta single-tenant per Cloud HSM mette a fuoco una realtà: per alcuni settori, multi-tenant non è negoziabile. Il valore non è solo l’HSM, è la possibilità di avere un cluster dedicato, isolamento hardware e un controllo più rigido su chiavi radice e amministrazione. L’integrazione con Cloud Key Management Service rende la proposta più completa: non si tratta di “un dispositivo”, ma di un’architettura di gestione delle chiavi che può supportare requisiti di compliance, audit e segregazione.

Nel 2026, questa scelta parla a banche, pubbliche amministrazioni e infrastrutture critiche, ma anche a chi sviluppa sistemi agentici che interagiscono con dati sensibili. Perché l’agente, per definizione, avrà bisogno di credenziali e chiavi per eseguire azioni: se quelle chiavi non sono protette a livello hardware e policy, l’automazione diventa un rischio sistemico.

Chrome Enterprise e il browser che diventa agente, ma con guardrail

L’evoluzione di Chrome Enterprise in chiave “browser agentico” è un altro segnale del cambio di paradigma. Il browser è un posto dove già transitano identità, sessioni e dati. Se lo si rende capace di compiti agentici, si guadagna produttività, ma si apre anche un tema enorme: evitare che il browser-agente diventi uno strumento di esfiltrazione involontaria o un canale per la manipolazione di workflow sensibili.

Le misure citate, come DLP e watermarking dinamico, indicano una direzione: l’agentic computing deve stare dentro un perimetro di controllo che impedisca la diffusione non autorizzata dei dati. Il punto, nel 2026, è che l’AI nel browser non è solo una feature: è un cambiamento nel confine tra “utente” e “azione automatica”, e richiede un’architettura di fiducia che molti ambienti enterprise non hanno ancora consolidato.

Strumenti per sviluppatori: .NET, manutenzione unificata e full-stack Dart

Sul fronte developer, l’estensione di Vertex AI per .NET e l’adozione di astrazioni unificate puntano a ridurre il costo di integrazione. È un tema che sembra secondario, ma non lo è: l’AI diventa infrastruttura solo se gli sviluppatori la usano in modo ripetibile, standardizzato e mantenibile. Se ogni team integra l’AI in modo diverso, la governance diventa impossibile.

La manutenzione unificata, con una dashboard che centralizza aggiornamenti e finestre di manutenzione, risponde a un problema storico del cloud: la frammentazione delle notifiche e degli impatti. Nel 2026, quando gli agenti e le pipeline AI aumentano la dipendenza da servizi gestiti, sapere “quando cambia cosa” diventa essenziale per resilienza.

L’idea di un’architettura full-stack Dart con Flutter su Cloud Run mostra invece una direzione più radicale: ridurre la distanza tra frontend e backend, con modelli condivisi e deployment semplificato. Flutter qui non è solo un framework mobile: viene posizionato come componente di un’architettura end-to-end che riduce complessità e accelera la messa in produzione. È un tipo di scelta che piace soprattutto ai team che vogliono iterare velocemente su prodotti agentici e data-driven.

Hackathon e casi d’uso: quando l’AI incontra il dato clinico e operativo

I numeri dell’hackathon BigQuery AI e i progetti citati, come OncOmix per oncologia di precisione o soluzioni multimodali per ticketing, servono a un obiettivo preciso: dimostrare che la piattaforma non è solo un insieme di servizi, ma un ecosistema dove l’AI può applicarsi a problemi complessi e reali. Il punto non è il premio. Il punto è far vedere che la combinazione tra data platform e agentic AI produce applicazioni che superano la semplice automazione di task ripetitivi e iniziano a toccare domini ad alta responsabilità.

Qui, però, torna la domanda fondamentale del 2026: come si governa la qualità quando l’AI entra in domini sensibili? La risposta, nel discorso di Google Cloud, passa da governance e sicurezza “by design”, ma la verità operativa è che serve una disciplina nuova: test, osservabilità e controlli continui su ciò che l’agente fa, non solo su ciò che dice.

Perché questo pacchetto di novità conta davvero nel 2026

Mettendo insieme tutte le componenti, il quadro è coerente: Google Cloud punta a far diventare gli agenti un layer operativo trasversale, sostenuto da un’infrastruttura che include modelli, data platform, database ibridi e runtime con GPU, mentre la cyber defense viene presentata come condizione di possibilità, non come optional.

Il 2026, in questo racconto, è l’anno in cui il cloud prova a diventare “agent-native” e “security-native” nello stesso tempo. È una promessa ambiziosa, perché l’agentic computing tende a complicare la security posture: più automazione significa più privilegi distribuiti, più integrazioni, più superfici di errore. Se il mercato seguirà questa direzione, la differenza la farà chi riesce a trasformare la sicurezza in meccanica di piattaforma, non in documento di policy.

Faq

Che cosa cambia davvero con gli AI agents nel cloud nel 2026

Gli agenti passano da chatbot a sistemi che eseguono azioni su dati e workflow. Questo richiede controlli su identità, autorizzazioni e audit, non solo buone risposte in chat.

Perché BigQuery punta su analytics conversazionali e SQL generato da linguaggio naturale

Perché l’AI deve entrare nei workflow reali dei team data. La generazione di SQL riduce attrito e accelera insight, ma impone verificabilità e tracciabilità per evitare errori silenziosi.

In che senso Spanner “unifica” relazionale, vettori e grafi

Significa supportare nello stesso motore query transazionali, retrieval semantico e relazioni tra entità. È un’architettura pensata per applicazioni RAG e agentiche che devono usare più modelli di dato.

Qual è il rischio principale delle campagne estorsive SaaS attribuite a ShinyHunters

Il rischio è la perdita di controllo su identità e sessioni: con vishing e phishing su SSO gli attori entrano nei servizi SaaS, estraggono campioni di dati e costruiscono estorsione senza ransomware tradizionale.

Perché un Cloud HSM single-tenant diventa rilevante nel 2026

Perché alcune organizzazioni richiedono isolamento hardware dedicato e controllo più rigido delle chiavi, soprattutto quando agenti e automazioni devono accedere a dati sensibili e sistemi critici.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU...