L’inferenza è il momento in cui l’intelligenza artificiale smette di essere “promessa” e diventa servizio. È il passaggio in cui un modello già addestrato prende un input e produce un output: una risposta testuale, un’immagine, una previsione, un riconoscimento. Se il training è la fase in cui un modello impara, l’inferenza è la fase in cui quel modello viene usato. Ed è la parte che, nel mondo reale, si mangia la maggioranza del tempo operativo, dei budget e delle discussioni su prestazioni, privacy e controllo. Il problema è che la parola “inferenza” viene spesso trattata come un dettaglio tecnico, quando invece è la leva che decide tutto: quanto costa far girare un assistente AI in produzione, quanta latenza accetti prima che l’esperienza utente diventi irritante, quanta energia bruci per generare una risposta, quanta dipendenza crei verso un cloud esterno, quanta parte dei tuoi dati sensibili finisce in transito. L’inferenza non è un tecnicismo. È la fabbrica.

Inferenza: definizione semplice ma precisa, senza favole

In termini puliti, inferenza significa “esecuzione di un modello” su dati nuovi. Il modello è già stato addestrato e i suoi parametri sono fissati. Tu invii un input e il modello calcola un output usando quei parametri. Il calcolo avviene in tempo reale o quasi reale, e ogni richiesta è una transazione di compute e memoria.

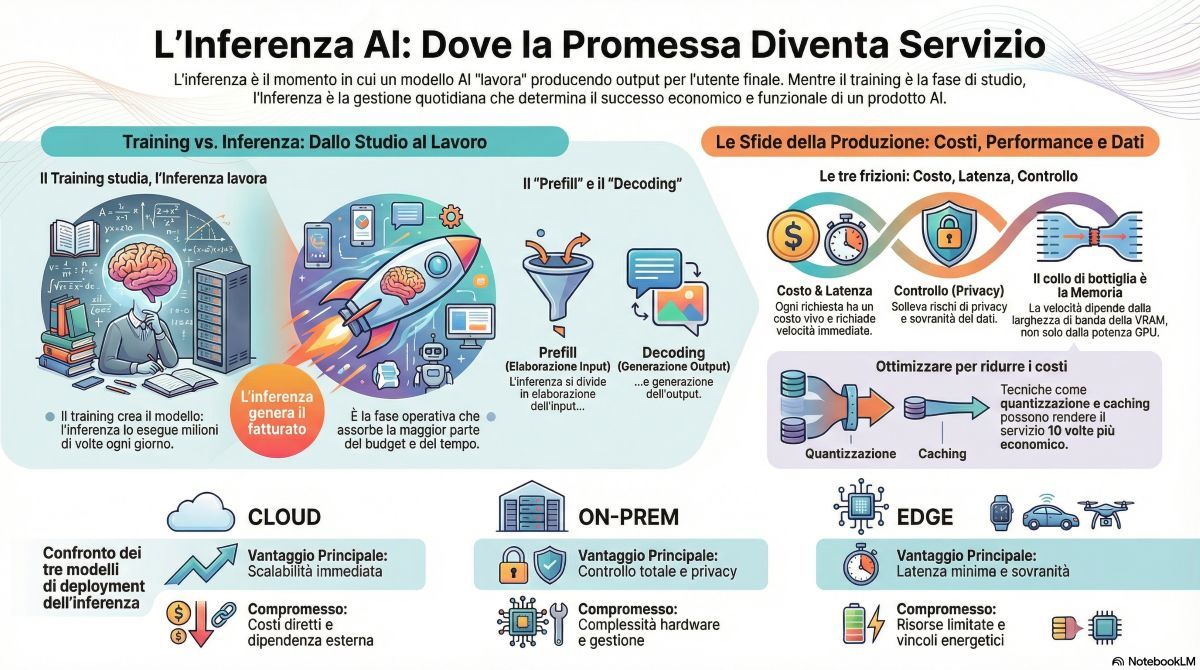

Se vuoi dirlo ai lettori in modo diretto: l’inferenza è quando l’AI “lavora”. Il training è quando l’AI “studia”. Il training può durare settimane e costare milioni, ma l’inferenza è quella che succede ogni singolo giorno, milioni di volte, su ogni app, chatbot, sistema antifrode, motore di raccomandazione e pipeline industriale. Per questo l’inferenza è diventata la parte più economica da discutere e la più costosa da gestire.

Perché nel 2026 l’inferenza è più importante del training per quasi tutti

Il training è spettacolare: fa notizia. L’inferenza è la routine: fa fatturato. La maggior parte delle organizzazioni non addestra modelli foundation da zero. Compra, integra, affina, oppure usa modelli già pronti. Ma poi li mette in produzione e deve farli girare su richieste reali, con SLA, picchi di traffico, utenti che non aspettano, e costi che diventano immediatamente visibili.

Quando l’inferenza scala, emergono tre frizioni principali.

La prima è il costo per richiesta. Ogni output richiede calcolo, memoria e banda. Se l’output cresce, crescono i costi. Se aumentano gli utenti, aumentano i costi. Se aumentano i contesti lunghi, aumentano i costi. Non è un costo “una tantum”. È un costo che respira con il prodotto.

La seconda frizione è la latenza. Un modello può essere “molto intelligente” ma se risponde in cinque secondi in un contesto dove l’utente si aspetta mezzo secondo, quella intelligenza diventa frustrazione. La latenza non è solo un numero: è il punto in cui l’AI viene percepita come utile o come un giocattolo lento.

La terza frizione è il controllo dei dati. Fare inferenza in cloud significa spesso spostare input, contesti e documenti verso un provider. Anche quando ci sono contratti e policy, il fatto tecnico resta: i dati viaggiano. Se fai inferenza on-prem o edge, sposti il problema su hardware, gestione e ottimizzazione, ma riduci l’esposizione e puoi costruire sovranità operativa.

Inferenza non è una cosa sola: i due momenti che contano davvero

Per capire l’inferenza dei modelli generativi, soprattutto LLM, devi separare due fasi che nella pratica determinano prestazioni e costi. La prima fase è l’elaborazione dell’input, spesso chiamata prefill. Il modello “legge” il prompt e il contesto. Qui il costo cresce con la lunghezza dell’input: più contesto, più calcolo, più memoria. La seconda fase è la generazione dell’output, spesso chiamata decoding. Il modello produce token uno dopo l’altro. Qui la velocità si misura in token al secondo e la latenza percepita dipende da quanto rapidamente arrivano i primi token e da quanto scorre fluida la generazione. Questo spiega un fenomeno che i lettori notano senza sapere perché: due chatbot possono avere la stessa “qualità” ma una sembra istantanea e l’altra sembra impastata. La differenza spesso non è nel modello, ma nel modo in cui viene servito: batching, quantizzazione, caching, hardware, parallelismo e gestione della coda.

Token: la moneta dell’inferenza che quasi nessuno spiega bene

Nei modelli linguistici, l’inferenza è legata ai token, cioè unità di testo che non coincidono sempre con parole intere. I token determinano quanto calcolo serve e quanto paghi quando usi servizi a consumo. E determinano anche perché i contesti lunghi sono una trappola economica se li gestisci male. Qui il lettore deve capire un punto: quando fai una domanda “semplice” ma incolli dentro una quantità enorme di testo, stai comprando inferenza due volte. Stai pagando per far leggere al modello tutto quel contesto e poi per farlo rispondere. Non è cattiveria dei provider. È la fisica del calcolo. Nel mondo enterprise questo diventa un problema progettuale. Se il prodotto basa tutto su prompt giganteschi, ogni richiesta costa. Se invece usa retrieval intelligente, indicizzazione e caching, può dare risposte simili con molti meno token.

Il vero collo di bottiglia dell’inferenza: memoria e banda, non solo “potenza”

Un errore comune è pensare che l’inferenza sia “solo GPU”. È vero che la GPU è spesso la macchina principale, ma il limite pratico, soprattutto con modelli grandi, è la memoria: quanta ne hai, quanto è veloce, e come la usi. Quando un modello entra in inferenza, devi caricare i suoi pesi. Se i pesi stanno in VRAM e non si muovono, sei felice. Se iniziano a spostarsi tra VRAM e RAM di sistema, o peggio tra RAM e storage, la latenza esplode e l’esperienza si degrada. HBM e GDDR sono decisive per la banda, ma il punto operativo è sempre lo stesso: il modello deve restare “vicino” al compute e deve poter leggere i pesi senza strozzature. Ecco perché i provider parlano ossessivamente di HBM, di capacità di VRAM, di topologie multi-GPU e di interconnessioni. Non è marketing puro. È che l’inferenza moderna è un flusso continuo di letture e operazioni che diventano inefficaci se la memoria non regge.

Cloud inference, on-prem inference, edge inference: tre mondi, tre compromessi

Nel cloud, l’inferenza è comoda: paghi, scali, integri in fretta. È perfetta per prototipi, per prodotti che crescono, per aziende che vogliono velocità. Ma il cloud porta due costi: economico e strategico. Economico perché il costo per token o per richiesta cresce in modo diretto con l’uso. Strategico perché i dati transitano e perché il lock-in può diventare reale quando costruisci l’intero prodotto attorno a un fornitore. On-prem, l’inferenza ti dà controllo: porti il modello dove sono i dati, costruisci governance, riduci esposizione. Ma paghi in complessità: hardware, aggiornamenti, osservabilità, ottimizzazione, gestione dei picchi. E spesso paghi anche in tempo: mettere in produzione un sistema di inferenza serio non è “installare un tool”, è progettare un servizio critico. Edge, l’inferenza diventa un vantaggio competitivo quando la latenza è tutto o quando la privacy è non negoziabile. È qui che l’AI smette di essere “in cloud” e diventa parte del dispositivo: smartphone, auto, macchinari, sensori. Ma edge significa risorse limitate e vincoli energetici. Quindi l’inferenza edge vive di modelli più piccoli, di compressione, di quantizzazione, e di una disciplina di engineering molto più severa.

Perché l’inferenza decide la privacy più del training

Nel dibattito pubblico si discute spesso di training, dataset, copyright, “da cosa ha imparato”. Sono questioni reali. Ma nel quotidiano di molte aziende, il rischio immediato è l’inferenza: cosa inviano gli utenti, cosa inviano i dipendenti, quali documenti finiscono dentro un prompt, quali dati personali vengono concatenati dentro un contesto. Se un customer care incolla dati identificativi in un chatbot, se un ufficio legale incolla contratti, se un team HR incolla CV, l’inferenza diventa un canale di fuga potenziale. Anche quando c’è un contratto e una policy “non usiamo i dati”, la governance interna deve considerare che l’errore umano è sistemico. E che l’AI rende più facile incollare, velocemente, cose che prima non avresti mai caricato su un servizio esterno. Questo è un punto editoriale forte: l’inferenza è un’interfaccia di rischio, non solo una funzione. Ed è il motivo per cui molte organizzazioni stanno spostando inferenza su ambienti controllati, o stanno imponendo filtri, redaction automatica, e segregazione dei dati.

Latenza: il punto in cui l’AI passa da demo a prodotto

La latenza è la variabile che decide se l’inferenza “funziona” nel senso umano. Un assistente che risponde lentamente cambia il comportamento dell’utente: lo interrompe, lo porta a fare altro, e riduce la fiducia. Nelle aziende, la latenza è anche costo: se una catena decisionale dipende da un output lento, il flusso di lavoro collassa. Qui puoi spiegare ai lettori un fatto semplice: la latenza non è solo “quanto ci mette il modello”. È rete, code, batching, cold start, e saturazione. Un sistema può essere veloce al 50% di carico e diventare lento al 90%. E se non dimensioni correttamente, l’esperienza utente diventa imprevedibile. Chi fa inferenza bene lavora ossessivamente su due cose: tempo al primo token e stabilità del flusso. Perché l’utente perdona una risposta lunga se vede che arriva subito e scorre. Non perdona il silenzio.

Ottimizzazione dell’inferenza: perché “fare la stessa cosa” può costare 10 volte meno

La parte più sottovalutata è che due sistemi possono produrre output simili, ma con costi radicalmente diversi. L’ottimizzazione dell’inferenza non è un dettaglio da nerd. È la differenza tra un prodotto sostenibile e un prodotto che brucia budget.

- Il concetto centrale, da raccontare bene, è che un modello non è solo “il modello”. È un insieme di scelte.

- La quantizzazione riduce precisione numerica per far stare i pesi in meno memoria e accelerare calcolo. Spesso permette di servire più richieste con lo stesso hardware.

- Il caching evita di ricalcolare parti già viste, soprattutto nei contesti ripetuti o nelle chat lunghe.

- Il batching raggruppa richieste per usare meglio la GPU, ma può aumentare la latenza se spinto male.

- Il retrieval riduce la necessità di incollare contesti enormi, perché prendi solo i documenti rilevanti.

- La distillazione crea modelli più piccoli che imitano quelli grandi, riducendo costi in produzione.

Tutto questo, spiegato senza trasformarlo in un manuale, porta a un messaggio forte: l’inferenza è ingegneria di sistema, non solo AI.

Inferenza e sovranità digitale: quando l’AI diventa infrastruttura geopolitica

L’inferenza come questione di potere industriale. Perché chi controlla l’inferenza controlla la capacità di trasformare dati in decisioni in tempo reale. E perché l’hardware che rende possibile l’inferenza su larga scala è una catena di fornitura critica: GPU, HBM, packaging avanzato, datacenter, energia. Qui l’inferenza diventa la forma più concreta della dipendenza tecnologica. Non perché “l’AI è cattiva”, ma perché se non possiedi la capacità di eseguire i modelli, finisci per comprare capacità da altri. E quando l’AI entra nei processi di impresa, sanità, industria e pubblica amministrazione, il “comprare capacità” non è una scelta neutra. È anche qui che si capisce perché edge AI cresce: non solo per latenza o privacy, ma perché riduce l’obbligo di passare sempre da un cloud esterno.

L’inferenza è la parte operativa dell’AI. È quella che incide su budget, UX, governance e rischio. È quella che trasforma un modello in un servizio e un servizio in un’infrastruttura. È quella che rende la memoria e l’hardware centrali, perché senza banda e senza VRAM non c’è magia che tenga. Ed è quella che decide se i dati restano vicino a chi li produce o se diventano traffico verso un fornitore. Il training crea il modello, l’inferenza crea il potere d’uso. E nel 2026, quasi tutto ciò che conta sta in quel “potere d’uso”.

Domande frequenti su inferenza AI

Che cos’è l’inferenza AI e in cosa si differenzia dal training?

L’inferenza AI è l’esecuzione di un modello già addestrato su un input reale per produrre un output, come una risposta testuale, una classificazione o una previsione. Il training è la fase in cui il modello apprende aggiornando i pesi; l’inferenza usa quei pesi “fissi” per calcolare risultati. In produzione, l’inferenza è spesso la parte che pesa di più perché viene eseguita continuamente, su molte richieste, e determina costi, latenza e carico hardware.

Perché l’inferenza costa così tanto quando il modello è già addestrato?

Perché ogni richiesta di inferenza richiede calcolo e soprattutto accessi intensivi a memoria per leggere pesi e attivazioni. Nei modelli linguistici, il costo cresce con i token: più lungo è l’input, più calcolo serve per elaborarlo, e più lungo è l’output, più calcolo serve per generarlo token dopo token. Se il servizio scala su molti utenti, il costo diventa una funzione diretta del volume di richieste e della lunghezza media di input/output, quindi esplode rapidamente se non viene ottimizzato.

Cosa influenza di più la latenza durante l’inferenza di un LLM?

La latenza dipende dal tempo necessario per elaborare il contesto e dal ritmo di generazione. Pesano la fase di lettura del prompt e del contesto, la velocità in token al secondo, la disponibilità di VRAM/HBM, la saturazione della GPU, la coda di richieste e la rete se l’inferenza è remota. Un sistema può essere rapido a basso carico e diventare lento quando la GPU è saturata, perché batching e code aumentano il tempo di attesa prima che inizi la generazione.

Che differenza c’è tra inferenza in cloud e inferenza on-prem o edge?

Nel cloud, l’inferenza è più semplice da scalare e integrare, ma implica spesso trasferimento dei dati e un costo variabile legato al volume di utilizzo. In on-prem, i dati restano sotto controllo e si riduce la dipendenza da provider esterni, ma servono investimenti in hardware, gestione e ottimizzazione. In edge, l’inferenza avviene sul dispositivo vicino alla sorgente dei dati, riducendo latenza e esposizione, ma richiede modelli più leggeri e un’ottimizzazione aggressiva per rispettare vincoli energetici e termici.

Perché la memoria è il collo di bottiglia più frequente nell’inferenza?

Perché un modello deve leggere continuamente i propri pesi e manipolare attivazioni e cache. Se i pesi non stanno “comodi” in memoria veloce, il sistema deve spostare dati tra livelli più lenti, aumentando la latenza e riducendo il throughput. Per questo nel datacenter contano HBM3E/HBM4 e grandi capacità di VRAM: non serve solo potenza di calcolo, serve alimentare quel calcolo con abbastanza banda di memoria per mantenerlo occupato.

Cosa significa ottimizzare l’inferenza e quali tecniche hanno l’impatto maggiore?

Ottimizzare l’inferenza significa ottenere output comparabili con meno costo, meno latenza e più richieste servite per unità di hardware. Le tecniche più incisive includono quantizzazione per ridurre memoria e accelerare calcolo, caching per evitare ricalcoli, gestione del contesto per limitare token inutili, e strategie di serving che migliorano l’utilizzo della GPU senza far esplodere le code. L’obiettivo operativo è aumentare throughput e prevedibilità mantenendo qualità, non inseguire un solo numero di benchmark.

Come si capisce se un sistema è limitato dall’inferenza oppure da altre parti della pipeline?

I segnali tipici sono latenza variabile, aumento del tempo al primo token, saturazione della GPU con utilizzo di memoria vicino al limite, e degradazione netta quando cresce la lunghezza del contesto o il numero di richieste concorrenti. Se invece la GPU è scarica ma il sistema è lento, il limite può essere rete, I/O, orchestrazione o preparazione dei dati. In pratica, quando l’inferenza è il collo di bottiglia, la relazione tra volume di token e tempo/costo tende a essere molto diretta e visibile.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.