Meta introduce Prometheus, un cluster AI su scala gigawatt progettato per sostenere la prossima generazione di modelli di intelligenza artificiale, spingendo il networking oltre i limiti tradizionali dei data center hyperscale. Il sistema interconnette decine di migliaia di GPU distribuite su più edifici e data center regionali, utilizzando una nuova architettura di rete chiamata Backend Aggregation (BAG), capace di gestire fino a 48 petabit per secondo di bandwidth inter-regionale. L’obiettivo non è solo aumentare la potenza di calcolo, ma rendere il training AI realmente distribuito e resiliente su scala geografica.

Prometheus non è un singolo supercomputer, ma un’infrastruttura multi-campus, progettata per operare come un unico cluster logico anche quando il compute è fisicamente separato. È una risposta diretta ai limiti energetici, spaziali e termici dei data center monolitici, e segna una svolta nel modo in cui Meta concepisce la scalabilità dell’AI.

Backend Aggregation, la super spine che unisce regioni e backbone

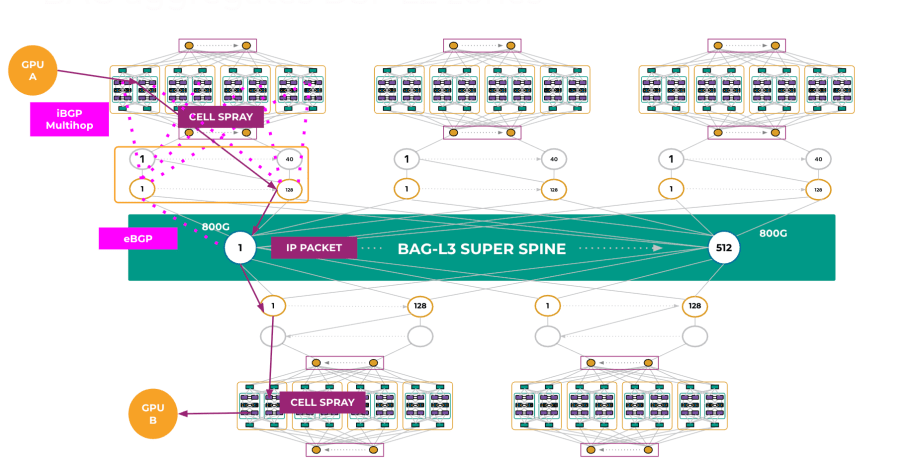

Il cuore tecnologico di Prometheus è BAG, una super spine Ethernet centralizzata che funge da livello di aggregazione tra reti regionali e backbone. A differenza delle spine tradizionali, BAG non si limita a un singolo data center, ma collega fabric distribuiti su un’intera regione, mantenendo visibilità end-to-end su flussi di traffico AI estremamente sensibili a latenza e perdita di pacchetti.

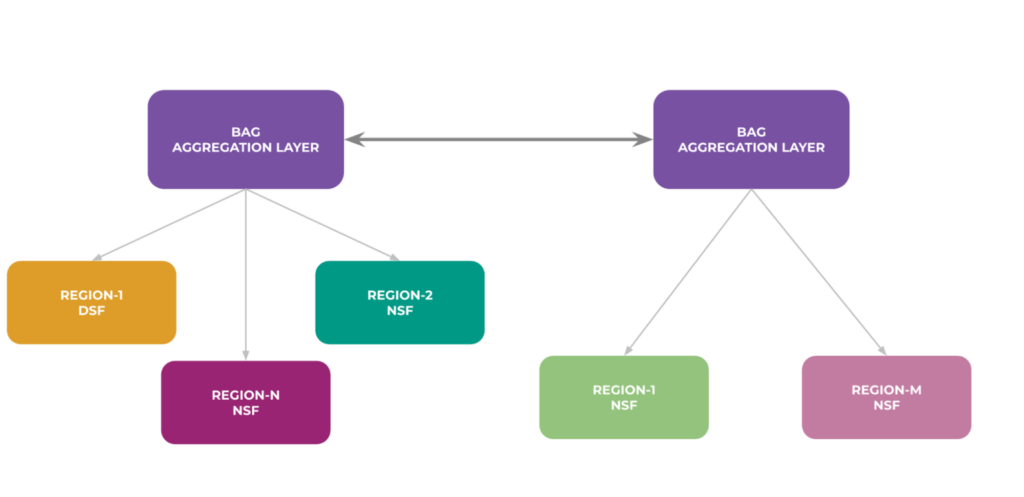

Utilizziamo l’aggregazione backend (BAG) per interconnettere le regioni dei data center e condividere risorse di elaborazione e di altro tipo in cluster di grandi dimensioni.

Meta progetta BAG per supportare topologie planari o spread, aumentando la diversità dei percorsi e la resilienza ai guasti. In un cluster che può estendersi per chilometri, la probabilità di fault simultanei cresce in modo non lineare. La scelta architetturale punta quindi a limitare failure domain, evitando che un singolo evento comprometta interi job di training che possono durare giorni o settimane.

Distribuzione a layer regionali e oversubscription controllata

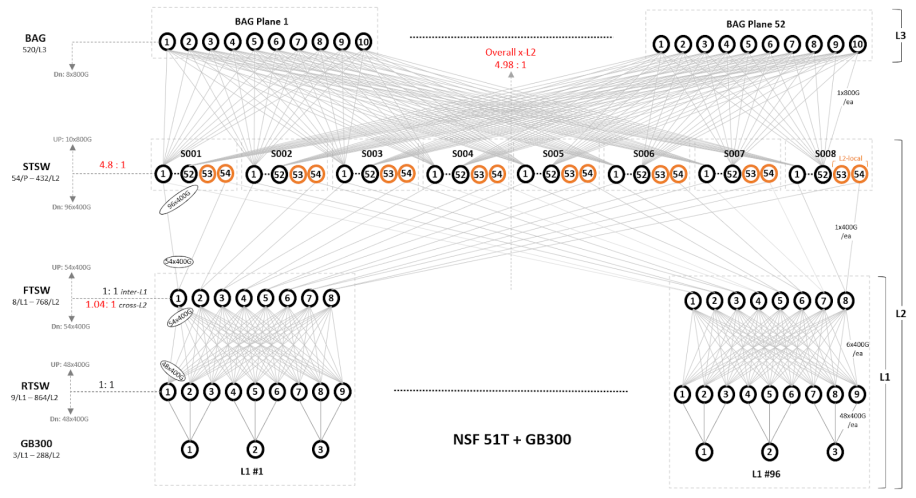

Prometheus distribuisce BAG in layer regionali, ciascuno responsabile di subset specifici del fabric Layer 2, con un rapporto di oversubscription intorno a 4,5:1. Questa scelta riflette un compromesso deliberato: massimizzare l’efficienza del capitale senza introdurre congestioni ingestibili durante i picchi di traffico tipici del training AI sincrono.

Un esempio di topologia di rete inter-BAG.

Il design tiene conto del fatto che non tutte le GPU comunicano sempre con la stessa intensità, ma che durante alcune fasi del training i pattern di traffico diventano estremamente bursty. La presenza di un layer di aggregazione consente a Meta di assorbire questi burst senza degradare le prestazioni complessive del cluster.

Switch deep-buffer e protocolli lossless per le lunghe distanze

Uno dei problemi più complessi del networking AI su larga scala è la distanza fisica. Prometheus affronta il tema utilizzando switch con buffer profondi sulle connessioni più lunghe, capaci di supportare protocolli lossless come Priority Flow Control (PFC). Questo approccio riduce drasticamente la probabilità di packet loss, che nei workload AI può tradursi in stall dell’intero job di training.

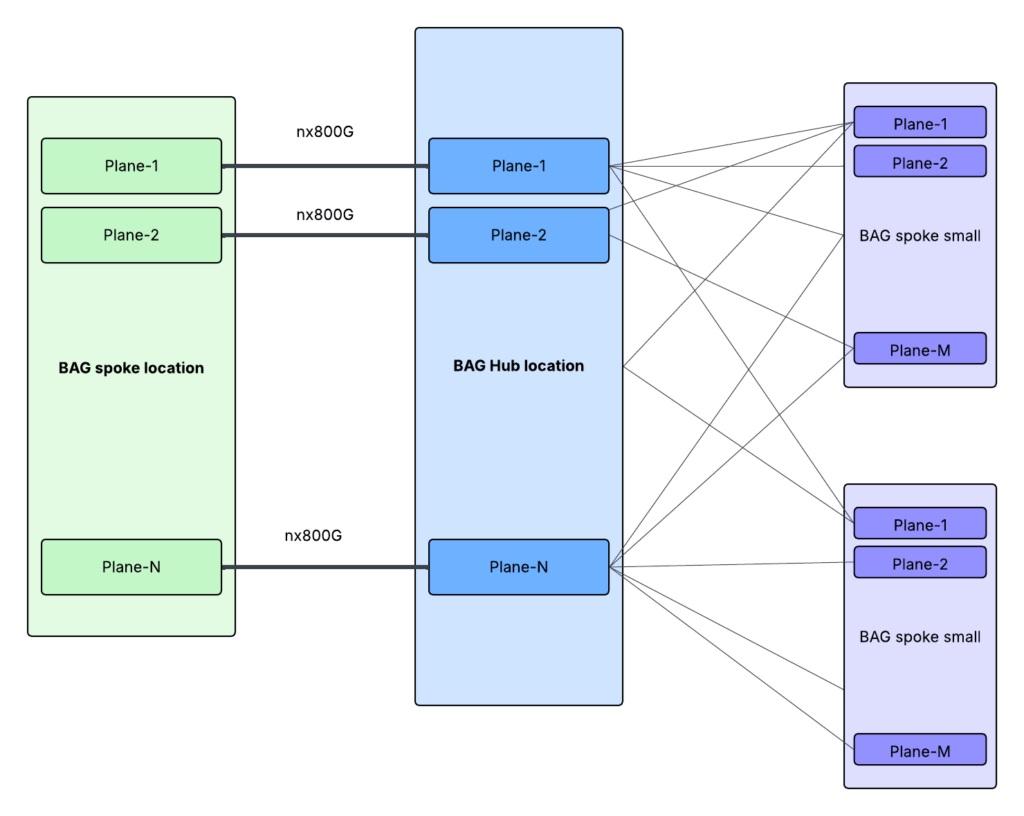

Una connessione BAG tra edifici per la struttura DSF su cinque data center.

Al contrario, nelle zone di edge L2, dove la latenza è minima e i percorsi sono brevi, Meta utilizza switch shallow-buffer, ottimizzati per velocità e densità. La combinazione di buffer profondi e superficiali non è casuale, ma risponde a una logica di ottimizzazione differenziale: buffer dove servono davvero, leggerezza dove è possibile.

Chassis modulari e ASIC Jericho3

Sul piano hardware, BAG sfrutta chassis modulari basati su ASIC Jericho3, in grado di offrire fino a 432 porte a 800 Gbps per singolo sistema. Questa densità è fondamentale per ridurre il numero di hop, semplificare il cablaggio e mantenere latenze prevedibili anche in configurazioni estremamente estese.

Un collegamento tra edifici BAG per tessuto NSF.

La scelta di Jericho3 non è neutra: questi ASIC sono progettati per scenari di routing ad altissima scala, con supporto avanzato per telemetria, QoS e gestione del traffico, elementi indispensabili in un cluster che opera a livelli di throughput petabit.

Integrazione tra DSF e NSF nel fabric AI

BAG non sostituisce i fabric esistenti, ma li integra. Nel caso del Distributed Spine Fabric (DSF), BAG si collega tramite backend edge pod, mentre per il Network Spine Fabric (NSF) si connette direttamente agli spine training switches. Questo consente a Meta di unificare ambienti di training differenti sotto un’unica architettura di aggregazione, riducendo frammentazioni operative. Il risultato è una rete che può adattarsi a diversi pattern di carico, mantenendo coerenza architetturale anche mentre il cluster cresce o viene riconfigurato.

Routing, sicurezza e resilienza operativa

Il routing di Prometheus utilizza eBGP con UCMP (Unequal Cost Multi-Path), permettendo un bilanciamento del carico sofisticato e una gestione più fine dei guasti. A questo si aggiunge MACsec, utilizzato per garantire sicurezza a livello di link, un requisito sempre più critico in infrastrutture distribuite su più siti fisici. Per evitare fenomeni di blackholing in caso di failure parziali, Meta implementa port striping, aggregazione condizionale delle route e un’analisi continua dei failure domain. L’obiettivo non è eliminare i guasti, ma impedire che un guasto locale si propaghi a livello di cluster.

Un gigawatt di capacità per l’AI di nuova generazione

Una volta completato, Prometheus fornirà circa 1 gigawatt di capacità, posizionandosi tra le infrastrutture AI più energivore mai realizzate. Questa scala non è fine a sé stessa: Meta la considera necessaria per sostenere modelli sempre più grandi, con parametri che crescono più rapidamente dell’efficienza per watt delle singole GPU. Il cluster è progettato per supportare prodotti e servizi AI su scala globale, dalle esperienze consumer all’addestramento di modelli fondamentali. In questo senso, Prometheus non è un progetto isolato, ma un pilastro strategico per l’evoluzione dell’ecosistema AI di Meta.

Un nuovo paradigma per i data center AI

Prometheus rappresenta un’evoluzione netta rispetto ai data center tradizionali: compute distribuito, networking centralizzato e resiliente, scalabilità regionale. Meta dimostra che, oltre una certa soglia, la sfida dell’AI non è più solo il numero di GPU, ma la capacità di farle comunicare in modo affidabile, sicuro e prevedibile su distanze sempre maggiori. In un’epoca in cui i modelli AI spingono verso infrastrutture petabit e consumi gigawatt, BAG e Prometheus segnano una direzione chiara: il futuro dell’AI hyperscale passa da reti progettate come sistemi critici, non come semplici collegamenti tra server.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.