Google Cloud porta sul tavolo un aggiornamento che vale più per ciò che lascia intendere che per l’elenco delle feature. Il messaggio, letto nel suo insieme, è che l’AI non resta più un “livello applicativo” da aggiungere a posteriori, ma diventa un componente che sposta il perimetro della sicurezza, cambia la postura difensiva e ridefinisce i tempi di reazione. Da un lato, il Threat Intelligence Group descrive attori statali che usano modelli generativi per accelerare fasi operative concrete, dalla ricognizione alla produzione di esche e kit di phishing, fino alla sperimentazione su vulnerabilità e allo sviluppo di tooling. Dall’altro, la stessa piattaforma propone strumenti e guide per rendere più “industriale” l’adozione dei modelli, dal fine-tuning su Vertex AI e GKE alla riduzione della latenza con un Inference Gateway che promette tagli misurabili sul tempo di risposta.

Il punto che interessa davvero, però, non è il singolo annuncio. È la convergenza tra tre esigenze che di solito vivono separate: difesa contro abusi e extraction, resilienza operativa e regolatoria (soprattutto nel finanziario), e messa in produzione di modelli e agenti con observability e networking coerenti anche in ambienti isolati. Google prova a cucire questi pezzi in un’unica narrazione tecnica: l’AI può essere un acceleratore per chi attacca, ma anche un acceleratore per chi difende, a patto di trattarla come infrastruttura, con policy, telemetria, controlli sugli accessi, e meccanismi di contenimento che funzionano quando i modelli diventano bersaglio.

Quello che emerge è una mappa operativa: chi gestisce organizzazioni pubbliche e private, chi lavora sulla base industriale della difesa, chi opera in ambito regolato, e chi fa MLOps su larga scala, si trova davanti a un cambio di priorità. Non basta più chiedersi “cosa può fare il modello”. Serve capire cosa può fare un attaccante con il modello, cosa può rubare dal modello, come può avvelenare l’interazione con prompt injection, come può scalare le attività con API e automazioni, e come difendersi senza bloccare il business.

Abusi AI nelle operazioni adversarial: la produttività diventa un’arma

Nella lettura proposta dal Threat Intelligence Group, l’AI entra nelle campagne non come “magia” ma come moltiplicatore di produttività. La ricognizione diventa più rapida perché i modelli sintetizzano OSINT, costruiscono profili, riducono il costo cognitivo della raccolta e della correlazione. L’ingegneria sociale diventa più efficace perché l’output può essere localizzato, adattato, riscritto, testato e iterato con una velocità che cambia il rapporto tra tentativi e successo. L’attacco non diventa automaticamente più sofisticato, ma diventa più scalabile.

È qui che la distinzione fra attori “capaci” e attori “industriali” si assottiglia. L’AI permette di portare a un livello semi-automatizzato la produzione di contenuti, pretesti, messaggi e materiali di contorno. Nella catena tradizionale, la creazione di esche credibili era un collo di bottiglia perché richiedeva tempo, lingua, contesto, e spesso competenze culturali. Ora quel collo di bottiglia si riduce. E quando un collo di bottiglia si riduce, aumentano le campagne parallele, aumentano le varianti, aumenta la probabilità che qualcuno cada.

Dentro questo quadro compaiono casi e nomi che Google associa a pratiche specifiche. Si parla, per esempio, di gruppi che usano modelli per analizzare vulnerabilità, per generare kit di phishing, per creare lures più credibili, per raffinare traduzioni e per impersonare ruoli lavorativi. Il dato operativo non è tanto “il gruppo X usa Gemini”, quanto la direzione: l’AI diventa parte della pipeline, e la pipeline è ciò che rende un’operazione ripetibile.

Qui si innesta la raccomandazione più concreta: se l’attaccante usa l’AI soprattutto via API e automazioni, la difesa deve spostarsi su monitoraggio degli accessi, pattern di utilizzo e anomalie, non solo su contenuto. In altre parole, la difesa moderna deve leggere il traffico AI come legge il traffico applicativo: rate, burst, distribuzione linguistica, ripetizione di prompt, tentativi di estrazione, comportamento di sessione, e correlazione con identità e contesto.

Un punto che torna è quello dell’estrazione e della distillazione. Gli avversari tentano di ottenere valore non soltanto dai contenuti generati, ma dal modello stesso, provando a “tirare fuori” conoscenza o a costruire student model. La difesa qui non coincide con il semplice rifiuto di richieste malevole, perché molte richieste possono essere “innocue” prese singolarmente e dannose se sommate. Per questo Google parla di rilevamento in tempo reale e degradazione delle prestazioni del modello student quando identifica pattern di estrazione. È un modo per dire che la protezione del modello non è solo policy, è anche controllo dinamico.

Minacce alla base industriale della difesa: l’HR e gli edge device diventano il varco

Un passaggio che merita attenzione è la focalizzazione sulla base industriale della difesa. La fotografia che emerge è una combinazione di tattiche note e nuove pressioni: exploitation di edge device, supply chain come vettore, campagne di phishing costruite su offerte di lavoro e processi HR, infiltrazioni e tentativi di raccolta credenziali. In questo scenario l’AI entra come strumento per rendere più credibili le interazioni e per aumentare la capacità di costruire pretesti realistici. Il segnale più importante è che l’HR non è più “solo” un bersaglio per ottenere accesso iniziale. Diventa un bersaglio per colpire persone e processi che hanno autorizzazioni, visibilità, e accesso a strumenti interni. Dove si gestiscono curriculum, job posting, contratti e identità, si gestisce anche la porta d’ingresso. Qui l’AI rende più facile costruire finte conversazioni, finte catene email, finte procedure di onboarding, e perfino finte sessioni di supporto tecnico. Parallelamente, l’edge rimane un acceleratore per l’intrusione perché vive spesso in un territorio di patching incompleto, esposizione pubblica e complessità di gestione. E quando un attore ha sia una componente di social engineering potenziata dall’AI sia una componente di exploitation edge, la campagna diventa ibrida: si entra dove è più facile, e si usa l’altro canale per consolidare o muoversi lateralmente. La raccomandazione “politica” di Google, in questi casi, è una postura: integrare threat intelligence nel threat hunting, aumentare la visibilità su canali HR e su flussi di autenticazione, ridurre l’attrito nel patching degli edge, rafforzare la detection sui comportamenti, non solo sugli indicatori statici. Tradotto in pratica, significa che l’HR deve essere trattato come un asset critico, non come un reparto amministrativo. E significa che l’osservabilità di base, log, e audit trail non sono accessori, ma parte del perimetro difensivo.

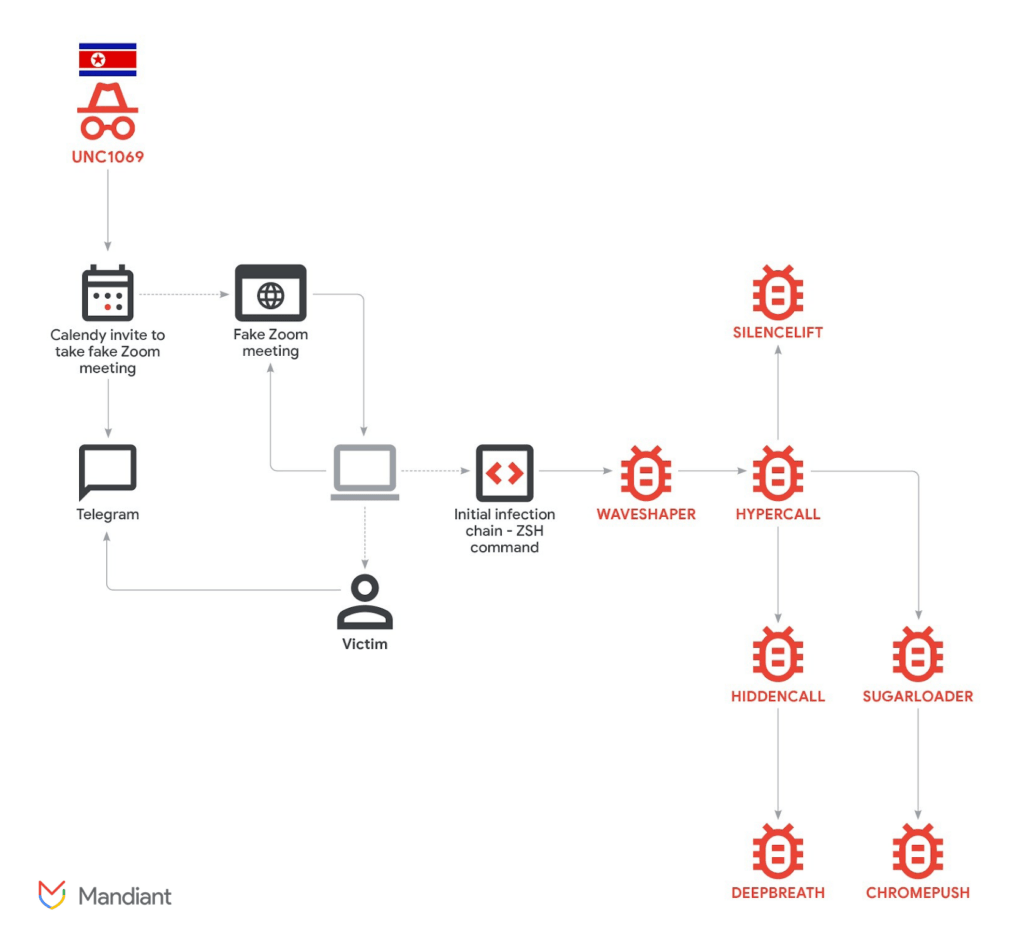

UNC1069 e il crypto theft: quando la social engineering diventa una catena industriale

Nel panorama descritto, il caso UNC1069 nel settore crypto è un esempio di come l’AI venga usata per aumentare la resa delle campagne di ingegneria sociale. Qui l’obiettivo non è solo rubare credenziali, ma rubare session token, accessi a wallet, e dati che permettono frodi e movimenti rapidi. La dinamica tipica è la costruzione di fiducia, l’aggancio tramite canali compromessi, e poi l’innesco di una sequenza che porta la vittima a eseguire azioni non verificate.

Il meccanismo è importante perché richiama un pattern contemporaneo: non serve più convincere la vittima a scaricare un file chiaramente sospetto, basta convincerla a “sistemare un problema” seguendo istruzioni, spesso sotto pressione, spesso durante una call. E l’AI aiuta a rendere quella call più realistica, più fluida, più credibile. In questo senso, l’AI non è l’exploit, è il collante che rende l’exploit più probabile. Le contromisure suggerite, lette in modo concreto, insistono su due cose: validazione dei link e dei flussi di meeting, e protezioni comportamentali lato endpoint, perché quando la vittima esegue comandi, l’indicatore non è più il file malevolo ma l’azione anomala. È un cambio che pesa: se l’utente diventa parte della catena di esecuzione, la difesa deve essere progettata per interrompere azioni oltre che bloccare oggetti.

Secure AI framework e governance: la risposta non è “vietare”, è ridurre superficie e impatto

In mezzo a questi scenari, la risposta che Google prova a consolidare è il SAIF, cioè un modo per portare nella sicurezza dei sistemi AI la disciplina che la sicurezza applicativa ha costruito in anni: threat modeling, hardening, monitoraggio, red teaming, e guardrail. Il messaggio è che l’AI va trattata come un sistema che può essere abusato, compromesso, estratto, manipolato, e che quindi deve avere difese specifiche. Il punto che interessa alle organizzazioni è pragmatico: la maggior parte degli incidenti legati all’AI in contesti enterprise non nasce da un “modello cattivo”, ma da integrazioni sbagliate, permessi troppo larghi, logging insufficiente, e promesse di produttività non accompagnate da controlli. Quindi l’obiettivo diventa ridurre superficie e impatto. Limitare e segmentare gli accessi API, definire policy per input e output, verificare e filtrare prompt e tool invocation quando si introducono agenti, e progettare fallback e degradazione controllata quando il sistema rileva abuso. Qui torna una parola chiave: monitoraggio API. In un mondo dove l’AI è consumata via chiamate e dove l’attaccante può generare traffico come un client, l’osservabilità sull’uso reale diventa più importante dell’elenco delle policy. Una policy non osservata è un’ipotesi. Un pattern di abuso osservato è un incidente evitato.

Resilienza finanziaria e DORA: l’AI come strumento per simulare crisi realistiche

Un altro blocco dell’aggiornamento riguarda il settore finanziario e la resilienza operativa. Qui il tema non è “AI contro gli attaccanti”, ma AI per prepararsi all’interruzione, in un contesto dove DORA impone disciplina e dove la narrativa dei tabletop tradizionali rischia di rimanere astratta. L’idea proposta è usare modellazione di scenari con AI context-aware per costruire simulazioni più vicine alla realtà di produzione, includendo timeline, dipendenze, metriche e impatti comunicativi, non solo tecnici. Questa proposta ha un pregio e un rischio. Il pregio è che costringe le organizzazioni a vedere le fragilità reali: runbook incompleti, failover che “esiste sulla carta”, comunicazioni cross-funzionali lente, e gap tra IT e funzioni di business. Il rischio è credere che l’AI “sostituisca” la preparazione. In realtà, qui l’AI funziona come generatore di scenario, non come garante di verità. Serve a mettere pressione su processi e architetture, non a certificare compliance. Nella pratica, la parte importante è la direzione: se gli outage e i disruption hanno impatti rapidi, l’organizzazione deve passare da scenari generici a scenari che riflettono architettura reale e dipendenze reali. E questa direzione spinge verso un concetto che si ripete in tutto l’aggiornamento: contestualizzare. Contestualizzare minacce, contestualizzare resilienza, contestualizzare deployment.

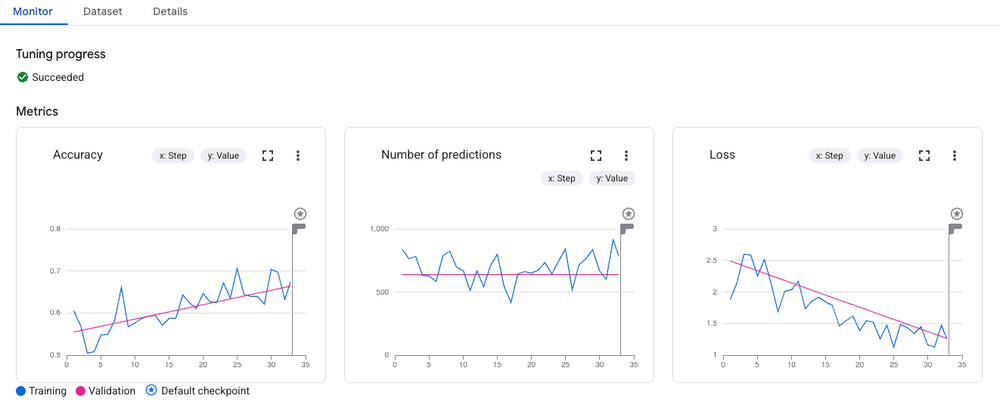

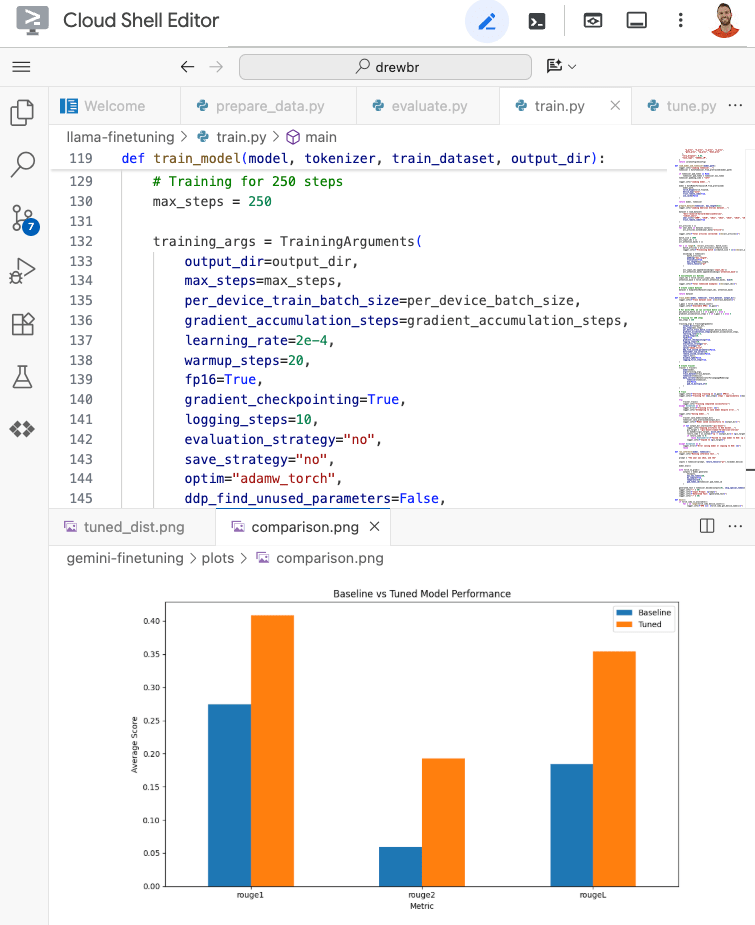

Fine-tuning su Vertex AI e GKE: specializzare modelli senza perdere controllo

Accanto alla minaccia, Google spinge anche l’adozione. Le guide sul fine-tuning raccontano un percorso tipico: partire da modelli generalisti come Gemini o da open model, curare dataset, stabilire baseline, e poi specializzare tramite SFT o tecniche come LoRA. La promessa è ridurre allucinazioni, aumentare coerenza, e ottenere un modello più utile per un dominio specifico con costi e latenza controllabili.

Qui la scelta fra Vertex AI e GKE diventa una scelta di governance e operatività. Vertex AI offre un flusso managed che riduce complessità e accelera iterazioni. GKE offre una piattaforma più “vicina al ferro” e più flessibile per chi vuole gestire open model, pipeline personalizzate, e requisiti specifici di sicurezza e isolamento. In entrambi i casi, il punto non è soltanto addestrare, ma validare. Senza un confronto serio tra baseline e tuned, e senza metriche adatte al dominio, il fine-tuning diventa una forma di bias che migliora stile ma non sostanza.

Qui torna utile l’idea che l’AI è sistema. Se un modello viene specializzato, allora cambia anche il modo in cui viene attaccato: cambia la superficie di prompt injection, cambia la probabilità che generi output pericolosi in contesti specifici, cambia la sensibilità ai dati di training, e quindi cambia la policy che lo governa. Il fine-tuning non è solo performance, è anche responsabilità.

Takeaway tecnici da Gemini: la disciplina del prompt come ingegneria, non come magia

Dentro le note operative compare un set di takeaway che, letti bene, suonano come una correzione culturale. Gemini, quando usato per codice e sistemi scalabili, funziona meglio se l’utente spezza il problema, definisce vincoli, e fornisce contesto specifico. La parte interessante è che Google spinge verso un uso più ingegneristico dei modelli: decomposizione in snippet, prompt che impongono formati e regole, automazioni deterministiche per pezzi ripetitivi, e test in ambiente reale.

È una forma di “MLOps mentale”: invece di chiedere al modello di essere infallibile, si progettano processi che riducono allucinazioni e aumentano verificabilità. E in un contesto enterprise, dove il codice finisce in produzione, questa disciplina è un confine di sicurezza. Un modello che genera codice non testato non è un acceleratore, è una fonte di debito tecnico e vulnerabilità.

GDC air-gapped 1.15: quando l’AI deve vivere in ambienti isolati

Un altro elemento tecnico riguarda GDC air-gapped 1.15 e il networking. Qui il tema è cruciale per enti pubblici, difesa, e infrastrutture critiche: l’AI e i workload cloud-native devono funzionare anche dove la connettività è controllata o dove l’ambiente è isolato. Miglioramenti come Cloud NAT, health checks e policy di networking rendono più gestibile la vita di cluster in condizioni “non ideali”. La cosa importante non è il dettaglio del componente, è la traiettoria: l’AI enterprise non vive solo in ambienti con internet pieno e managed services ovunque. Vive anche dove l’isolamento è requisito e dove l’operatività deve essere mantenuta senza perdere visibilità. E qui l’osservabilità, le policy di rete e la pianificazione IP diventano parte del progetto, non un’aggiunta.

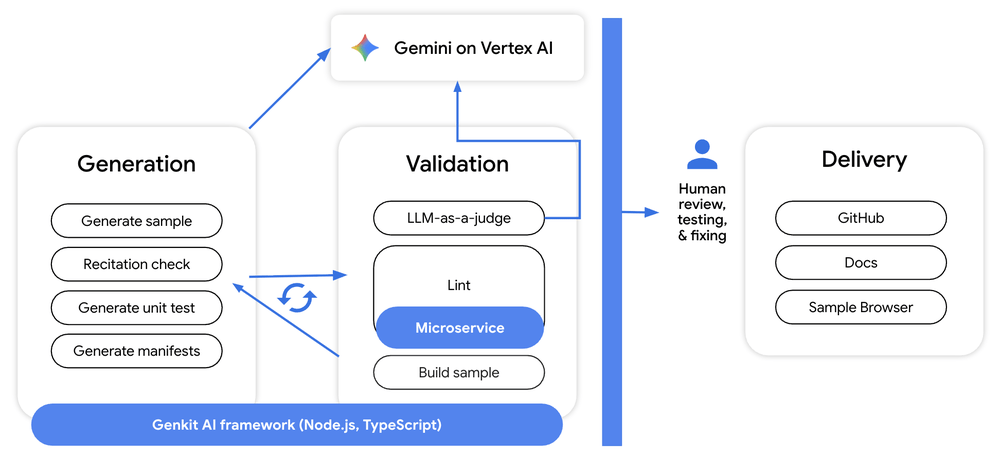

GEAR: agenti AI enterprise e il problema reale dell’orchestrazione

Il programma GEAR, descritto come Gemini Enterprise Agent Ready, è la formalizzazione di un trend: l’enterprise non vuole solo chatbot, vuole agenti che pianificano e agiscono, cioè che integrano ragionamento, tool invocation e workflow. Ma l’agente, per definizione, amplia la superficie di rischio, perché collega un modello a strumenti che possono fare cose, leggere dati, scrivere ticket, muovere pipeline, modificare risorse.

Quindi la domanda che conta non è “come costruire un agente”, ma “come costruire un agente senza trasformarlo in un moltiplicatore di incidenti”. Qui le parole chiave diventano identità, autorizzazione, audit, e policy per le azioni. Se l’agente può fare, allora deve essere limitato a ciò che serve, tracciato in ciò che fa, e verificabile quando sbaglia.

OTLP e osservabilità: l’AI entra nel monitoring come workload standard

L’integrazione OTLP e OpenTelemetry in Cloud Monitoring è un tassello che sembra secondario ma non lo è. Se l’AI diventa infrastruttura, deve diventare osservabile con standard e pipeline coerenti. Metriche, log e trace devono essere raccolti, correlati, e interrogabili, perché senza telemetria l’AI è una scatola nera. E una scatola nera, quando la colleghi a processi critici, è un rischio operativo. Qui la direzione è chiara: ridurre frizioni tra osservabilità cloud-native e workload AI, permettere invio di metriche con overhead controllato, e portare agenti e inference sotto lo stesso ombrello di monitoring che si usa per microservizi e infrastruttura.

GKE Inference Gateway: ridurre latenza e costi, ma soprattutto controllare la coda

Il blocco sul GKE Inference Gateway è quello più immediatamente “vendibile”: riduzioni di latenza e miglioramenti misurabili sul tempo al primo token. Ma la questione di fondo è un’altra: l’inferenza su larga scala non è solo performance media, è controllo della coda, gestione dei burst, e stabilità della tail latency. Se una piattaforma promette riduzioni del 35-52% su TTFT in scenari di produzione, sta dicendo che investe su routing load-aware, su cache di contesto, e su meccanismi di admission control che proteggono la stabilità. In un contesto dove l’AI entra in processi reali, la latenza non è un dettaglio UX, è un parametro di affidabilità. Se un agente deve prendere decisioni entro un tempo, se un workflow deve chiudere una finestra operativa, la tail latency diventa un rischio. E qui l’inferenza gateway si propone come strato di controllo, non solo come acceleratore.

Cosa resta a chi gestisce organizzazioni: la checklist non scritta

Messo insieme, l’aggiornamento di Google Cloud racconta una transizione. L’AI viene trattata come infrastruttura e come bersaglio, e quindi richiede una postura simile a quella dei sistemi critici: policy, telemetria, resilienza, controllo degli accessi, test realistici e guardrail. La stessa piattaforma che offre fine-tuning e agenti propone anche detection su abusi, mitigazioni contro extraction e framework per secure AI. È un tentativo di chiudere il cerchio: se spingi l’adozione, devi anche rendere sostenibile la difesa. Per le organizzazioni pubbliche e private, la conseguenza è pratica. Il rischio non è solo che l’AI venga usata contro di loro. Il rischio è che loro stessi la mettano in produzione senza trattarla come sistema, e quindi senza log, senza policy, senza controlli sulle API, e senza esercizi di resilienza che somigliano alla realtà. In quel caso l’AI diventa un acceleratore di debolezze già presenti.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.