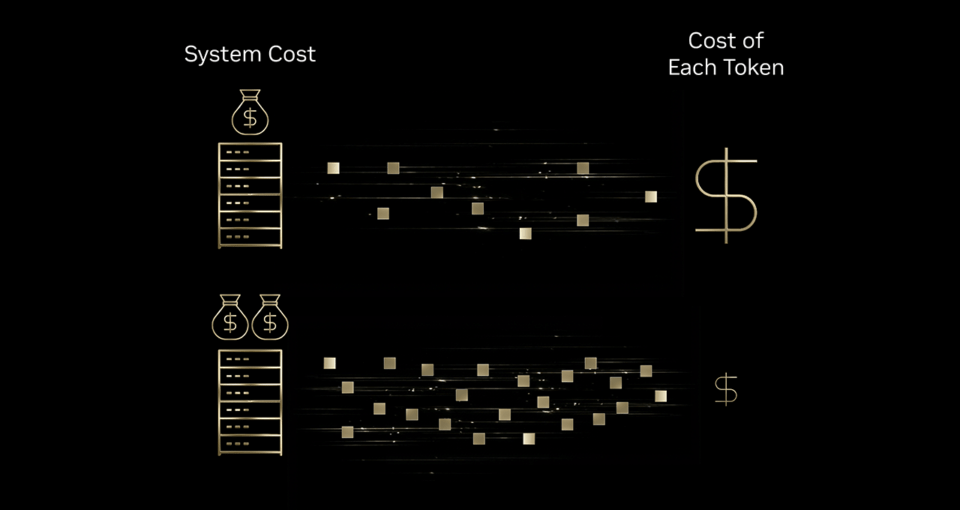

Nvidia cambia l’equazione economica dell’intelligenza artificiale con la piattaforma Blackwell, dichiarando riduzioni fino a 10 volte nei costi per token rispetto alla generazione precedente Hopper. L’impatto non è solo incrementale: si tratta di una trasformazione strutturale dell’inferenza AI, resa possibile da un codisegno estremo tra hardware, networking e software. La dinamica è chiara: più investimenti in infrastruttura generano output di token superiori alla crescita dei costi, creando un moltiplicatore di produttività. Fornitori come Baseten, DeepInfra, Fireworks AI e Together AI stanno già sfruttando Blackwell per ottimizzare stack e servizi su scala industriale.

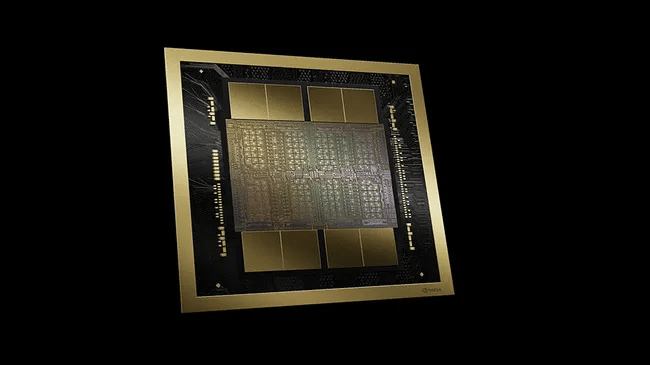

Blackwell: co-design estremo e inferenza a bassa precisione

La piattaforma Blackwell integra GPU di nuova generazione con ottimizzazioni profonde nello stack di inferenza. Il sistema GB200 NVL72 consente riduzioni fino a 10x nei costi per token su modelli mixture-of-experts (MoE) rispetto a Hopper, aumentando throughput ed efficienza energetica. Tra le innovazioni chiave emerge il formato NVFP4, che abilita inferenza a bassa precisione mantenendo accuratezza di frontiera. La libreria TensorRT-LLM ottimizza pipeline di generazione, mentre il framework Dynamo accelera l’esecuzione dinamica. La decodifica speculativa rappresenta un altro elemento strategico: modelli più piccoli generano risposte preliminari che vengono verificate in background da modelli più grandi. Questo approccio riduce latenze e costi computazionali, senza sacrificare qualità. La cache di elementi conversazionali ripetuti e la scalabilità automatica completano l’architettura, consentendo gestione efficiente dei picchi di traffico.

Modelli open-source e intelligenza di frontiera

Blackwell spinge l’adozione di modelli open-source di grandi dimensioni, come gpt-oss-120b e MoE su larga scala, capaci di raggiungere livelli di intelligenza comparabili a soluzioni closed-source. Secondo analisi del MIT, le combinazioni di efficienza algoritmica e infrastrutturale stanno producendo riduzioni annuali dei costi fino a 10 volte per performance di frontiera. Il passaggio da modelli proprietari a open-source su Blackwell consente in alcuni casi un taglio dei costi del 90%. La strategia riduce barriere economiche, democratizza l’accesso e favorisce l’espansione di applicazioni AI in settori tradizionalmente sensibili ai costi.

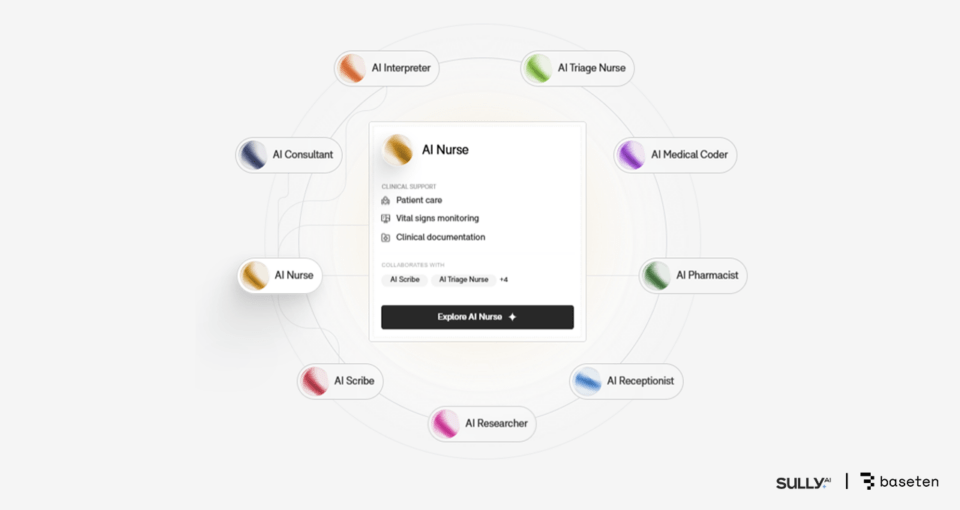

Sanità: Baseten e Sully.ai riducono costi del 90%

Baseten utilizza Blackwell per ospitare modelli open-source in ambito sanitario, collaborando con Sully.ai per l’automazione delle note cliniche. L’adozione della Model API su GPU Blackwell ha prodotto una riduzione del 90% nei costi di inferenza rispetto a modelli closed-source.

Il throughput per euro risulta 2,5 volte superiore rispetto a Hopper, mentre i tempi di risposta migliorano del 65%. Sully.ai consente ai medici di recuperare milioni di minuti di lavoro, trasformando efficienza operativa in impatto concreto sul sistema sanitario.

Gaming interattivo: DeepInfra abbatte il costo per milione di token

DeepInfra utilizza Blackwell per supportare Latitude nelle piattaforme AI Dungeon e Voyage. Il costo per milione di token scende da 0,183 euro a 0,092 euro, fino a 0,046 euro con NVFP4, per un miglioramento complessivo fino a 4x.

L’accuratezza rimane invariata, mentre la gestione dei picchi di traffico garantisce esperienze fluide. L’inferenza a bassa latenza consente narrazioni dinamiche in tempo reale, trasformando il gaming generativo in un servizio scalabile.

Chat agentiche: Fireworks AI migliora costi del 25-50%

Fireworks AI potenzia Sentient Foundation con workflow multi-agente su Blackwell. Il risultato è un miglioramento dei costi del 25-50% rispetto a Hopper, con throughput superiore per GPU.

Sentient Chat ha gestito 1,8 milioni di utenti in 24 ore, mantenendo latenze contenute e qualità elevata. L’architettura multi-agente dimostra che l’inferenza efficiente è la chiave per servizi conversazionali su scala massiva.

Assistenza clienti: Together AI e Decagon sotto i 400 millisecondi

Together AI supporta Decagon nello sviluppo di agenti vocali enterprise. Le risposte scendono sotto i 400 millisecondi, con una riduzione dei costi fino a 6x rispetto a modelli proprietari. La combinazione tra modelli open-source, decodifica speculativa e cache intelligente consente gestione di migliaia di token per query, mantenendo efficienza e stabilità.

Verso Rubin: il prossimo salto 10x

Nvidia anticipa la piattaforma Rubin, che integrerà sei nuovi chip in un supercomputer AI progettato per offrire 10x performance rispetto a Blackwell e costi per token ulteriormente inferiori.

Blackwell rappresenta quindi un ponte: un’infrastruttura che ha già trasformato l’economia dell’inferenza e che prepara il terreno per un’ulteriore compressione dei costi.

Un cambio strutturale nell’economia dell’AI

La riduzione dei costi per token fino a 10x non è solo un miglioramento tecnico, ma un cambio strutturale nell’economia dell’intelligenza artificiale. Con hardware ottimizzato, inferenza a bassa precisione e modelli open-source di frontiera, Nvidia ridefinisce la sostenibilità economica dell’AI su larga scala. Sanità, gaming, chat agentiche e assistenza clienti mostrano che l’efficienza non è più un obiettivo teorico, ma un vantaggio competitivo immediato. Blackwell consolida Nvidia come riferimento nell’inferenza AI, mentre Rubin promette di spingere ancora più in basso la soglia economica di accesso all’intelligenza artificiale avanzata.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.