Persona finisce al centro di un caso che intreccia verifica dell’età, riconoscimento facciale e antiriciclaggio. Tre hacktivisti hanno individuato 2.456 file accessibili pubblicamente su un frontend collegato al servizio, scoprendo un perimetro di funzioni che va oltre l’age-gating adottato da Discord. Nel codice emergono 269 controlli di verifica, integrazioni con Chainalysis e TRM Labs, interfacce per SAR verso autorità federali e una distribuzione parallela autorizzata FedRAMP. La piattaforma, valutata 2 miliardi di euro e sostenuta da investitori come Peter Thiel, fornisce soluzioni KYC/AML a clienti tra cui OpenAI, Roblox, Heritage Bank e Lime. Dopo la scoperta, Discord ha annunciato il ritiro del servizio.

Persona e il frontend esposto: cosa rivelano i 2.456 file

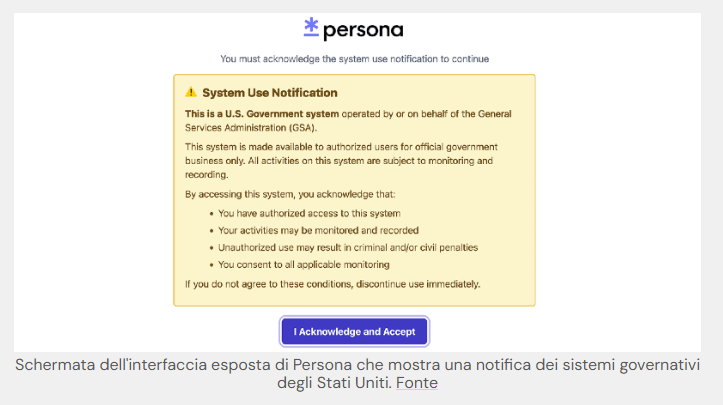

L’accesso al frontend ha mostrato un’architettura orientata alla compartimentazione dei dati, con un dominio parallelo autorizzato FedRAMP, il programma federale nato nel 2011 per standardizzare la sicurezza dei servizi cloud governativi. L’isolamento infrastrutturale, separato da sistemi condivisi e protezioni tipiche come Cloudflare, suggerisce requisiti di compliance elevati e una gestione dedicata di PII e biometrie. Tra i file analizzati compaiono funzioni di analytics comportamentale in tempo reale, tracciamento di clic e caricamenti pagina su ambienti governativi, oltre a moduli per verifiche finanziarie. Un endpoint denominato openai-watchlistdb.withpersona.com interroga verifiche associate a database interni, ampliando l’uso da semplici confronti con liste federali a possibili watchlist proprietarie. Non emergono flussi diretti di PII verso terzi nel codice osservato, ma la presenza di componenti di copilot AI per assistere la revisione di report solleva interrogativi sull’accesso contestuale ai dati sensibili.

Le 269 verifiche: biometria, sanzioni e punteggi di rischio

Il motore esegue 269 controlli distinti. Sul piano biometrico confronta selfie con liste di soggetti politicamente esposti e categorie di media avversi che includono terrorismo e spionaggio, genera punteggi di similarità e risk score, analizza incoerenze di età e rileva sfondi simili o pose ripetute riconducibili a precedenti immagini nel database. Il sistema conserva per tre anni dati come IP, fingerprint del browser e del device, numeri di documento governativo, telefono, nome, volto e metadati del contesto fotografico.

Sul versante finanziario integra screening su liste sanzioni e analisi di attività crypto tramite Chainalysis e TRM Labs, con interfacce per l’invio di Suspicious Activity Report (SAR) a agenzie di Stati Uniti e Canada. La convergenza tra riconoscimento facciale e AML crea una matrice di valutazione che, se imprecisa, può tradursi in de-banking o limitazioni di servizio. Errori nella stima dell’età o nella similarità facciale hanno già mostrato impatti concreti in altri contesti, alimentando il dibattito su bias e discriminazione.

FedRAMP, ONYX e l’ombra delle piattaforme di sorveglianza

La distribuzione parallela autorizzata FedRAMP indica possibili usi governativi. Alcuni riferimenti tecnici menzionano un deployment denominato ONYX. La coincidenza nominale richiama Fivecast ONYX, piattaforma di sorveglianza open source acquistata da ICE con un contratto da 3,85 milioni di euro nel 2023, capace di aggregare contenuti da oltre 300 piattaforme e 28 miliardi di punti dati per costruire profili digitali e punteggi di rischio. Non risultano collegamenti contrattuali diretti con Persona, ma l’ecosistema di strumenti KYC/AML e OSINT mostra una crescente interoperabilità.

Il codice evidenzia anche un liveliness check proprietario per distinguere umani da contenuti generati da AI, un elemento diventato centrale con l’aumento di deepfake e identità sintetiche. L’evoluzione verso verifiche multimodali amplia la superficie di attacco e la quantità di dati concentrati in pochi nodi infrastrutturali.

Discord, “teen-by-default” e il ritiro del servizio

Dieci giorni prima della scoperta, Discord aveva annunciato impostazioni globali “teen-by-default”, con accessi ristretti a spazi age-gated e filtri sui contenuti. Per l’uso abituale in alcune aree era richiesta la scansione del volto. La reazione della comunità è stata critica; dopo l’emersione del frontend esposto, Discord ha comunicato il ritiro di Persona. Il caso riapre la discussione sull’efficacia delle verifiche centralizzate. I sostenitori richiamano la tutela dei minori; i critici sottolineano che la concentrazione di ID, biometrie e metadati crea obiettivi ad alto valore per attacchi e ricatti. Il precedente leak di 70.000 foto ID legate a processi di verifica su Discord nel 2025 resta un monito sui rischi di furto d’identità.

Normative globali e centralizzazione dei dati sensibili

Il contesto normativo accelera l’adozione di sistemi di age verification. In Europa si discute di Chat Control; nel Regno Unito è in vigore l’Online Safety Act; negli Stati Uniti si muovono KOSA ed EARN IT Act. L’obiettivo dichiarato è la protezione dei minori, ma l’effetto sistemico è la centralizzazione di dati sensibili e la costruzione di grafi di sorveglianza che incrociano identità, comportamenti e finanza. Esperti di sicurezza avvertono che database centrali di ID e biometrie rappresentano target privilegiati. Le fughe di dati si susseguono con cadenza quasi settimanale, mentre alcune istituzioni finanziarie spingono per un approccio AML sempre più data-driven, includendo accesso a social media, IP e identificativi di device dei clienti. L’integrazione tra riconoscimento facciale e screening finanziario promette maggiore accuratezza, ma amplia anche il raggio di possibili falsi positivi.

AI di supporto e domande aperte sull’accesso ai dati

La piattaforma include componenti di assistenza basate su modelli AI per la revisione di match e report. L’uso di un chatbot di OpenAI come supporto operativo non mostra, nel codice osservato, flussi espliciti di PII verso l’esterno, ma solleva interrogativi su contesto di accesso, logging e minimizzazione dei dati. In ambienti regolati, la separazione tra inferenza e dataset è cruciale per evitare esposizioni indirette. Il punto tecnico non è solo se i dati escano, ma come vengono segmentati, per quanto tempo sono trattenuti e quali audit trail garantiscano accountability. Con retention fino a tre anni, la governance del ciclo di vita diventa un fattore di rischio primario.

Verso un web meno anonimo?

La scoperta funziona da wake-up call. La promessa di un web più sicuro attraverso verifiche pervasive si scontra con la realtà di sistemi complessi, integrazioni finanziarie e infrastrutture governative. La traiettoria è chiara: dall’age check alla costruzione di grafi di sorveglianza completi che collegano volto, identità e transazioni. Resta una domanda tecnica e politica insieme: è possibile progettare verifiche dell’età privacy-preserving, con minimizzazione dei dati e architetture decentralizzate, evitando la concentrazione di biometrie e ID? La risposta determinerà se la tutela dei minori potrà convivere con un internet che non trasformi ogni accesso in un atto di identificazione permanente.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.