Google Cloud prova a fare una cosa molto precisa: trasformare la promessa “AI per l’impresa” in una catena operativa completa, dove il modello non è un gadget ma un acceleratore di decisioni, e i database non sono solo storage ma motori globali per applicazioni distribuite. Nel pacchetto di annunci che stai ricostruendo, la direzione è netta: Gemini 3.1 Pro spinge il ragionamento complesso e l’uso “grounded” dei dati; Vertex AI introduce strumenti per rendere prevedibile capacità e latenza; Spanner aggiunge un endpoint CQL per intercettare migrazioni da Cassandra con un salto verso transazioni ACID globali; BigQuery si sposta su due assi chiave, cioè embedding generati e mantenuti “in casa” e query globali multi-regione senza l’ossessione dell’ETL. In mezzo, Google mette la narrativa della sovranità europea, la sicurezza dell’AI come tema non negoziabile e un’infrastruttura di rete che allunga la propria ombra da un continente all’altro. Il filo rosso non è la singola feature, è l’abbattimento dell’overhead. Se prima l’enterprise doveva scegliere tra “fare AI” e “mantenere la piattaforma”, ora l’obiettivo è comprimere quel costo mentale e infrastrutturale. L’AI diventa un layer di interazione, ma anche un layer di governance. I database diventano multi-modello e multi-regione, ma con strumenti per restare interrogabili come se fossero locali. La promessa, in sostanza, è che l’impresa possa muoversi più velocemente senza perdere controllo, e che i team possano spendere meno tempo in colla, pipeline, repliche, trasferimenti e più tempo in prodotto.

Gemini 3.1 Pro su Vertex AI: il ragionamento come feature di piattaforma

Gemini 3.1 Pro, in preview su Vertex AI e disponibile anche in ambito Gemini Enterprise, viene posizionato come modello orientato al ragionamento complesso, con miglioramenti fino al 15% nelle performance. In una fase in cui molte aziende stanno scoprendo che la differenza non la fa “avere un LLM”, ma riuscire a farlo lavorare con dati sporchi, frammentati e governati, l’enfasi sul ragionamento non è marketing: è una risposta alla frustrazione operativa più comune, cioè che l’AI sembra brillante finché non deve incrociare vincoli, eccezioni, policy e contabilità del reale. Il valore pratico emerge nei casi d’uso che citi: unire dati eterogenei, costruire viste unificate, ridurre output token per migliorare efficienza, ragionare su tabelle e documenti non strutturati senza perdere aderenza ai fatti. Quando l’obiettivo è portare l’AI nei processi, la “fantasia” è un difetto, non una virtù. E un modello che promette di essere più stabile nel ragionamento e più economico in output è chiaramente pensato per scalare in contesti enterprise dove ogni chiamata pesa in costi e in rischio. C’è poi un altro livello, meno evidente ma decisivo: l’AI come traduttore tra strumenti. Se Gemini entra davvero nei workflow di sviluppo, analisi e operations, la sua funzione non è solo generare testo. È trasformare richieste in azioni coerenti, con un sistema di permessi, audit e governance che regga un utilizzo quotidiano.

Snowboarding e analisi 3D: quando l’AI diventa metrica fisica

La collaborazione con U.S. Ski & Snowboard è interessante non perché “fa scena”, ma perché mette in luce un punto tecnico che torna utile anche fuori dallo sport: estrarre dati 3D da video ordinari, misurare rotazioni e assi reali, produrre visualizzazioni che non dipendono dai nomi convenzionali ma dai gradi effettivi e dall’efficienza biomeccanica. Qui l’AI non fa “interpretazione”, fa misurazione.

Nel racconto, Gemini e tecnologie collegate a DeepMind vengono usate per estrarre skeleton 3D e calcolare rotazioni freestyle, tracciando gradi rotazionali reali e mostrando in modo più fedele cosa succede in aria. Questo tipo di pipeline ha un valore trasversale: significa che l’AI può diventare uno strumento di “strumentazione” anche quando non hai sensori dedicati. E per l’enterprise, tradotto, significa poter ricavare segnali quantitativi da sorgenti che prima erano considerate troppo informali o troppo costose da strutturare. È anche una dichiarazione di intenti: Google vuole che l’AI sia percepita come infrastruttura “fisica”, non solo digitale. Se riesci a dimostrare che un modello può misurare e ottimizzare un gesto atletico, stai implicitamente dicendo che può misurare e ottimizzare un processo industriale, un flusso logistico, un’anomalia in produzione, una dinamica di traffico o un comportamento in ambiente retail. Il caso d’uso sportivo è una vetrina, ma il target è il mondo dei processi.

Vertex AI e Provisioned Throughput: la latenza smette di essere un’incognita

Uno dei punti più pratici è Provisioned Throughput su Vertex AI, cioè la possibilità di prenotare capacità per workload AI e agentici. È un tema spesso sottovalutato da chi guarda solo al modello: in produzione, la differenza tra un progetto che regge e uno che fallisce è spesso la prevedibilità. Non basta avere un modello “forte”, serve sapere che risponderà entro una finestra utile, in modo stabile, sotto picco, senza sorprese sui costi. Con throughput riservato, Google sta dicendo alle imprese: smettete di progettare “in base alla speranza” e iniziate a progettare “in base a una capacità garantita”. L’impatto è duplice. Da una parte, migliora l’esperienza utente e la qualità percepita degli agenti, perché l’interazione non si rompe su tempi morti. Dall’altra, permette una gestione più razionale dei costi, perché si può pianificare capacità invece di inseguirla a consumo nei momenti peggiori. Questo si lega direttamente ai casi multi-tenant e ai picchi stagionali che citi: piattaforme con alta concorrenza, eventi promozionali, workload educativi o enterprise con finestre di utilizzo concentrate. È la parte “noiosa” della GenAI, ma è quella che rende la GenAI acquistabile.

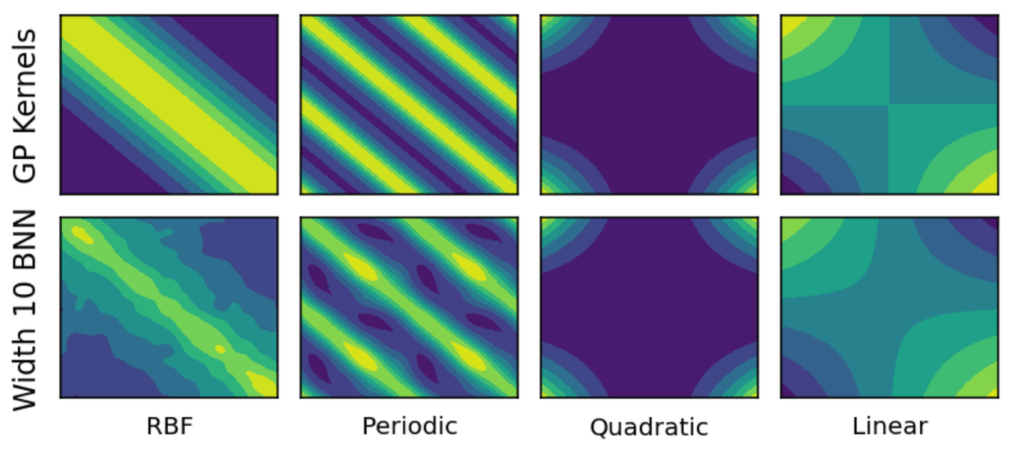

BigQuery: embedding nativi e sincronizzati, RAG senza pipeline fragili

Su BigQuery la svolta è più sottile, ma potenzialmente più trasformativa: la generazione di embedding direttamente nel data warehouse, con colonne vettoriali mantenute sincronizzate con i dati sorgente. Questo risolve un problema ricorrente nei progetti RAG: la fragilità delle pipeline. Nella pratica, molte aziende finiscono con un patchwork di job esterni, scheduler, trasformazioni, vector store separati e meccanismi di sync che prima o poi si desincronizzano. Il risultato è che il retrieval semantico diventa un secondo sistema da mantenere, con i suoi ritardi, i suoi bug e i suoi costi nascosti. Se BigQuery consente di definire embedding via SQL e li gestisce in asincrono, tenendo stato e sincronizzazione, l’AI smette di essere un “progetto parallelo” e diventa una funzione del dato. È un cambiamento culturale: l’impresa non deve più chiedersi “dove mettiamo i vettori?”, ma “quali dati devono essere interrogabili semanticamente e con quale modello?”. Il che, di fatto, riduce l’attrito tra team data e team AI, perché la superficie operativa resta nel perimetro del warehouse, con governance e controlli già esistenti. La parte importante, in un’ottica enterprise, è che l’embedding non è fine a sé stesso. Serve a costruire un retrieval coerente con policy, ruoli, VPC, e a evitare che l’AI “veda” più del dovuto. Quando gli embedding diventano un componente nativo, è più facile gestire accessi, audit e conformità senza dover replicare metà della governance in un sistema esterno.

BigQuery e query globali: analisi multi-regione senza ETL come religione

L’altra novità su BigQuery è l’introduzione delle query globali per dati multi-regione. Qui la posta è alta: molte aziende globali vivono in una tensione continua tra sovranità, latenza e centralizzazione. Se sposti tutto in una regione unica, semplifichi analisi ma rischi di violare vincoli o creare colli di bottiglia. Se tieni i dati locali per compliance e performance, ti ritrovi con silos e un ETL per ogni domanda. Il risultato è che i report “globali” diventano progetti, non risposte. L’idea che BigQuery possa eseguire parti della query localmente e trasferire risultati ottimizzati, consentendo join e analisi cross-continentali senza una migrazione continua dei dati, è una risposta a questa tensione. Non elimina tutti i problemi, perché restano i temi di egress, latenza e policy, ma sposta l’asticella: l’analista può ottenere consolidamento senza chiedere ogni volta una pipeline. E quando l’analisi si accelera, accelerano anche le decisioni, soprattutto in funzioni come supply chain, vendite globali, fraud e risk. La parola chiave, in questo contesto, è governance. Se le query globali rispettano i perimetri VPC e i vincoli di esecuzione, allora l’enterprise può usare “globale” senza perdere controllo. È un equilibrio delicato, ma è esattamente il tipo di equilibrio che decide se una feature resta demo o diventa standard.

Agenti dati conversazionali: la democratizzazione che non può essere ingenua

BigQuery, nel quadro che riporti, abilita la costruzione di agenti dati conversazionali tramite API, capaci di interrogare dataset con linguaggio naturale e restituire insight immediati. Questa promessa è potente perché intercetta un desiderio reale: ridurre l’asimmetria tra chi ha la domanda e chi sa scrivere query. In molte aziende, il collo di bottiglia non è la mancanza di dati, è la coda di richiesta verso il team data. Qui però esiste un punto critico che Google sembra voler affrontare con il contesto enterprise: un agente conversazionale su dati aziendali non è un chatbot, è un sistema decisionale. Se l’agente può fare follow-up, mantenere stato, generare tabelle e grafici, allora può anche produrre interpretazioni e condurre l’utente verso conclusioni sbagliate se non è ben vincolato. È per questo che il valore non sta solo nell’interfaccia naturale, ma nei guardrail: policy di accesso, spiegabilità, tracciabilità delle query eseguite, gestione del contesto per evitare leakage tra conversazioni o utenti. In un’organizzazione matura, l’agente diventa un “front-end” del data warehouse con un rischio specifico: l’illusione di semplicità. La domanda in linguaggio naturale abbassa la soglia, ma aumenta il bisogno di audit. Se Google riesce a rendere questa parte solida, BigQuery non diventa solo un warehouse, diventa un’interfaccia universale al dato aziendale.

Spanner con CQL: la mossa che mira a Cassandra senza chiedere riscritture

La novità su Spanner è un classico colpo “da piattaforma”: aggiungere un endpoint CQL nativo per facilitare migrazioni da Cassandra. In termini enterprise, il problema delle migrazioni non è mai solo tecnico, è economico. Le aziende restano su sistemi legacy perché riscrivere applicazioni costa, e perché il rischio operativo di una migrazione totale è spesso percepito come superiore al beneficio. Con CQL, Google prova a ridurre quel costo d’ingresso: l’app parla lo stesso linguaggio, ma dietro trova un database con transazioni ACID globali e scalabilità distribuita. Il messaggio implicito è che puoi mantenere la semantica applicativa e ottenere un salto di consistenza e disponibilità. Qui entra in gioco anche l’argomento “enterprise-grade” che citi: disponibilità 99,999%, scalabilità “illimitata”, e la narrativa di una leadership riconosciuta su transazioni leggere. Al di là del ranking, la strategia è chiara: posizionare Spanner come il database dove puoi costruire sistemi globali senza dover fare compromessi dolorosi su consistenza. Il punto più interessante è che CQL non è solo compatibilità. È un invito a “decommissionare” una costellazione di tool tipici dell’ecosistema Cassandra. Se Spanner può offrire backup nativi, osservabilità e un’esperienza gestita, il valore non è solo nel motore dati, ma nel taglio del costo operativo. È lo stesso pattern visto in BigQuery: ridurre la manutenzione del contorno.

Neo4j in Gemini CLI: GraphRAG e knowledge graph come asset operativo

L’estensione Neo4j in Gemini CLI è un’altra tessera coerente: portare il linguaggio naturale dentro strumenti che, storicamente, richiedono competenze specialistiche. I graph database sono potenti per modellare relazioni, contesti e connessioni, ma spesso restano confinati a team esperti. Se l’AI può generare query Cypher, gestire provisioning e aiutare a visualizzare modelli, allora un knowledge graph può diventare un asset più diffuso. Questo si lega direttamente al concetto di GraphRAG: non solo retrieval da vettori, ma retrieval da relazioni, con memoria strutturata di fatti e legami. È un approccio che può aumentare robustezza e grounding degli agenti, soprattutto in domini come customer 360, frodi, compliance e risk. In pratica, Google sta dicendo: l’AI non deve solo leggere testi, deve interrogare strutture. La sfida, anche qui, non è “funziona?”, ma “regge in governance?”. Perché un knowledge graph è spesso un concentratore di dati sensibili. Se l’AI lo rende più accessibile, deve anche renderlo più controllabile.

Sicurezza AI e minacce: distillazione, abuso di API e malware agentico

Il blocco sulla sicurezza è uno dei più importanti perché sposta la conversazione dal “cosa possiamo fare con l’AI” al “cosa possono farci gli altri con l’AI”. Il report citato sulle minacce mette in evidenza la distillazione come vettore per estrarre IP e capacità da modelli, e l’integrazione dell’AI in catene di attacco, inclusi scenari dove API vengono usate per automatizzare reconnaissance, phishing, o peggio, per alimentare componenti malware. Nel racconto compare anche l’idea che l’AI possa essere integrata direttamente in malware o in flussi di attacco, e che gli attori minacciosi stiano sperimentando jailbreak, prompt underground e pattern di abuso. Qui la risposta di Google Cloud passa da due concetti: monitoraggio e framework. Il riferimento a un approccio come SAIF segnala la volontà di trattare l’AI come superficie d’attacco con pratiche specifiche, non come semplice feature applicativa. Per un CISO, questo cambia il modello: non basta mettere un LLM dietro un proxy. Serve osservabilità delle chiamate, rilevamento di pattern anomali, rate e policy, controlli su prompt e output dove serve, e una governance che definisca cosa è consentito fare ai modelli in produzione. In altre parole, l’AI diventa un servizio critico che va difeso come un database o un gateway, perché in effetti è un gateway verso funzioni e dati.

Sovranità europea: l’AI enterprise non può essere solo prestazione

L’enfasi sulla sovranità europea è un altro segnale: Google Cloud vuole parlare alle imprese e alle PA europee con un linguaggio che non sia solo “più performance”, ma “più controllo”. In Europa il tema non è accessorio, perché molte organizzazioni stanno ristrutturando la propria postura su dati, cloud e AI in base a vincoli normativi e geopolitici. Quando Google parla di partnership, interoperabilità, modelli aperti e scelte multi-cloud, sta cercando di ridurre la paura di lock-in e di spostare la narrazione verso un “AI senza compromessi su autonomia”. È un punto delicato perché, nella percezione di molte aziende, l’AI tende a centralizzare: centralizza modelli, centralizza dati, centralizza decisioni. Offrire un percorso che promette controllo, audit, regioni e opzioni serve a rendere l’adozione meno conflittuale. In un contesto come il tuo, dove la sovranità è un asse editoriale, questa parte va letta anche come geopolitica dell’infrastruttura: chi controlla i modelli controlla capacità cognitive industriali; chi controlla i database globali controlla la latenza del business; chi controlla i cavi e la rete controlla resilienza e flussi.

America-India Connect: la rete come fondamento della cloud economy AI

L’annuncio America-India Connect aggiunge la dimensione fisica: cavi subacquei, gateway, percorsi fibra, resilienza su quattro continenti. In piena era AI, la rete torna a essere l’elemento invisibile che decide cosa è possibile. Un modello può essere straordinario, ma se la latenza è instabile o se i percorsi sono fragili, l’esperienza enterprise crolla. Una rete più resiliente serve a due cose. Serve a ridurre rischi di single point of failure su tratte critiche e serve a rendere più praticabili quei workload distribuiti di cui parlano BigQuery e Spanner. Se vuoi query globali e transazioni globali, devi avere un trasporto globale affidabile. È un piano coerente: database che scalano geograficamente, AI che gira su infrastrutture distribuite, e rete che sostiene la promessa. C’è anche una lettura industriale: investire su connettività e su un hub come l’India significa puntare su un mercato che sarà sia produttore sia consumatore di AI. Nel tuo testo compaiono anche cifre e iniziative di supporto pubblico, che in una narrazione enterprise rafforzano l’idea di “ecosistema” più che di “singolo prodotto”.

Perché queste novità riducono overhead e accelerano le imprese globali

Messe insieme, queste feature riducono overhead in tre punti dove normalmente si perde tempo e denaro. Il primo è l’overhead di integrazione, perché l’AI entra in strumenti come BigQuery e Gemini CLI senza chiedere sistemi paralleli. Il secondo è l’overhead di migrazione, perché Spanner parla CQL e prova a intercettare applicazioni esistenti. Il terzo è l’overhead di operatività, perché throughput riservato e embedding gestiti nativamente riducono l’ansia da performance e l’ansia da pipeline. La conseguenza, se l’esecuzione regge, è che le imprese possono passare da “progetti AI” a “processi AI”. Ed è qui che Google Cloud sta provando a posizionarsi: non come vendor di modelli, ma come piattaforma dove dati, modelli e governance convivono senza che il cliente debba costruire tutto a mano.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.