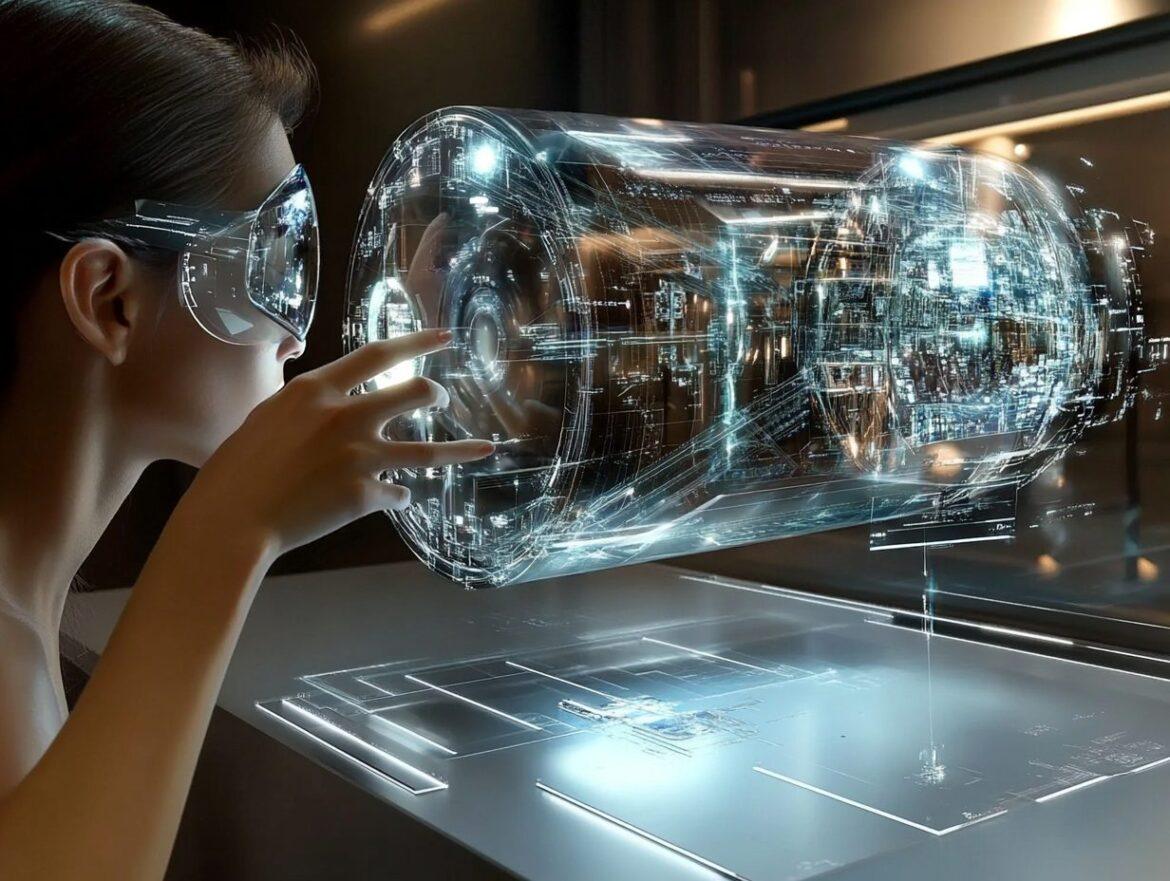

I sistemi di realtà aumentata (AR), come quelli presenti in visori ingombranti e display head-up nelle automobili, richiedono componenti ottici portatili. Tuttavia, ridurre i classici sistemi AR a quattro lenti alle dimensioni di un paio di occhiali spesso compromette la qualità dell’immagine generata al computer e ne limita il campo visivo. Youguang Ma e il suo team potrebbero aver trovato una soluzione per comprimere questa tecnologia: una combinazione di due tecnologie ottiche, una metasuperficie e una lente refrattiva, insieme a uno schermo microLED per creare un design compatto a lente singola.

La metasuperficie del display è costituita da un film ultrasottile e leggero in nitruro di silicio, inciso con un motivo che modella e mette a fuoco la luce emessa dai microLED verdi. Su una lente refrattiva in polimero sintetico si forma quindi un’immagine in bianco e verde, che affina e riduce le aberrazioni della luce proiettata. L’immagine finale viene proiettata dal sistema e sovrapposta a un oggetto o a uno schermo. Per migliorare ulteriormente la risoluzione dell’immagine proiettata, Ma e il suo team hanno utilizzato algoritmi informatici per identificare le minime imperfezioni del sistema ottico e correggerle prima che la luce lasci lo schermo microLED.

Test del prototipo e miglioramenti delle immagini

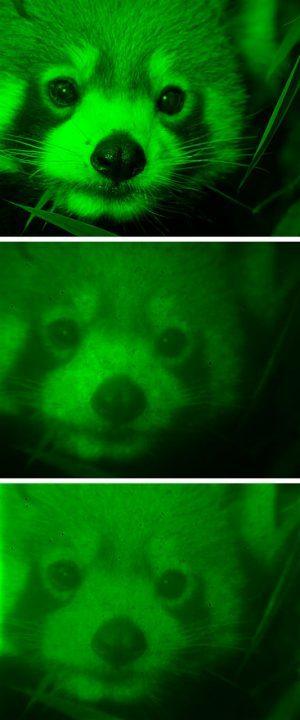

Il team ha integrato il display AR ibrido in un paio di occhiali e ha testato le prestazioni del prototipo utilizzando algoritmi di elaborazione delle immagini. Le immagini proiettate dal sistema a lente singola presentavano meno del 2% di distorsione su un campo visivo di 30 gradi, offrendo una qualità d’immagine paragonabile alle attuali piattaforme AR commerciali a quattro lenti. Gli algoritmi informatici di pre-elaborazione hanno permesso inoltre di migliorare la qualità dell’immagine proiettata: la riproduzione AR di una foto di un panda rosso è risultata essere simile all’originale per il 74,3%, un miglioramento del 4% rispetto all’immagine proiettata senza correzioni.

Con ulteriori sviluppi, i ricercatori affermano che la piattaforma potrebbe espandersi dal verde a colori completi, aprendo la strada a una nuova generazione di occhiali AR mainstream.