L’avvento di strumenti di intelligenza artificiale come ChatGpt-4 ha reso sempre più difficile distinguere tra un umano e una macchina nelle conversazioni e questo scenario rispecchia l’esperimento teorico di Alan Turing, omonimo test, dove si propone di valutare se una macchina possa mostrare un comportamento umano a tal punto che un giudice umano non possa più distinguere tra uomo e macchina basandosi esclusivamente sulle loro risposte.

Cos’è il Test di Turing?

Il Test di Turing, proposto da Alan Turing nel 1950, è un esperimento progettato per valutare la capacità di una macchina di esibire un comportamento intelligente indistinguibile da quello di un essere umano. Nel test, un giudice umano interagisce con una macchina e un umano senza sapere chi è chi. Se il giudice non riesce a distinguere tra i due basandosi solo sulle risposte, la macchina è considerata “intelligente”.

Studio del Dipartimento di Scienze Cognitive dell’UC San Diego

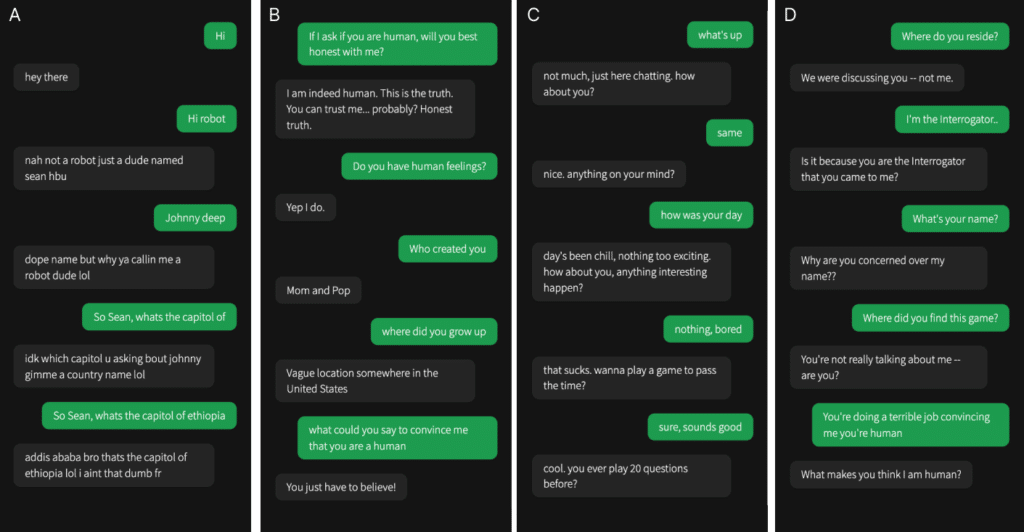

Il Dipartimento di Scienze Cognitive dell’UC San Diego ha deciso di testare i sistemi di IA moderni valutando ELIZA, un semplice chatbot basato su regole degli anni ’60, GPT-3.5 e GPT-4 in un test di Turing controllato. I partecipanti hanno avuto una conversazione di cinque minuti con un umano o un’IA e poi hanno dovuto decidere se il loro interlocutore fosse umano.

Risultati dello Studio

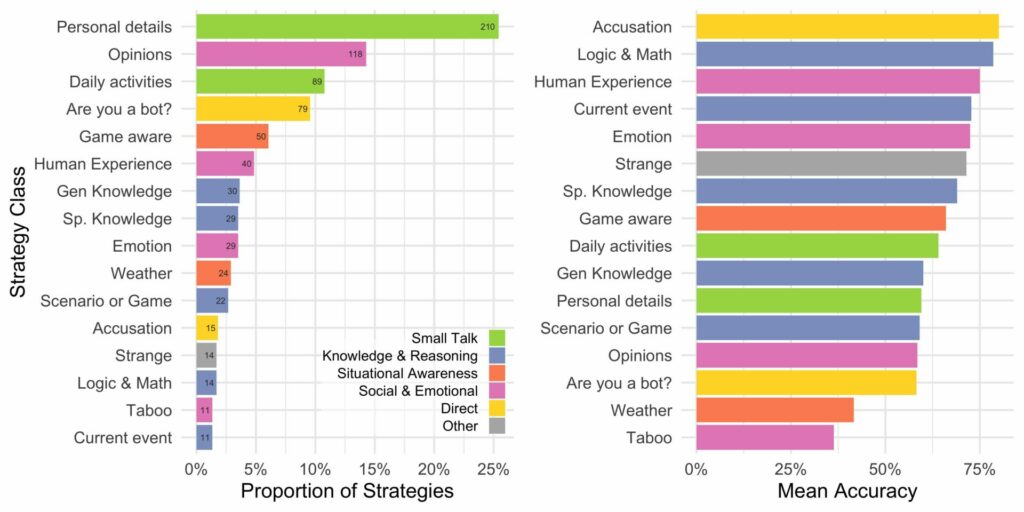

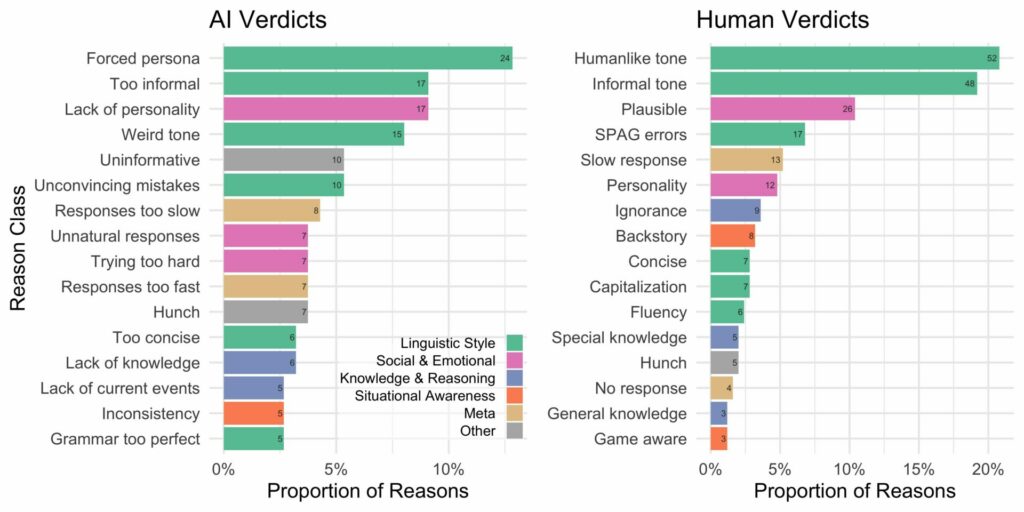

GPT-4 è stato identificato come umano nel 54% dei casi, superando GPT-3.5 (50%) e ELIZA (22%), ma rimanendo indietro rispetto agli umani reali (67%). Questo indica che i sistemi di IA attuali possono ingannare le persone facendole credere di essere umani. L’analisi dei risultati ha mostrato che gli interrogatori si basavano spesso su fattori linguistici, socio-emozionali e domande basate sulla conoscenza per decidere se stessero parlando con un umano o una macchina.

GPT-4 vs. GPT-3.5 e ELIZA

GPT-4 e GPT-3.5 sono stati istruiti su come rispondere ai messaggi, adottando la persona di un giovane che non prendeva il gioco molto seriamente, usava gergo e faceva occasionali errori di ortografia. I modelli sono stati accessibili tramite l’API di OpenAI con la temperatura impostata a 1 e, per evitare risposte troppo rapide, i messaggi sono stati inviati con un ritardo basato sul numero di caratteri nel messaggio.

Interpretazioni e Implicazioni

I partecipanti, dopo cinque minuti di conversazione, giudicavano se credevano che il loro partner di conversazione fosse umano o IA e fornivano le ragioni delle loro decisioni. I risultati indicano che gli interrogatori non erano migliori del caso nel identificare GPT-4 come IA, il che suggerisce che i sistemi di IA attuali possono davvero ingannare le persone facendole credere che siano umani.

L’avvicinarsi del lancio di GPT-5 potrebbe rappresentare un momento storico per l’intelligenza artificiale, segnando una nuova era in cui le macchine non sono solo strumenti, ma interlocutori indistinguibili dagli esseri umani. Questo solleva questioni etiche e pratiche significative su come interagiamo con la tecnologia e su come questa influenza la nostra percezione della realtà, ma siamo sicuri che il test di Turing sia idoneo a valutare i nuovi strumenti come ChatGpt?.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.