Il primo semestre del 2025 segna un’evoluzione concreta e altamente diversificata nel panorama dell’intelligenza artificiale. Le grandi realtà del settore – OpenAI, Meta, Google e WhatsApp – non solo competono sulla potenza computazionale dei propri modelli linguistici, ma definiscono nuovi criteri di adozione, standard di sicurezza, benchmark di performance e pratiche di tutela della privacy.

L’intelligenza artificiale, oggi, non è più una tecnologia sperimentale, ma uno strumento operativo diffuso, che incide su cloud, messaggistica, sviluppo software e difesa informatica.

Nel dettaglio, questa analisi affronta le strategie di adozione selettiva dei modelli GPT suggerite da OpenAI, l’approccio riservato di WhatsApp all’elaborazione AI nel cloud, le performance comparative tra GPT-4.1 e Gemini, l’integrazione di Gemini Flash in Google NotebookLM e l’iniziativa di Meta con LlamaFirewall e i nuovi benchmark di sicurezza. Un ecosistema in rapido mutamento che richiede standard sempre più elevati in materia di affidabilità, protezione e trasparenza.

OpenAI e l’adozione selettiva dei modelli GPT: guida all’uso efficiente

Nel mese di aprile, OpenAI pubblica un documento tecnico mirato a fornire criteri operativi per la selezione dei modelli GPT in base ai casi d’uso. L’iniziativa risponde all’esigenza crescente di distinguere non solo tra versioni di modelli, ma anche tra modalità di esecuzione e obiettivi applicativi.

Nel documento, OpenAI spiega con precisione quando adottare GPT-4.1, GPT-4 Turbo o GPT-3.5, evidenziando che il modello più avanzato non è sempre il più adatto. GPT-4.1 viene raccomandato per applicazioni complesse che richiedono ragionamento multi-turno, comprensione semantica profonda e generazione di contenuti lunghi e strutturati.

| Modello | Limite di utilizzo | Capacità principali | Tipi di input supportati |

|---|---|---|---|

| GPT-4o | Illimitato | GPTs, Analisi dati, Ricerca, Generazione immagini, Canvas, Voce avanzata | Documenti, Immagini, CSV, Audio, Video |

| GPT-4.5 | 20 richieste a settimana | Analisi dati, Ricerca, Generazione immagini, Canvas, Voce | Documenti, Immagini, CSV, Audio, Video |

| o4-mini | 300 richieste al giorno | Analisi dati, Ricerca, Generazione immagini, Canvas, Ricerca approfondita | Documenti, Immagini, CSV |

| o4-mini-high | 100 richieste al giorno | Analisi dati, Ricerca, Generazione immagini, Canvas | Documenti, Immagini, CSV |

| o3 | 100 richieste a settimana | Analisi dati, Ricerca, Generazione immagini, Canvas, Ricerca approfondita | Documenti, Immagini, CSV |

| o1-pro | 5 richieste al mese | Solo ricerca e immagini | Immagini |

GPT-4 Turbo, invece, si dimostra ideale in contesti di elevato carico, in cui l’ottimizzazione dei costi e delle latenze è prioritaria, soprattutto per assistenti vocali, strumenti di riepilogo e chatbot commerciali.

Il modello GPT-3.5 resta efficace per scenari meno sensibili alla precisione, come la generazione di codice basilare, la categorizzazione testuale o l’automazione di e-mail.

OpenAI sottolinea infine che la scelta del modello dovrebbe considerare non solo la potenza computazionale, ma anche la coerenza nel comportamento, il supporto alle API specifiche e l’affidabilità della memoria contestuale.

Benchmark e comparazioni: GPT-4.1 contro Gemini Advanced

I test pubblicati mostrano i primi benchmark indipendenti tra GPT-4.1 e Gemini Advanced di Google, concentrati su scenari di ragionamento logico, scrittura strutturata e coding. I risultati indicano che GPT-4.1 mantiene un vantaggio netto nei compiti multi-step e nei prompt di lunga durata, dimostrando una maggiore capacità di mantenere coerenza tra input e output, e un miglior equilibrio tra creatività e precisione.

Tuttavia, Gemini mostra segni di miglioramento nelle interazioni a bassa latenza e in compiti di comprensione linguistica istantanea, soprattutto nella versione Gemini Flash recentemente introdotta in NotebookLM. Quest’ultima consente esperienze di scrittura assistita su documenti complessi, con risposte sintetiche e navigazione tra fonti integrate.

La distinzione tra i due modelli non è solo qualitativa ma architetturale: GPT-4.1 punta sulla profondità della memoria contestuale, mentre Gemini si orienta verso l’ottimizzazione distribuita in ambienti web-native, sfruttando l’architettura modulare di Google Cloud.

WhatsApp introduce Private Processing: l’AI nel cloud diventa riservata

Sul fronte della messaggistica, WhatsApp annuncia l’introduzione di un meccanismo sperimentale denominato Private Processing, che consente l’uso di funzionalità AI mantenendo il controllo sulla privacy.

La soluzione si basa su un ambiente di esecuzione sicuro, dove le richieste utente vengono elaborate in cloud, ma all’interno di un perimetro crittografico isolato, auditabile da ricercatori indipendenti.

L’obiettivo dichiarato da Meta è rendere l’intelligenza artificiale compatibile con i principi di riservatezza, protezione dei metadati e trasparenza nel trattamento dei dati sensibili.

Questo approccio sfida implicitamente i modelli di raccolta centralizzata dei dati, come quelli adottati da molte piattaforme generative, e si pone come possibile standard etico per l’elaborazione AI in ambito consumer.

Secondo quanto riferito, la fase attuale è ancora sotto verifica con esperti della sicurezza, ma le basi architetturali sembrano già pronte per l’implementazione su larga scala.

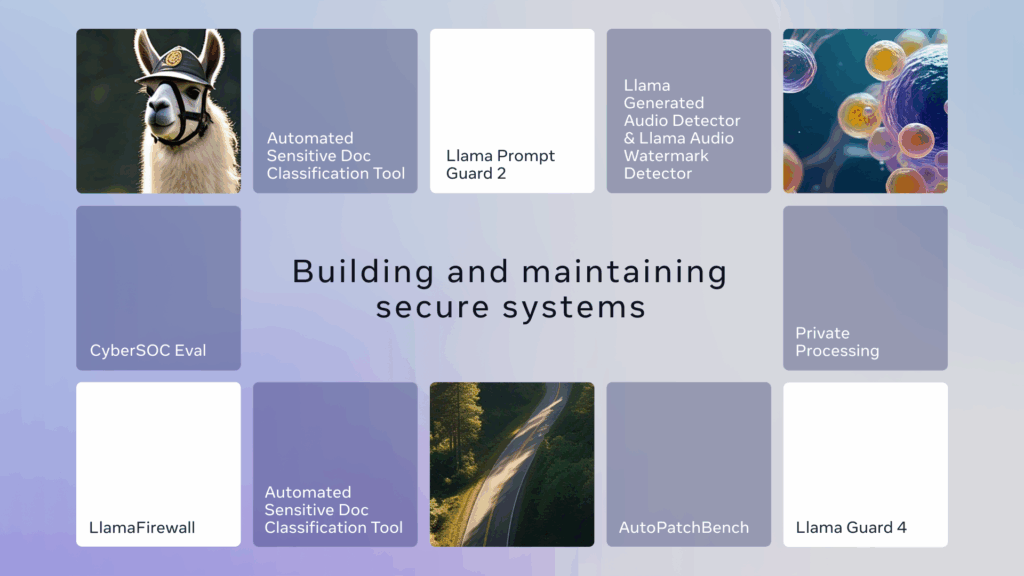

Meta e il framework LlamaFirewall: nuovo paradigma per la difesa AI

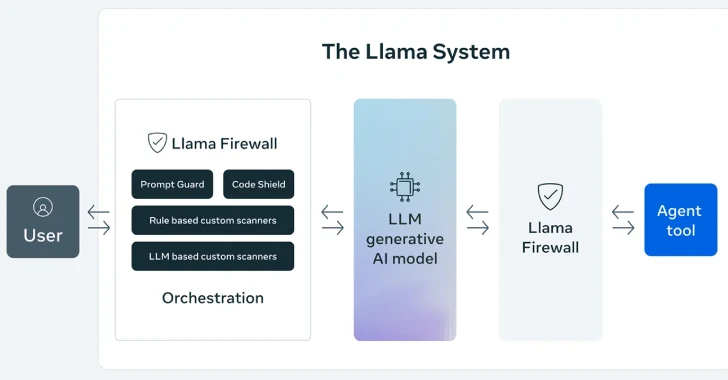

Meta introduce LlamaFirewall, un sistema modulare progettato per proteggere i modelli linguistici da prompt malevoli, comportamenti devianti e attacchi linguistici mirati. Il framework, pubblicato in forma open source, è pensato per operare a monte del modello AI, come filtro semantico e logico, in grado di intercettare input potenzialmente dannosi, violazioni etiche e richieste sensibili.

A differenza delle tradizionali regole di prompt-blocking, LlamaFirewall adotta un approccio multilivello, in cui ogni strato applica una trasformazione o una valutazione specifica: dalla normalizzazione linguistica alla classificazione del rischio, fino alla riscrittura selettiva dei prompt.

Meta non propone il framework solo come uno strumento interno per Llama 3, ma come un’architettura universale per la sicurezza AI, personalizzabile da altri attori del settore.

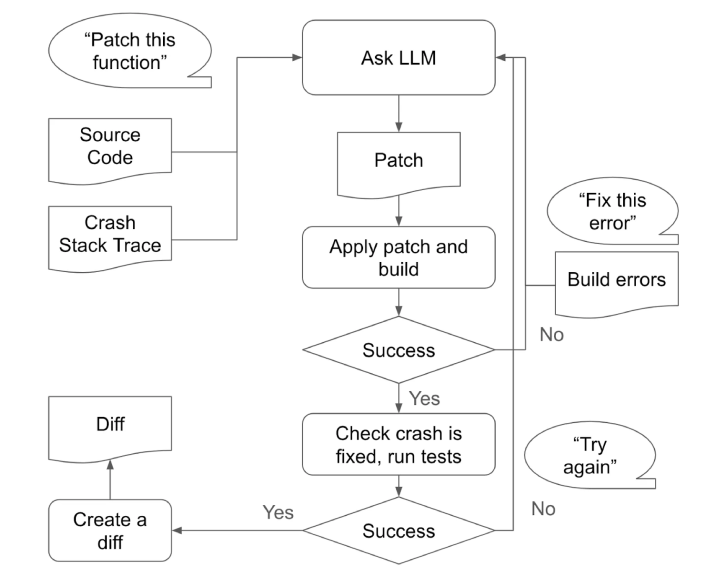

Il lancio del framework è accompagnato da una nuova release del benchmark CyberSecEval, versione 4.0, una suite di test sviluppata per valutare la resistenza dei modelli LLM contro exploit testuali, manipolazioni iterative, violazioni di policy e leakage di informazioni.

CyberSecEval 4 adotta uno standard più realistico di simulazione delle minacce, con prompt ispirati a contesti d’uso reali: conversazioni tecniche, richieste ambigue, pressioni indirette.

I risultati mostrano che modelli dotati di guardrail modulari come LlamaFirewall riducono l’emissione di contenuti sensibili fino al 65% rispetto a modelli standard con filtri statici.

L’adozione di questo sistema da parte di altri provider potrebbe rappresentare una svolta nella governance della sicurezza generativa, soprattutto in ambiti regolati come sanità, difesa e pubblica amministrazione.

Interoperabilità e governance come prossima frontiera

Il quadro delineato dalla primavera 2025 rivela una chiara tendenza: le intelligenze artificiali non competono più solo sulla qualità dell’output, ma sulla capacità di adattarsi a scenari regolati, sicuri e interamente auditabili.

OpenAI raffina la logica d’impiego dei suoi modelli, mentre WhatsApp sperimenta ambienti riservati per l’uso dell’AI nel cloud. Google spinge sulla distribuzione web-native e Meta costruisce infrastrutture di sicurezza a livello linguistico.

L’interoperabilità tra modelli e framework di protezione, così come la trasparenza nella gestione delle richieste utente, si impongono come elementi essenziali per l’adozione sostenibile dell’AI nei settori critici. La prossima fase sarà definita non tanto dall’intelligenza dei modelli, quanto dalla capacità di proteggerli e renderli verificabili in tempo reale, all’interno di ecosistemi sempre più complessi.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.