La comprensione teorica delle attenzioni nei modelli di linguaggio ha raggiunto un nuovo traguardo grazie all’analisi presentata da Hugo Cui, Freya Behrens, Florent Krzakala e Lenka Zdeborová, pubblicata su Journal of Statistical Mechanics: Theory and Experiment. L’articolo si concentra sull’emergenza di meccanismi algoritmici all’interno delle reti neurali di tipo Transformer, offrendo una cornice matematica solida che spiega come e quando i modelli di attenzione passano da un comportamento puramente posizionale a uno semantico.

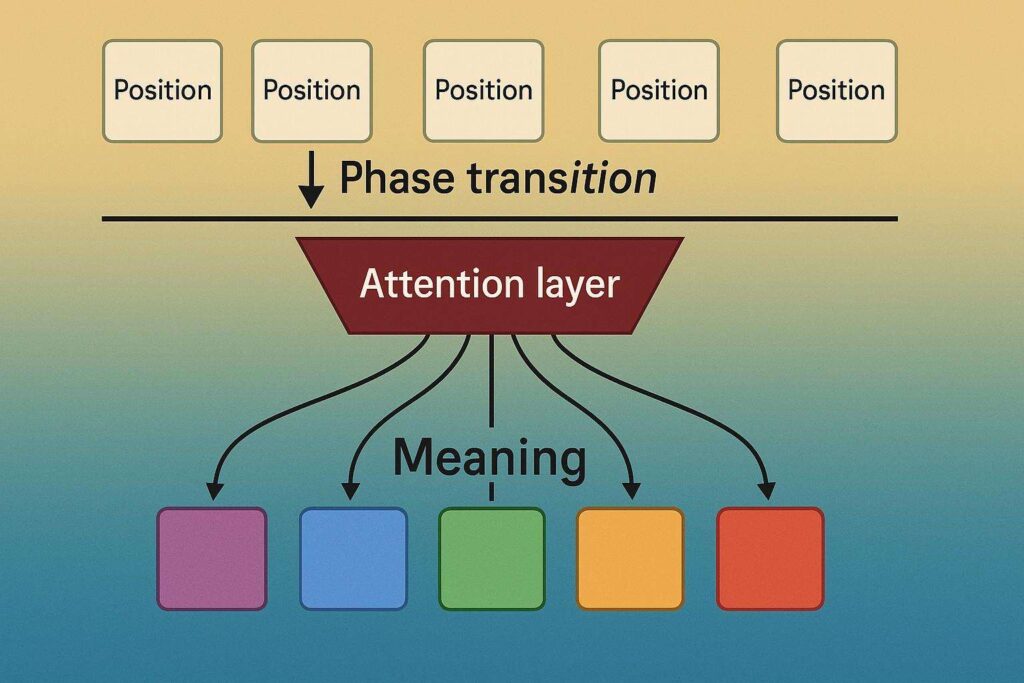

Il cuore della ricerca risiede nello studio di una fase di transizione, cioè un punto critico in cui il modello cambia radicalmente il suo modo di utilizzare le informazioni, passando dal confrontare token in base alla posizione al riconoscere e usare il significato dei token stessi. Il lavoro offre una dimostrazione formale del perché e del come avvenga questa transizione, fornendo un collegamento diretto con la quantità di dati disponibili durante l’addestramento e le proprietà architetturali del layer di attenzione.

Modelli di attenzione: tra posizione e semantica

Gli strati di self-attention nei modelli di linguaggio moderni sono in grado di apprendere sia informazioni sulla posizione delle parole (ad esempio la struttura sintattica) sia sul significato (ad esempio il contesto semantico). Fino ad ora, si sapeva empiricamente che, aumentando la complessità del compito e la quantità di dati disponibili, questi layer potevano improvvisamente iniziare a sfruttare correlazioni semantiche invece che solo posizionali, ma mancava una teoria matematica capace di spiegare questo fenomeno.

La ricerca dimostra che, all’aumentare della sample complexity (quantità di dati e dimensionalità dell’input), esiste un vero e proprio punto di svolta: sotto una certa soglia, il modello apprende strategie posizionali, sopra quella soglia riesce invece ad apprendere regole e relazioni semantiche tra i token, indipendentemente dalla loro posizione.

Descrizione del modello e metodologia analitica

Gli autori analizzano un modello di self-attention non lineare con matrici di query e key condivise, a bassa rank, che agiscono su dati di alta dimensionalità. L’attenzione si basa su due meccanismi: uno posizionale, che tiene conto solo della posizione dei token, e uno semantico, che si basa sul contenuto. La soluzione analitica trova il minimo globale della funzione di perdita empirica e identifica se questo corrisponde a una strategia posizionale o semantica, evidenziando la presenza di un vero salto di fase tra i due regimi.

Utilizzando strumenti dalla fisica statistica, come il limite degli alti numeri di parametri e la caratterizzazione dei minimi tramite algoritmi di approximate message passing, il gruppo di ricerca è riuscito a derivare formule chiuse per la stima della loss di training e di generalizzazione in funzione della complessità campionaria.

Analisi quantitativa e osservazioni sperimentali

Il lavoro illustra che, per modelli di dot-product attention con architettura semplificata (matrici di key/query condivise e a basso rango), la transizione tra meccanismi avviene quando il rapporto tra dati disponibili e parametri del modello supera una soglia critica. Sotto questa soglia, la soluzione ottimale corrisponde a una strategia che fa leva solo sulle posizioni; sopra la soglia, la soluzione cambia bruscamente e il modello diventa capace di identificare e sfruttare relazioni semantiche tra i token.

Questo salto di fase è stato caratterizzato analiticamente e validato sperimentalmente su task di conteggio (“histogram task”), dove la funzione target può essere risolta sia con una strategia posizionale che semantica. Le simulazioni mostrano che entrambi i minimi locali sono stabili, ma solo uno dei due è globale a seconda della complessità dei dati, con test accuracy che si avvicina al 100% in entrambi i casi.

Implicazioni per architetture di deep learning e applicazioni

La presenza di una fase di transizione nel comportamento della dot-product attention non è solo una curiosità teorica: ha forti implicazioni per la progettazione e il tuning di modelli deep learning in ambiti come NLP, traduzione automatica, sintesi di testo e question answering. Sapere quanta sample complexity è necessaria affinché il modello apprenda relazioni semantiche permette di prevedere meglio le prestazioni del sistema e di dimensionare in modo più efficiente dataset, architettura e strategie di addestramento.

Il confronto tra layer di attenzione dot-product e modelli puramente lineari dimostra inoltre che la superiorità dei primi emerge solo quando sono presenti dati sufficienti da far emergere il comportamento semantico. In assenza di sample complexity adeguata, anche architetture molto avanzate rischiano di rimanere bloccate su strategie semplici, inefficaci per i task più complessi.

Dettagli tecnici: equazioni di stato, replica method e simulazioni

L’articolo entra nei dettagli tecnici della statistical mechanics applicata al deep learning. Le equazioni di stato derivate sono equivalenti a quelle della teoria delle transizioni di fase nei materiali, come il modello di Ising per il ferromagnetismo, e trovano applicazione diretta nella caratterizzazione delle proprietà asintotiche dei modelli di attenzione.

Le appendici descrivono in dettaglio i metodi di derivazione, dall’approximate message passing (AMP) ai metodi della replica theory, mostrando come le soluzioni ottenute siano robustamente stabili anche in presenza di perturbazioni o con inizializzazioni differenti degli ottimizzatori. Viene inoltre esplorata la stabilità dei minimi e la presenza di regioni piatte nel paesaggio della loss, con simulazioni su architetture semplificate ma realistiche.

Limiti della teoria e prospettive di ricerca

Nonostante la potenza del modello teorico proposto, la ricerca evidenzia alcune limitazioni rispetto ai Transformer reali: la semplificazione architetturale, l’assenza di matrici value trainabili, il focus su dati Gaussiani e il numero ridotto di head. Tuttavia, il framework presentato può essere esteso a configurazioni più realistiche e costituisce la base per nuove indagini sul comportamento interno dei modelli di attenzione.

Un aspetto ancora aperto riguarda la dinamica degli algoritmi di ottimizzazione: sapere esattamente se e quando un dato inizializzatore (randomico o informato) conduce al minimo globale resta un punto cruciale per la formazione efficiente dei grandi modelli di linguaggio.

Impatto sulla teoria e sulle applicazioni delle reti neurali

Il lavoro di Cui, Behrens, Krzakala e Zdeborová rappresenta una tappa fondamentale nella comprensione dei meccanismi di emergenza algoritmica nei modelli di attenzione. Dimostra formalmente che la dot-product attention attraversa una vera transizione di fase tra apprendimento posizionale e semantico, fornendo strumenti teorici utili sia alla ricerca fondamentale che alle applicazioni industriali dell’intelligenza artificiale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.