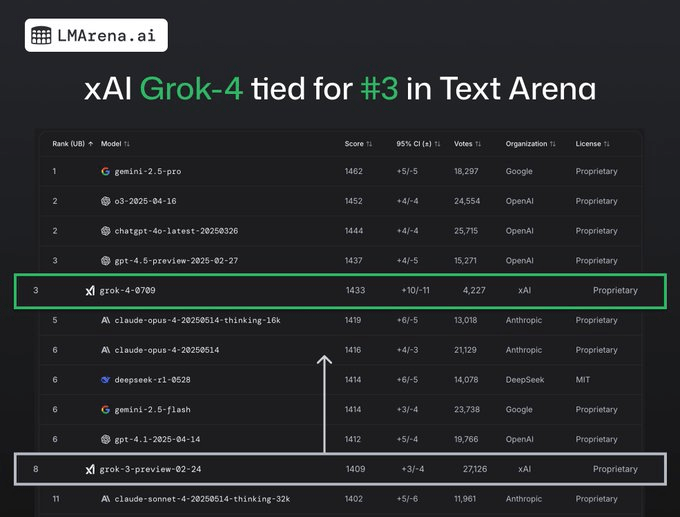

Il modello linguistico Grok 4, sviluppato da xAI, ha ottenuto un riconoscimento di rilievo nel competitivo ecosistema dell’intelligenza artificiale, posizionandosi tra i primi tre modelli nella Text Arena di LM Arena, la piattaforma di benchmarking pubblico fondata su voti della comunità. Il risultato, annunciato il 15 luglio 2025, rappresenta un passo in avanti decisivo rispetto alla precedente generazione Grok 3, e colloca Grok 4 alla pari con Claude 3.5 e Gemini.

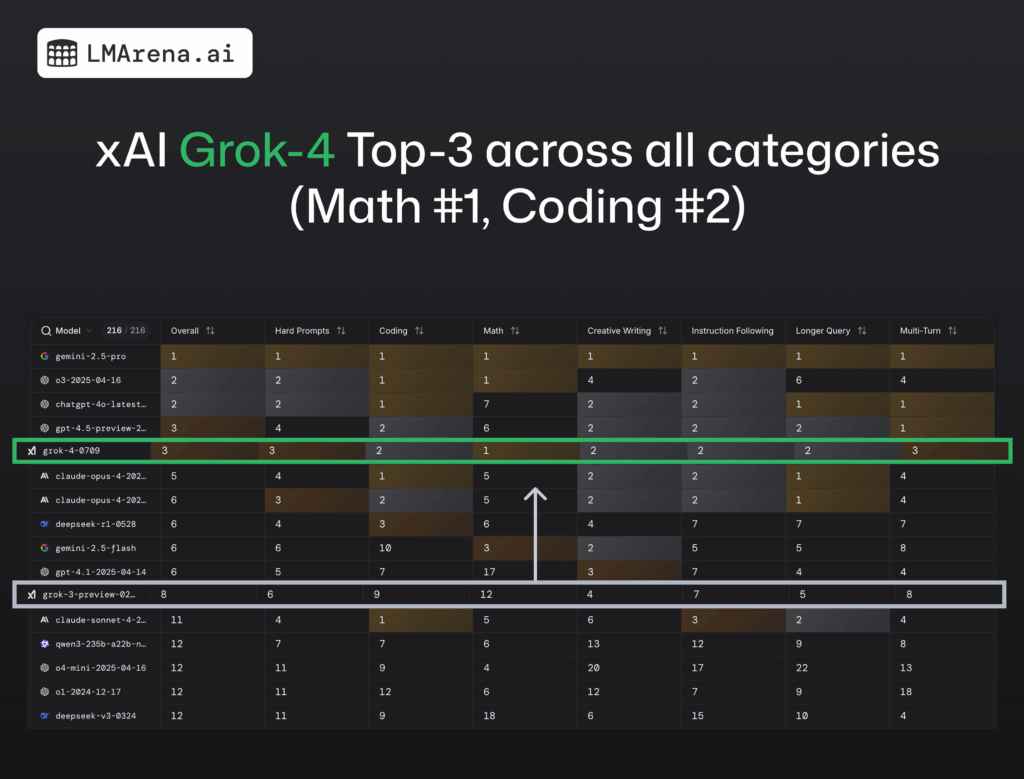

Ciò che distingue Grok 4 è la sua performance nella categoria matematica, dove conquista il primo posto assoluto, superando tutti gli altri modelli in capacità di ragionamento simbolico, calcolo e gestione logica. Il modello ha inoltre ottenuto il secondo posto nelle categorie coding, creative writing e instruction following, mentre si è attestato al terzo posto per prompt ad alta difficoltà, confermandosi efficace su un’ampia gamma di ambiti.

Un benchmark su prompt reali e senza prompt di sistema

I test condotti da LM Arena sono avvenuti utilizzando la versione API grok-4-0709, senza l’uso di prompt di sistema predefiniti di xAI, in linea con il principio della neutralità nei confronti dei contesti preimpostati. In questa configurazione, Grok 4 ha raggiunto un punteggio Elo di 1433, calcolato su confronti pairwise tra modelli su migliaia di prompt reali. La versione dotata di prompt di sistema ha invece totalizzato 1422 punti Elo, a riprova della coerenza tra le varianti. La piattaforma LM Arena adotta il sistema Elo come metrica di riferimento, ispirato agli algoritmi del gioco degli scacchi, per misurare la forza relativa dei modelli. Ogni sfida tra modelli avviene tramite prompt identici, e la valutazione viene espressa direttamente dagli utenti, che scelgono quale output ritengono superiore in un confronto alla cieca. Oltre 4.000 voti sono stati espressi per Grok 4, indicando un elevato coinvolgimento e una partecipazione attiva della community.

La filosofia open e crowdsourced di LM Arena

Fondata come iniziativa open dall’Università di Berkeley e dalla comunità LMSYS, LM Arena promuove un approccio crowdsourced alla valutazione dei modelli AI, basato su dati reali, confronto diretto tra modelli, e trasparenza completa nei punteggi. La piattaforma si è evoluta per includere categorie fondamentali come matematica, codifica, scrittura creativa, risposte a istruzioni e sviluppo web, ampliando la varietà di scenari testati. L’obiettivo dichiarato di LM Arena è quello di ridurre al minimo l’influenza di benchmark sintetici, promuovendo invece un valore pratico ancorato all’esperienza utente. In questo contesto, Grok 4 si distingue per la sua versatilità, riuscendo ad adattarsi a prompt di diversa complessità e stile, mantenendo una coerenza elevata nelle risposte e una latenza ridotta anche nei task computazionalmente pesanti.

Il punto debole: la WebDev Arena

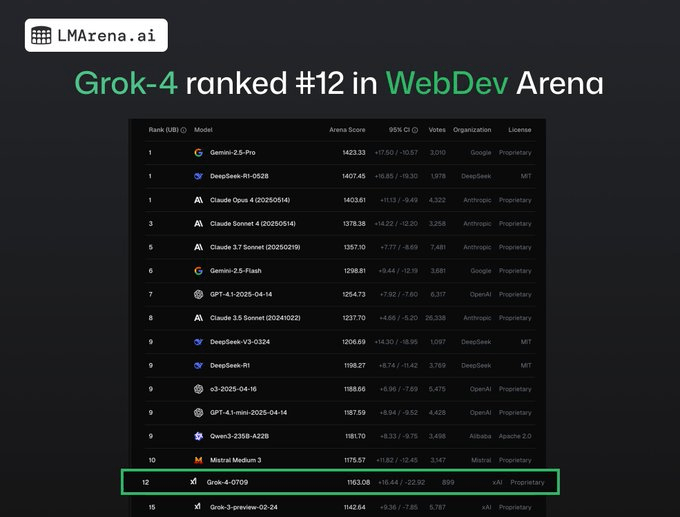

Nonostante l’eccellenza nella Text Arena, Grok 4 ha ottenuto solo il dodicesimo posto nella WebDev Arena, l’ambiente che valuta la capacità dei modelli di scrivere applicazioni web funzionanti in condizioni reali. Questo segmento, dominato da Claude, Gemini, GPT-4 e DeepSeek, mette alla prova non solo la competenza sintattica ma anche la capacità di produrre codice compatibile con ambienti di esecuzione reali. La WebDev Arena si distingue infatti per l’utilizzo di sandbox di esecuzione che testano effettivamente il funzionamento del codice generato. In questo contesto, Grok 4 mostra margini di miglioramento, probabilmente dovuti a un focus maggiore su prompt generali e complessi piuttosto che su task esecutivi concreti. Il risultato lascia emergere la necessità per xAI di calibrare meglio il modello anche su casi d’uso orientati alla produzione.

Le implicazioni per xAI e il posizionamento strategico

I risultati ottenuti da Grok 4 su LM Arena rappresentano una milestone rilevante per xAI, l’azienda fondata da Elon Musk, che continua a perseguire una visione alternativa ai modelli chiusi dominanti nel settore. La capacità di Grok 4 di raggiungere le prime posizioni nella Text Arena, superando concorrenti consolidati in alcune categorie, dimostra una maturazione significativa del modello e apre nuove opportunità per l’adozione in ambiti produttivi e di ricerca. Secondo gli analisti di settore, la presenza tra i primi tre posti nella leaderboard, ottenuta senza bias introdotti da prompt di sistema, rafforza la credibilità tecnica del modello e conferisce autorità alla metodologia di valutazione adottata da LM Arena. Allo stesso tempo, il risultato nella WebDev Arena sottolinea le sfide ancora aperte nella capacità dei modelli di gestire prompt pratici, vincolati da test reali di esecuzione e compatibilità. xAI ha già annunciato ulteriori aggiornamenti per Grok 4, focalizzati su ottimizzazione multimodale, latenza ridotta, e generalizzazione dei prompt, con l’obiettivo di ampliare la resilienza e la precisione del modello su tutti i task, inclusi quelli con output eseguibili o integrabili in pipeline applicative.

Come funziona il sistema di ranking di LM Arena

Il meccanismo alla base di LM Arena si basa su un sistema Elo rating mutuato dal mondo degli scacchi, dove ogni modello accumula o perde punti in base alle scelte binarie espresse dagli utenti in confronti diretti. Ogni prompt è sottoposto a duelli randomizzati tra modelli e i voti degli utenti determinano quale modello fornisce l’output migliore. Questo approccio riduce il rischio di valutazioni artificiali e riflette in modo più fedele la percezione dell’efficacia dei modelli nel mondo reale. Per aumentare l’affidabilità statistica, LM Arena raccoglie migliaia di valutazioni per ogni prompt e calcola la varianza di ogni modello sulle varie categorie. I test della WebDev Arena, in particolare, si basano su sandbox di esecuzione reale del codice generato, dove l’accuratezza non è solo linguistica ma dipende dalla funzionalità del prodotto creato. Questo tipo di test si sta affermando come nuovo standard per validare l’efficacia pratica dei modelli AI.

L’importanza della community nel benchmarking AI

Uno dei punti di forza di LM Arena è il coinvolgimento diretto della comunità globale degli utenti, che partecipa attivamente al processo di valutazione. La possibilità di consultare le leaderboard aggiornate in tempo reale su lmarena.ai, unita all’interfaccia semplice e al voto anonimo, ha reso la piattaforma uno strumento riconosciuto per confrontare modelli anche di produttori differenti. Questa impostazione democratizza l’accesso al benchmarking e consente una continua iterazione dei modelli su base pubblica, riducendo il rischio di metriche manipolate o orientate al marketing. Grok 4, in questo scenario, ha beneficiato di un training basato su dataset diversificati e realistici, e l’assenza di prompt guidati ha permesso di valutarne le capacità in modo più genuino.

Verso un’evoluzione della competizione tra LLM

L’ingresso di Grok 4 nel podio LM Arena segna una nuova fase nella competizione tra Large Language Models, dove l’efficacia su prompt reali sta diventando un criterio fondamentale per giudicare le capacità effettive dei modelli. Il successo di xAI conferma che è possibile ottenere risultati all’avanguardia anche al di fuori dei circuiti tradizionali, purché si adotti un approccio mirato e una strategia di training focalizzata sull’utilità concreta. LM Arena si propone come alternativa open e trasparente a benchmark chiusi, portando benefici all’intera comunità di sviluppatori, utenti e ricercatori. Per xAI, Grok 4 rappresenta un ponte verso applicazioni aziendali e consumer, con un potenziale che va oltre il puro confronto accademico e si inserisce pienamente nelle dinamiche del mercato AI globale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.