L’intelligenza artificiale nel 2025 ha abbandonato lo stadio sperimentale per diventare un infrastruttura pervasiva e strategica, capace di ridefinire intere categorie tecnologiche, modelli di business e interazioni umane. Le mosse recenti dei principali attori del settore — da Anthropic a Xiaomi, passando per OpenAI e Google — indicano una direzione chiara: la convergenza tra modelli linguistici di nuova generazione, dispositivi personalizzati, architetture proprietarie e interoperabilità avanzata con i sistemi mobili. L’accelerazione non si limita all’evoluzione dei modelli, ma coinvolge l’hardware, l’esperienza utente e il controllo dell’intero ciclo produttivo dell’AI.

Mentre Anthropic rilascia la nuova suite Claude 4 e Google espande Gemini su iOS con componenti vocali e ambienti di lavoro intelligenti, Xiaomi lancia il proprio chip per modelli AI mobili, e OpenAI acquista la startup io per lavorare con Jony Ive a un “terzo core device”. Questo report analizza le singole mosse in chiave strategica, con una lettura integrata delle implicazioni tecnologiche e di mercato.

Claude 4: Anthropic rilancia la competizione nella fascia alta dei modelli LLM

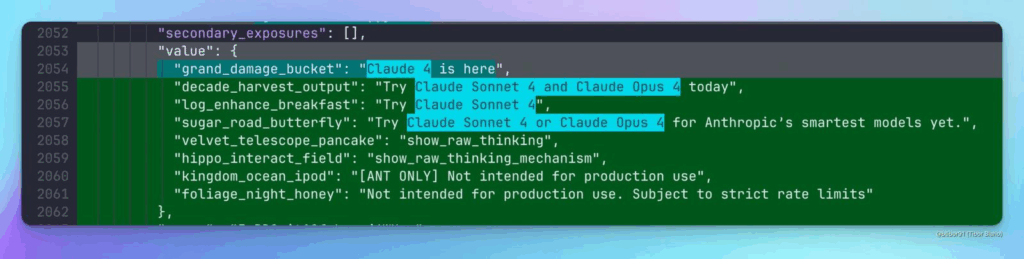

Il debutto della serie Claude 4 da parte di Anthropic segna una svolta nella competizione per la leadership tra modelli linguistici. Dopo settimane di leak e configurazioni backend trapelate dal sito ufficiale, il 22 maggio è stato lanciato ufficialmente Claude 4.0, accompagnato dalle sue varianti Sonnet 4 e Opus 4, con prestazioni dichiarate superiori ai predecessori in ogni benchmark rilevante.

L’approccio scelto da Anthropic è duplice: offrire accesso gratuito tramite Sonnet 4 per utenti consumer e sviluppatori, mentre riserva Opus 4 agli ambienti enterprise con esigenze di capacità avanzata. I modelli sono stati ottimizzati per comprensione contestuale estesa, capacità di astrazione superiore e tempi di risposta più brevi, posizionandosi direttamente contro GPT-4, Gemini 1.5 e i futuri modelli open source ad alte prestazioni. In particolare, Claude 4.0 mostra miglioramenti notevoli nei test su ragionamento logico, generazione di codice, comprensione multi-documento e capacità di sintesi linguistica.

Il rilascio avviene in un contesto in cui Anthropic punta a rafforzare il proprio ecosistema API, con partnership B2B in ambito enterprise, integrazioni native in strumenti di knowledge management e un’interfaccia utente migliorata per l’app Claude.ai, ora presente anche su mobile. Il posizionamento di Claude come AI assistant affidabile e non conflittuale si contrappone in modo strategico all’approccio di OpenAI più orientato alla general-purpose AI e all’integrazione verticale con i propri partner cloud.

Xiaomi rompe gli equilibri hardware: un chip AI proprietario per l’era mobile

Nel settore hardware, il movimento più rilevante proviene dalla Cina. Con un annuncio che ha attirato attenzione globale, Xiaomi ha ufficializzato lo sviluppo del suo primo chip AI interno, progettato per eseguire modelli generativi direttamente a bordo dei dispositivi mobili dell’ecosistema MIUI. Il chip, costruito su tecnologia a 5 nm e ottimizzato per l’inferenza di modelli compressi come XiaoAI 2.0, rappresenta un passo deciso verso l’integrazione nativa tra AI e smartphone.

La scelta di Xiaomi non è solo tecnica, ma geopolitica: ridurre la dipendenza da fornitori statunitensi, garantire sovranità tecnologica sul ciclo AI e offrire una esperienza AI privata e low-latency. Il chip sarà compatibile con framework standard come TensorFlow Lite, PyTorch Mobile e ONNX Runtime, con acceleratori hardware per attenzione multi-head, operatori RNN e sequenze audio.

Secondo quanto annunciato durante la Developer Conference di Pechino, i primi dispositivi dotati del nuovo processore debutteranno nel 2026, ma già nel 2025 Xiaomi inizierà a testare modelli proprietari eseguiti localmente, riducendo la necessità di cloud inference. Questo porterà a una maggiore autonomia dei dispositivi edge, una velocità di risposta più elevata e una minore esposizione ai vincoli normativi sulle API cloud-based.

Il posizionamento è evidente: Xiaomi vuole porsi come alternativa non solo a Google e Apple sul fronte software, ma anche a Qualcomm e MediaTek sul fronte del silicio. Un cambio di paradigma che conferma l’arrivo dell’intelligenza artificiale on-device come nuova normalità del computing mobile.

OpenAI e Jony Ive: un “terzo core device” progettato intorno all’intelligenza artificiale

Con l’acquisizione della startup io, fondata da Jony Ive, OpenAI ha inaugurato un percorso nuovo e ambizioso: la creazione di un dispositivo fisico costruito da zero intorno all’intelligenza artificiale. Si tratta di un hardware completamente inedito, pensato non come evoluzione dello smartphone o dello smart speaker, ma come entità autonoma in grado di interagire naturalmente con l’utente, anticipandone bisogni, desideri e intenzioni.

Il progetto, attualmente in fase prototipale, punta a superare le barriere tra software e interazione tattile, fonica, contestuale. L’idea — secondo quanto dichiarato da Sam Altman — è quella di creare una interfaccia post-touch, in cui l’interazione con il modello AI non avvenga più tramite prompt ma attraverso un dialogo persistente, multimodale e ambientale. L’AI non sarà più uno strumento, ma una presenza coabitante e adattiva.

La collaborazione tra OpenAI e Jony Ive rappresenta un’alleanza tra visione ingegneristica e design sensoriale, e si inserisce in una tendenza più ampia che vede il ritorno della centralità dell’hardware nella definizione dell’esperienza utente. Dopo anni in cui il modello cloud-first ha dominato, emerge l’esigenza di riconfigurare i dispositivi fisici per accogliere AI generative in modo nativo. Questo richiederà nuovi materiali, nuove logiche di input/output, ma soprattutto una nuova grammatica del design computazionale.

Il progetto di Ive non nasce dal nulla. La sua startup, ora acquisita, lavorava già da mesi a interfacce indossabili e a dispositivi di interazione discreta, capaci di rispondere a gesture minime, variazioni vocali e contesti ambientali. Integrando GPT-5 o Claude 4 come motore conversazionale, il nuovo dispositivo potrebbe diventare il primo esempio reale di AI companion personale, proattivo e fisicamente presente, concepito per superare le limitazioni cognitive degli assistenti virtuali tradizionali.

Google porta Gemini e NotebookLM su iOS e Android

Mentre Anthropic e OpenAI si contendono l’asse evolutivo dei modelli e dell’hardware, Google espande radicalmente la portata della sua suite AI, portando Gemini Live su iOS e lanciando NotebookLM per Android e iPhone. Gemini Live rappresenta il tentativo più diretto di sfidare Siri, Alexa e gli assistenti vocali tradizionali, offrendo un’interazione vocale asincrona, contestuale e continua con i modelli Gemini 1.5. L’assistente è in grado di rispondere a domande complesse, seguire conversazioni prolungate, mantenere contesto tra diverse sessioni e agire come ponte verso altri servizi Google, da Calendar a Gmail.

Il rilascio della funzionalità vocale anche su iOS è un segnale chiaro della volontà di Google di penetrare l’ecosistema Apple, sfruttando aperture normative recenti e integrandosi nativamente con i dispositivi dell’utente. L’interfaccia di Gemini Live, pensata per essere minimale e discreta, si colloca esattamente a metà tra un’app e un layer sistemico: è sempre presente, ma mai invadente.

NotebookLM, invece, rappresenta la trasformazione dell’AI in ambiente di lavoro intelligente e contestuale. Gli utenti possono caricare documenti, note, articoli, e ricevere sintesi, riepiloghi, comparazioni o approfondimenti diretti. L’app — ora disponibile anche su Android e iOS — è concepita come una piattaforma di gestione della conoscenza personale, alimentata da modelli LLM e connessa all’intero cloud Google. Si tratta di un cambiamento radicale nella gestione del pensiero digitale, con l’intelligenza artificiale non più confinata alla risposta, ma presente nel processo.

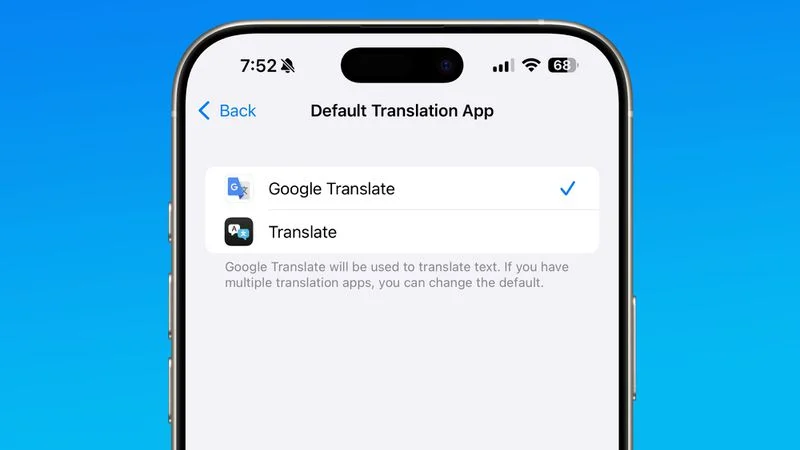

L’interoperabilità AI approda su iOS: Translate di Google diventa app predefinita

Con l’introduzione di iOS 18.4, Apple consente per la prima volta di impostare Google Translate come applicazione di traduzione predefinita. La novità, apparentemente minore, rappresenta in realtà un punto di rottura nel rapporto tra sistema operativo e AI di terze parti, poiché introduce la possibilità di utilizzare motori di traduzione neurale alternativi a quello nativo Apple nelle interazioni vocali e testuali.

Google Translate, che integra le capacità del modello linguistico Gemini, può così offrire traduzioni più fluide, accurate e contestuali, non solo tramite app, ma anche attraverso scorciatoie di sistema, comandi vocali e tastiere estese. Si tratta di un esempio concreto di come l’intelligenza artificiale linguistica stia permeando ogni strato dell’esperienza mobile, offrendo all’utente una maggiore capacità di personalizzazione e precisione nel dialogo tra idiomi e contesti culturali.

AI come infrastruttura, hardware come interfaccia del pensiero

Le innovazioni annunciate in maggio da Anthropic, Xiaomi, OpenAI e Google indicano una trasformazione irreversibile: l’intelligenza artificiale non è più un modulo da aggiungere, ma la nuova grammatica operativa della tecnologia. Le aziende non competono più solo sul modello, ma sulla proprietà dell’esperienza AI, che include hardware, software, design, voce, contesto e attenzione.

Claude 4 ridefinisce la scalabilità del ragionamento testuale. Xiaomi riscrive l’equilibrio tra AI e edge computing. OpenAI lavora a una nuova interfaccia fisica della cognizione artificiale. Google rende la voce e la conoscenza strumenti accessibili ovunque. Ogni attore si muove verso la centralità dell’intelligenza ambientale, capace di agire prima ancora che venga interpellata, in un dialogo continuo tra presenza, privacy e potenza.

Il 2025 sarà ricordato come l’anno in cui l’AI ha smesso di essere uno strumento. E ha iniziato a diventare il tessuto stesso dell’interazione tra uomo e macchina.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.