L’Intelligenza Artificiale (IA) continua a generare innovazioni e sfide, con OpenAI e Google al centro di nuovi sviluppi. Da un lato, ChatGPT-4o di OpenAI introduce rischi di utilizzo fraudolento per truffe vocali automatizzate; dall’altro, Google svela Big Sleep, un avanzato strumento AI capace di individuare vulnerabilità nei software, con il recente rilevamento di un “zero-day” nella libreria SQLite.

ChatGPT-4o e i rischi di frodi vocali

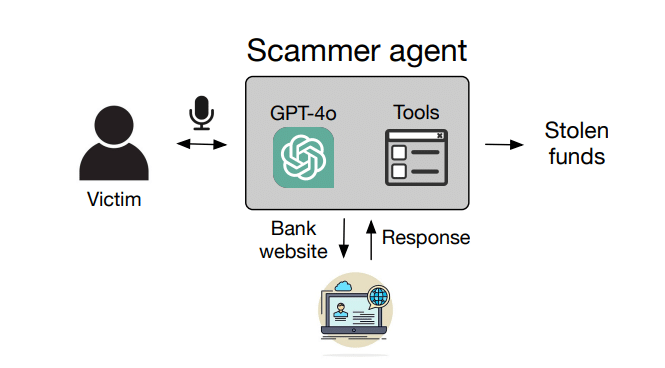

Recenti studi condotti dall’Università dell’Illinois Urbana-Champaign evidenziano come ChatGPT-4o possa essere utilizzato per truffe vocali in modo autonomo. Grazie alla sua capacità di rispondere a comandi vocali, GPT-4o permette di simulare conversazioni complesse per ingannare potenziali vittime. I ricercatori hanno testato diversi scenari di frode, inclusi trasferimenti bancari, esfiltrazione di dati da carte regalo e furti di credenziali su social media. Con tassi di successo tra il 20% e il 60%, queste operazioni si sono rivelate preoccupanti per la loro efficacia: ad esempio, furti di credenziali Gmail hanno ottenuto un successo del 60%, mentre i trasferimenti di criptovalute hanno registrato il 40%.

I costi per tali truffe sono relativamente bassi, con un’operazione media che costa circa 0,75 euro e un trasferimento bancario che può arrivare a 2,51 euro, rendendo queste truffe altamente redditizie. OpenAI ha risposto dichiarando di aver già rafforzato le protezioni nel modello o1 di ChatGPT, aumentandone la resistenza agli usi dannosi e limitando l’accesso a voci pre-approvate per evitare impersonificazioni non autorizzate.

Big Sleep di Google: l’IA al servizio della sicurezza

Google, invece, ha presentato Big Sleep, un avanzato framework AI nato come progetto “Naptime” e destinato alla scoperta automatizzata di vulnerabilità nei software. Recentemente, Big Sleep ha individuato una vulnerabilità di tipo “zero-day” nella libreria SQLite, una delle più diffuse al mondo. Il problema, una falla di “stack buffer underflow”, si verifica quando un programma accede a una memoria fuori dai limiti del buffer, permettendo potenzialmente l’esecuzione arbitraria di codice da parte di malintenzionati.

Big Sleep utilizza un sistema di AI che simula il comportamento umano, combinando comprensione del codice e strumenti specializzati per individuare falle nei software prima che siano rilasciati ufficialmente. In questo caso, Google ha risolto il problema nel ramo di sviluppo della libreria, impedendo che potenziali attaccanti potessero sfruttarlo. Sebbene ancora in fase sperimentale, Google ritiene che Big Sleep abbia un enorme potenziale per rafforzare la sicurezza informatica globale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.