Sommario

Un’indagine condotta dall’osservatorio Internet di Stanford ha rilevato una preoccupante presenza di materiale di abuso sessuale su minori (CSAM) sulla piattaforma social Mastodon. Il materiale includeva molti esempi noti che avrebbero dovuto essere automaticamente rilevati attraverso l’impronta digitale.

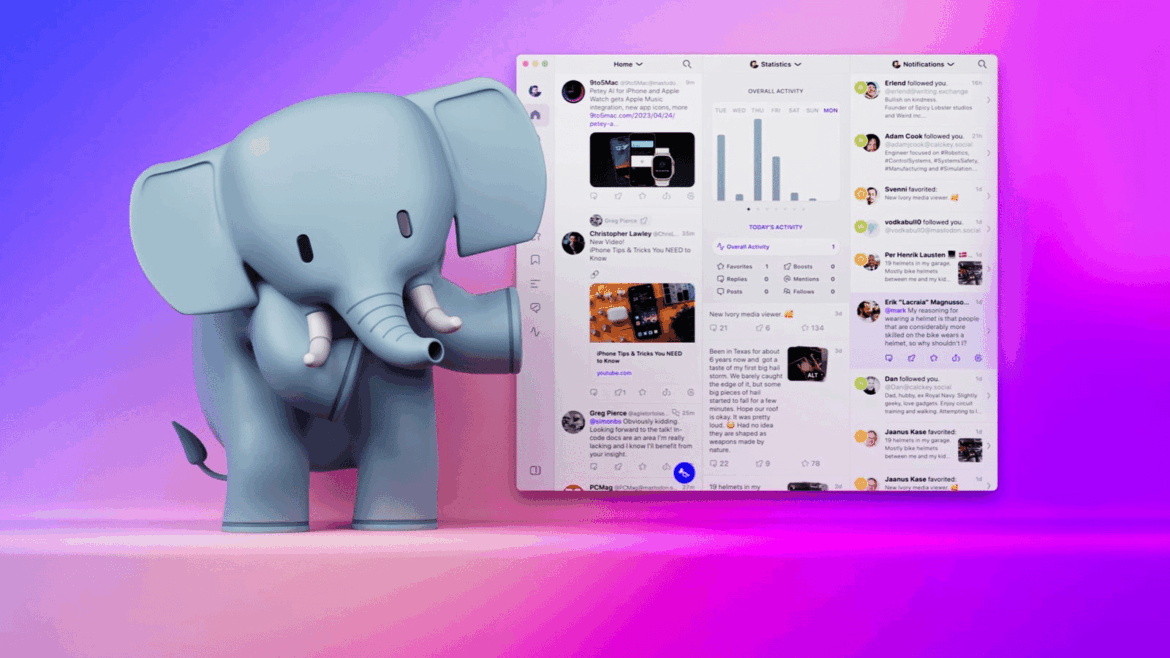

La natura aperta di Mastodon e i problemi di contenuto

Chiunque può creare un server Mastodon, che poi si collega ad altri server (o “istanze”) per formare quello che appare come un unico social network, ma che non ha proprietà o controllo centrale. Questo è un problema quando si tratta di contenuto illegale e problematico, affermano i ricercatori.

Dettagli dell’indagine

Durante un test di due giorni, i ricercatori dell’Osservatorio Internet di Stanford hanno trovato oltre 600 pezzi di materiale noto o sospettato di abuso su minori su alcune delle reti più popolari di Mastodon. Hanno segnalato di aver trovato il loro primo pezzo di contenuto contenente sfruttamento di minori entro circa cinque minuti. Sono andati avanti per scoprire circa 2.000 utilizzi di hashtag associati a tale materiale.

La necessità di strumenti di scansione

Nonostante la natura aperta di Mastodon abbia molti vantaggi, i ricercatori di Stanford affermano che la rete ha bisogno di sfruttare gli stessi tipi di strumenti di scansione utilizzati da piattaforme chiuse come Twitter e Facebook.