La lotta contro lo sfruttamento sessuale online dei minori (OCSEA) si arricchisce di un nuovo strumento: Lantern. Questo programma, annunciato oggi dalla Tech Coalition, un gruppo di aziende tecnologiche unite per combattere questa piaga, rappresenta un tentativo di prevenire che i predatori eludano il rilevamento spostando le potenziali vittime su altre piattaforme.

Un database condiviso per la sicurezza dei minori

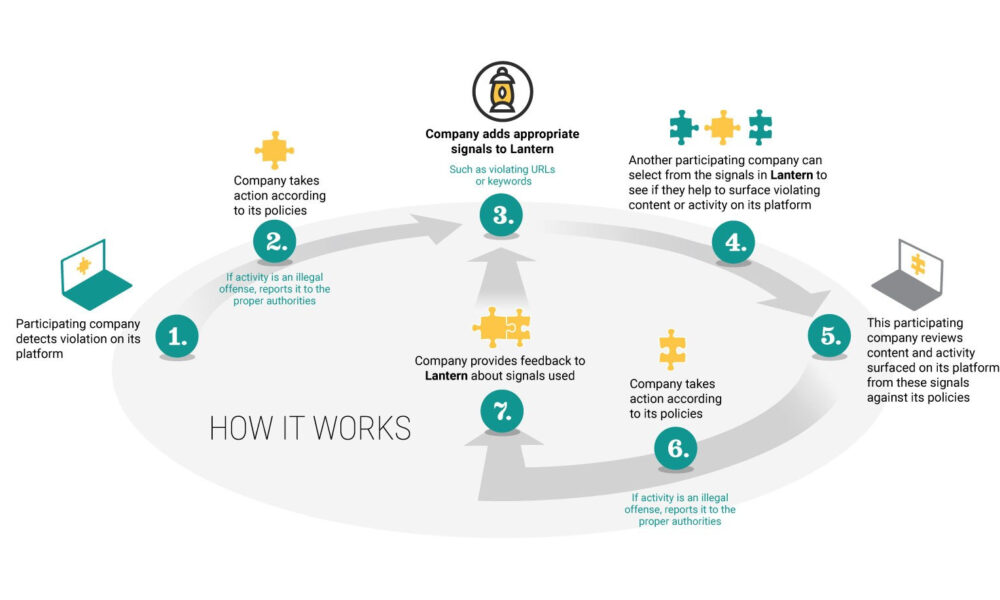

Lantern funge da database centrale dove le aziende possono contribuire con dati e verificare le proprie piattaforme. Quando emergono segnali di violazione delle politiche OCSEA, come indirizzi email o nomi utente noti, hash di materiale di abuso sessuale su minori (CSAM) o parole chiave CSAM, le aziende possono segnalarli nei propri sistemi. Sebbene questi segnali non provino direttamente l’abuso, facilitano le indagini e le azioni conseguenti, come la chiusura di un account o la segnalazione alle autorità.

Risultati tangibili nella fase pilota di Lantern

Durante la fase pilota di Lantern, Meta ha utilizzato informazioni condivise da uno dei partner del programma, Mega, per rimuovere “oltre 10.000 profili, pagine Facebook e account Instagram” violatori e segnalarli al National Center for Missing and Exploited Children.

La partecipazione attiva di Discord e altri giganti tech

Anche Discord, attraverso il capo della sicurezza John Redgrave, ha confermato di aver agito su dati condivisi tramite il programma, assistendo in molte indagini interne. Tra i partecipanti a Lantern figurano Discord, Google, Mega, Meta, Quora, Roblox, Snap e Twitch. I membri della coalizione hanno sviluppato Lantern negli ultimi due anni, assicurandosi che il programma superasse la “verifica di idoneità” e fosse conforme ai requisiti legali e regolamentari, oltre che “eticamente accettabile”.

Questioni di privacy e diritti umani

Uno dei grandi interrogativi riguarda l’efficacia del programma senza generare nuovi problemi. Un episodio del 2021 ha visto un padre indagato dalla polizia dopo che Google lo aveva segnalato per CSAM a causa di foto dell’infezione inguinale del figlio. Gruppi vari hanno avvertito che problemi simili potrebbero sorgere con la funzione di scansione CSAM della libreria foto iCloud di Apple, ora cancellata.

La Tech Coalition ha commissionato una valutazione dell’impatto sui diritti umani da parte di Business for Social Responsibility (BSR), che fornirà consulenza continua man mano che il programma si evolve. La coalizione supervisionerà Lantern, stabilendo linee guida e regole chiare per la condivisione dei dati, con formazione obbligatoria e controlli di routine per le aziende coinvolte, e rivedendo regolarmente le proprie politiche e pratiche.