Sommario

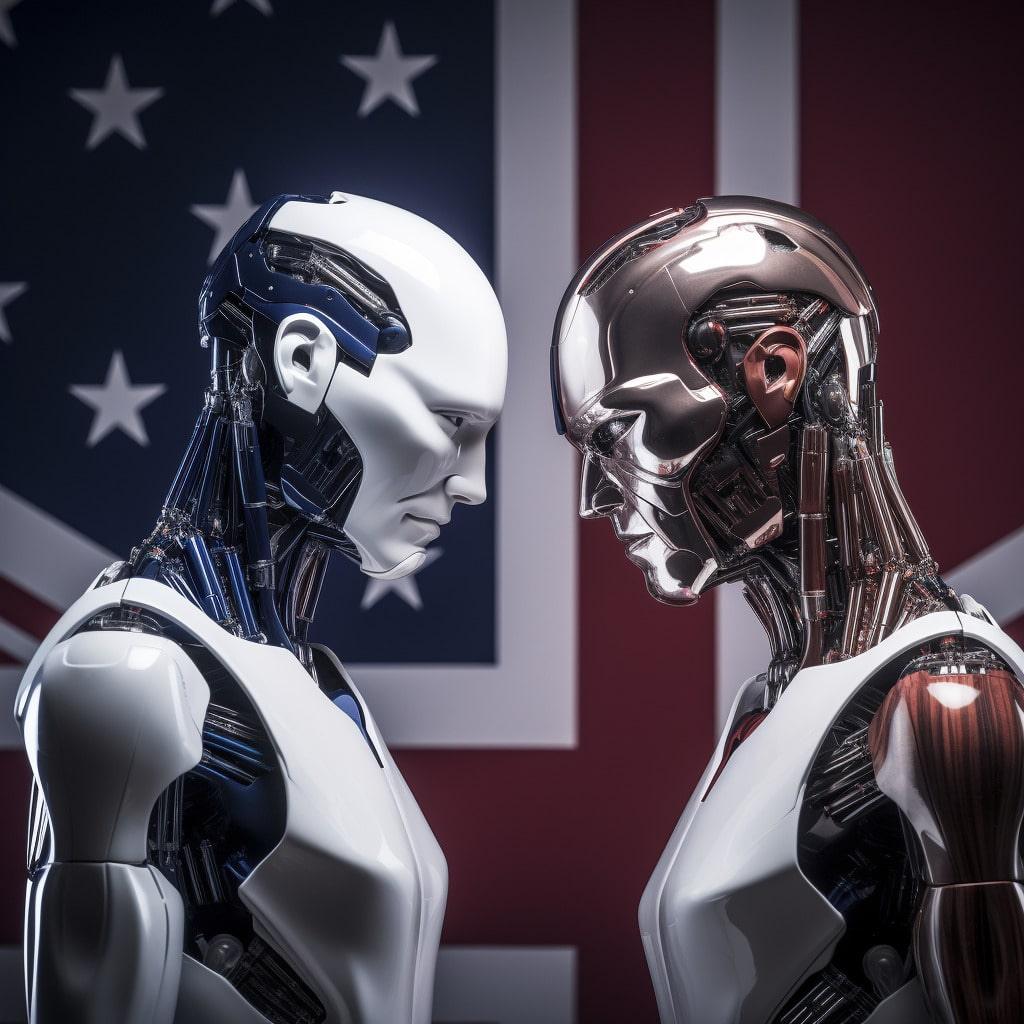

La Cybersecurity and Infrastructure Security Agency (CISA) degli USA e il National Cyber Security Centre (NCSC) dell’UK, insieme a partner internazionali, hanno rilasciato nuove linee guida per lo sviluppo sicuro di sistemi di intelligenza artificiale (AI). Questa iniziativa, supportata da 23 organizzazioni di cybersecurity nazionali e internazionali, rappresenta un passo significativo nel trattare l’intersezione tra AI, cybersecurity e infrastrutture critiche.

Cosa prevedono le nuove Linee Guida AI?

Le linee guida, che integrano gli “Impegni Volontari degli Stati Uniti per un’IA Sicura, Protetta e Affidabile”, forniscono raccomandazioni essenziali per lo sviluppo di sistemi AI. L’approccio adottato enfatizza l’importanza di aderire ai principi di “Secure by Design”, ovvero la progettazione sicura fin dall’inizio. Questo approccio priorizza la proprietà dei risultati di sicurezza per i clienti, promuove una trasparenza e responsabilità radicali e stabilisce strutture organizzative dove la progettazione sicura è una priorità assoluta.

Come si applicano? Quali sono gli obiettivi?

Le linee guida si applicano a tutti i tipi di sistemi AI, non solo ai modelli all’avanguardia. Forniscono suggerimenti e mitigazioni per aiutare scienziati dei dati, sviluppatori, manager, decisori e proprietari del rischio a prendere decisioni informate riguardo alla progettazione sicura, allo sviluppo del modello, allo sviluppo del sistema, al suo dispiegamento e alla sua operatività.

Protezione contro vulnerabilità e abusi

Le linee guida mirano anche a combattere gli attacchi adversariali che prendono di mira i sistemi AI e di apprendimento automatico (ML), che possono causare comportamenti non intenzionali in vari modi, inclusa l’alterazione della classificazione di un modello, permettendo azioni non autorizzate e l’estrazione di informazioni sensibili. Questi attacchi possono includere l’iniezione di prompt negli attacchi ai modelli di grandi dimensioni o la corruzione deliberata dei dati di addestramento o del feedback degli utenti (noto come “data poisoning”).

Le nuove linee guida per lo sviluppo sicuro di sistemi AI tracciate da USA e UK rappresentano un importante passo avanti nella gestione dei rischi associati all’Intelligenza Artificiale, garantendo che la tecnologia sia progettata, sviluppata e implementata in modo sicuro. Questo sforzo congiunto tra Stati Uniti, Regno Unito e partner internazionali sottolinea l’importanza di una collaborazione globale nella promozione di sistemi AI sicuri e affidabili.