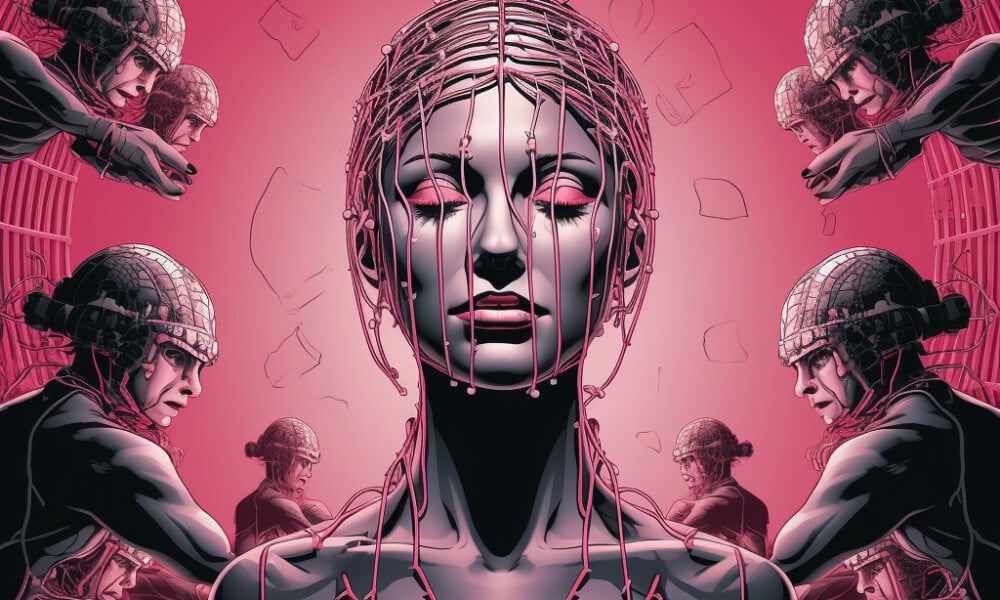

In un periodo in cui la digitalizzazione sta raggiungendo nuovi picchi, la sicurezza informatica è più importante che mai. Recentemente, è emersa una tendenza preoccupante: l’uso di strumenti di intelligenza artificiale generativa come ChatGPT per scopi malevoli. Questo articolo esplora come le comunità online stanno collaborando per trovare nuovi modi per violare le regole etiche di ChatGPT e come i hacker stanno sviluppando una rete di nuovi strumenti per sfruttare o creare modelli di lingua grande (LLM) per fini malevoli.

Il fenomeno del jailbreaking di ChatGPT

Da dicembre, i hacker sono alla ricerca di nuovi e inventivi prompt per manipolare ChatGPT e modelli di lingua grande open-source che possono essere riutilizzati per scopi malevoli. Questo ha dato origine a una comunità di hacking LLM ancora in fase nascente ma in fiorente espansione, che possiede molti prompt intelligenti ma pochi malware abilitati all’IA che valgono una seconda considerazione. Questi “ingegneri dei prompt” cercano di manipolare i chatbot come ChatGPT facendo domande astute per farli violare le loro regole programmate, un esercizio che richiede una grande quantità di tentativi e errori.

WormGPT e l’ascesa dei LLM malevoli

A luglio è apparso WormGPT, dando il via al fenomeno dei LLM malevoli. Si tratta di un’alternativa “black-hat” ai modelli GPT, progettata specificamente per attività malevole come attacchi BEC, malware e phishing. WormGPT, che non ha limiti etici o restrizioni, è stato creato su un modello di lingua personalizzato, con un’enfasi sui dati relativi agli attacchi informatici. Questo significa che i hacker possono ora eseguire attacchi a larga scala a costi molto ridotti, con una mira molto più precisa rispetto al passato.

Difesa contro le cyber-armi IA di nuova generazione

Sebbene WormGPT e i suoi simili non rappresentino ancora una minaccia significativa per le aziende, l’ascesa dei mercati del jailbreaking sotterraneo indica che stanno diventando disponibili più strumenti per i cybercriminali. Questo preannuncia un ampio cambiamento nel campo dell’ingegneria sociale e nel modo in cui ci difendiamo da essa. Gli esperti consigliano di non affidarsi solo alla formazione, ma di adottare strumenti IA per rilevare, prevedere e bloccare queste minacce emergenti.