L’intelligenza artificiale (AI) sta trasformando il panorama delle minacce informatiche, con applicazioni che vanno dalla creazione di contenuti fraudolenti al potenziamento delle campagne di disinformazione. Due rapporti recenti, uno dell’FBI e l’altro sul caso di disinformazione orchestrata dalla Russia, mettono in evidenza la portata e l’impatto di queste tecnologie.

Frodi AI-driven: il rapporto dell’FBI

L’FBI ha emesso un avviso pubblico riguardo l’uso crescente di strumenti di AI generativa da parte di criminali per ottimizzare campagne di frode e inganno online. Questi strumenti vengono utilizzati per:

- Creazione di contenuti manipolatori: deepfake audio e video vengono prodotti per impersonare autorità e celebrità in modo realistico, convincendo le vittime a fornire denaro o informazioni sensibili.

- Profili social falsi e phishing mirato: la combinazione di immagini generate dall’AI e messaggi personalizzati aumenta il tasso di successo delle truffe.

- Estorsioni tramite contenuti intimi: immagini pornografiche false vengono create per ricattare vittime o diffamare figure pubbliche.

- Disastri fittizi e false richieste di donazioni: l’AI viene usata per creare immagini convincenti di catastrofi inesistenti per attirare donazioni fraudolente.

L’agenzia consiglia di adottare misure preventive:

- Verifica dell’identità: stabilire parole o frasi segrete con familiari o colleghi.

- Analisi dei dettagli: identificare anomalie in immagini o video, come ombre distorte o movimenti innaturali.

- Limitazione della condivisione di dati personali: proteggere profili social e monitorare le richieste sospette.

Queste misure non eliminano il rischio, ma riducono significativamente le probabilità di cadere vittima di tali schemi.

Operazione Undercut: disinformazione alimentata dall’AI

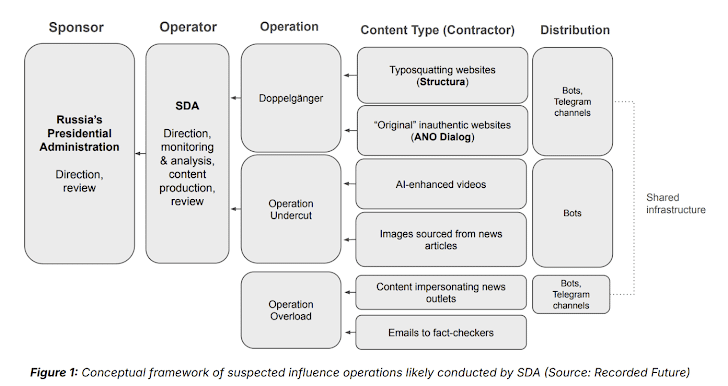

La campagna Operation Undercut, condotta dalla Social Design Agency (SDA) con sede a Mosca, utilizza l’AI per diffondere contenuti manipolatori e minare la fiducia nelle istituzioni. Obiettivi principali:

- Discreditare l’Ucraina: contenuti creati con AI sono usati per presentare la leadership ucraina come inefficace e corrotta, cercando di ridurre il supporto militare occidentale.

- Manipolazione elettorale: le campagne mirano a influenzare il risultato delle elezioni negli Stati Uniti e in Europa, sfruttando argomenti divisivi.

- Creazione di ecosistemi falsi: siti di fact-checking fraudolenti e account social inautentici promuovono narrazioni coerenti con gli obiettivi geopolitici russi.

I contenuti vengono distribuiti attraverso reti sociali, utilizzando hashtag virali e siti che imitano fonti affidabili per guadagnare credibilità.

Tecniche e implicazioni delle campagne AI-driven

L’uso dell’AI in operazioni come Operation Undercut e nelle frodi segnalate dall’FBI evidenzia un’innovazione nelle metodologie utilizzate dai malintenzionati. Tra le tecniche principali emergono:

- Deepfake audio e video: sfruttati per simulare comunicazioni realistiche, convincere le vittime della legittimità di richieste fraudolente o amplificare contenuti di disinformazione. Questi strumenti rendono difficile distinguere tra reale e artificiale.

- Imitazione di siti affidabili: l’AI permette di clonare con estrema precisione l’aspetto di fonti autorevoli, aumentando la probabilità che gli utenti credano a contenuti manipolatori.

- Amplificazione tramite social media: centinaia di account generati automaticamente sono utilizzati per diffondere contenuti e manipolare discussioni online, creando l’impressione di consenso diffuso.

Le implicazioni di tali sviluppi sono vaste:

- Erosione della fiducia: sia nelle istituzioni che nei media, poiché gli utenti trovano sempre più difficile verificare l’autenticità delle informazioni.

- Sovraccarico cognitivo: la costante esposizione a contenuti manipolati può confondere gli utenti e influenzare decisioni critiche, incluse quelle elettorali.

- Minacce alla sicurezza nazionale: campagne come quella della SDA cercano di destabilizzare alleanze politiche e militari, amplificando le divisioni interne.

Le tecnologie AI stanno trasformando la natura delle minacce digitali. Frodi e disinformazione basate sull’AI non solo aumentano l’efficacia delle campagne malevole, ma pongono anche sfide senza precedenti per la sicurezza globale. La collaborazione tra governi, aziende tecnologiche e utenti è essenziale per contrastare queste minacce in continua evoluzione.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.