OpenAI ha pubblicato un dettagliato rapporto dal titolo “Disrupting Malicious Uses of AI”, volto a documentare dieci campagne malevole condotte tramite modelli linguistici, spesso legate a operazioni di influenza geopolitica, ingegneria sociale e cyberspionaggio. Il documento rappresenta un passo significativo nella strategia di trasparenza e contrasto agli abusi dell’intelligenza artificiale, confermando il coinvolgimento di attori presumibilmente connessi a Cina, Corea del Nord, Russia, Iran, Cambogia e Filippine.

Attraverso una combinazione di analisi comportamentale, tracciamento delle attività e confronto tra output generati e contenuti pubblicati online, OpenAI ha identificato pattern ricorrenti di utilizzo fraudolento di ChatGPT, smantellando numerose reti digitali impegnate in azioni che spaziano dalle truffe occupazionali all’inquinamento informativo.

Operazioni truffaldine e identità digitali costruite con l’IA

Uno dei casi più emblematici analizzati nel report è legato a una campagna di assunzioni ingannevoli condotta da operatori che tentavano di sfruttare ChatGPT per fabbricare curricula, lettere motivazionali, risposte a domande tecniche e perfino messaggi per reclutare complici. Alcuni elementi sono riconducibili agli IT worker schemes della Corea del Nord, già oggetto di indagini del Dipartimento di Giustizia USA.

Queste attività prevedevano:

– Generazione automatizzata di profili professionali credibili per il mercato statunitense

– Utilizzo di strumenti di geolocalizzazione falsata per far apparire candidati localizzati in USA

– Ricorso a tecnologie come OBS Studio, Tailscale, vdo.ninja per simulare videoconferenze

– Reclutamento di individui disposti a ricevere hardware aziendale da usare come terminale remoto

Questa combinazione di automatismi, deep fake comportamentali e architetture di anonimato evidenzia come l’intelligenza artificiale stia diventando un moltiplicatore operativo per le truffe ad alta complessità.

Influenze occulte su social media: dalle Filippine alla Cina

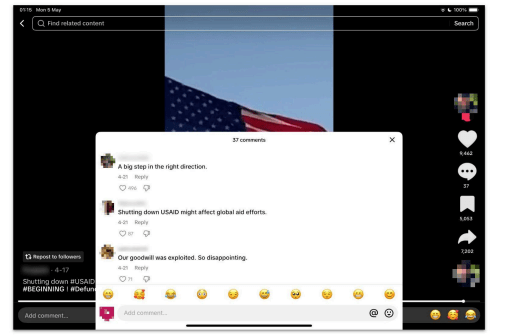

Tra i casi di covert influence operations (IO), emerge l’operazione “High Five”, associata a Comm&Sense Inc, agenzia di marketing nelle Filippine. Usando ChatGPT, sono stati generati migliaia di commenti sintetici a sostegno del presidente Marcos e contro la vicepresidente Duterte. Le stesse dinamiche sono riscontrate nell’operazione “Sneer Review”, con origine cinese presunta, basata su post multilingua (cinese, inglese, urdu) che criticano oppositori della Belt and Road Initiative e promuovono contenuti filogovernativi su TikTok e X (ex Twitter).

In particolare:

– Commenti pilotati su contenuti riguardanti Taiwan e la chiusura di USAID

– Falsi video accusatori contro attivisti come Mahrang Baloch, con commenti artificiali di supporto

– Pubblicazione parallela su Facebook, Reddit e forum online per simulare consenso diffuso

Queste operazioni sono state classificate da OpenAI come a impatto moderato (categoria 2 o 3 sulla scala IO Breakout), ma rappresentano comunque una minaccia alla qualità del dibattito pubblico e alla sicurezza informativa nei contesti democratici.

Cyber spionaggio e inganno tecnico: il caso dei contractor russi e degli operatori iraniani

Il report di OpenAI evidenzia anche operazioni legate a cyber spionaggio, tra cui l’attività del collettivo russo Doppelganger, già noto per la diffusione di disinformazione anti-ucraina. Questi attori hanno impiegato modelli IA per:

– Tradurre automaticamente contenuti propagandistici

– Ottimizzare la stesura di articoli da pubblicare su siti fasulli o ricondividere su piattaforme legittime

– Generare post simili per evitare rilevamento algoritmico su piattaforme social

Parallelamente, operatori legati all’Iran hanno impiegato ChatGPT in contesti meno sofisticati, come traduzioni, articoli di blog anti-israeliani e notizie manipolate a tema geopolitico. Queste attività non sempre avevano finalità dirette di attacco, ma miravano a costruire un contesto di narrativa ideologica ostile, spesso veicolato tramite fonti semi-credibili e condiviso in canali Telegram o reti proxy.

OpenAI ha identificato oltre 20 account sospetti direttamente coinvolti in queste attività, disattivandoli e segnalando i pattern d’uso a partner industriali e agenzie di sicurezza.

Politiche proattive e proposta per un piano d’azione nazionale USA

Il lavoro di contrasto ai contenuti malevoli ha spinto OpenAI a pubblicare una proposta ufficiale per la creazione di un piano d’azione AI per gli Stati Uniti, articolato in cinque pilastri operativi:

- Rafforzamento delle norme di sicurezza per i modelli di base, includendo testing esterno e audit indipendenti

- Adozione di una etichettatura standardizzata per contenuti sintetici, compatibile con formati C2PA e watermark invisibili

- Integrazione di sistemi di monitoraggio e allerta rapida tra aziende tecnologiche e autorità federali

- Promozione di protocolli di trasparenza pubblica su interventi di contenimento o sospensione account

- Coordinamento interagenzia per affrontare le minacce ibride e l’influenza straniera attraverso l’IA

La proposta evidenzia la necessità di interventi legislativi coordinati, in grado di coniugare libertà di innovazione e sicurezza collettiva, evitando che strumenti generativi diventino armi per la manipolazione sociale o l’inganno transnazionale.

Analisi dei limiti strutturali nei LLM e vettori di abuso

La capacità dei modelli linguistici di generare testo plausibile e contestualizzato li rende strumenti potenti, ma anche vulnerabili a prompt injection, jailbreaking e utilizzi reiterati per scopi malevoli. Il report sottolinea la necessità di implementare:

– rate limiting per utenti e script sospetti

– filtri sintattici avanzati per rilevare richieste anomale

– moduli di apprendimento continuo per riconoscere pattern operativi avversari

Questo richiede una evoluzione continua dei framework di sicurezza, che integrino machine learning difensivo e contromisure AI-native. L’intersezione tra cybersicurezza e AI non è più teoria, ma una priorità strategica per governi e sviluppatori.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.