A metà giugno 2025, due notizie nel campo dell’intelligenza artificiale pongono al centro il tema del controllo – da una parte OpenAI introduce una nuova funzionalità nel suo AI coder Codex, consentendo agli sviluppatori di scegliere tra più soluzioni proposte, dall’altra, Meta è travolta dalle polemiche per una funzione di condivisione automatica che rende pubbliche chat private con il suo assistente AI. Il contrasto è emblematico: mentre un sistema punta sull’empowerment dell’utente, l’altro mostra quanto la mancanza di trasparenza possa minare la fiducia in un ecosistema digitale.

Cosa leggere

Codex migliora: ora gli sviluppatori scelgono l’output ideale

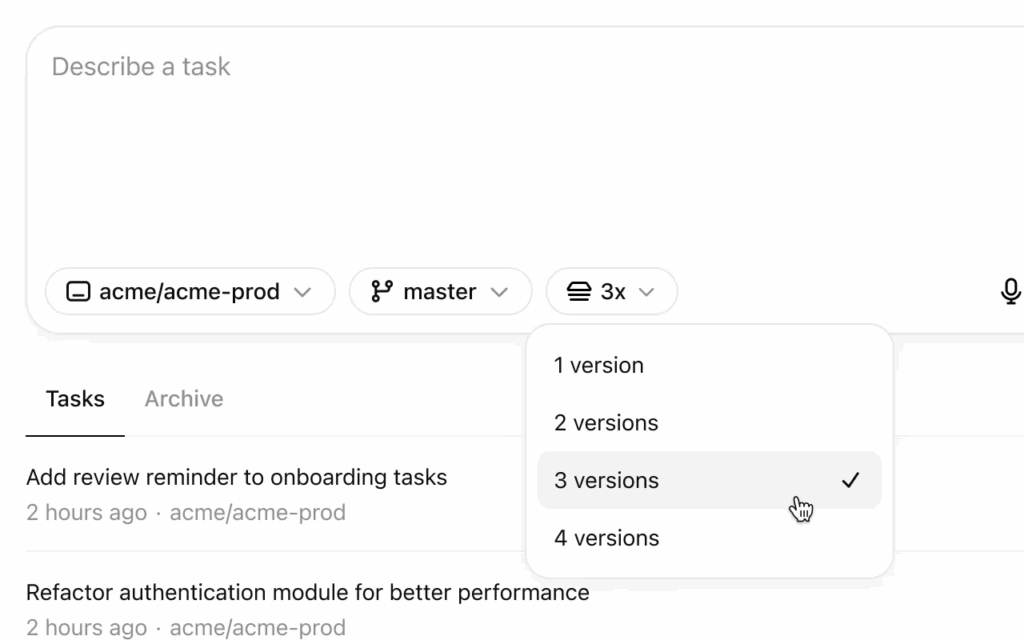

OpenAI ha aggiornato Codex, il modulo integrato in ChatGPT dedicato alla generazione di codice, con una nuova funzione che propone più opzioni di soluzione per ogni richiesta. Lo strumento, ora disponibile in anteprima per alcuni utenti Pro e Enterprise, permette agli sviluppatori di valutare diverse implementazioni di uno stesso algoritmo o struttura software, accelerando così la fase di valutazione e test.

Ogni volta che l’utente richiede una funzione – ad esempio “scrivi una funzione Python per ordinare una lista con merge sort” – Codex mostra tre o più varianti, ciascuna con commenti, struttura diversa o ottimizzazioni specifiche. L’utente può visualizzare rapidamente il codice generato, confrontare le versioni, ed eventualmente selezionare quella più leggibile o più adatta al contesto.

Il sistema adotta un’interfaccia a schede (tabs), dove è possibile anche dare un voto alla soluzione, aiutando così il modello a migliorare le proposte future. Questa innovazione non solo potenzia il supporto alla scrittura di codice, ma rappresenta un esempio concreto di IA assistiva e controllabile, che non impone ma collabora in modo trasparente.

Meta AI e il caso delle chat pubbliche: non è un bug, è una funzione documentata

Nel frattempo, Meta AI si trova al centro di un’accesa polemica innescata dalla scoperta che alcune chat degli utenti vengono indicizzate pubblicamente nei motori di ricerca. Diversi utenti hanno segnalato che frasi o estratti delle loro interazioni con l’assistente AI di Meta risultavano visibili pubblicamente via URL, senza alcuna richiesta esplicita di pubblicazione.

L’azienda ha confermato che non si tratta di un bug, ma di una funzionalità attiva nei laboratori Meta AI. Ogni volta che un utente genera contenuti con l’assistente, il sistema può – se attivata l’opzione “Share” – creare una pagina pubblica accessibile tramite link diretto. Sebbene Meta abbia incluso un disclaimer nella documentazione, questo non era evidenziato né nel prompt, né nell’interfaccia principale, portando molti utenti a condividere inconsapevolmente contenuti sensibili o personali.

Meta ha difeso la funzione come parte del programma “AI Showcases”, dove gli output più interessanti vengono archiviati per allenare meglio i modelli e ispirare altri utenti. Tuttavia, mancano controlli granulari, come la possibilità di revocare una pubblicazione o gestire un elenco delle conversazioni rese pubbliche.

Rischi per la privacy e implicazioni legali

La questione solleva preoccupazioni significative sul piano della privacy e della protezione dei dati. Se un utente utilizza Meta AI per scrivere un documento di lavoro, un’email simulata, o anche solo una bozza di contenuto personale, e questo viene pubblicato senza consapevolezza, si configura una potenziale violazione della normativa GDPR e del CCPA. Alcuni avvocati specializzati in diritto digitale hanno già segnalato che questa modalità di pubblicazione potrebbe risultare non conforme, anche se autorizzata nei termini d’uso, in quanto l’interfaccia non rende sufficientemente evidente il rischio.

Meta ha promesso un aggiornamento dell’interfaccia per rendere il comportamento del pulsante “Share” più chiaro, e sta valutando l’introduzione di un pannello di gestione delle condivisioni attive. Tuttavia, il danno reputazionale potrebbe essere già compiuto, soprattutto in ambienti dove riservatezza, sicurezza e controllo del dato sono aspetti fondamentali.

I due casi mostrano due facce dell’evoluzione AI: da un lato l’empowerment proattivo dell’utente attraverso interfacce trasparenti, come nel caso di Codex, dall’altro una funzione che, pur pensata per l’ottimizzazione e la collaborazione, espone l’utente a rischi concreti se non gestita con chiarezza e strumenti di controllo. In ambito professionale, la scelta di soluzioni AI dovrebbe sempre privilegiare il controllo semantico, l’auditabilità e l’interazione consapevole.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.