Due incidenti separati evidenziano le vulnerabilità persistenti nelle infrastrutture IT e nei sistemi di intelligenza artificiale. Gli aggiornamenti di sicurezza Microsoft per Windows Server 2022 e 2019, rilasciati nell’ambito del Patch Tuesday, hanno causato malfunzionamenti del servizio DHCP, impedendo il corretto rilascio degli indirizzi IP e bloccando l’accesso alla rete per numerosi client. Parallelamente, Google ha reso pubblica una nuova strategia tecnica per mitigare gli attacchi di prompt injection indiretta, che minacciano i sistemi di AI conversazionale come Gemini e ChatGPT. Entrambe le situazioni richiamano l’attenzione sulle fragilità operative e di sicurezza di tecnologie chiave nel panorama enterprise e cloud.

Cosa leggere

Aggiornamenti Microsoft: i server DHCP non assegnano IP ai client

Dopo il rilascio degli aggiornamenti KB5039227 (per Windows Server 2022) e KB5039226 (per Windows Server 2019), amministratori di sistema in tutto il mondo hanno segnalato un problema critico: i server DHCP non riescono più ad assegnare indirizzi IP ai dispositivi della rete. Gli effetti sono blocchi di rete, impossibilità di autenticazione sui domini Active Directory, e interruzioni nei servizi che dipendono da IP dinamici.

Microsoft ha confermato il problema e sta attualmente indagando, mentre alcune soluzioni temporanee includono la disinstallazione della patch o il passaggio temporaneo all’assegnazione statica degli IP. L’impatto è particolarmente critico in ambienti enterprise dove centinaia di client e dispositivi dipendono da DHCP centralizzati.

- Windows Server 2016 (KB5061010)

- Windows Server 2019 (KB5060531)

- Windows Server 2022 (KB5060526)

- Windows Server 2025 (KB5060842)

La vulnerabilità sembra derivare da una modifica nel modulo che gestisce le richieste DHCP con autenticazione, che non riesce a completare la transazione con il client. In alcuni casi, gli eventi nei log indicano errori generici, ma non sono presenti crash evidenti o schermate blu.

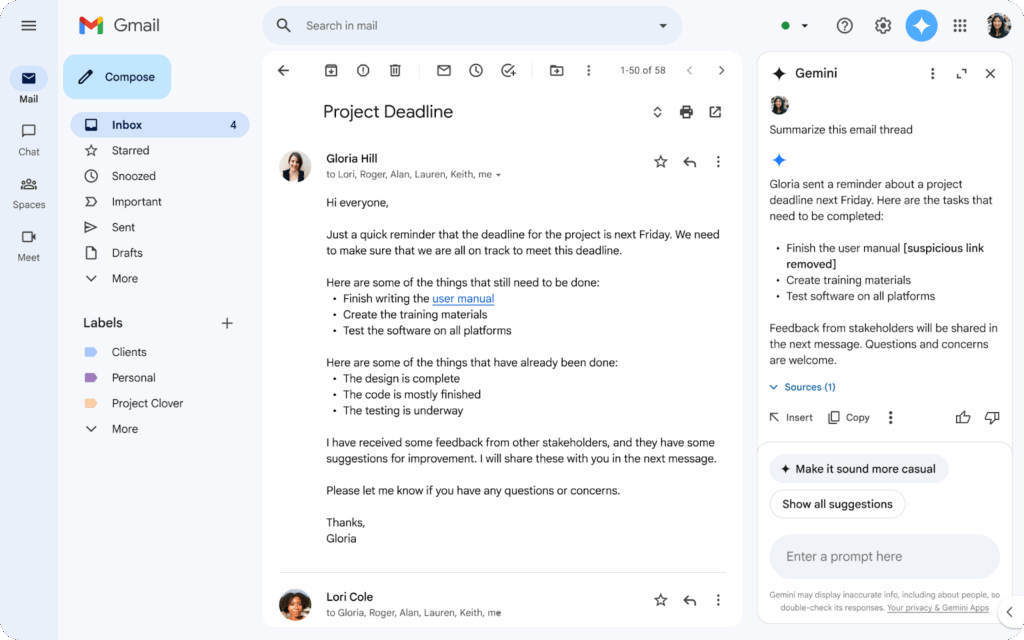

Google contro i prompt injection: strategia multilivello per Gemini

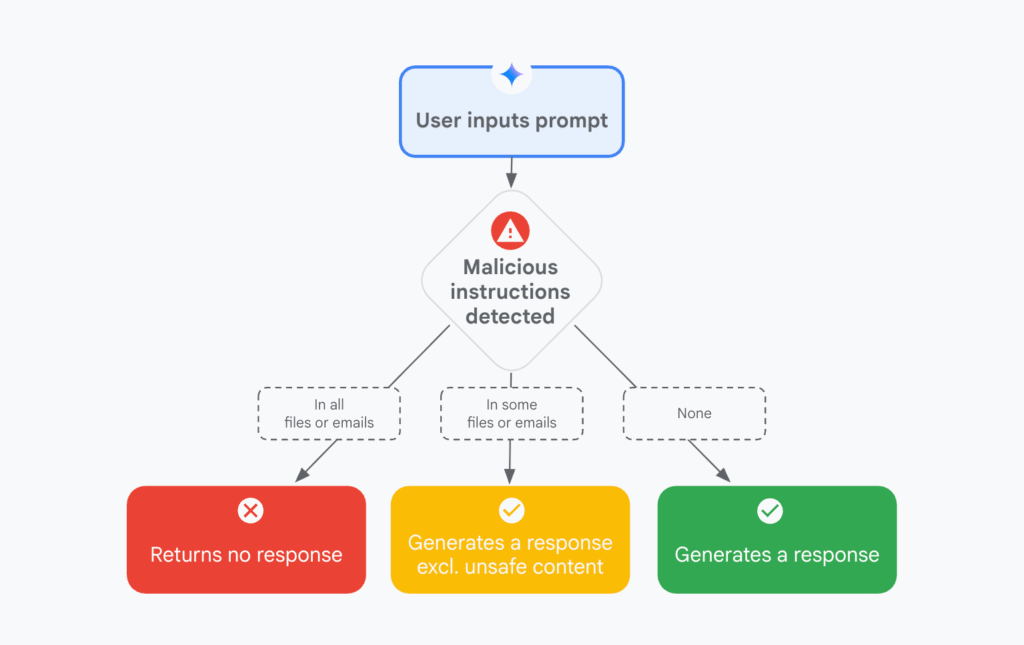

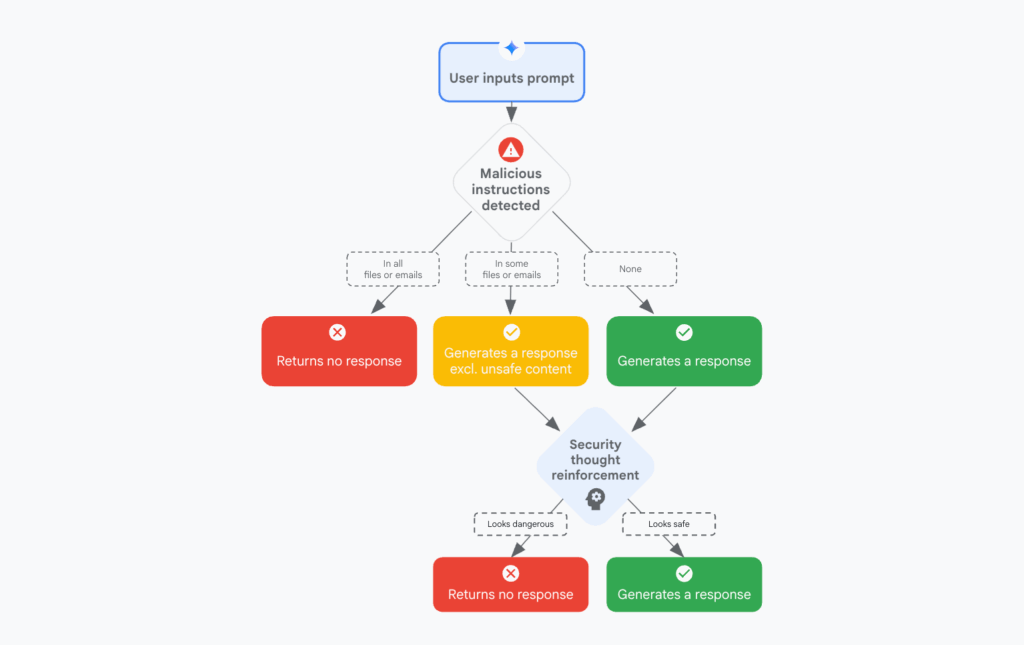

Google ha affrontato pubblicamente il problema emergente degli attacchi di prompt injection, in particolare nella loro forma indiretta, attraverso contenuti maligni provenienti da fonti esterne. Un esempio è un link o messaggio su un sito web o email che, una volta elaborato da un’IA, altera il comportamento della stessa inducendola a eseguire azioni non desiderate o compromettere la confidenzialità dei dati.

Il team di sicurezza di Google propone un approccio a tre livelli:

- Difese pre-inferenza: sanificazione e controllo degli input provenienti da fonti potenzialmente manipolabili.

- Difese durante l’inferenza: inserimento di guardrails semantici nel prompt system-level dell’IA, per impedirle di agire su comandi non autorizzati.

- Difese post-inferenza: validazione dei risultati generati, con filtri automatici per individuare contenuti devianti o pericolosi.

Google sta già implementando queste misure su Gemini 2 e prevede l’estensione a tutti i suoi modelli LLM in cloud e dispositivi. L’obiettivo è contrastare attacchi sofisticati dove un prompt maligno si nasconde all’interno di testi apparentemente legittimi, come e-mail, siti web, documenti o ticket di assistenza.

Prompt injection e sicurezza AI: una minaccia in crescita

Gli attacchi di prompt injection indiretta rappresentano una delle sfide più insidiose nel contesto dell’AI generativa. A differenza delle iniezioni dirette, dove un attaccante scrive intenzionalmente un prompt per manipolare l’output, l’attacco indiretto sfrutta contenuti inseriti da terze parti che vengono successivamente interpretati dall’IA. Il rischio è che il modello, leggendo questi contenuti come istruzioni, possa violare policy, esporre dati sensibili o eseguire azioni non previste.

Questi attacchi non sono puramente teorici. Alcuni test condotti da ricercatori indipendenti hanno dimostrato che un messaggio nascosto in una pagina HTML o in un documento Markdown può indurre l’IA a rispondere in modi che compromettono la sicurezza o la coerenza operativa. Google ha ammesso che nessun LLM attualmente in uso è immune a tali minacce, e per questo ha deciso di anticipare la pubblicazione delle contromisure in fase di test.

Microsoft e AI: impatto operativo e reputazionale

Nel caso di Microsoft, l’incidente DHCP evidenzia quanto delicata sia la gestione dei processi critici di rete in ambienti Windows Server. Anche una patch correttamente firmata e distribuita può innescare un malfunzionamento sistemico, che diventa rapidamente una crisi operativa per infrastrutture IT che gestiscono VPN, VoIP, ambienti ibridi e Active Directory.

La mancanza temporanea di soluzioni ufficiali ha costretto molte aziende a disinstallare manualmente le patch, ritardando così anche altre correzioni di sicurezza incluse nel pacchetto cumulativo. Questo apre a una finestra di vulnerabilità, in cui i sistemi non solo sono instabili, ma anche esposti a CVE non mitigati.

Dal lato Google, l’esposizione al rischio non ha causato incidenti pubblici, ma l’apertura alla comunità accademica è un segnale chiaro: la trasparenza e la cooperazione sono essenziali per arginare minacce ancora poco comprese come la manipolazione semantica attraverso input testuali complessi.

L’interazione tra sistemi legacy, patch di sicurezza e architetture cloud-native richiede test di compatibilità più estesi, soprattutto in ambienti enterprise con dipendenze da servizi come DHCP, DNS e autenticazione Kerberos. Le aziende devono adottare strategie di aggiornamento progressivo, sandboxing e rollback automatico per prevenire downtime critici.

Nel contesto AI, la prompt injection richiede la definizione di standard semantici nei prompt system-level, oltre all’adozione di filtri contestuali post-inferenza. L’uso di LLM come Gemini o GPT-4 in ambienti aziendali deve prevedere un livello di auditabilità e controllo delle fonti, integrato nelle pipeline CI/CD dei servizi basati su AI.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.