L’adozione accelerata dei Large Language Model (LLM) nell’industria, nella ricerca e nei servizi pubblici apre scenari di produttività, automazione e analisi mai sperimentati prima. Tuttavia, proprio l’incremento di utilizzo di modelli come GPT-4, Claude, Gemini e derivati open source genera una superficie d’attacco del tutto inedita, che i cybercriminali e i gruppi APT stanno rapidamente sfruttando. Le recenti ricerche di Check Point Research e Cisco Talos Intelligence offrono una fotografia avanzata delle minacce emergenti: prompt injection, tecniche di evasione delle policy AI, manipolazione dei risultati, automazione del social engineering e sviluppo di nuovi tool malevoli direttamente tramite modelli generativi.

Prompt injection: vettori di manipolazione e tecniche di evasione nei sistemi AI

La prompt injection rappresenta oggi uno dei rischi principali per l’affidabilità e la sicurezza dei sistemi basati su LLM. Secondo il report di Check Point, gli attaccanti sfruttano l’ambiguità intrinseca del linguaggio naturale e la mancanza di robusti meccanismi di filtraggio a monte. Tramite richieste appositamente progettate, è possibile indurre il modello AI a eludere restrizioni, ignorare istruzioni di sicurezza o rivelare informazioni teoricamente protette. Queste tecniche non si limitano all’ottenimento di output testuali indesiderati, ma abilitano vere e proprie escalation: dal leaking di dati sensibili alla generazione di codice dannoso, dalla redazione di documenti fraudolenti alla bypass delle policy di moderazione.

I ricercatori evidenziano come la complessità dei modelli e la loro tendenza a “sovrascrivere” prompt precedenti renda difficile implementare barriere universali. I test dimostrano che combinando input stratificati, tecniche di re-prompting e istruzioni in linguaggi misti, anche i sistemi più evoluti possono essere indotti a comportamenti rischiosi. Gli attacchi di prompt injection risultano particolarmente efficaci quando l’AI è integrata in flussi automatizzati – come chatbot di customer care, sistemi di workflow documentale, strumenti di analisi dati – poiché l’output del modello viene spesso consumato da altri software senza verifica manuale.

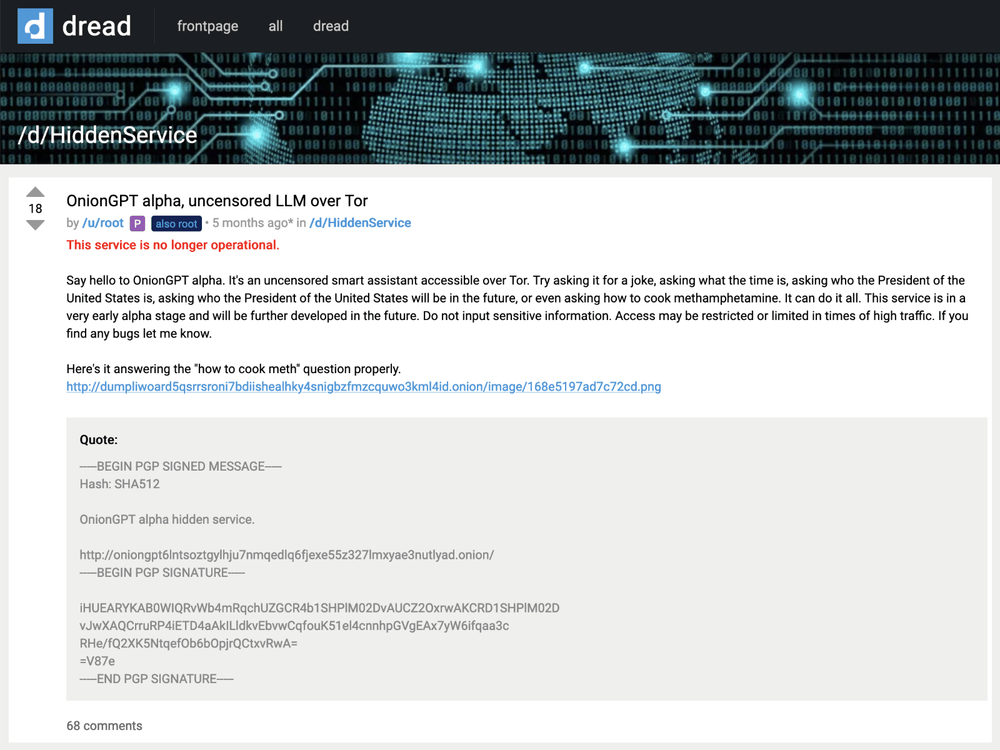

Abuso dei LLM nel cybercrime: automazione, phishing e sviluppo malware

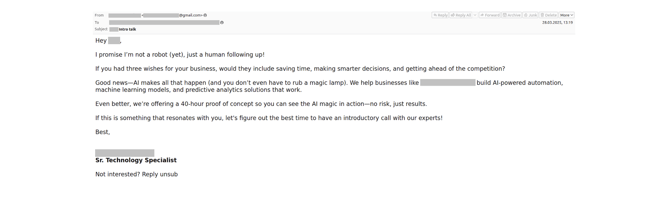

Cisco Talos sottolinea come l’ecosistema criminale stia già adottando LLM per automatizzare attività di attacco che tradizionalmente richiedevano competenze avanzate e tempi di preparazione lunghi. I modelli AI vengono impiegati per la generazione di spear phishing ultra realistici, la creazione di script per bypassare filtri antispam, la redazione di contenuti fraudolenti in molteplici lingue e l’analisi automatica delle risposte degli utenti per affinare strategie di ingegneria sociale. La combinazione tra prompt injection e abuso di LLM trasforma la catena del cybercrime, rendendo possibile la personalizzazione di massa delle campagne e l’adattamento rapido alle contromisure difensive.

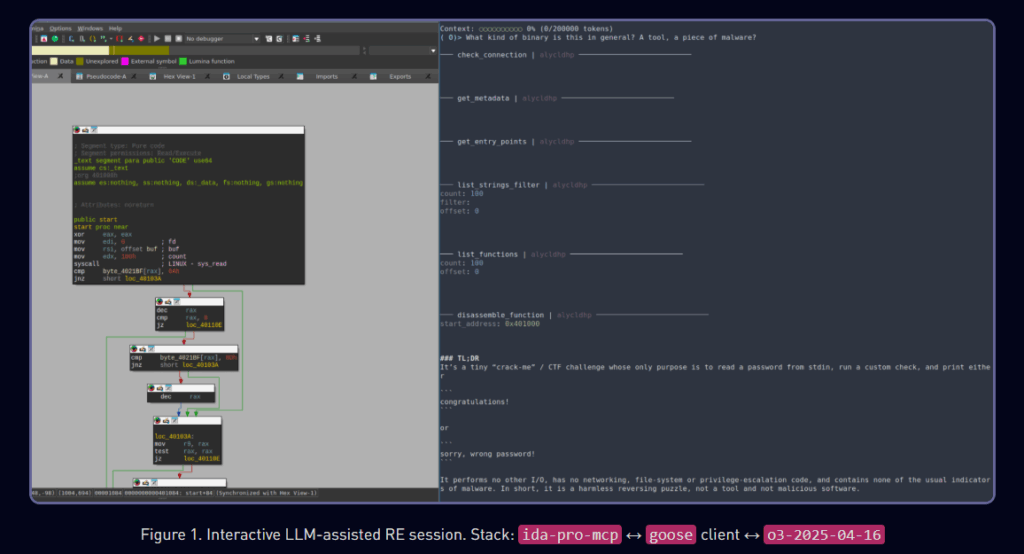

Un trend preoccupante riguarda la produzione di malware tramite LLM. Gli attaccanti forniscono al modello descrizioni tecniche e requisiti specifici, ottenendo in risposta codice potenzialmente utilizzabile per dropper, infostealer, exploit di privilege escalation e tool di persistence. Anche se molte piattaforme AI hanno introdotto barriere per limitare la generazione di contenuti pericolosi, gli attori malevoli sperimentano costantemente prompt alternativi, formulazioni indirette e tecniche di segmentazione del task per eludere i controlli automatici.

I ricercatori segnalano casi concreti in cui modelli open source, privi di filtri centralizzati, sono stati impiegati per sviluppare componenti malevoli poi riutilizzati in campagne di ransomware, phishing industriale e attacchi supply chain. L’integrazione dei LLM in tool di automazione OSINT, scansione di vulnerabilità e orchestrazione C2 accelera la diffusione di tecniche di attacco sofisticate anche tra attori con risorse limitate.

Kaspersky denuncia l’aumento delle app AI fraudolente

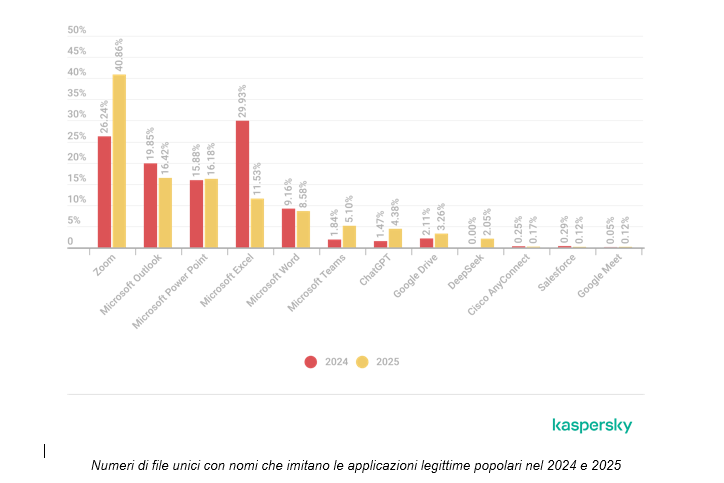

Nel primo semestre del 2025, Kaspersky ha rilevato un incremento senza precedenti nei tentativi di attacco rivolti alle PMI tramite la diffusione di minacce mascherate da applicazioni di intelligenza artificiale, in particolare imitazioni di ChatGPT. Il report evidenzia come l’aumento del 115% di file malevoli che sfruttano il brand ChatGPT rappresenti un segnale chiaro della capacità dei cybercriminali di adattarsi rapidamente ai trend tecnologici più esposti mediaticamente.

Questa evoluzione nelle tattiche di social engineering, secondo Kaspersky, non riguarda soltanto la crescita numerica degli attacchi, ma mostra una selettività nella scelta delle piattaforme AI da sfruttare come esca: le campagne malevole preferiscono strumenti come ChatGPT e DeepSeek, ignorando altri LLM meno discussi, per massimizzare la probabilità di inganno tra gli utenti aziendali. Nel dettaglio, Kaspersky sottolinea come il clamore mediatico attorno alle nuove applicazioni AI amplifichi il rischio di incappare in versioni false diffuse attraverso siti web o allegati e-mail, rafforzando la necessità di controlli puntuali su link, domini e offerte online apparentemente vantaggiose.

In questo scenario, la formazione continua degli utenti e la verifica sistematica delle fonti diventano elementi essenziali per la difesa delle infrastrutture aziendali, specie in contesti dove il lavoro remoto e l’utilizzo di piattaforme collaborative accrescono la superficie di attacco.

Difesa e mitigazione: limiti attuali e strategie evolutive

La velocità con cui emergono nuove tecniche di evasione e abuso degli LLM mette sotto pressione vendor, sviluppatori e responsabili di sicurezza. Le classiche barriere di blacklist, pattern matching e ban di parole chiave si rivelano spesso inefficaci contro prompt injection e attacchi di seconda generazione. Gli esperti raccomandano l’adozione di AI alignment continuo, sandboxing dell’output, validazione multipla delle risposte e segmentazione delle funzioni critiche. I sistemi devono prevedere audit trail dettagliati e meccanismi di verifica esterna dei risultati prodotti dai LLM, soprattutto quando l’output viene consumato in processi automatizzati o critici.

Un ruolo chiave è affidato anche alla formazione degli utenti e degli sviluppatori: la consapevolezza delle tecniche di manipolazione, la capacità di identificare comportamenti anomali nei modelli e l’aggiornamento continuo delle policy interne rappresentano elementi centrali per limitare i danni potenziali. Si sviluppano nuovi framework per la robustezza dei prompt e strumenti open source che simulano attacchi di injection per testare la resilienza delle implementazioni LLM.

Prospettive: l’evoluzione della minaccia tra AI, cybercrime e governance

Il rischio di prompt injection e abuso dei LLM non si limita alla sicurezza IT, ma si estende a privacy, governance, gestione dell’identità digitale e resilienza delle infrastrutture critiche. L’automazione delle tecniche di attacco, la rapidità di adattamento dei cybercriminali e la difficoltà di tracciare prompt e output in ambienti complessi richiedono una ridefinizione delle best practice di sicurezza. Gli analisti prevedono che le minacce AI-driven diventeranno parte integrante dei threat landscape dei prossimi anni, spingendo per la convergenza tra strumenti di AI security, analisi comportamentale e risposta automatizzata agli incidenti.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.